标签:

一、准备插件

1、自己编译

1.1 安装Ant

1.2 下载hadoop2.6.0

http://hadoop.apache.org/releases.html#News,选择2.6.0的binary

1.3 下载hadoop2x-eclipse-plugin源代码

地址:https://github.com/winghc/hadoop2x-eclipse-plugin,选择右侧的“Download ZIP”,下载。

1.4 编译

注:由于我本机的有个commons-httpclient包下载不下来,也没找到原因,也就没用自己打包的方式。 一 一+

2、直接下载,这是我下载的一份,确实可用的:

网盘地址:链接: http://pan.baidu.com/s/1dDwemop 密码: idve

二、Eclipse配置

1、把插件放到eclipse的plugins目录下,启动eclipse,可以在左侧看到DFS Location

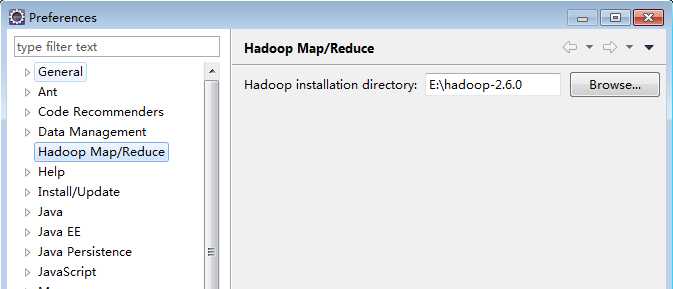

2、打开Window -> Preferences,可以看到Hadoop Map/Reduce选项,选中,设置hadoop的根目录,如下图:

3、配置MapReduce

3.1 点击Window -> Show View -> MapReduce Tools,打开Map/ReduceLocation视图

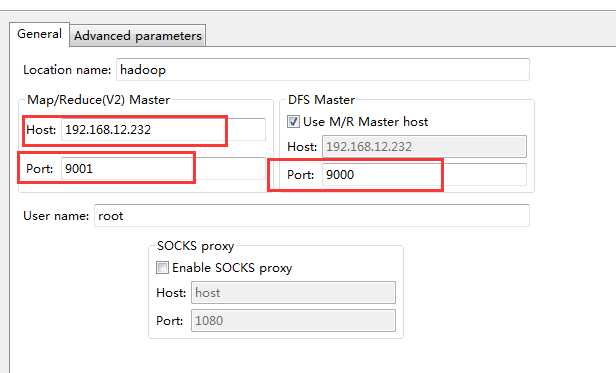

3.2 找到Map/ReduceLocation选项卡,点击右侧的蓝色小象图标,打开配置窗口,输入任意Location name,配置Map/Reduce Master和DFS Master,如下图:

注意:9001和9000端口要设置开放;MR Master和DFS Master配置必须和mapred-site.xml和core-site.xml等配置文件一致

4、测试连接是否成功

4.1 登录到hadoop服务器,启动hadoop服务

4.2 查看左侧DFS Location,如果看到上传的文件,说明连接成功,如下图:

注意:在左侧上传文件到hdfs时,会提示没写的权限,解决方法有三种:

a. 打开hdfs-site.xml,增加如下代码,但不适合生产环境:

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

b. 修改文件的读写权限,如:bin/hadoop dfs -chmod 777 /in/input3

c. windows创建一个和hadoop用户一样的用户,且要用这个用户打开eclipse。(这个本人未亲身测试,有兴趣的可以自己试试)

标签:

原文地址:http://www.cnblogs.com/bookwed/p/4816521.html