标签:

从Selenium模块化一文中,可以看出参数化的必要性,本文来介绍下读取外部txt文件的方法。

打开文件有以下两个函数可以应用:

1、open(file_name,access_mode)

file_name: 文件路径及名称;

access_mode :访问方式,具体参数如下,,未提供参数,则默认为r:

2、file函数

file()内建函数它的功能等于open(),如下根据文档说明可知:

>>> help(open)open(...) open(name[, mode[, buffering]]) -> file objectOpen a file using the file() type, returns a file object. This is the

preferred way to open a file. See file.__doc__ for further information.(END)

接下来介绍读取txt文件内容的方法,Python中提供了读取文件的几种方法,如下;

现在假设读取的txt文件存储的是用户登录名及密码的测试数据,内容如下:

admin,admin

guest,guest

test,test

那么这种情况就比较适合用按行读取的方式来获取文件,如下示例:

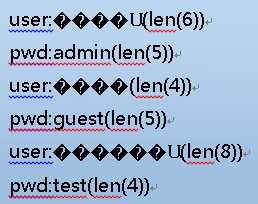

#coding:utf-8 import codecs def str_reader_txt(address): fp=open(address,‘r‘) users=[] pwds=[] lines=fp.readlines() for data in lines: name,pwd=data.split(‘,‘) name=name.strip(‘ \t\r\n‘) pwd=pwd.strip(‘ \t\r\n‘) users.append(name) pwds.append(pwd) print "user:%s(len(%d))" %(name,len(name)) print "pwd:%s(len(%d))" %(pwd,len(pwd)) return users,pwds fp.close()

上述通过Readlines()按行读取txt文件内容,并且使用split()函数切割字符串,分别得到用户名和密码,需要注意的是读取出来的字符有最后面的回车符,所以需要strip函数进行过滤。

但是实际测试过程中,也有可能需要输入中文的用户及密码,能否测试通过?修改测试文档txt的用户名为中文,内容如下:

管理员,admin

来宾,guest

测试人员,test

执行上述脚本后,结果如下:

可以看出,上述的脚本,在进行中文处理时,遇到异常,中文字符显示乱码,下面提供两种解决方法:

#coding:utf-8 import codecs def str_reader_txt(address): fp=open(address,‘r‘) users=[] pwds=[] lines=fp.readlines() for data in lines: print type(data) data=data.decode("gb18030")#处理中文编码问题 print type(data) name,pwd=data.split(‘,‘) name=name.strip(‘ \t\r\n‘) pwd=pwd.strip(‘ \t\r\n‘) users.append(name) pwds.append(pwd) print "user:%s(len(%d))" %(name,len(name)) print "pwd:%s(len(%d))" %(pwd,len(pwd)) return users,pwds fp.close()

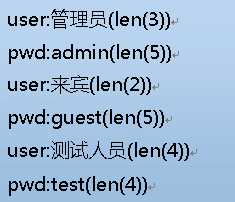

该方法是在分割内容之前,将代码进行decode("gb18030")后,即可正常显示,结果如下

在python中提到unicode,一般指的是unicode对象,例如‘哈哈‘的unicode对象为 u‘\u54c8\u54c8‘

而str,是一个字节数组,这个字节数组表示的是对unicode对象编码(可以是utf-8、gbk、cp936、GB2312)后的存储的格式。这里它仅仅是一个字节流,没有其它的含义,如果想使这个字节流显示的内容有意义,就必须用正确的编码格式,解码显示。

在上述脚本运行中,使用type(data)打印在decode前后的data的数据格式,如下:

<type ‘str‘>

<type ‘unicode‘>

可以看出,内置的open()方法打开文件时,read()读取的是str格式的:

在文件打开时直接指定使用gb18030格式读取后,即可直接操作,另外,该方法对中文txt和英文txt的处理均适用

#coding:utf-8 import codecs def str_reader_txt(address): fp=codecs.open(address,‘r‘,"gb18030") #fp=open(address,‘r‘) users=[] pwds=[] lines=fp.readlines() for data in lines: name,pwd=data.split(‘,‘) name=name.strip(‘ \t\r\n‘) pwd=pwd.strip(‘ \t\r\n‘) users.append(name) pwds.append(pwd) print "user:%s(len(%d))" %(name,len(name)) print "pwd:%s(len(%d))" %(pwd,len(pwd)) return users,pwds fp.close()

备注:Codecs.getreader也可以达到同样的效果,如下:

#coding:utf-8 import codecs def str_reader_txt_csv(address): f=file(address,‘rb‘) users=[] pwds=[] csv=codecs.getreader(‘gb18030‘)(f) #Codecs.getreaderf方法 for data in csv: name,pwd=data.split(‘,‘) name=name.strip(‘ \t\r\n‘) pwd=pwd.strip(‘ \t\r\n‘) users.append(name) pwds.append(pwd) return users,pwds f.close()

模块codecs提供了一个open()方法,可以指定一个编码打开文件,使用这个方法打开的文件读取返回的将是unicode。

写入时,如果参数是unicode,则使用open()时指定的编码进行编码后写入;

如果是str,则先根据源代码文件声明的字符编码,解码成unicode后再进行前述操作。对内置的open()来说,这个方法比较不容易在编码上出现问题,推荐使用

下面是通过对比测试的结果,可以看出使用gb18030和UTF-8操作的结果:

在windows平台下,默认的文档保存方式为ANSI,在简体中文系统下,ANSI 编码代表 GB2312 编码。

在txt保存时,修改保存格式为UTF-8时,可以使用UTF-8编码打开,但是其字符长度有差异,其原因如下:

需要一提的是BOM(Byte Order Mark)。我们在储存文件时,文件使用的编码并没有保存,打开时则需要我们记住原先保存时使用的编码并使用这个编码打开,这样一来就产生了许多麻烦。

那记事本打开文件时并没有让选编码?不妨先打开记事本再使用文件 -> 打开一个保存为UTF-8编码格式的txt文档看看

UTF引入了BOM来表示自身编码,如果一开始读入的几个字节是其中之一,则代表接下来要读取的文字使用的编码是相应的编码:

BOM_UTF8 ‘\xef\xbb\xbf‘

BOM_UTF16_LE ‘\xff\xfe‘

BOM_UTF16_BE ‘\xfe\xff‘

那针对UTF-8格式文件存在BOM的情况下,如何获取内容呢?Codec中有个方法codecs.BOM_UTF8可以去参考一下,此处不详细解释

这里给出参考链接,http://www.zhihu.com/question/19677619

该文章描述的比较全面清晰,总结一下就是:

GB 18030,全称:国家标准GB 18030-2005《信息技术中文编码字符集》,是中华人民共和国现时最新的内码字集,是GB 18030-2000《信息技术信息交换用汉字编码字符集基本集的扩充》的修订版。

处理中文数据时最好采用如下方式:

1. Decode early(尽早decode, 将文件中的内容转化成unicode再进行下一步处理)

2. Unicode everywhere (程序内部处理都用unicode)

3. Encode late (最后encode回所需的encoding, 例如把最终结果写进结果文件)

有几点要说明一下:

* 所谓“正确的”编码,指得是指定编码和字符串本身的编码必须一致。这个其实并不那么容易判断,一般来说,我们直接输入的简体中文字符,有两种可能的编码:GB2312(GBK、GB18030)、以及UTF-8

* GB2312、GBK、GB18030本质上是同一种编码标准。只是在前者基础上扩充了字符数量

* UTF-8和GB编码不兼容

*第二步,将str转化为unicode对象时,可以使用下列两个方法:都是将gb2312编码的str转为unicode编码

*另外,在定义字符串时,出现中文,都使用str=u ‘汉字‘ 来定义。

Python中文乱码问题深入分析

http://www.jb51.net/article/26543.htm

http://www.cnblogs.com/huxi/archive/2010/12/05/1897271.html

详解 python 中文编码与处理

http://my.oschina.net/leejun2005/blog/74430

Python字符串的encode与decode研究心得——解决乱码问题

http://blog.csdn.net/lxdcyh/article/details/4018054

标签:

原文地址:http://www.cnblogs.com/leeboke/p/5014440.html