标签:

elasticsearch官方只提供smartcn这个中文分词插件,效果不是很好,好在国内有medcl大神(国内最早研究es的人之一)写的两个中文分词插件,一个是ik的,一个是mmseg的,下面分别介绍ik的用法,

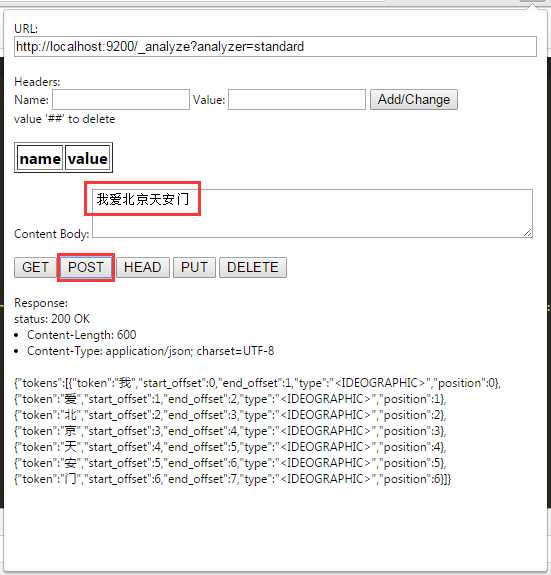

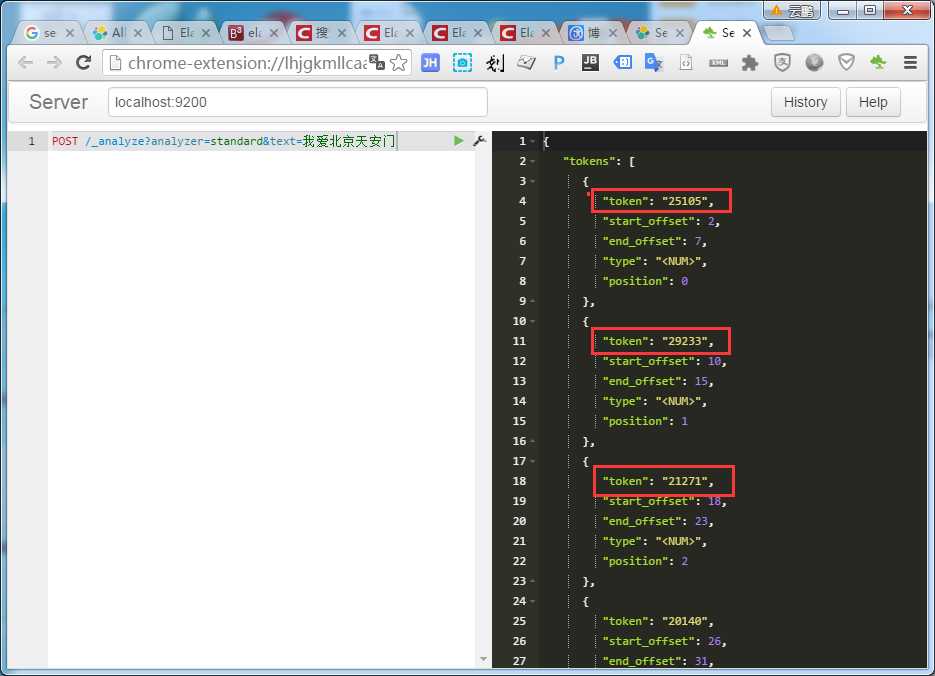

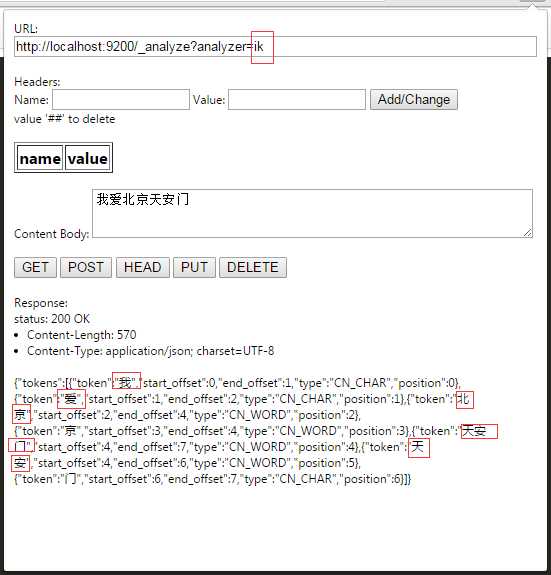

当我们创建一个index(库db_news)时,easticsearch默认提供的分词器db_news,分词结果会把每个汉字分开,而不是我们想要的根据关键词来分词。例如:

代码如下:

正常情况下,这不是我们想要的结果,比如我们更希望 “我”,“爱”,“北京”,"天安门"这样的分词,这样我们就需要安装中文分词插件,ik就是实现这个功能的。

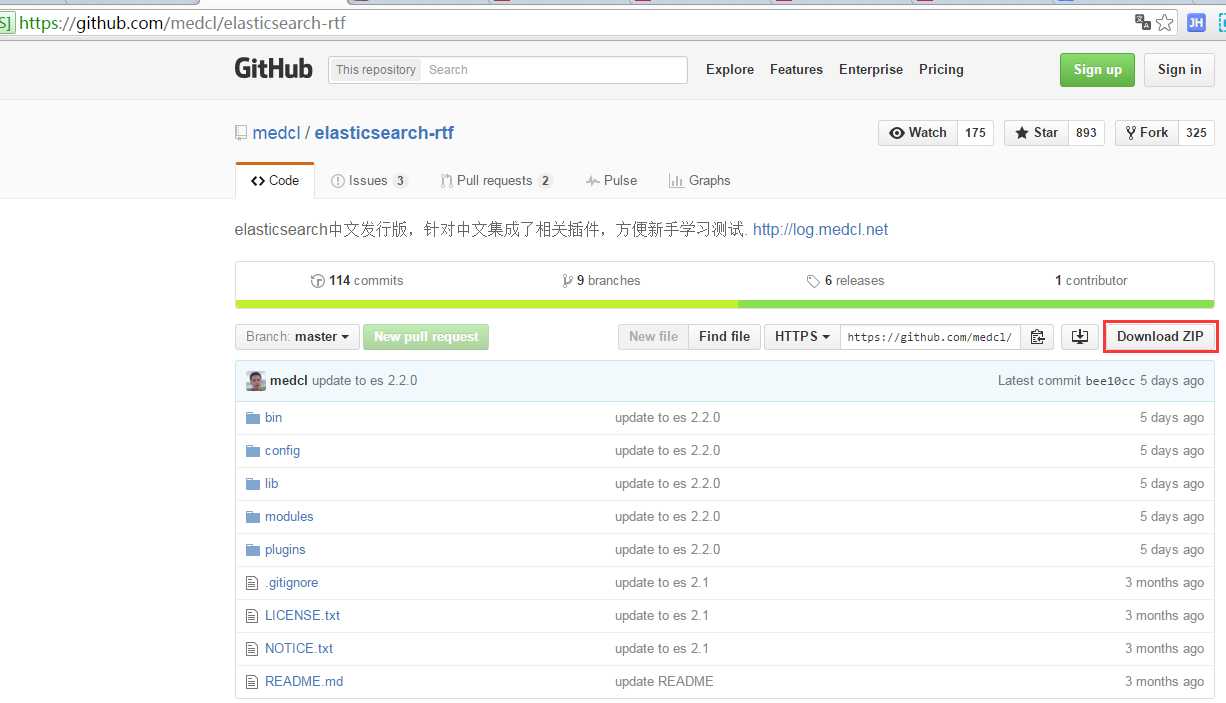

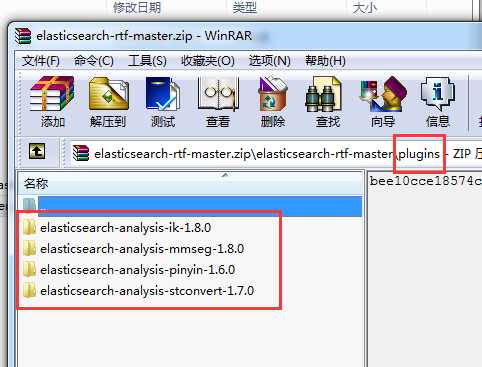

直接下载elasticsearch中文发行版。下载地址是:https://github.com/medcl/elasticsearch-rtf。重新运行安装elasticsearch实例。

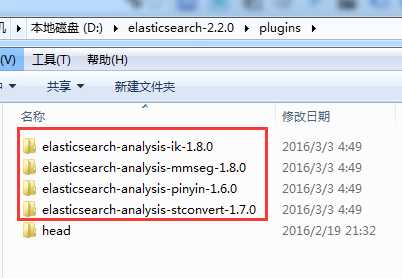

只解压缩plugins文件夹里面的内容到plugins目录里面

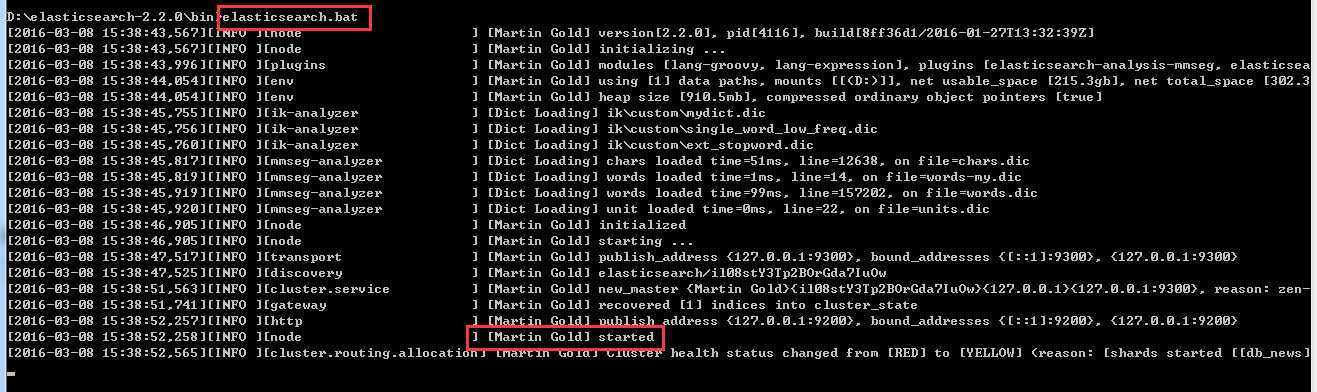

重新启动ElasticSearch

安装完毕,执行命令:

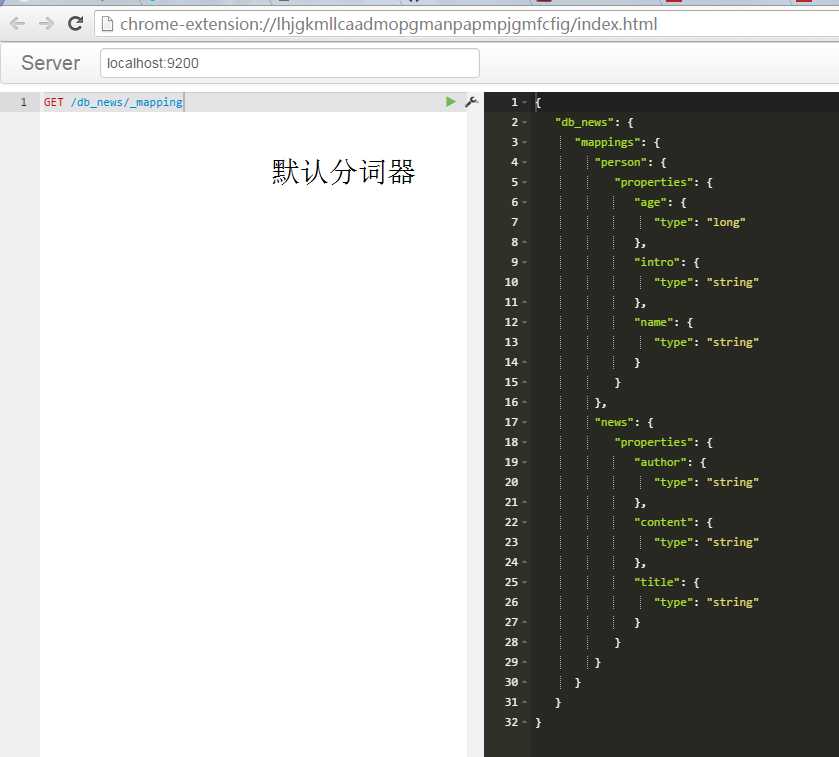

如果我们直接创建索引库,会使用默认的分词进行分词,这不是我们想要的结果。这个时候我们再去更改分词器会报错如下:

{ "error": "IndexAlreadyExistsException[[db_news] already exists]", "status": 400 }

GET /db_news/_mapping

而且没有办法解决冲突,唯一的办法是删除已经存在的索引,新建一个索引,并制定mapping使用新的分词器(注意要在数据插入之前,否则会使用elasticsearch默认的分词器)。

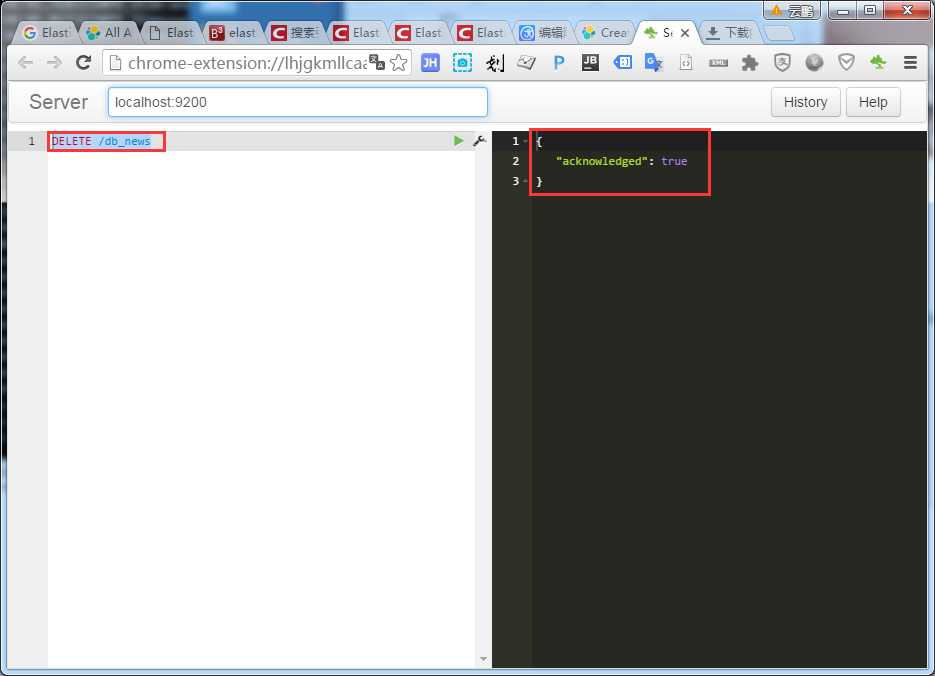

删除索引命令如下:

DELETE /db_news

转:http://eggtwo.com/news/detail/146

IK:https://github.com/medcl/elasticsearch-analysis-ik

标签:

原文地址:http://www.cnblogs.com/qiyebao/p/5254173.html