标签:

mac下没找到非常合适的工具来下载网站页面,来做模板网页用,

于是就查找资料,写了一个脚本,通过wget来下载页面,具体如下:

#! /bin/bash

URL="$2"

PATH="$1"

echo "download url: $URL"

echo "download dir: $PATH"

/usr/local/bin/wget -e robots=off -w 1 -xq -np -pk -E -t 1 -P "$PATH" "$URL"

echo "success to download"

注:

这里robots=off是因为wget默认会根据网站的robots.txt进行操作,如果robots.txt里是User-agent: * Disallow: /的话,wget是做不了镜像或者下载目录的。-e robots=off 这个选项可以通过这个命令绕过这个限制。

-w seconds 资源请求下载之间的等待时间(减轻服务器的压力)

-np 只下载给定URL下的内容,不下载它的上级内容

-pk 下载有关页面需要用到的所有资源,包括图片和css样式,并将绝对路径转换为相对路径(这个很重要,为了在用户打开网页的时候,加载的相关资源都在本地寻找)

-E 将下载的文件,以htm后缀保存

-t times 某个资源下载失败后的重试下载次数

-P 下载到哪个路径

讲以上内容存储为*.sh文件,并通过命令chmod +x,增加文件权限,

然后传入参数执行这个文件,如:

/Users/zhangtao/Documents/shell脚本/test.sh /Users/zhangtao/Documents/sites http://kedahb.com/index.asp

此命令说明:执行test.sh的文件,传入了保存的目录,以及需要下载的页面文件,命令执行完毕后会提示“success to download”

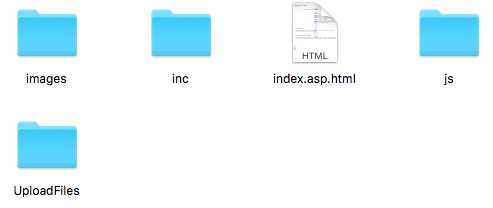

下载的结果:

标签:

原文地址:http://www.cnblogs.com/luotuo/p/5514555.html