标签:

(1)下载Spark源码

到官方网站下载:Openfire、Spark、Smack,其中Spark只能使用SVN下载,源码的文件夹分别对应Openfire、Spark和Smack。

直接下载Openfire、Smack源代码

下载地址:http://www.igniterealtime.org/downloads/source.jsp

利用SVN方式下载Spark源代码

1.为Eclipse安装Subversive插件

A 启动Eclipse

B 依次点击Help->Install New Software...->Add

C 输入框里Name输入Subversive,并且在URL输入框里输入http://www.polarion.org/projects/subversive/download/1.1/update-site(最新的Subversive URL地址在http://www.eclipse.org/subversive 上查询)

D 点击Finish开始安装Subversive,Eclipse将搜索网站并且在下一个窗口中显示你想安装的功能,选择安装Subversive SVN Team Provider Plugin 和 Subversive Client Libraries下面所有的功能

E 点击Next,Eclipse开始安装,安装结束后重启Eclipse

2.利用svn下载spark代码

A 点击如下Windows::Open Perspective::Other...

B 弹出一个“Open Perspective”对话框,选择“SVN Repository Exploring”,单击OK

C 这时Eclipse界面发生变化,在左边的“ SVN Repositories”面板上右击鼠标,选择New::Repository Location...

D 在“New Repository Location”的位置输入“http://svn.igniterealtime.org/svn/repos”,单击 “Finish”

E 在SVN Repositories面板上会发生变化,展开它并找到spark的选项,右击spark下面的trunk项并选择“Check Out”下载spark代码

F 下载完成后选择Window::Open Perspective::Java,在Project Explorer面板上会看到Spark项目,删掉它,在弹出来的对话框中选择“Do not delete contents”,然后在工作目录下面找到spark文件夹,它就是spark的源代码

利用SVN客户端从官网下载Spark源代码

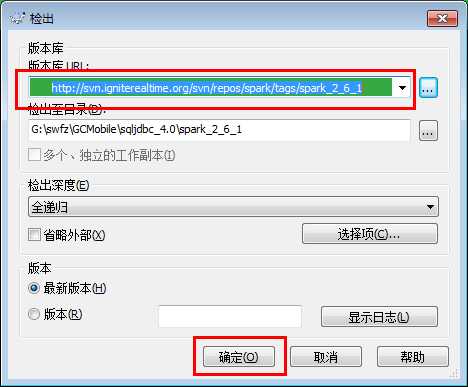

1.新建个文件夹作为检出文件的根目录,命名为 spark_2.6.1,打开该文件夹,空白处右键 ——> SVN检出(要已安装SVN客户端右键才有这个菜单)

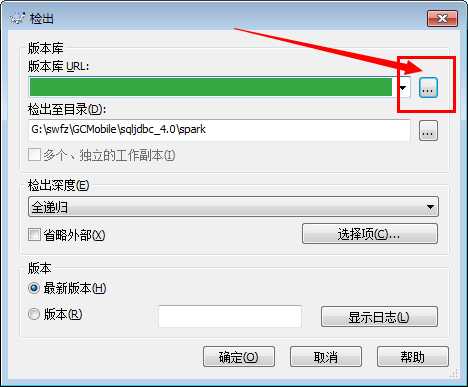

2.“版本库 URL:” 中输入官网下载地址 http://svn.igniterealtime.org/svn/repos/spark ,然后点击浏览(图中标红的按钮,注意一定要进去浏览,不然就会把官网所有的版本下载下来,会很大超级慢)

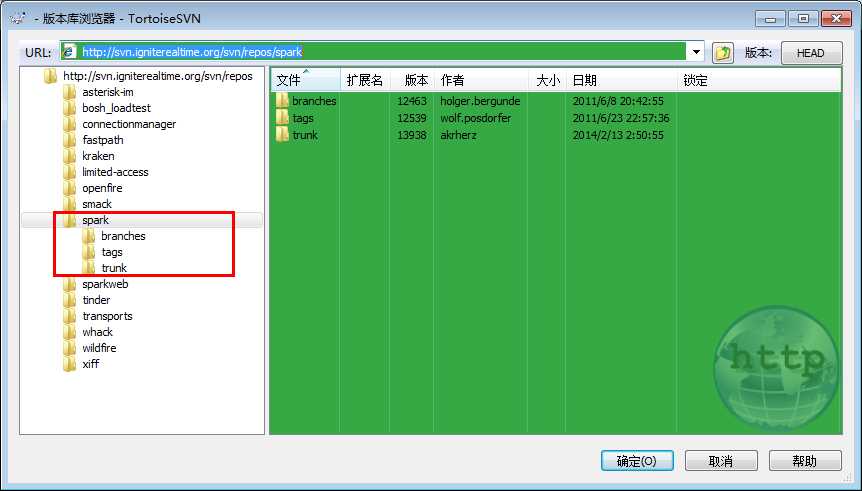

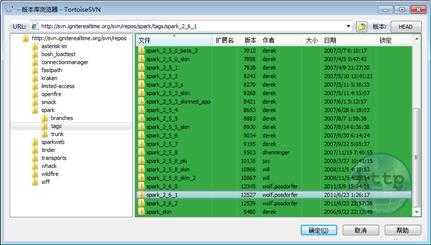

3.进来后我们会看到如下的结构树,其中trunk是最新版本,tags是之前的版本,如果要下载最新版就在左侧选中trunk 或者右边双击trunk文件夹;如果要下载其他版本就展开tags文件夹,再选要下载的文件夹,然后确定—>确定,开始下载。

(2)导入工程

1.打开Eclipse。

2.创建Java project,命名为spark(建议用这个名字),其Contents中选择“Create project from existing source”,然后将下载的spark源代码文件所在的文件夹加进去。

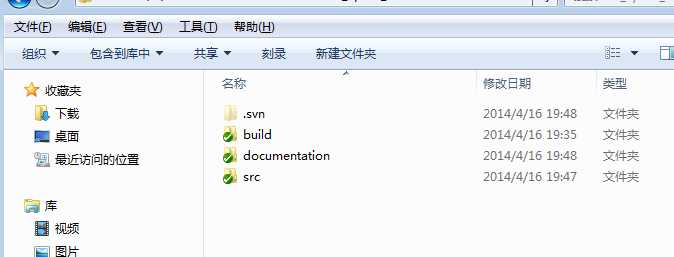

或者在Eclipse的工作空间workplace文件夹中直接新建一个名为spark的文件夹,将下载的spark源代码的三个文件夹(如下图)复制一份,粘贴到新建的spark文件夹中,再重新启动Eclipse定位到此workplace,在 Package Explorer下右键—>New—>Java Project,命名为spark(此处和workplace中新建的文件夹名称一致),Finish后便直接加载项目进来了。

加载进来后会有一些红色错误和黄色警告,其它教程说把带红色错误的包直接删除掉,其实不删也没什么影响。

3.在Eclipse的Package Explorer中显示如下图所示:

(3)生成、编译、运行Spark

生成Spark

1.点击Window->Show View->Ant

2.右击Ant面板,选择Add Buildfiles

3.展开spark下的build文件夹,选择build.xml文件,点击OK

4.在Ant面板展开spark,双击“release[default]”,如右图。![]()

5.等一段时间会提示“BUILD SUCCESSFUL”(若没有显示,再次双击“release[default]”)

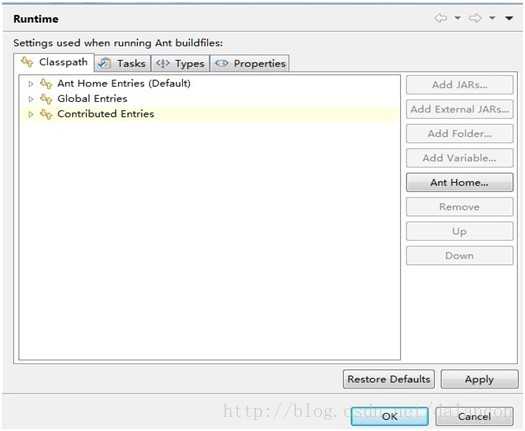

一直显示BUILD FAILED,提示Must use Ant 1.6.x or higher to build Spark,说明Eclipse自带的Ant版本较低,需要修改Eclipse的Ant在1.6.x ~1.7.x 之间:

A Windows---Preferences---Ant---Runtime

B 选中Ant Home Entries(Default)点击左边的箭头,展开里面的jar包,把里面的这些自带的jar全删掉

B 选中Ant Home Entries(Default)点击左边的箭头,展开里面的jar包,把里面的这些自带的jar全删掉

C 点击Add External JARS... 进入已下载的更高版本的Ant的安装目录(C:\Apache Spark\apache-ant-1.7.0\lib),把目录下的jar全选添加进来即可

6.生成target文件夹,重新编译时,要手工删除此文件夹

编译Spark

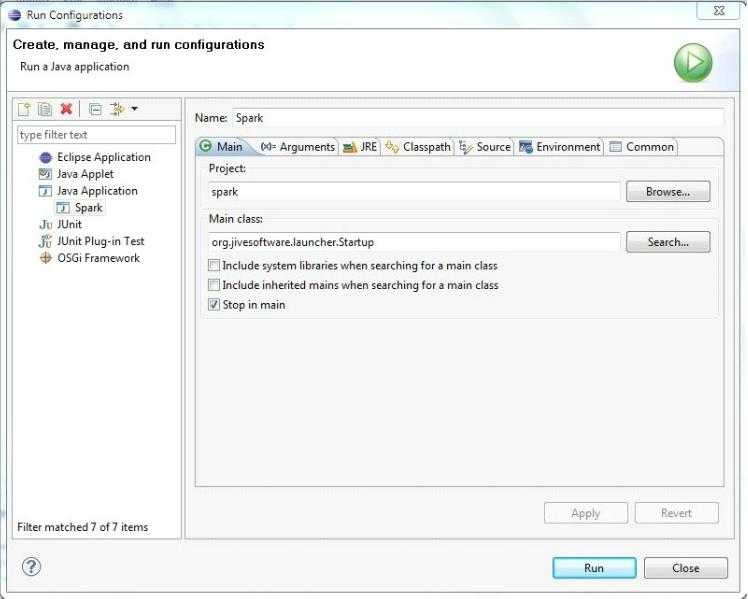

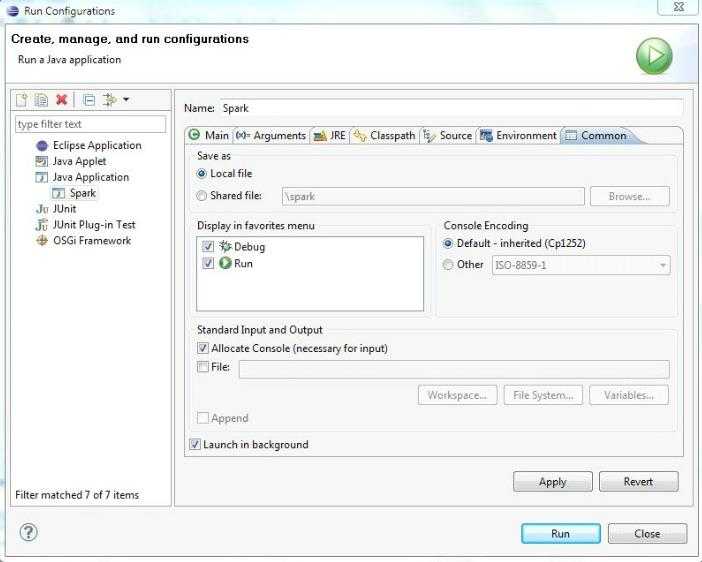

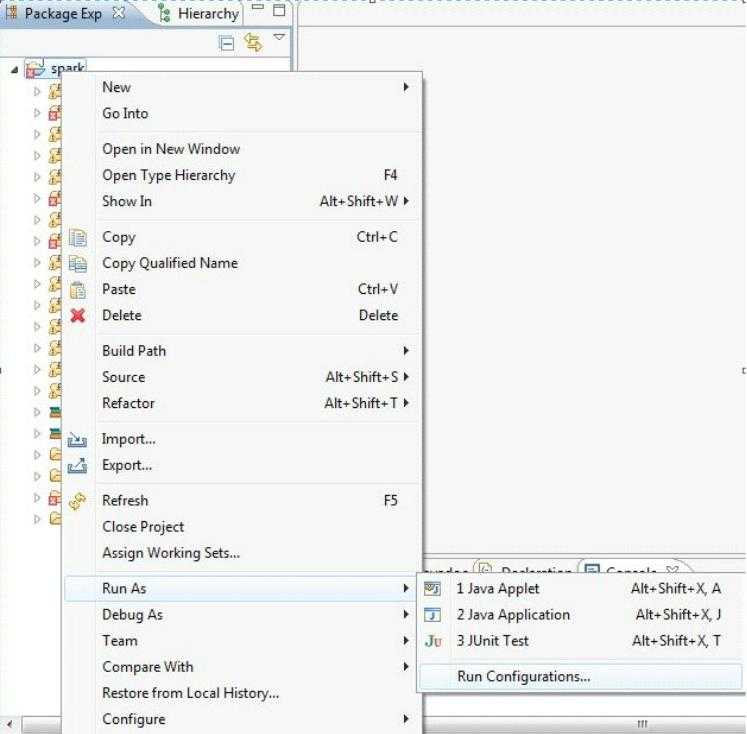

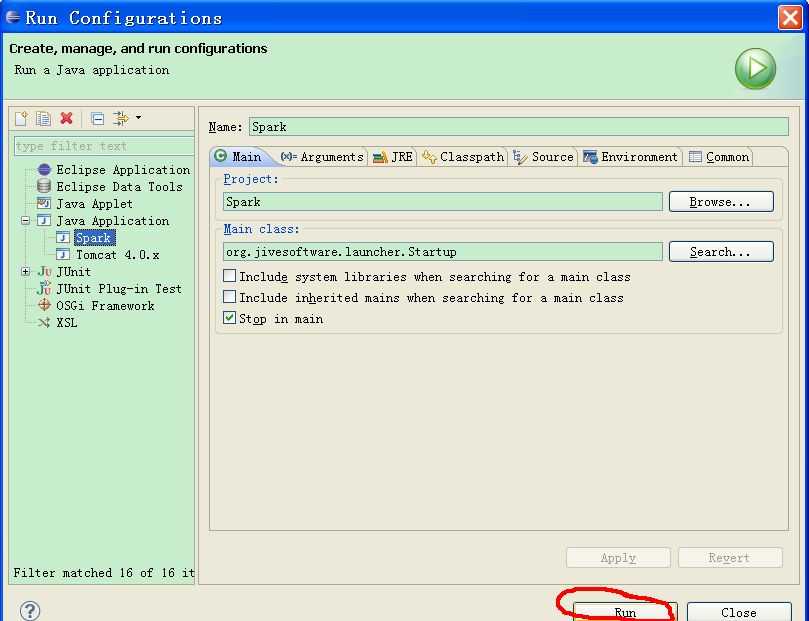

1.点击Run->Run Configurations

2.点击Main

Name填写:Spark

Project:Spark(选择Spark工程)

Main class:org.jivesoftware.launcher.Startup(启动类)

勾选Stop in main

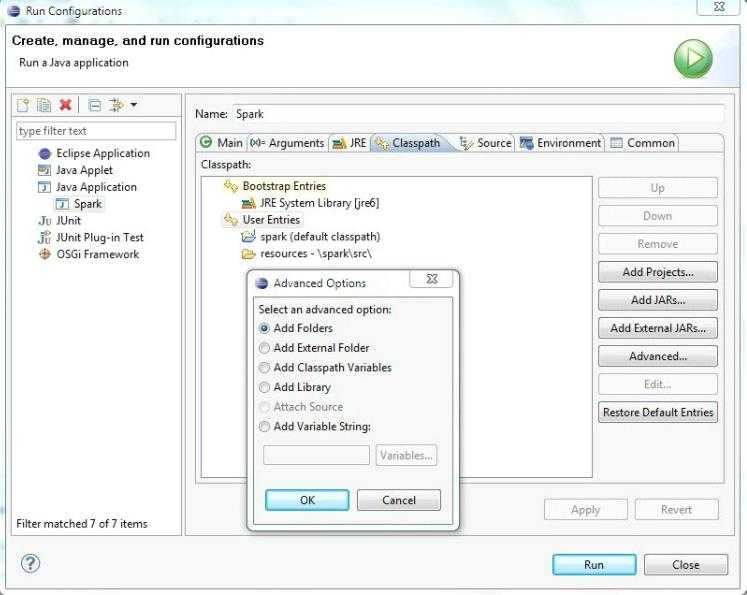

3.点击Classpath标签页

选择User Entries ,使得Advanced..按钮变的可用.点击Advanced按钮.在弹出来的Advanced Options窗口,选择Add Folders,再点OK,在Folder Selection窗口选择spark::src::resources 文件夹,点击OK

4.选择Common标签页,勾选Debug,Run前面的框。点击Apply,再点击Close。

运行Spark

运行Spark

Spark源代码在Eclipse3.5.2中的部署、编译、运行

标签:

原文地址:http://www.cnblogs.com/5211314jackrose/p/5720074.html