标签:cep ext 通道数 san 调整 eal reg neu time

arxiv上放出的物体检测的文章,在Pascal voc数据集上排第二。源码也已放出(https://github.com/sanghoon/pva-faster-rcnn),又可以慢慢把玩了。这篇文章遵循faster-rcnn“CNN feature extraction + region proposal + RoI classification”的pipeline,重新设计了feature extraction的网络结构。"The devil is in details",文章利用很多的cnn tricks,详述了网络设计的细节。

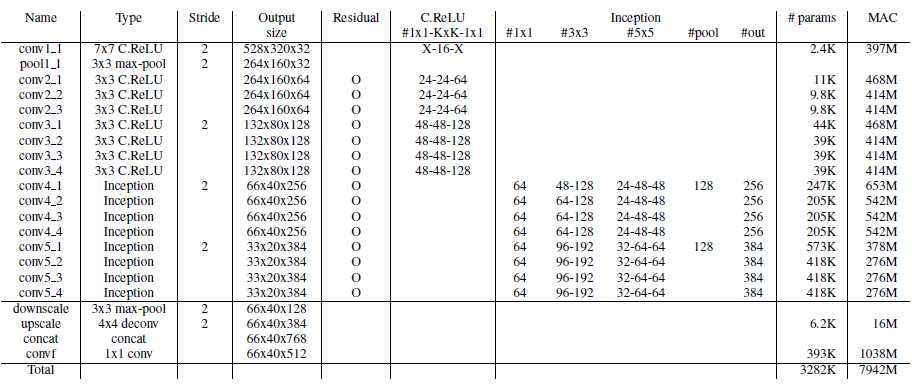

C.ReLU是在ICML2016一篇文章提出。文章发现,CNN的初期阶段,神经元的激活值正好相反。C.ReLU把卷积输出的通道数减半,将输出与其负向输出级联,在没有损失正确率的情况下,获得两倍的加速。

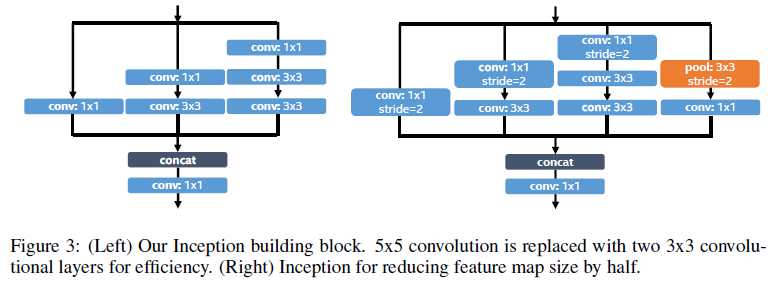

Inception是GoogleNet的重要组成模块,却还没用在检测任务上。Inception中的1x1卷积核不仅能够增加网络的非线性,同时能够保持前一层的感受野,因此对小物体的检测有很好的作用。文中还把原来5x5的卷积核换成两个3x3的卷积核,减少参数,增加网络非线性和模块感受野。

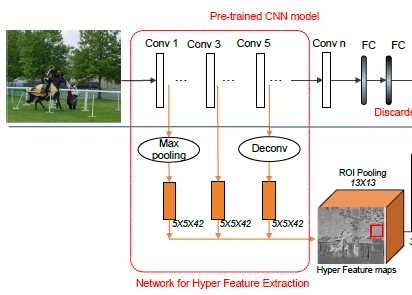

HyperNet将不同卷积阶段的卷积层级联起来,对同时需要分类和定位的检测任务来说有很好的效果。

论文的级联为:

combines 1) the last layer and 2) two intermediate layers whose scales are 2x and 4x of the last

layer, respectively.

文章用了residual connections 和batch normalization加速网络收敛。BN层加在ReLU层后面,学习率根据plateau detection自动调整。

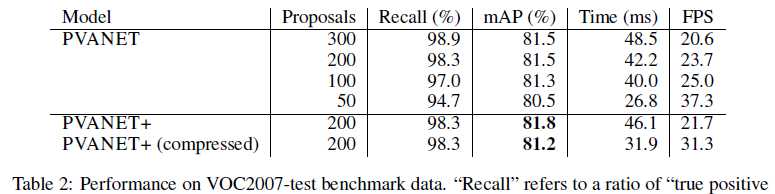

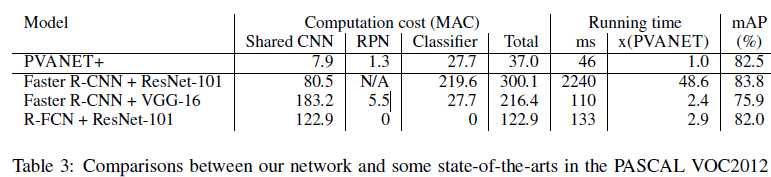

RPN用了25个anchor(5 scales(3,6,9,16,25),5 aspect ratios(0.5,0.557,1.0,1.5,2.0))。最后的全连接层使用了简单的SVD分解,map有部分降低,检测速度加快。

PVANET----Deep but Lightweight Neural Networks for Real-time Object Detection论文记录

标签:cep ext 通道数 san 调整 eal reg neu time

原文地址:http://www.cnblogs.com/slyz/p/6004417.html