标签:style blog http java os io strong 文件

下面开始hadoop的安装与配置;

(1)安装jdk

我安装的是JDK1.7.0_40,windows x64版的

下载完之后,直接点击安装,

我的安装路径为默认路径:C:\Program Files\Java\jdk1.7.0_40;

安装完毕后,设置环境变量:

JAVA_HOME指向JDk安装目录

PATH指向JDK的bin目录

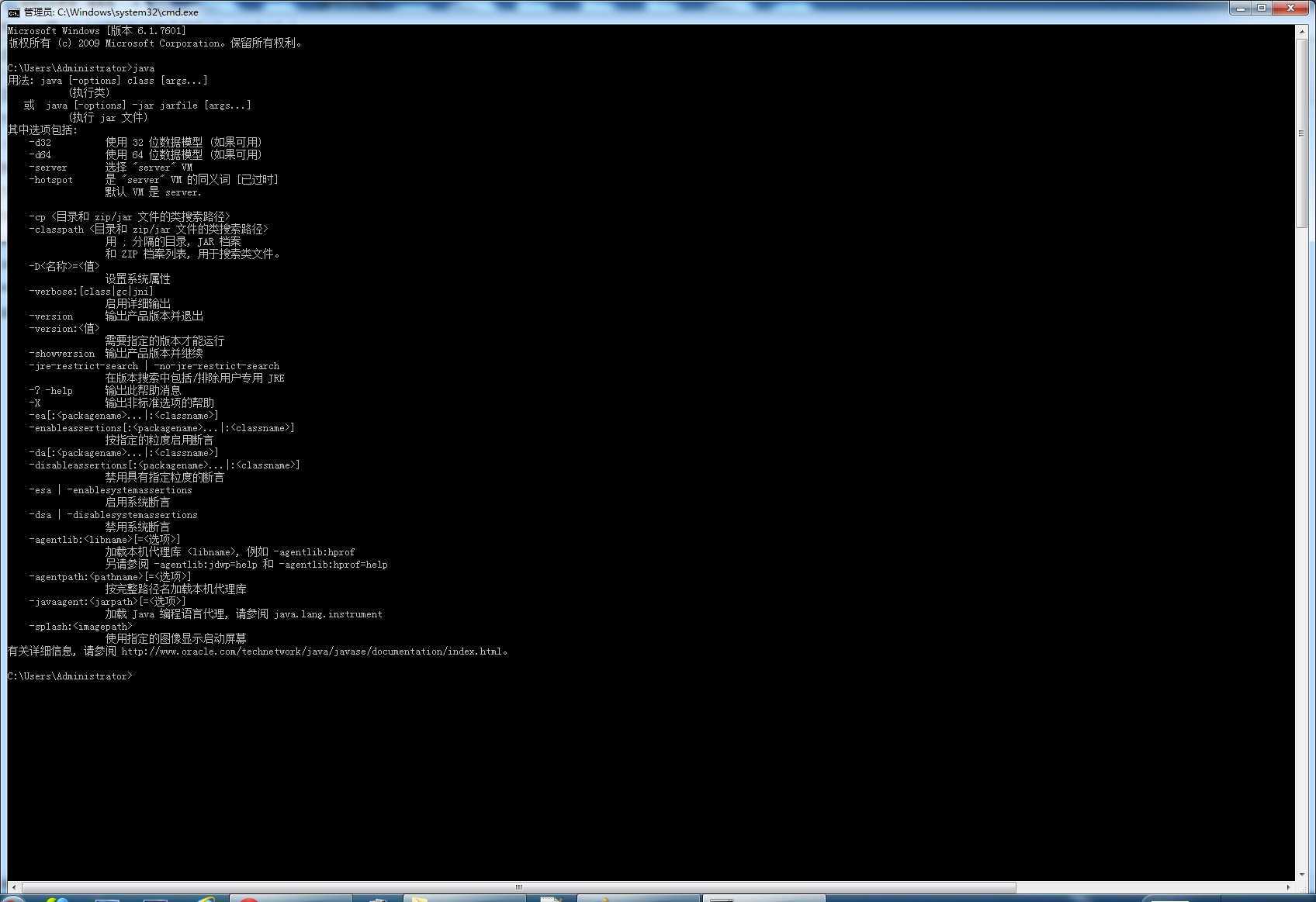

设置完成之后,在cmd中 输入java命令,如果出现一下画面,即为安装成功:

(2)安装hadoop

下载hadoop,http://hadoop.apache.org

我下载的版本是hadoop-1.2.1.tar.gz

下载之后 将该文件解压到C:\cygwin64\home\ldm\目录下,并将文件夹的名字改为hadoop

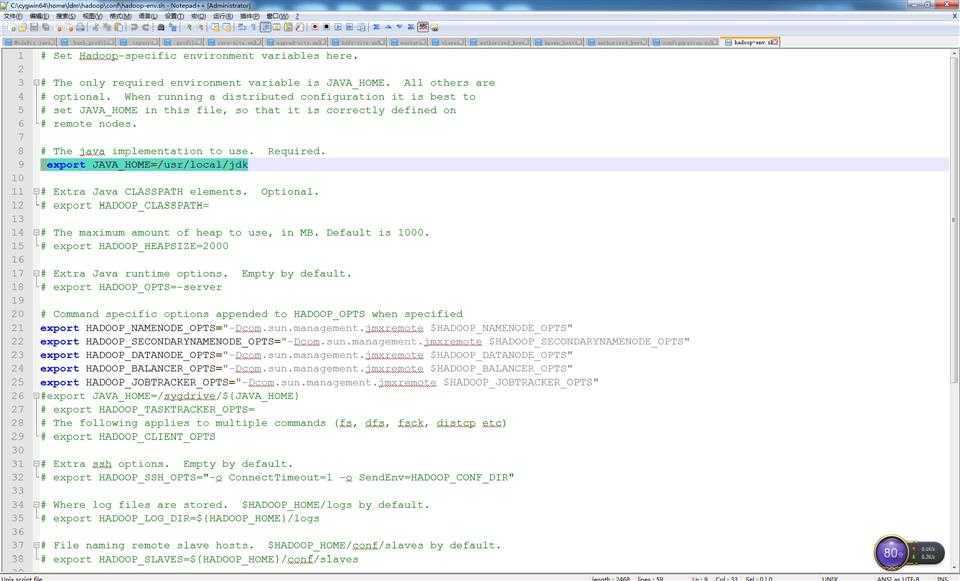

配置conf/hadoop-env.sh:

配置JDk即可:

export JAVA_HOME=/usr/local/jdk;

这里呢,要在cygwin下面执行命令:

LN -s C:\Program Files\Java\jdk1.7.0_40 /usr/local/jdk;

生成 链接文件;

否则 直接配置windows下的路径时,肯能会有不能识别的问题。

配置 core-site.xml:

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/hadoop</value>

</property>

</configuration>

配置hdfs-site.xml:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

配置mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

(3)启动hadoop

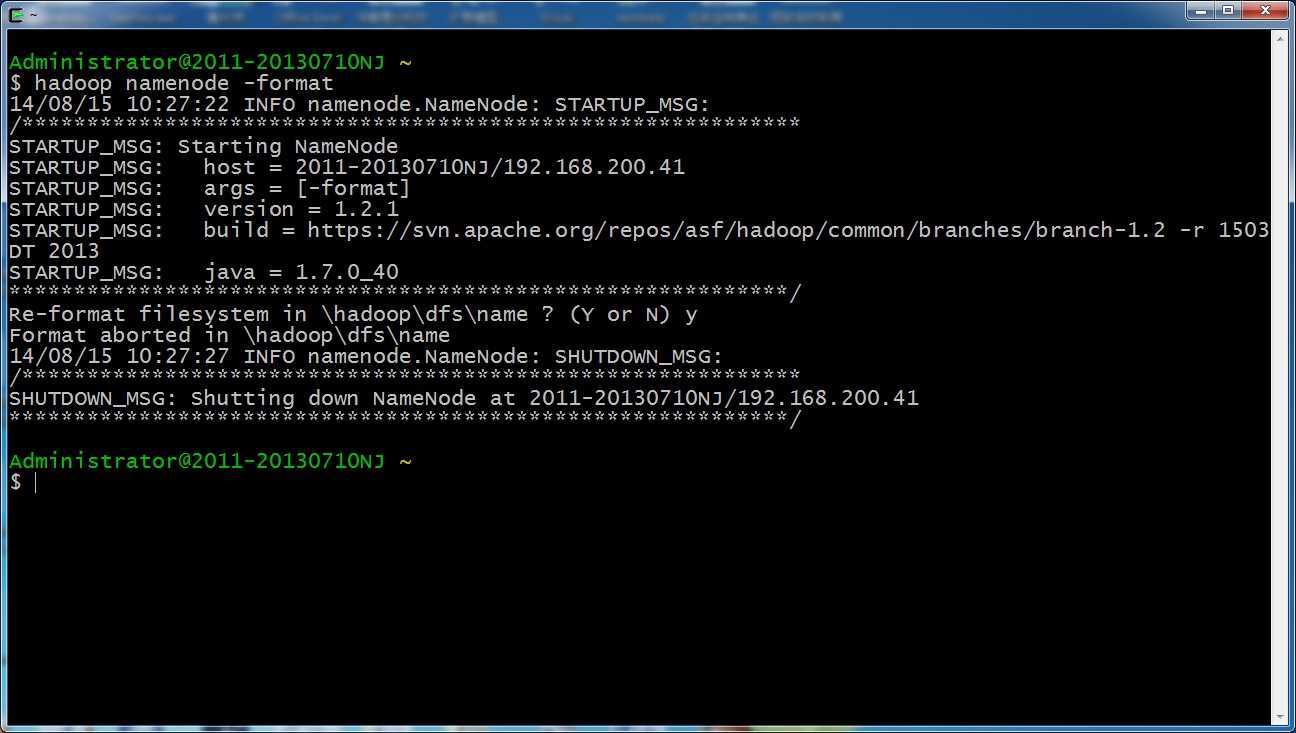

格式化文件系统:

hadoop namenode -format

启动hadoop:

启动关闭所有任务:start-all.sh/stop-all.sh

启动关闭HDFS:start-dfs.sh/stop-dfs.sh

启动关闭MapReduce:start-mapred.sh/stop-mapred.sh

(4)hadoop的访问

Hadoop的重要端口:

JobTracker管理界面:50030

HDFS管理界面:50070

HDFS通信界面:9000

MapReduce通信端口:9001

常用的访问界面:

NameNode界面:http://localhost:50070

JobTracker管理界面:http://localhost:50030

如果hadoop启动成功的话,就可以从上述访问界面上访问。

windows下hadoop的单机伪分布式部署(2),布布扣,bubuko.com

标签:style blog http java os io strong 文件

原文地址:http://www.cnblogs.com/liudmblog/p/3914171.html