标签:服务 cli int work style hdfs 编写 imp 过滤

代码

package spark_1 import org.apache.spark.SparkConf import org.apache.spark.SparkContext class WorkCountTest {

//自定义函数 def jiSuan(){ //数据文件路径 var loadFile="hdfs://服务器ip:8020/tmp/dataTest/Z";

//初始化sparkContext var conf=new SparkConf(); conf.setAppName("workCountZhangxs"); conf.setMaster("spark://服务器ip:7077") var sc=new SparkContext(conf);

//从hdfs上读取文件 var fileRdd=sc.textFile(loadFile, 2);

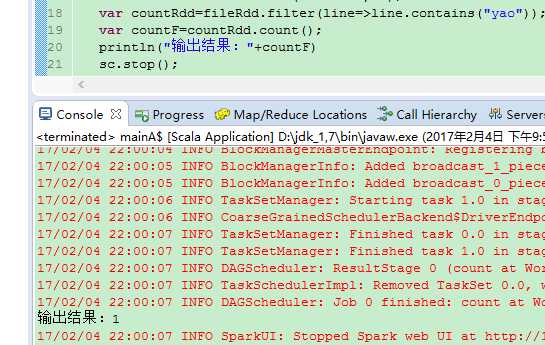

//过滤出包含执行的字符("yao") var countRdd=fileRdd.filter(line=>line.contains("yao"));

//计算出count var countF=countRdd.count(); println(countF) sc.stop(); } } object mainA{ def main(args: Array[String]) {

//初始化类 var t=new WorkCountTest();

//调用计算函数 t.jiSuan(); } }

输出结果

标签:服务 cli int work style hdfs 编写 imp 过滤

原文地址:http://www.cnblogs.com/zhangXingSheng/p/6512405.html