标签:chap tle 作用 bag 分布 .com www 自适应 blank

相比单一的学习器,集成Ensemble的思想是将不同的分类器组合,以期得到更优的(组合)模型用于预测。根据实现的不同,集成算法又有多种形式:

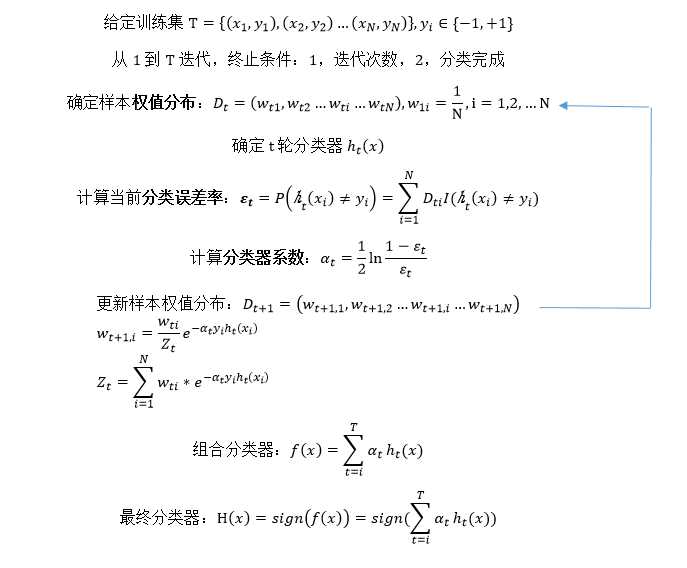

集成Ensemble算法主要分为Bagging和Boosting,AdaBoost是Boosting算法的主要代表,是"Adaptive Boosting"(自适应增强)的缩写,由Yoav Freund和Robert Schapire在1995年提出。它的自适应在于:前一个基本分类器分错的样本会得到加强,加权后的全体样本再次被用来训练下一个基本分类器。同时,在 每一轮中加入一个新的弱分类器,直到达到某个预定的足够小的错误率或达到预先指定的最大迭代次数。

整个Adaboost 迭代算法就3步:

标签:chap tle 作用 bag 分布 .com www 自适应 blank

原文地址:http://www.cnblogs.com/1xin/p/6793761.html