标签:rac 信息 html 核心 software 分析 2.4 nbsp put

我们在抓网页的时候,希望获得的是网页中的有效信息。事实上,直接抓取下来的内容是网页全部的HTML代码,代码中有很多标签、格式控制等等无效的信息。这一节我们就来讲解对于任意一个网页,我们怎么提取出网页中的有效信息,并且结构化存储。

先亮代码:https://github.com/1049451037/universal_webpage_extraction

这个工程使用起来很简单,把要提取的链接放到pool.txt里,然后运行main.py,就可以把pool.txt里的页面都抓取下来并且结构化存储。结果存在output文件夹里。

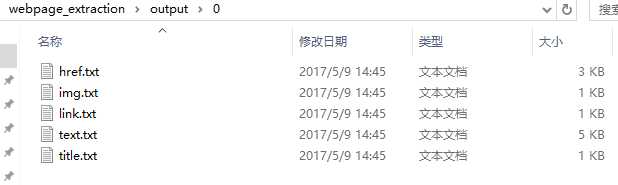

每个网页都保存了链接、标题、文本、图片链接、链接到的网页。效果如下:

下面来讲解一下原理,实际上很简单,使用的是beautifulsoup包。

beautifulsoup是Python的一个拓展库,可以非常方便的实现HTML网页的分析。下面是它的官方文档网址,里面讲的非常清楚:

https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/

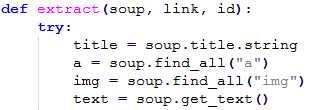

实现起来特别容易,核心代码只有几行,就可以很容易的提取出想要的东西:

想要更多地了解和使用beautifulsoup,建议学习官方文档~

标签:rac 信息 html 核心 software 分析 2.4 nbsp put

原文地址:http://www.cnblogs.com/itlqs/p/6831944.html