标签:blog http 判断 初始化 bsp search 下一步 ring 棋盘

Silver, David, et al. "Mastering the game of Go with deep neural networks and tree search." Nature 529.7587 (2016): 484-489.

Alphago的论文,主要使用了RL的技术,不知道之前有没有用RL做围棋的。

提出了两个网络,一个是策略网络,一个是价值网络,均是通过自我对战实现。

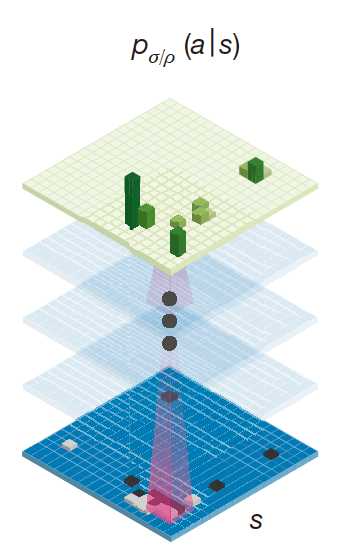

策略网络:

策略网络就是给定当前棋盘和历史信息,给出下一步每个位置的概率。以前的人似乎是用棋手下的棋做有监督训练,这里用RL代替,似乎效果比有监督训练要好。策略网络的参数初始化是用有监督训练网络的参数。

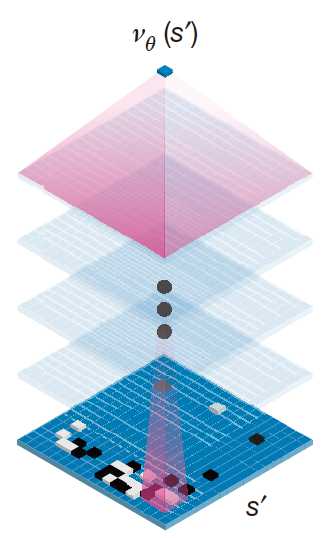

价值网络:

价值网络就是给定当前棋盘和历史信息,给出对己方的优势概率。本来是用来代替蒙特卡洛的随机模拟估计的,但是发现把价值网络和随机模拟估计结合起来效果比较好。个人觉得要是价值网络如果训练得足够好,说不定也就不需要模拟估计了。当然这里的模拟也不是完全随机,好像是用的一个有监督训练出来的浅层网络进行模拟下棋。

策略网络可以降低蒙特卡洛搜索树的宽度,价值网络减小其深度。

该论文第一次打败了人类职业选手(五段的Fan Hui)

另外,该方法有分布式版本和单机版,官方给单机版的判断是和Fan Hui一个水平,分布式版本的可以达到职业5段以上水平。分布式版本用了40个搜索线程, 1,202 个CPU以及176个GPU。单机版是40个搜索线程,48个CPU和8个GPU。按照这个配置,应该10年之内,单台笔记本电脑能跑个职业3段以上的围棋程序,这对围棋学习者是个很好的消息。

Alphgo让RL火了,让围棋火了,让柯洁火了,威力还是巨大的。围棋比较容易形式化,规则也比较简单,只是搜索空间有点大,但现实中还有很多问题规则复杂,信息不完全,状态空间大,决策空间大,需要联合决策等。Alphago还在不断发展,后续应该还有论文。

Mastering the game of Go with deep neural networks and tree search

标签:blog http 判断 初始化 bsp search 下一步 ring 棋盘

原文地址:http://www.cnblogs.com/huangshiyu13/p/6994701.html