标签:app 最简 实现 div nbsp [] int 格式 教程

注明:本文并非教程,仅作为记录本人的日常学习历程而存在。

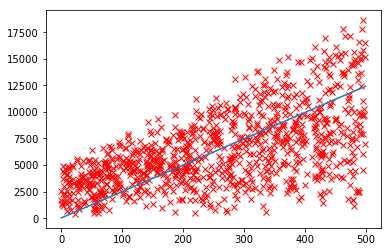

目标:实现将图中的大量红色X状标记拟合为图中所示的一条蓝色直线

基本思想:吴恩达的coursera机器学习课程变量线性回归章节;递度下降法

实现:

1.引入相关库:这里用到了python的科学计算库numpy和绘图库matplotlib

import numpy as np import matplotlib.pyplot as plt

2.虚拟生成数据:因为入门,暂时找不到现成的数据可以使用,故使用numpy的随机函数生成所需要的数据

#生成数据 data_size = 1000 x = np.random.randint(0,500,size=data_size) y = [] for i in range(data_size): y.append(x[i]*np.random.randint(1,30)+np.random.randint(100,5000)) plt.plot(x,y,‘rx‘)

3.定义拟合必须的参数与函数

因为公式中的x0默认为1,所以原始数据中需要为x0多加一列,可以理解为:x = [ 1,x ]

使用numpy.array的reshape函数生成numpy矩阵运算可用的数据格式。

gradient函数即为该方法的核心。具体公式的推导进程不详。

x = [[1,x[i]] for i in range(data_size)] X = np.array(x).reshape((data_size,2)) Y = np.array(y).reshape((data_size,1)) theta = np.zeros((2,1)) def gradient(x,y,theta): y_pred = x.dot(theta) diff = y_pred - y return np.sum(diff)/len(y)

4.进行拟合

max_iter = 1000 learning_rate = 0.0001 for i in range(max_iter): theta = theta - learning_rate * gradient(X,Y,theta)

5.画出该直线

result_x = np.linspace(0,500,50) result_y = theta[1] * result_x + theta[0] plt.plot(result_x,result_y)

6.总结

到此为止,已经可以拟合出代表数据集的一条直线了。但是,在学习过程中,学习速率的设定及结果的正确性都不得而知,所以,下一步引入代价函数cost function。

标签:app 最简 实现 div nbsp [] int 格式 教程

原文地址:http://www.cnblogs.com/minemine/p/7188340.html