标签:task 解决方案 集合 sha read 环境 context 网络 ice

转自:http://www.cnblogs.com/20135124freedom/p/5391170.html

陈民禾 原创作品转载请注明出处 《Linux内核分析》MOOC课程 http://mooc.study.163.com/course/USTC-1000029000

一.关于进程调度的基本知识

进程的几种不同分类:第一种分类:类型一:I/O-bound:频繁的进行I/O,通常会花费很多的时间等待I/O操作的完成;类型二:CPU-bound:计算密集型 ,需要大量的CPU时间进行运算第二种分类:类型一:批处理进程 ;类型二:实时进程;类型三:交互式进程。

调度策略:是一组规则,它们决定什么时候以怎样的方式选择一个新的进程运行,Linux的调度基于分时和优先级:随着版本的变化,分时技术在不断变化,Linux既支持普通的分时进程,也支持实时进程,Linux中的调度是多种调度策略和调度算法的混合。

nice

getpriority

sched_getscheduler/sched_setscheduler

sched_getparam/sched_setparam

sched_yield

sched_get_priority_min/sched_get_priority_max

sched_rr_get_interval

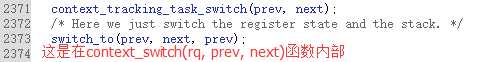

31#define switch_to(prev, next, last)

32do {

33 /*

34 * Context-switching clobbers all registers, so we clobber

35 * them explicitly, via unused output variables.

36 * (EAX and EBP is not listed because EBP is saved/restored

37 * explicitly for wchan access and EAX is the return value of

38 * __switch_to())

39 */

40 unsigned long ebx, ecx, edx, esi, edi;

41

42 asm volatile("pushfl\n\t" /* save flags */ //保存当前进程的flags

43 "pushl %%ebp\n\t" /* save EBP */ //把当前进程的堆栈基址压栈

44 "movl %%esp,%[prev_sp]\n\t" /* save ESP */ //把当前的栈顶保存到prev->thread.sp

45 "movl %[next_sp],%%esp\n\t" /* restore ESP */ //把下一个进程的栈顶保存到esp中,这两句完成了内核堆栈的切换

46 "movl $1f,%[prev_ip]\n\t" /* save EIP */ //保存当前进程的EIP,可以从这恢复

47 "pushl %[next_ip]\n\t" /* restore EIP */ //把下一个进程的起点位置压到堆栈,就是next进程的栈顶。next_ip一般是$1f,对于新创建的子进程是ret_from_fork

//一般用return直接把next_ip pop出来

48 __switch_canary

49 "jmp __switch_to\n" /* regparm call */ //jmp通过寄存器传递参数,即后面的a,d。 函数__switch_to也有return把next_ip pop出来

50 "1:\t" //认为从这开始执行next进程(EIP角度),第一条指令是next_ip这个起点,但前面已经完成内核堆栈的切换,早就是next进程的内核堆栈(算prev进程,比较模糊)

51 "popl %%ebp\n\t" /* restore EBP */ //next进程曾经是prev进程,压栈过ebp

52 "popfl\n" /* restore flags */

53

54 /* output parameters */

55 : [prev_sp] "=m" (prev->thread.sp), //当前进程的,在中断内部,在内核态,sp是内核堆栈的栈顶

56 [prev_ip] "=m" (prev->thread.ip), //当前进程的EIP

57 "=a" (last),

58

59 /* clobbered output registers: */

60 "=b" (ebx), "=c" (ecx), "=d" (edx),

61 "=S" (esi), "=D" (edi)

62

63 __switch_canary_oparam

64

65 /* input parameters: */

66 : [next_sp] "m" (next->thread.sp), //下一个进程的内核堆栈的栈顶

67 [next_ip] "m" (next->thread.ip), //下一个进程的执行起点

68

69 /* regparm parameters for __switch_to(): */

70 [prev] "a" (prev), //寄存器的传递

71 [next] "d" (next)

72

73 __switch_canary_iparam

74

75 : /* reloaded segment registers */

76 "memory");

77} while (0)

2.ls命令——最简单与最复杂的操作

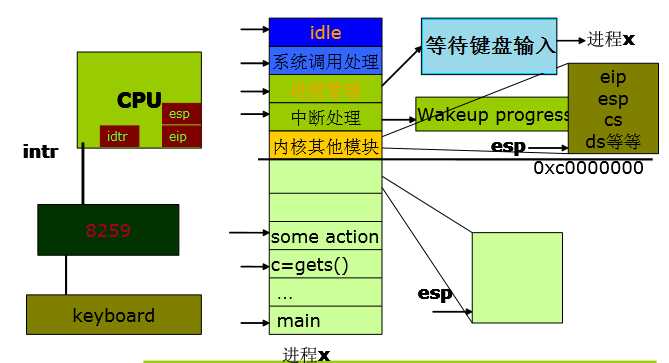

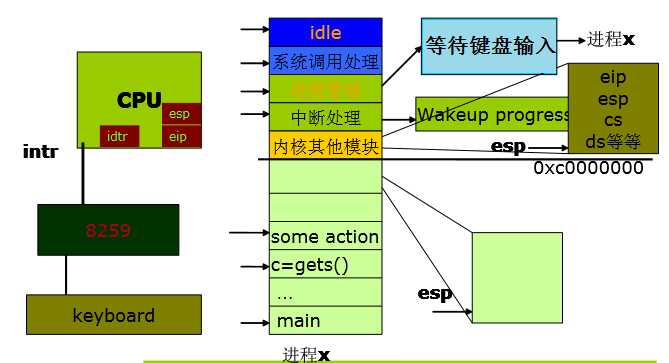

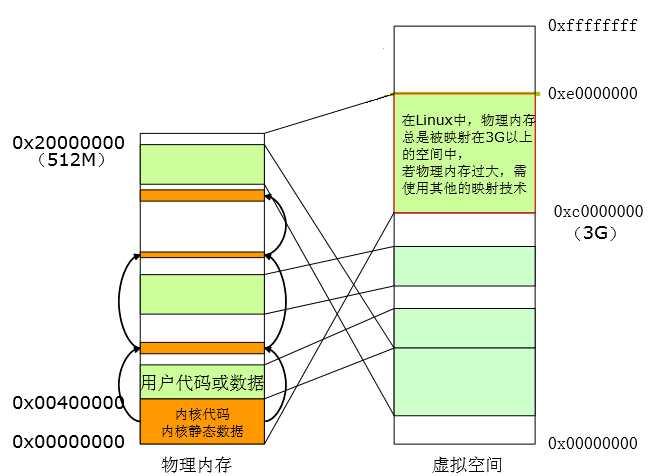

1.从在CPU执行指令的角度看:

2.从内存的角度看

五.实验过程截图及分析

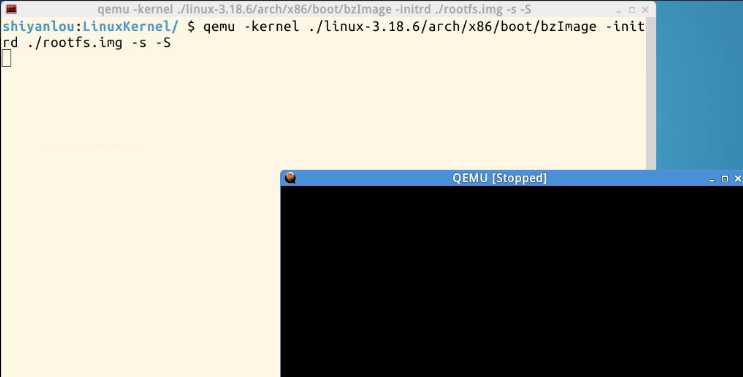

搭建实验环境:

cd LinuxKernel rm menu -rf git clone https://github.com/mengning/menu.git cd menu mv test_exec.c test.c make rootfs

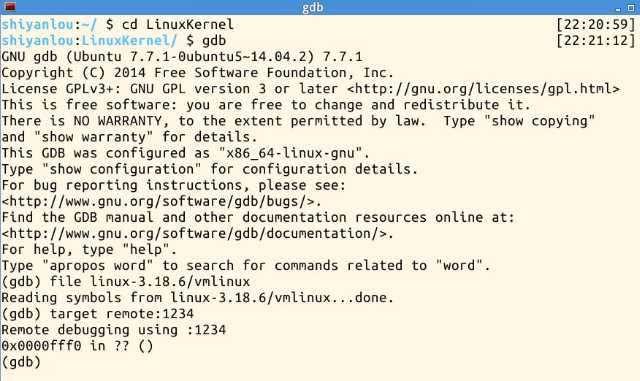

gdb调试

qemu -kernel linux-3.18.6/arch/x86/boot/bzImage -initrd rootfs.img -s -S gdb file ../linux-3.18.6/vmlinux target remote:1234 设置断点: b schedule b pick_next_task b context_switch b switch_to

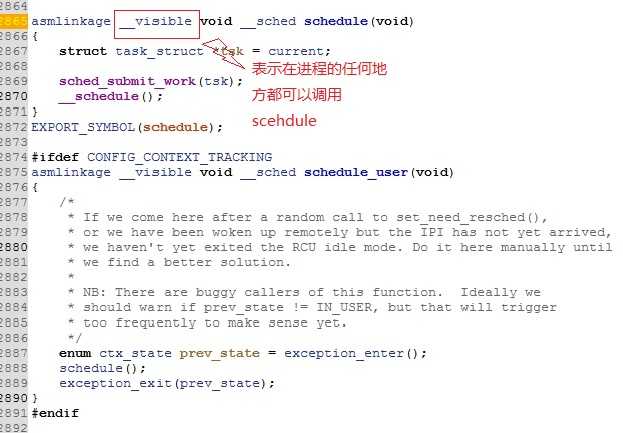

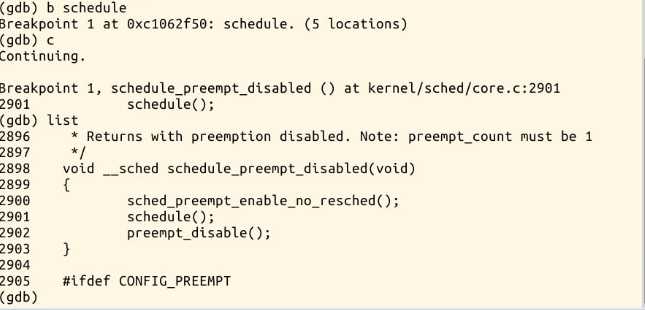

3.在schedule处设置断点,运行,并用list展开函数

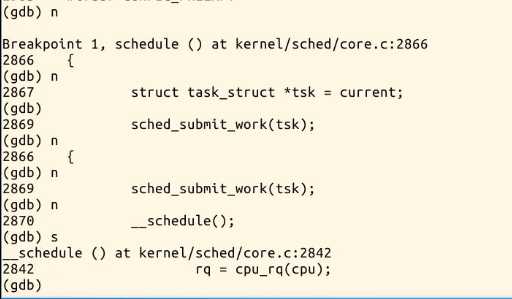

4.单步运行,直至__schedule()

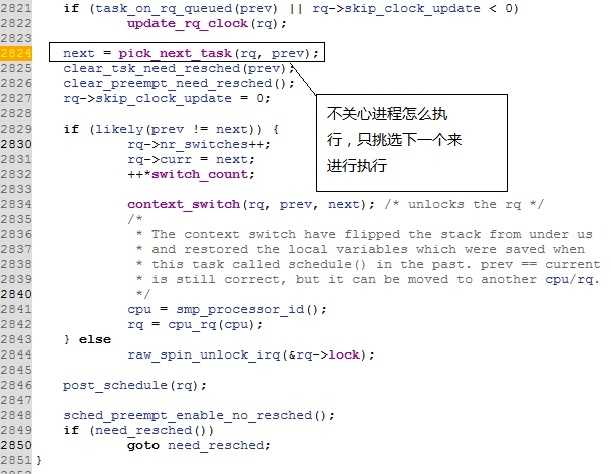

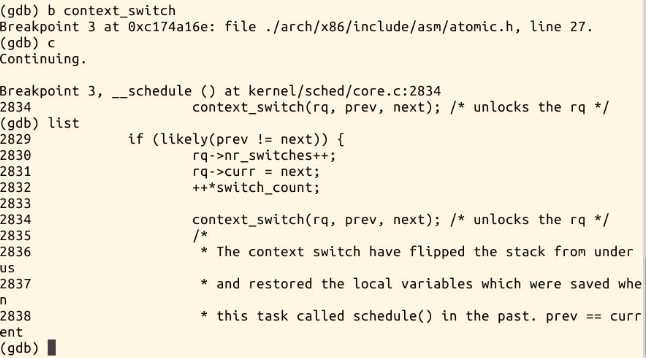

5.在context_switch处设立断点,执行

六.知识总结

进程调度程序是内核重要的组成部分,因为运行着的进程首先在使用计算机(至少在我们大多数人看来)。然而,满足进程调度的各种需要绝不是轻而易举的,很难找到“一刀切”的算棒,既适合众多的可运行进程,又具有可伸缩性,还能在调度周期和吞吐量之间求得平衡,同时还满足各种负载的需求。不过, Linux 内核的新CFS 调度程序尽量满足了各个方面的需求,并以较完善的可伸缩性和新颖的方挫提供了最佳的解决方案。前面的章节覆盖了进程管理的相关内容,本章则考察了进程调度所遵循的基本原理、具体实现、调度算能以及目前Linux 内核所使用的接口。

标签:task 解决方案 集合 sha read 环境 context 网络 ice

原文地址:http://www.cnblogs.com/sky-heaven/p/7225579.html