标签:class __name__ self 循环 find 过程 name driver names

程序说明:抓取斗鱼直播平台的直播房间号及其观众人数,最后统计出某一时刻的总直播人数和总观众人数。

过程分析:

一、进入斗鱼首页http://www.douyu.com/directory/all

进入平台首页,来到页面底部点击下一页,发现url地址没有发生变化,这样的话再使用urllib2发送请求将获取不到完整数据,这时我们可以使用selenium和PhantomJS来模拟浏览器点击下一页,这样就可以获取完整响应数据了。

首先检查下一页元素,如下:

<a href="#" class="shark-pager-next">下一页</a>

使用selenium和PhantomJS模拟点击,代码如下:

from selenium import webdriver # 使用PhantomJS浏览器创建浏览器对象 driver = webdriver.PhantomJS() # 使用get方法加载页面 driver.get("https://www.douyu.com/directory/all") # class="shark-pager-next"是下一页按钮,click() 是模拟点击 driver.find_element_by_class_name("shark-pager-next").click() # 打印页面页面查看 print driver.page_source

这样就可以通过设置一个循环条件,一直点击下去,直到页面加载完。循环终止的条件为最后一页,进入最后一页,检查下一页元素:

<a href="#" class="shark-pager-next shark-pager-disable shark-pager-disable-next">下一页</a>

对比发现:当出现"shark-pager-disable-next",下一页无法点击,这就是循环停止的条件。

# 如果在页面源码里没有找到"shark-pager-disable-next",其返回值为-1,可依次作为判断条件 driver.page_source.find("shark-pager-disable-next")

二,对要提取的内容进行分析

查看直播房间名称的元素,得到如下结果:

<span class="dy-name ellipsis fl">AI冬Ming</span>

使用BeatuifulSoup获取元素,代码如下:

# 房间名 names = soup.find_all("span", {"class" : "dy-name ellipsis fl"})

查看观看人数的元素,得到如下结果:

<span class="dy-num fr">75.6万</span>

使用BeatuifulSoup获取元素,代码如下:

# 观众人数 numbers = soup.find_all("span", {"class" :"dy-num fr"})

具体过程大概如此,下面是完整代码:

#!/usr/bin/env python # -*- coding:utf-8 -*- from selenium import webdriver from bs4 import BeautifulSoup as bs import sys reload(sys) sys.setdefaultencoding("utf-8") class Douyu(): def __init__(self): self.driver = webdriver.PhantomJS() self.num = 0 self.count = 0 def douyuSpider(self): self.driver.get("https://www.douyu.com/directory/all") while True: soup = bs(self.driver.page_source, "lxml") # 房间名, 返回列表 names = soup.find_all("span", {"class" : "dy-name ellipsis fl"}) # 观众人数, 返回列表 numbers = soup.find_all("span", {"class" :"dy-num fr"}) for name, number in zip(names, numbers): print u"观众人数: -" + number.get_text().strip() + u"-\t房间名: " + name.get_text().strip() self.num += 1 count = number.get_text().strip() if count[-1]=="万": countNum = float(count[:-1])*10000 else: countNum = float(count) self.count += countNum # 一直点击下一页 self.driver.find_element_by_class_name("shark-pager-next").click() # 如果在页面源码里找到"下一页"为隐藏的标签,就退出循环 if self.driver.page_source.find("shark-pager-disable-next") != -1: break print "当前网站直播人数:%s" % self.num print "当前网站观众人数:%s" % self.count if __name__ == "__main__": d = Douyu() d.douyuSpider()

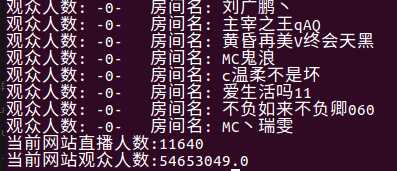

运行结果(部分展示):

Python爬虫实例(二)使用selenium抓取斗鱼直播平台数据

标签:class __name__ self 循环 find 过程 name driver names

原文地址:http://www.cnblogs.com/xinyangsdut/p/7617691.html