标签:优势 ace 著作权 blank 技术 分类 联系 分类算法 获得

该算法由facebook在2016年开源,典型应用场景是“带监督的文本分类问题”。

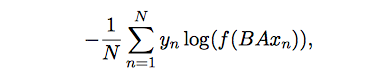

模型的优化目标如下:

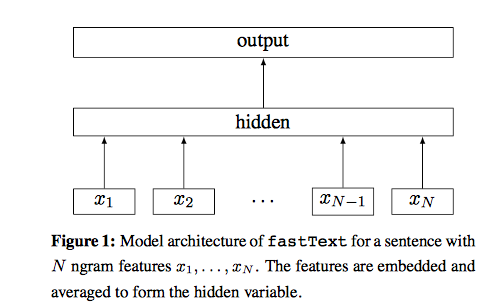

其中,$<x_n,y_n>$是一条训练样本,$y_n$是训练目标,$x_n$是normalized bag of features。矩阵参数A是基于word的look-up table,也就是A是词的embedding向量。$Ax_n$矩阵运算的数学意义是将word的embedding向量找到后相加或者取平均,得到hidden向量。矩阵参数B是函数f的参数,函数f是一个多分类问题,所以$f(BAx_n)$是一个多分类的线性函数。优化目标是使的这个多分类问题的似然越大越好。

将优化目标表示为图模型如下:

这个模型与word2vec有很多相似的地方,也有很多不相似的地方。相似地方让这两种算法不同的地方让这两

相似的地方:

不同的地方:

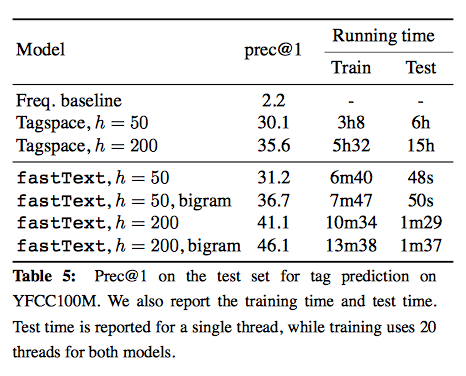

fasttext只有1层神经网络,属于所谓的shallow learning,但是fasttext的效果并不差,而且具备学习和预测速度快的优势,在工业界这点非常重要。

作者:EasonZhao

链接:http://www.jianshu.com/p/b7ede4e842f1

來源:简书

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

标签:优势 ace 著作权 blank 技术 分类 联系 分类算法 获得

原文地址:http://www.cnblogs.com/DjangoBlog/p/7903647.html