标签:并行 net lex img max 操作 网络 而不是 color

paper:https://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks

框架

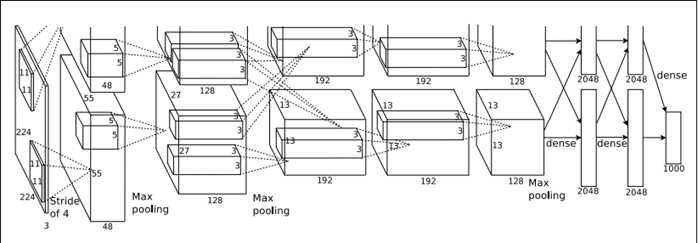

AlexNet一共有八层,包括5个卷积层和3个全连接层,其中在每一个卷积层中包含了激活函数ReLu,归一化(LRN)操作,某些层还包括pooling(池化)。总共拥有60M以上的参数总量。

AlexNet将计算出来的feature map分开在两台GPU上并行计算,但是前一层用到的数据要看连接的虚线,如图中input层之后的第一层第二层之间的虚线是分开的,是说二层上面的128map是由一层上面的48map计算的,下面同理;而第三层前面的虚线是完全交叉的,就是说每一个192map都是由前面的128+128=256map同时计算得到的。

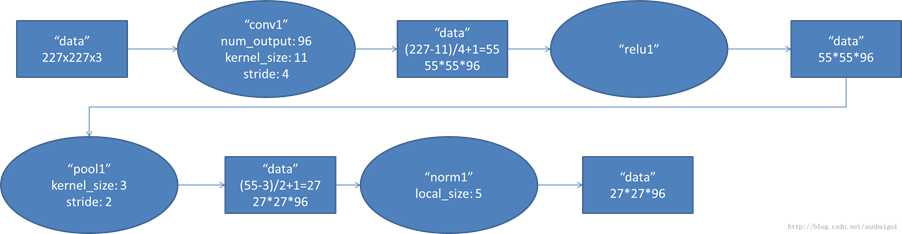

1) con-relu-pooling-LRN

具体计算都在图里面写了,要注意的是input层是227*227,而不是paper里面的224*224,这里可以算一下,主要是227可以整除后面的conv1计算,224不整除。如果一定要用224可以通过自动补边实现,不过在input就补边感觉没有意义,补得也是0。

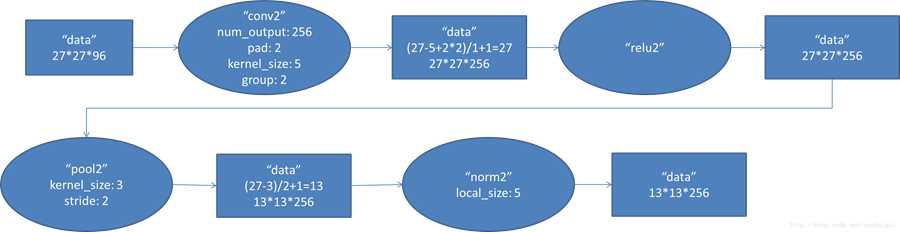

2)conv - relu - pool - LRN

和上面基本一样,唯独需要注意的是group=2,这个属性强行把前面结果的feature map分开,卷积部分分成两部分做。

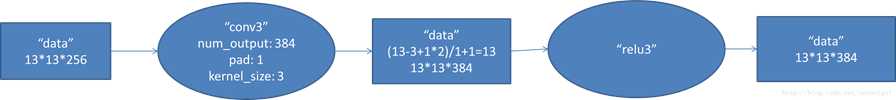

3)conv – relu

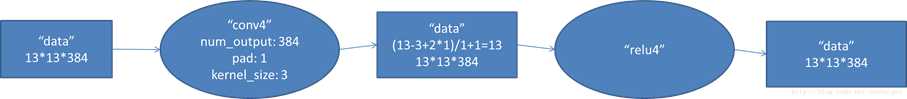

4)conv-relu

5)conv - relu - pool

6)fc - relu - dropout

这里有一层特殊的dropout层,在alexnet中是说在训练的以1/2概率使得隐藏层的某些neuron的输出为0,这样就丢到了一半节点的输出,BP的时候也不更新这些节点。

7)fc - relu - dropout

8)fc - softmax

标签:并行 net lex img max 操作 网络 而不是 color

原文地址:http://www.cnblogs.com/immersion/p/7955805.html