Squeeze-and-Excitation Networks

近些年来,卷积神经网络在很多领域都取得了巨大的突破。而卷积核作为卷积神经网络的核心,通常被看做是在局部感受野上,将空间上(spatial)的信息和特征维度上(channel-wise)的信息进行聚合的信息聚合体。卷积神经网络由一系列卷积层、非线性层和下采样层构成,这样它们能够从全局感受野上去捕获图像的特征来进行图像的描述。

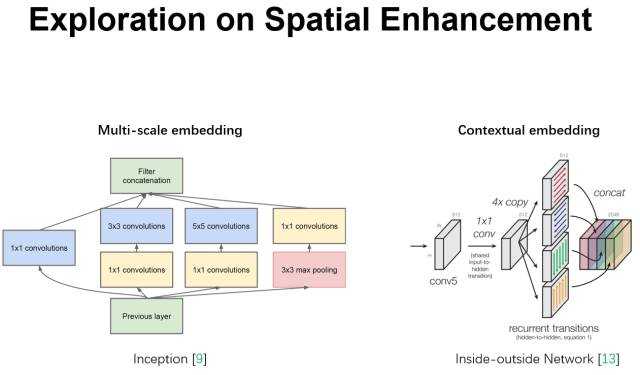

然而去学到一个性能非常强劲的网络是相当困难的,其难点来自很多方面。最近很多工作呗提出来从空间维度层面来提升网络的性能,如Inception结构中嵌入了多尺度信息,聚合多种不同感受野上的特征来获得性能增益;在Inside-Outside网络中考虑了空间中的上下文信息;还有将Attention机制引入到空间维度上等等。这些工作都获得了相当不错的成果。

可以看到,已经有很多工作在空间维度上来提升网络的性能。那么很自然的想到,网络是否可以从其他层面来考虑去提升性能,比如考虑特征通道之间的关系?论文作者的工作就是基于这一点提出了Squeeze-and-Excitation Networks(简称SEnet)。在提出的结构中,Squeeze和Excitation是两个非常关键的操作,所以作者以此来命名。作者的动机是希望显示地建模特征通道之间的相互依赖关系。另外,并不打算引入一个新的空间维度来进行特征通道间的融合,而是采用了一种全新的“特征重标定”策略。具体来说,就是通过学习的方式来自动获取到每个通道的重要程度,然后依照这个重要程度去提升有用的特征并抑制对当前任务用处不大的特征。

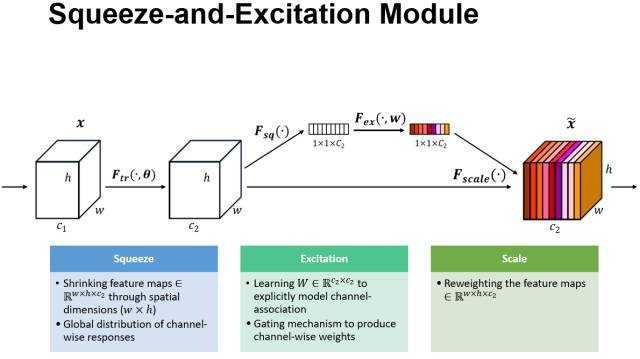

上图是作者提出的SE模块的示意图。给定一个输入X,其特征通道数为c1,通过一系列卷积等一般变换后得到一个特征通道数为c2的特征。与传统的CNN不一样的是,接下来通过三个操作来重标定前面得到的特征。

首先试Squeeze操作,顺着空间维度来进行特征压缩,将每个二维的特征通道变成一个实数,这个实数某种程度上具全局的感受野,并且输出的维度和输入的特征通道数相匹配。它表征着在特征通道上响应的全局分布,而且使得靠近输入的层也可以获得全局的感受野,这一点在很多任务中是非常有用的。

其次是Excitation操作,它是一个类似于循环神经网络中门的机制。通过参数来为每个特征通道生成权重,其中参数被学习用来显示地建模特征通道间的相关性。

最后是一个Reweight的操作,我们将Excitation的输出的权重看做是经过特征选择后的每个特征通道的重要性,然后通过乘法逐通道加权到先前的特征上,完成在通道维度上的对原始特征的重标定。

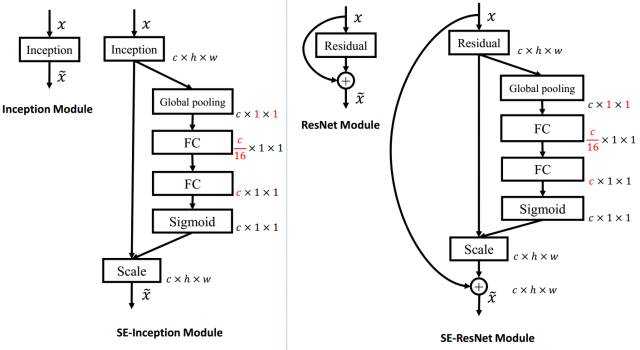

上左图是将SE模块嵌入到Inception结构的一个示例。方框旁边的维度信息代表改成的输出。这里我们使用global average pooling作为Squeeze操作。紧接着两个Fully Connected层组成一个Bottleneck结构去建模通道间的相关性,并输出和输入特征同样数目的权重。首先将特征维度降低到输入的1/16,然后经过ReLu激活后再通过一个Fully Connected层升回到原来的维度。这样比直接用一个Fully Connected层的好处在于1).具有更多的非线性,可以更好的拟合通道间复杂的相关性;2).极大的减少了参数量和计算量。然后通过sigmoid的门获得0~1之间归一化的权重,最后通过一个Scale的操作来将归一化后的权重加权到每个通道的特征上。

除此之外,SE模块还可以嵌入到含有skip-connections的模块中。上右图是将SE嵌入到ResNet模块中的例子,操作过程基本和SE-Inception一样,只不过是在Addition前对分支上的Residual的特征进行了重标定。如果对Addition后主分支上的特征进行重标定,由于在主干上存在0~1的scale操作,在网络较深BP优化时就会在靠近输入层容易出现梯度消散的情况,导致模型难以优化。

目前大多数的主流网络都是基于这两种类似的单元通过repeat方式叠加来构造的。由此可见,SE模块可以嵌入到现在几乎所有的网络结构中。通过在原始网络结构中的building block单元中嵌入SE模块,我们可以获得不同种类的SENet。如SE-BN-Inception,SE-ResNet等

从上面的介绍中可以发现,SENet构造非常简单

http://www.sohu.com/a/161793789_642762