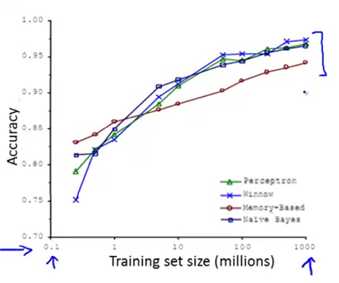

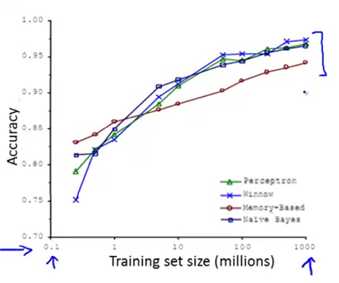

下图为四种不同算法应用在不同大小数据量时的表现,可以看出,随着数据量的增大,算法的表现趋于接近。即不管多么糟糕的算法,数据量非常大的时候,算法表现也可以很好。

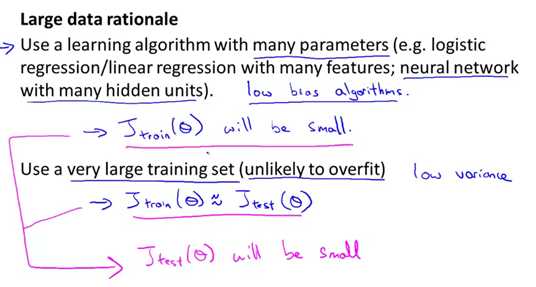

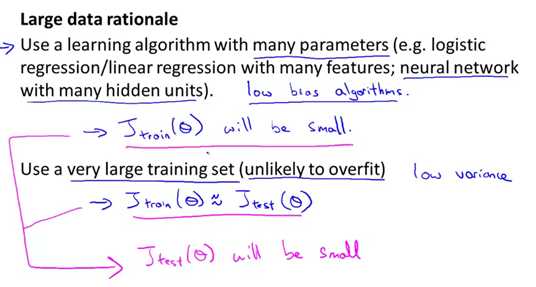

数据量很大时,学习算法表现比较好的原理:

使用比较大的训练集(意味着不可能过拟合),此时方差会比较低;此时,如果在逻辑回归或者线性回归模型中加入很多参数以及层数的话,则偏差会很低。综合起来,这会是一个很好的高性能的学习算法。

标签:过拟合 学习 http 公开课 性能 一个 模型 算法 分享图片

下图为四种不同算法应用在不同大小数据量时的表现,可以看出,随着数据量的增大,算法的表现趋于接近。即不管多么糟糕的算法,数据量非常大的时候,算法表现也可以很好。

数据量很大时,学习算法表现比较好的原理:

使用比较大的训练集(意味着不可能过拟合),此时方差会比较低;此时,如果在逻辑回归或者线性回归模型中加入很多参数以及层数的话,则偏差会很低。综合起来,这会是一个很好的高性能的学习算法。

斯坦福大学公开课机器学习:machine learning system design | data for machine learning(数据量很大时,学习算法表现比较好的原理)

标签:过拟合 学习 http 公开课 性能 一个 模型 算法 分享图片

原文地址:https://www.cnblogs.com/chenwenyan/p/8326027.html