标签:报错 阿里 集群 not health cond mes epo service

当我们将kubernetes的应用部署完之后,就需要对外发布服务的访问地址。kubernetes 将服务发布到外部访问的方式主要有:一、LoadBlancer Service

LoadBlancer Service 是 kubernetes 深度结合云平台的一个组件;当使用 LoadBlancer Service 暴露服务时,实际上是通过向底层云平台申请创建一个负载均衡器来向外暴露服务;目前 GCE、AWS、阿里云等公有云都有针对LoadBlancer Service完整的解决方案。

二、NodePort Service

因为K8s 的rc具有副本控制能力, Pod如果出现意外情况会自动销毁并重建;因此Pod 的ip地址也会跟着变化。我们可以在service中定义nodeport,在每个节点上开起一个端口,然后转发到内部 Pod IP 上。这就是所谓的NodePort Service,实质上就是在每个 node 上暴露一个端口,然后将这个端口映射到某个具体的 service 来实现的。虽然每个 node 的端口有很多(0~65535),但是由于安全性和易用性,实际上可用的端口范围为:30000-32767。如果在service指定的nodeport超过了这个范围,则会报错如下:

The Service "nginx-test" is invalid: spec.ports[0].nodePort: Invalid value: 38888: provided port is not in the valid range. The range of valid ports is 30000-32767采用这种方式存在着诸多不变:

1、首先端口数受限,使用此方式每一个node上都要开启相同的port

2、如果最终的应用访问要使用域名访问,还得在应用前端放一个nginx做转发。

又或者直接在k8s集群中部署一个nginx,将请求转发到集群内的其他服务器上,这是个好想法,但每次新增或者修改服务,都要去修改nginx配置文件,无法做到服务的自动发现,也不是最终的解决方案。

三、Ingress

Ingress 是在kubernetes 1.2版本才出现的,通过 Ingress 用户可以实现使用 nginx 等开源的反向代理负载均衡器实现对外暴露服务。使用 Ingress 时一般会有三个组件:

反向代理负载均衡器

反向代理负载均衡器通常使用nginx,部署方式可以选择 Replication Controller、Deployment、DaemonSet 等

Ingress Controller

Ingress Controller 通过连接api server,获取 service以及pod的信息,当得到这些变化信息后,Ingress Controller 再结合Ingress 生成配置,更新反向代理负载均衡器,达到服务发现的目的。

Ingress

Ingress 简单理解就是个规则定义;其本质是根据rules规则来将对应的host访问请求转发到k8s后端的services。从而实现整体的服务发现和负载均衡。

定义ingress前,必须先部署ingress controller ,以实现为所有后端的service 提供一个统一的入口。在ingress-controller的rc文件中定义了一个默认后端。所以在部署ingress controller前要先启动默认后端的pod,否则启动ingress-controller会不成功.

下面我们来介绍在k8s 1.5.2集群环境中,通过配置ingress,发布前面配置好的dashboard和nginx服务

1、默认后端的yaml文件

# cat default-backend.yaml

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: default-http-backend

labels:

k8s-app: default-http-backend

namespace: default

spec:

replicas: 1

template:

metadata:

labels:

k8s-app: default-http-backend

spec:

terminationGracePeriodSeconds: 60

containers:

- name: default-http-backend

# Any image is permissable as long as:

# 1. It serves a 404 page at /

# 2. It serves 200 on a /healthz endpoint

image: docker.io/cdchen/defaultbackend:1.0

livenessProbe:

httpGet:

path: /healthz

port: 8080

scheme: HTTP

initialDelaySeconds: 30

timeoutSeconds: 5

ports:

- containerPort: 8080

resources:

limits:

cpu: 10m

memory: 20Mi

requests:

cpu: 10m

memory: 20Mi

---

apiVersion: v1

kind: Service

metadata:

name: default-http-backend

namespace: default

labels:

k8s-app: default-http-backend

spec:

ports:

- port: 80

targetPort: 8080

selector:

k8s-app: default-http-backend2、ingress ReplicationController的yaml文件

# cat nginx-ingress-controller.yaml

apiVersion: v1

kind: ReplicationController

metadata:

name: nginx-ingress-lb

labels:

name: nginx-ingress-lb

namespace: default

spec:

replicas: 1

template:

metadata:

labels:

name: nginx-ingress-lb

annotations:

prometheus.io/port: ‘10254‘

prometheus.io/scrape: ‘true‘

spec:

terminationGracePeriodSeconds: 60

hostNetwork: true

containers:

- image: docker.io/cdchen/nginx-ingress-controller:0.9.0-beta.12

name: nginx-ingress-lb

readinessProbe:

httpGet:

path: /healthz

port: 10254

scheme: HTTP

livenessProbe:

httpGet:

path: /healthz

port: 10254

scheme: HTTP

initialDelaySeconds: 10

timeoutSeconds: 1

ports:

- containerPort: 80

hostPort: 80

- containerPort: 443

hostPort: 443

env:

- name: POD_NAME

valueFrom:

fieldRef:

fieldPath: metadata.name

- name: POD_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

- name: KUBERNETES_MASTER

value: http://192.168.115.5:8080

args:

- /nginx-ingress-controller

- --default-backend-service=$(POD_NAMESPACE)/default-http-backend

- --apiserver-host=http://192.168.115.5:80803、Dashboard 和 nginx的ingress yaml文件

# cat k8s-dashboard.yaml

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: k8s-dashboard-ingress

namespace: default

spec:

rules:

- host: k8s.webui

http:

paths:

- path: /

backend:

serviceName: kubernetes-dashboard

servicePort: 80# cat k8s-nginx-test.yaml

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: k8s-nginx-test

namespace: default

spec:

rules:

- host: test.fjhb.cn

http:

paths:

- path: /

backend:

serviceName: nginx-test

servicePort: 804、通过上述yaml文件创建对应的pod、rc及ingress

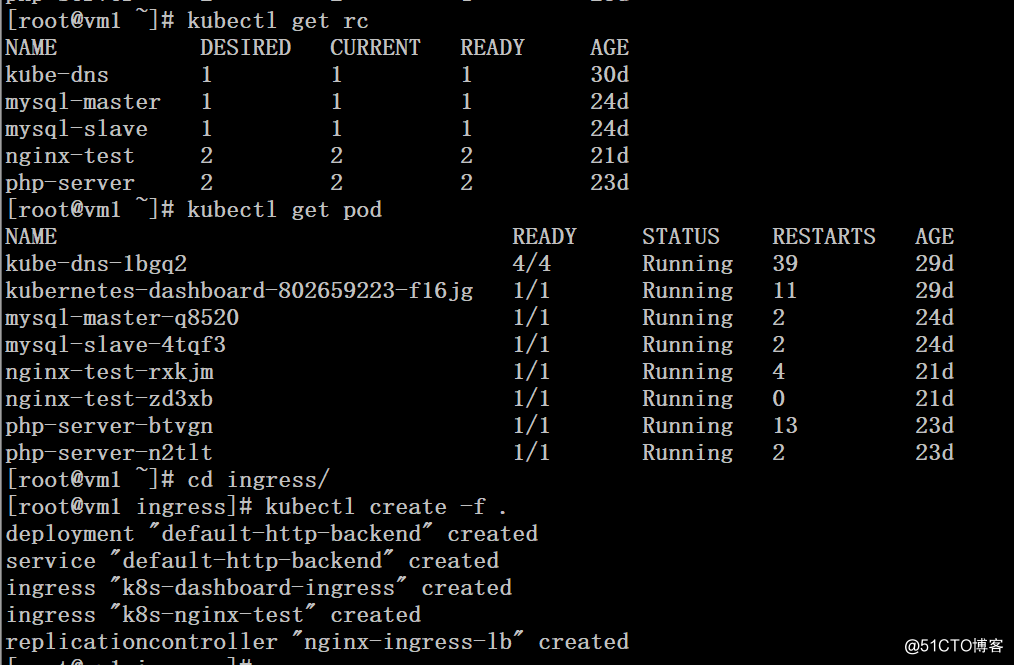

# kubectl get rc

# kubectl get pod

# cd ingress/

# kubectl create -f .

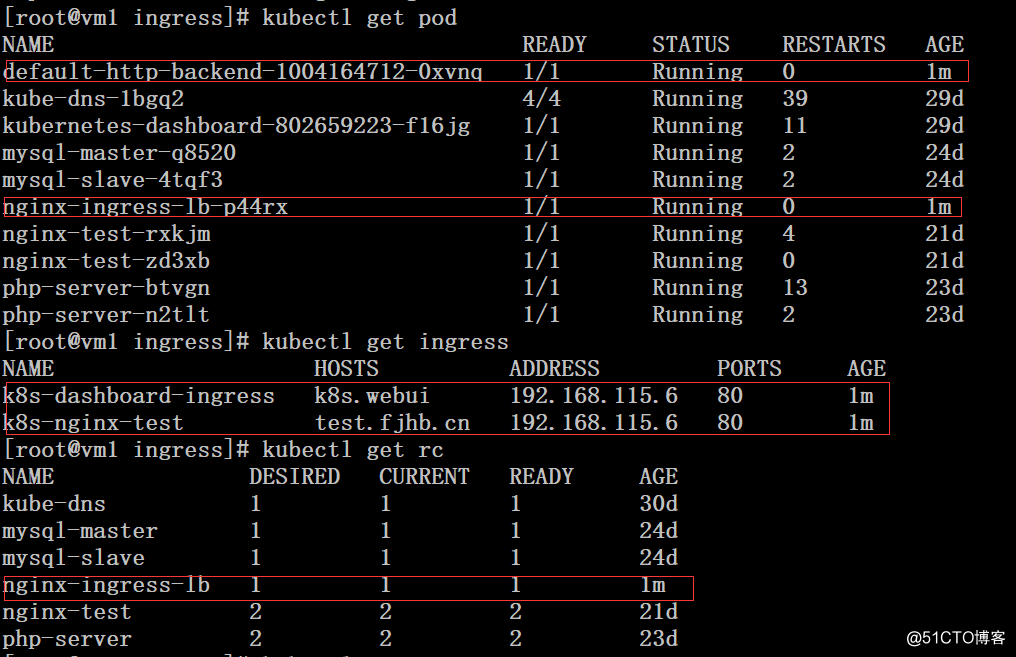

# kubectl get pod

# kubectl get ingress

# kubectl get rc

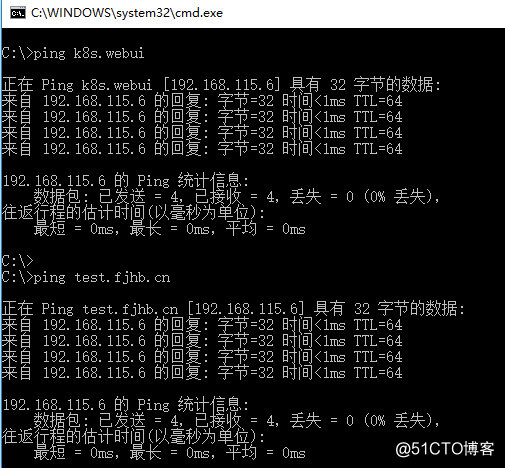

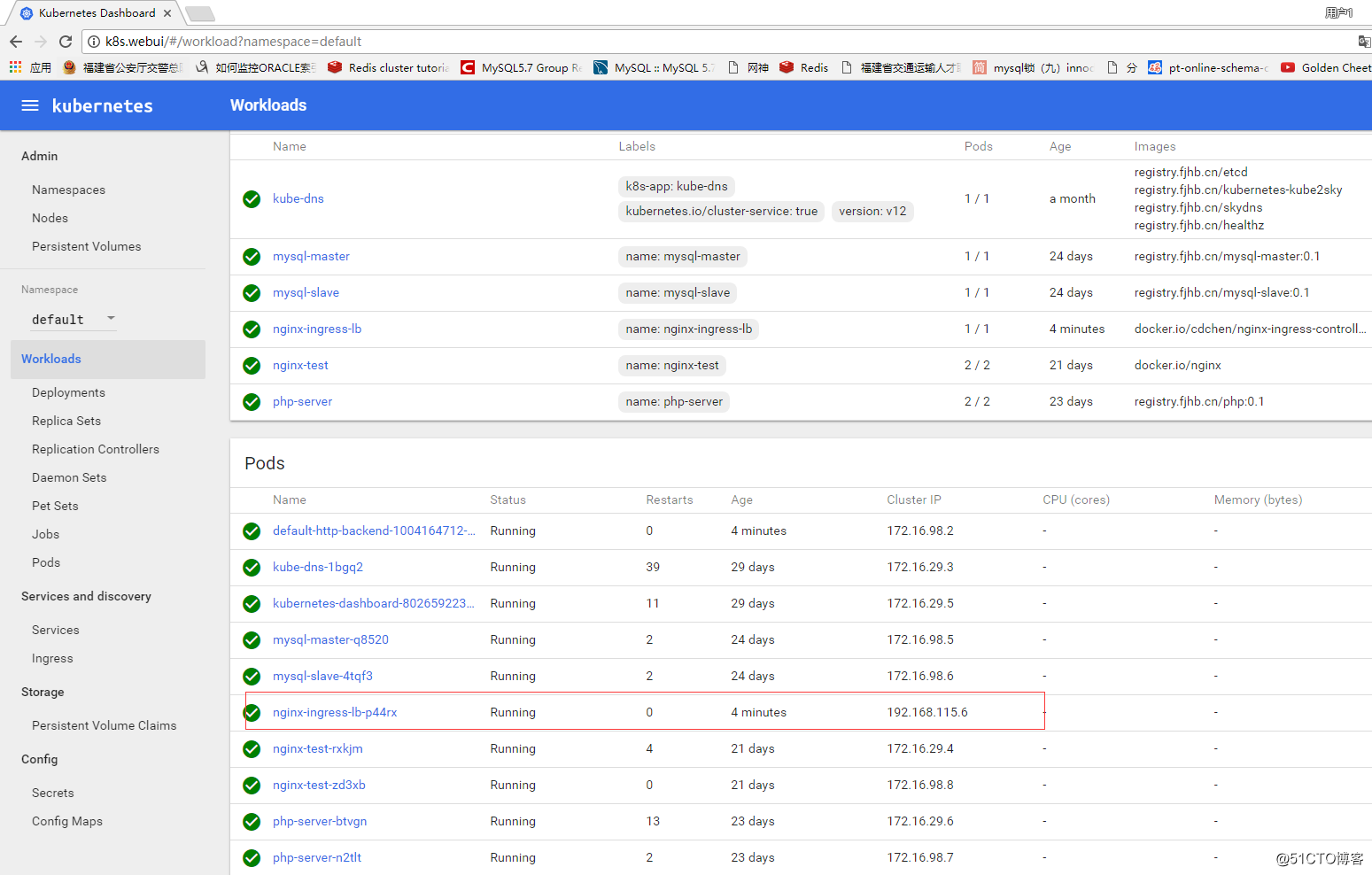

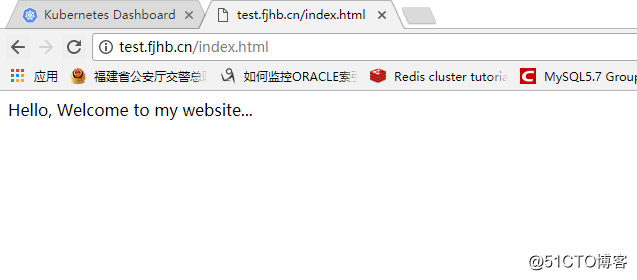

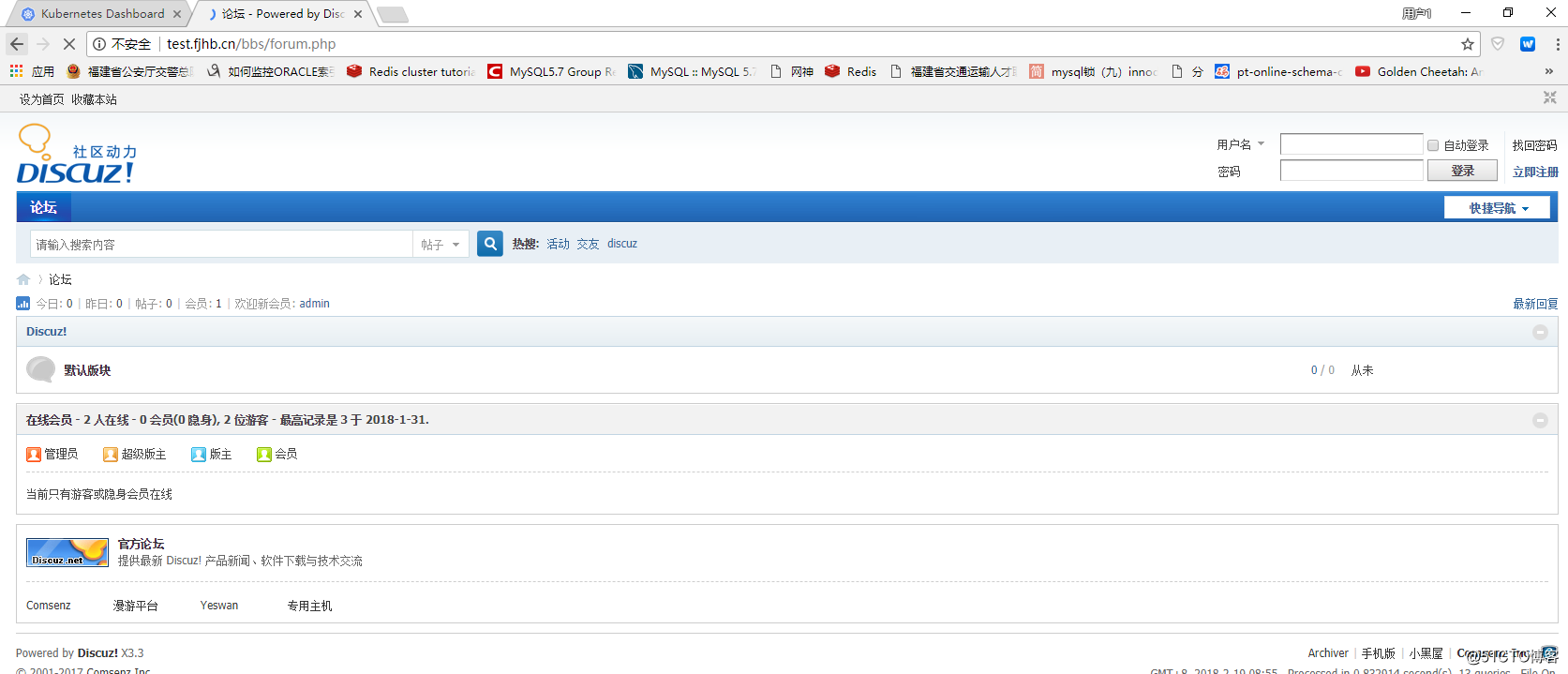

5、访问测试

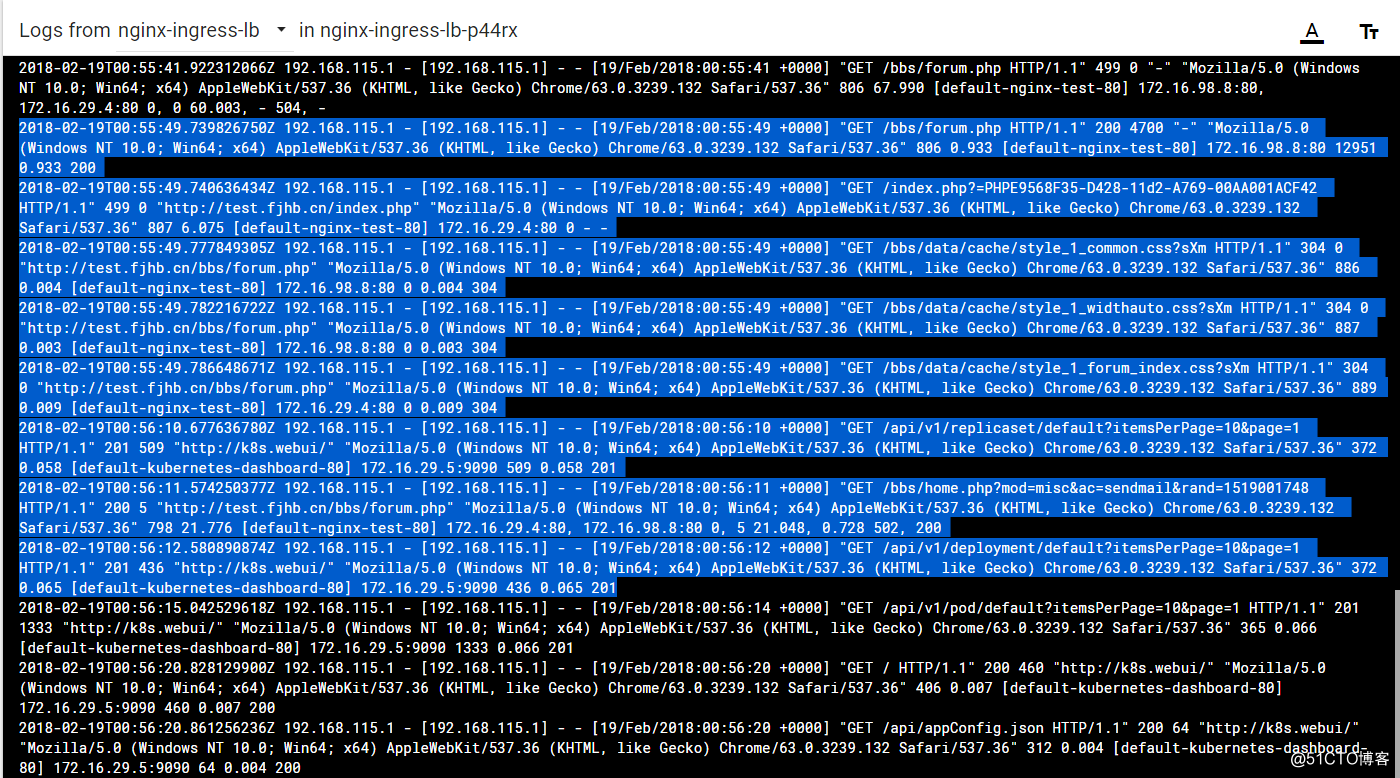

也可以通过查看nginx-ingress-lb pod的日志来验证。

标签:报错 阿里 集群 not health cond mes epo service

原文地址:http://blog.51cto.com/ylw6006/2072316