标签:函数 需要 led 研究 nbsp 作者 network 提高 好的

概述

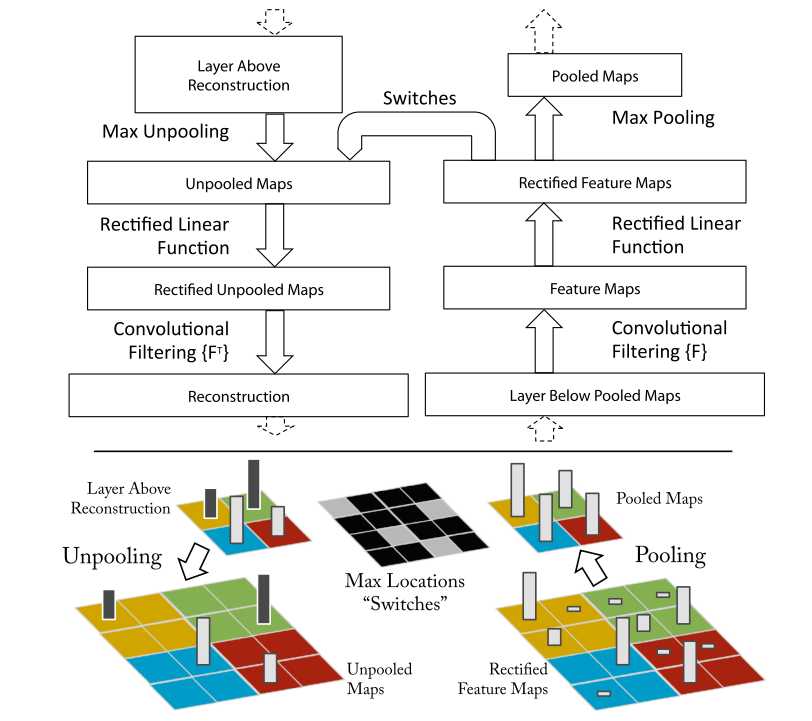

卷积网络就是网络利用学习到的卷积核对上一层的特征进行卷积得到本层的feature map。而反卷积就是这个过程的逆过程,用本层的feature map与转置后的卷积核进行卷积,得到上一层的特征。

2. 可视化结果

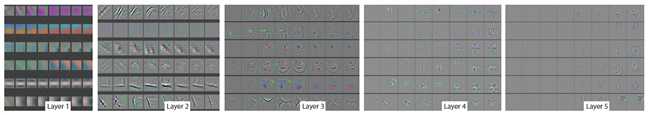

从上图可是化的结果中,我们可以看出,不同层的layer学习到的是不同的特征。对于Layer1和Layer2来说,网络学习到的基本上是边缘、颜色等图像中底层的特征;Layer3开始可以学习到一些复杂些的特征,类似网格纹理等;Layer4可以学习到更高维的特征,比如说狗头、鸟类的脚、同心环等;Layer5则是更加具有辨别性的关键特征。

上图展示了网络中各个特征层是如何随着训练步数而进化的。各子图中每列分别代表训练了[1,2,5,10,20,30,40,64]个epoch。可以看出,对于较低的特征层来说,它们的特征很快就学到并稳定下来了。而对于像Layer5这样比较高维的特征层来说,则是在学习了30个epoch后才学习到了比较有辨别性的关键特征。说明训练步数的增加还是能够比较好地提升网络的学习和收敛能力的。

作者可视化了原版AlexNet各特征层,发现了对于AlexNet来说,第一层的卷积核大部分是高频和低频的特征,而对中频段图像特征整提取得不好。同时,第二层特征的可视化的结果显示出了由于第一层卷积步长太大(4)导致的“ 混叠伪影”。因此作者对AlexNet的改善包括:将第一层的卷积核从11x11减小为7x7;将卷积步长减小为2,而不是4。经过作者改善后的模型在ImageNet2012的分类误差均比AlexNet有提高。

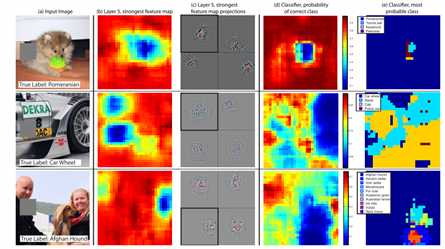

作者用消融分析对三张图进行了分析,发现当遮挡掉图片中的关键部位后,相关卷积核卷出来的特征激励会大幅变小(上图第二列)。同时发现遮挡掉关键部位后,网络很容易将图片放入错误的分类中去,而遮挡一些背景部位则不会(第五列)。

这篇文章是CNN网络可视化相关研究非常重要的一篇文章,在这之后的许多研究工作都基于了这篇文章的成果。所以说是研究CNN 网络可视化的必读文献也不为过。

参考资料:

1. http://blog.csdn.net/hjimce/article/details/50544370

2. Zeiler, M. D. and Fergus, R. Visualizing and understanding convolutional networks. In ECCV, 2014.

[论文解读]CNN网络可视化——Visualizing and Understanding Convolutional Networks

标签:函数 需要 led 研究 nbsp 作者 network 提高 好的

原文地址:https://www.cnblogs.com/rocklamighty/p/9074083.html