标签:auto 详解 class 去除 csdn 返回值 def 区域 rect

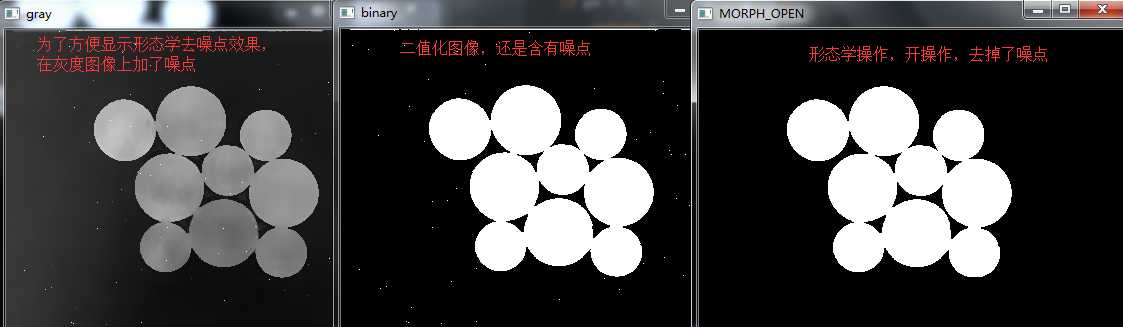

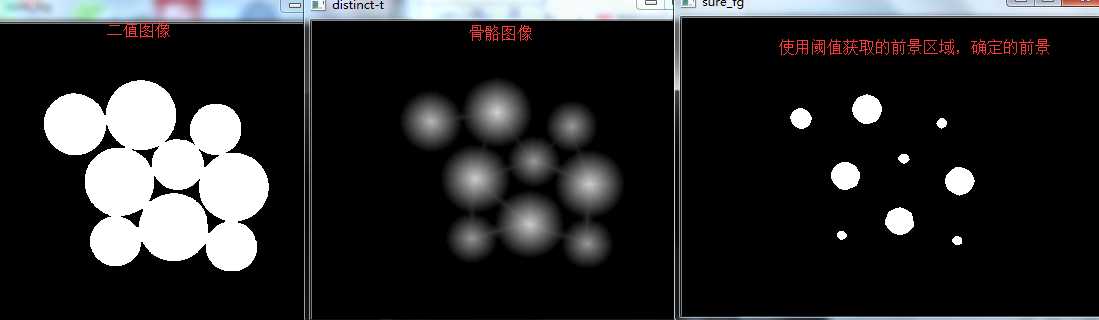

def watershed_demo(image): blur = cv.pyrMeanShiftFiltering(image,10,100) gray = cv.cvtColor(blur,cv.COLOR_BGR2GRAY) #获取灰度图像 ret,binary = cv.threshold(gray,0,255,cv.THRESH_BINARY|cv.THRESH_OTSU) #将图像转为黑色和白色部分 cv.imshow("binary",binary) #获取二值化图像

#形态学操作,进一步消除图像中噪点 kernel = cv.getStructuringElement(cv.MORPH_RECT,(3,3)) mb = cv.morphologyEx(binary,cv.MORPH_OPEN,kernel,iterations=2) #iterations连续两次开操作,消除图像的噪点

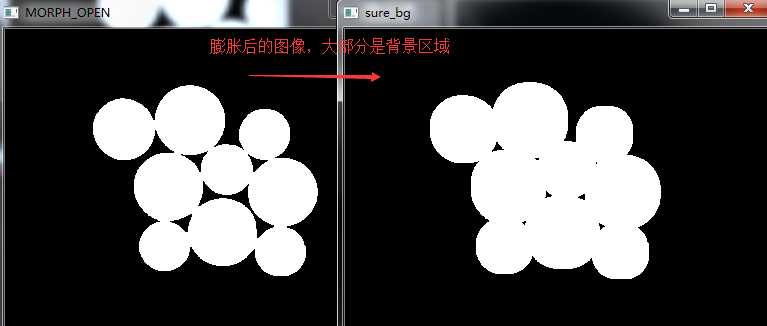

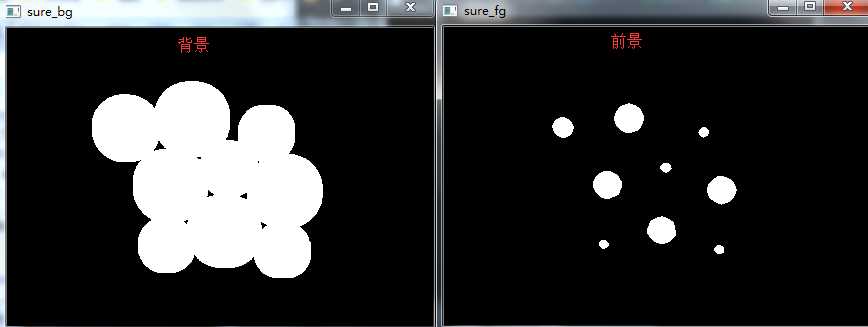

sure_bg = cv.dilate(mb,kernel,iterations=3) #3次膨胀,可以获取到大部分都是背景的区域

根据distanceTransform获取距离背景最小距离的结果(详细看下面相关知识补充)

根据distanceTransform操作的结果,设置一个阈值,使用threshold决定哪些区域是前景,这样得到正确结果的概率很高

dist = cv.distanceTransform(mb,cv.DIST_L2,5) #获取距离数据结果 ret, sure_fg = cv.threshold(dist,dist.max()*0.6,255,cv.THRESH_BINARY) #获取前景色

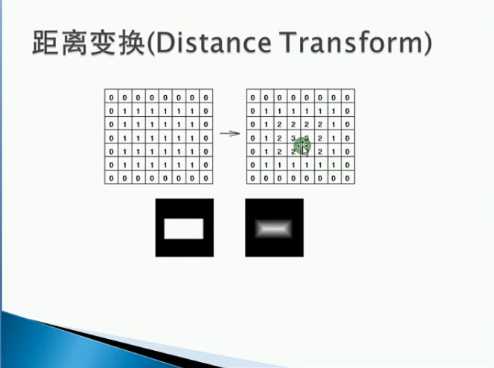

(1)距离变换原理

推文:图像识别中距离变换的原理及作用详解,并附用OpenCV中的distanceTransform实现距离变换的代码!(距离变换的定义讲得不错)

距离变换的处理图像通常都是二值图像,而二值图像其实就是把图像分为两部分,即背景和物体两部分,物体通常又称为前景目标!

通常我们把前景目标的灰度值设为255,即白色

背景的灰度值设为0,即黑色。

所以定义中的非零像素点即为前景目标,零像素点即为背景。

所以图像中前景目标中的像素点距离背景越远,那么距离就越大,如果我们用这个距离值替换像素值,那么新生成的图像中这个点越亮。

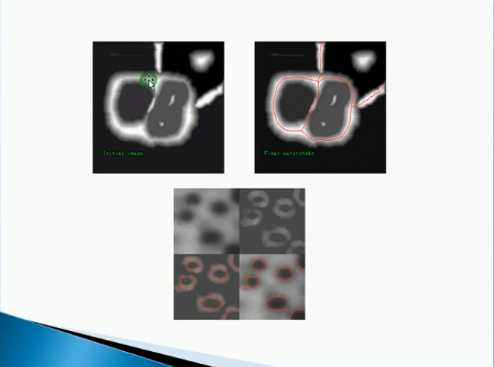

再通过设定合理的阈值对距离变换后的图像进行二值化处理,则可得到去除手指的图像(如下图“bidist”窗口图像所示),手掌重心即为该图像的几何中心。

主要用于计算非零像素到最近零像素点的最短距离。一般用于求解图像的骨骼

def distanceTransform(src, distanceType, maskSize, dst=None, dstType=None): # real signature unknown; restored from __doc__

src:输入的图像,一般为二值图像 distanceType:所用的求解距离的类型,有CV_DIST_L1, CV_DIST_L2 , or CV_DIST_C mask_size:距离变换掩模的大小,可以是 3 或 5. 对 CV_DIST_L1 或 CV_DIST_C 的情况,参数值被强制设定为 3, 因为 3×3 mask 给出 5×5 mask 一样的结果,而且速度还更快。

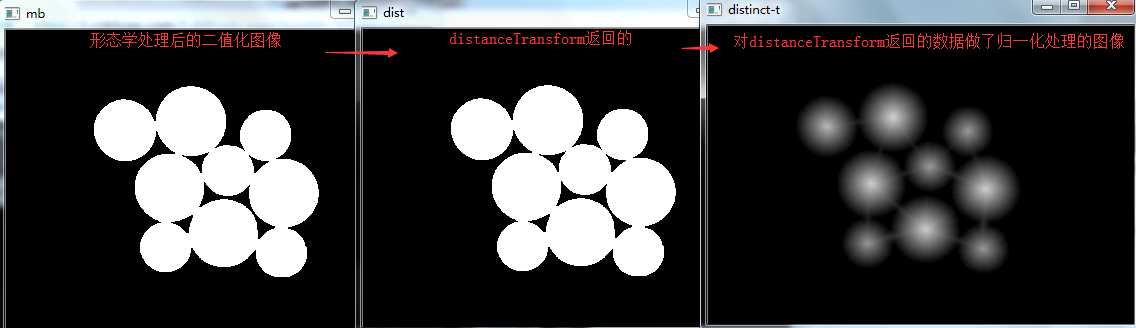

(3)若是想骨骼显示(对我们的分水岭流程无影响),我们需要对distanceTransform返回的结果进行归一化处理,使用normalize

因为distanceTransform返回的图像数据是浮点数值,要想在浮点数表示的颜色空间中,数值范围必须是0-1.0,所以要将其中的数值进行归一化处理

(重点)在整数表示的颜色空间中,数值范围是0-255,但在浮点数表示的颜色空间中,数值范围是0-1.0,所以要把0-255归一化。

顺便补充:若是不做归一化处理,数值大于1的都会变为1.0处理

mb = cv.morphologyEx(binary,cv.MORPH_OPEN,kernel,iterations=2) #iterations连续两次开操作 cv.imshow("mb", mb) #这是我们形态学开操作过滤噪点后的图像,暂时可以看做源图像 #距离变换 dist = cv.distanceTransform(mb,cv.DIST_L2,5) #这是我们获取的字段距离数值,对应每个像素都有,所以数组结构和图像数组一致 cv.imshow("dist",dist) dist_output = cv.normalize(dist,0,1.0,cv.NORM_MINMAX) #归一化的距离图像数组

cv.imshow("distinct-t",dist_output*50)

发现了似乎distanceTransform返回的图像和源图像一样,似乎出错了

原因:因为distanceTransform返回的是浮点型色彩空间,而dist中存放的数距离0值的最小距离,大多是大于1.0的数值,

而上面提到浮点型色彩空间数值范围0-1.0,当数值大于1.0都会被设置为1.0,显示白色,所以和原来的二值化图像一致,

我们要想显示骨骼,必须先进行归一化处理

下面是从二值化图像源,distanceTransform距离数组,和归一化距离数组中获取的一段像素数组

print(mb[150][120:140]) print(dist[150][120:140]) print(dist_output[150][120:140])

整数型色彩空间二值化图像

[ 0 0 0 0 0 0 0 0 0 255 255 255 255 255 255 255 255 255 255 255]

浮点型色彩空间最小距离数组,由于数值大于1.0都会被设置为1.0,所以和上面二值化图像一致 [ 0. 0. 0. 0. 0. 0. 0. 0. 0. 1. 1.4 2.1969 3.1969 4.1969 5.1969 6.1969 7.1969 8.196899 9.196899 10.187599]

浮点型色彩空间归一化数组图像,显示骨骼 [0. 0. 0. 0. 0. 0. 0. 0. 0. 0.00047065 0.0006589 0.00103396 0.00150461 0.00197525 0.00244589 0.00291654 0.00338719 0.00385783 0.00432847 0.00479474]

注1:

这里是求取硬币偏白色,使用THRESH_BINARY,所以我们获取对象是白色区域,是获取未重合部分

若是我们求取树叶等偏黑,需要使用THRESH_BINARY_INV,此时我们获取的对象是黑色区域,就变为了获取重合部分了

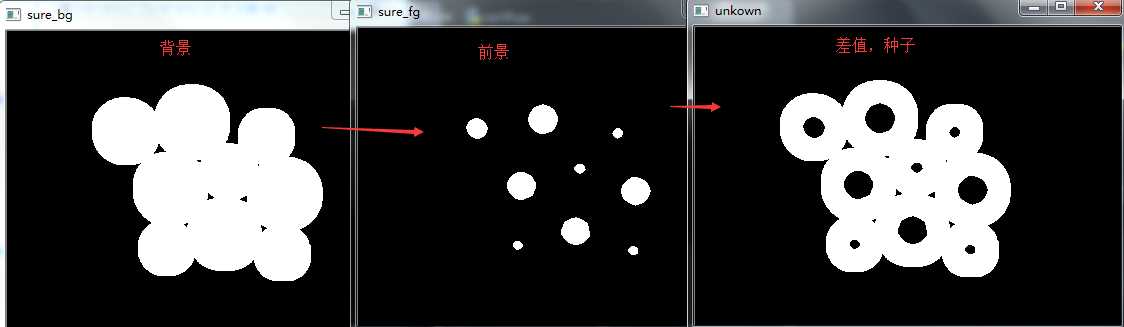

surface_fg = np.uint8(sure_fg) #保持色彩空间一致才能进行运算,现在是背景空间为整型空间,前景为浮点型空间,所以进行转换 unknown = cv.subtract(sure_bg,surface_fg) cv.imshow("unkown",unknown)

使用print查看背景前景色彩空间不同 print(sure_fg[150][120:140]) print(sure_bg[150][120:140]) --------------------------------------- [0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0.] [ 0 0 0 0 0 0 255 255 255 255 255 255 255 255 255 255 255 255 255 255]

推文:基于矩阵实现的Connected Components算法

利用connectedComponents求图中的连通图

现在知道了那些是背景那些是硬币(确定的前景区域)了。

那我们就可以创建标签(一个与原图像大小相同,数据类型为 in32 的数组),并标记其中的区域了。

对我们已经确定分类的区域(无论是前景还是背景)使用不同的正整数标记,对我们不确定的区域(unknown区域)使用 0 标记。

我们可以使用函数 cv2.connectedComponents()来做这件事。

它会把对标签进行操作,将背景标记为 0,其他的对象使用从 1 开始的正整数标记(其实这就是我们的种子,水漫时会从这里漫出)。然后将这个标签返回给我们markers 但是,我们知道如果背景标记为 0,那分水岭算法就会把它当成未知区域了。(我们要将未知区域标记为0,所以我们要将背景区域变为其他整数,例如+1)

所以我们想使用不同的整数标记它们。

而对不确定的区域(函数cv2.connectedComponents 输出的结果中使用 unknown 定义未知区域)标记为 0。

#获取mask

ret,markers = cv.connectedComponents(surface_fg)

函数原型:

def connectedComponents(image, labels=None, connectivity=None, ltype=None): # real signature unknown; restored from __doc__

参数image是需要进行连通域处理的二值图像,其他的这里用不到

返回值:

ret是连通域处理的边缘条数,是上面提到的确定区域(出去背景外的其他确定区域:就是前景),就是种子数,我们会从种子开始向外涨水

markers是我们创建的一个标签(一个与原图像大小相同,数据类型为 in32 的数组),其中包含有我们原图像的确认区域的数据(前景区域)

[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 #0是我们的背景区域 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 2 2 #像这些以1开始的整数就是我们确定的前景区域,就是我们要找的种子 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0]

watershed漫水算法需要我们将栅栏区域设置为0,所以我们需要将markers中背景区域(原来为0,会干扰算法)设置为其他整数。

解决方法将markers整体加一 #此时种子区域不止我们原来的前景区域,有增加了一个背景区域,我们将从这些区域一起灌水

markers = markers + 1 markers[unknown==255] = 0

markers = cv.watershed(image,markers=markers) #获取栅栏 image[markers==-1] = [0,0,255] #根据栅栏,我们对原图像进行操作,对栅栏区域设置为红色

[-1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 -1 #漫水算法会将找到的栅栏设置为-1 -1 -1 -1 -1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 -1 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 -1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 -1]

import cv2 as cv import numpy as np def watershed_demo(image): blur = cv.pyrMeanShiftFiltering(image,10,100) gray = cv.cvtColor(blur,cv.COLOR_BGR2GRAY) #获取灰度图像 ret,binary = cv.threshold(gray,0,255,cv.THRESH_BINARY|cv.THRESH_OTSU) #形态学操作,进一步消除图像中噪点 kernel = cv.getStructuringElement(cv.MORPH_RECT,(3,3)) mb = cv.morphologyEx(binary,cv.MORPH_OPEN,kernel,iterations=2) #iterations连续两次开操作 sure_bg = cv.dilate(mb,kernel,iterations=3) #3次膨胀,可以获取到大部分都是背景的区域 cv.imshow("sure_bg",sure_bg) #距离变换 dist = cv.distanceTransform(mb,cv.DIST_L2,5) cv.imshow("dist",dist) dist_output = cv.normalize(dist,0,1.0,cv.NORM_MINMAX) # print(mb[150][120:140]) # print(dist[150][120:140]) # print(dist_output[150][120:140]) cv.imshow("distinct-t",dist_output*50) ret, sure_fg = cv.threshold(dist,dist.max()*0.6,255,cv.THRESH_BINARY) cv.imshow("sure_fg",sure_fg) # print(sure_fg[150][120:140]) # print(sure_bg[150][120:140]) #获取未知区域 surface_fg = np.uint8(sure_fg) #保持色彩空间一致才能进行运算,现在是背景空间为整型空间,前景为浮点型空间,所以进行转换 unknown = cv.subtract(sure_bg,surface_fg) cv.imshow("unkown",unknown) #获取maskers,在markers中含有种子区域 ret,markers = cv.connectedComponents(surface_fg) #print(ret) #分水岭变换 markers = markers + 1 markers[unknown==255] = 0 markers = cv.watershed(image,markers=markers) image[markers==-1] = [0,0,255] cv.imshow("result",image) src = cv.imread("./c.png") #读取图片 cv.namedWindow("input image",cv.WINDOW_AUTOSIZE) #创建GUI窗口,形式为自适应 cv.imshow("input image",src) #通过名字将图像和窗口联系 watershed_demo(src) cv.waitKey(0) #等待用户操作,里面等待参数是毫秒,我们填写0,代表是永远,等待用户操作 cv.destroyAllWindows() #销毁所有窗口

标签:auto 详解 class 去除 csdn 返回值 def 区域 rect

原文地址:https://www.cnblogs.com/ssyfj/p/9278815.html