标签:存在 语言 解决 compute 一个 语音 com inf 依赖

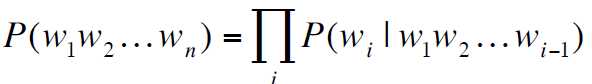

旨在:给一个句子或一组词计算一个联合概率![]()

作用:

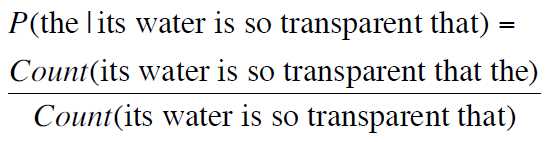

相关任务:在原句子的基础上,计算一个新词的条件概率![]() ,该概率与P(w1w2w3w4w5)息息相关。

,该概率与P(w1w2w3w4w5)息息相关。

任何一个模型计算以上两个概率的,我们都称之为语言模型LM。

方法:依赖概率的链式规则![]()

从而有:

问题:如何预估这些概率

方法一:计数和细分

但是不可能做到!

原因:句子数量过于庞大;永远不可能有足够的数据来预估这些(语料库永远不可能是完备的)

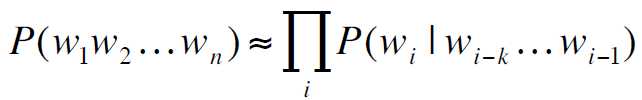

方法二:马尔可夫假设

![]()

或者:

![]()

即:

所以:

![]()

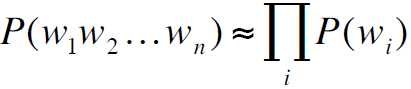

1. Unigram model

其假设词是相互独立的

2. Bigram model

![]()

3. N-gram models

但是并不有效,因为语言本身存在长距离依存关系

比如"The computer which ......crashed" 单词crash本身其实是依赖于主语computer的,但是中间隔了一个很长的从句,在马尔可夫模型中就很难找到这样的依存关系

但是在实际应用中,发现N-gram可以一定程度上解决这个问题

标签:存在 语言 解决 compute 一个 语音 com inf 依赖

原文地址:https://www.cnblogs.com/a-present/p/9424937.html