标签:next bsp 感受 最优 src 技术 ati 分享图片 思想

1.GoogleNet 网络:

Inception V1 - Inception V2 - Inception V3 - Inception V4

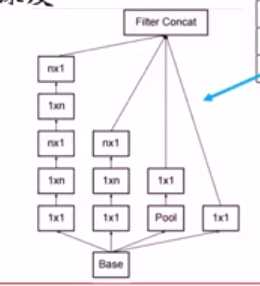

1. Inception v1

split - merge - 1*1卷积,3*3卷积, 5*5卷积, 3*3池化

输入层:inception

1*1 卷积

1*1卷积 - 3*3卷积

1*1卷积 - 5*5卷积

3*3 maxpooling - 1*1 卷积

2个辅助分类器

深网络中,梯度回传到最初几层,存在严重消失问题

有效加速收敛

测试阶段不适用

2. inception v2

采用了Batch Normalization(批归一化),使得输出规划到(0, 1)

对每一个特征通道做归一化, 归一化是进行中心化和标准化

x1 = (x-u) / б

y(k) = y(k) * x1(k) + β(k)

training:

每个batch中k组均值-标准差会被存储

testing:

无batch, 将所有的Kzu均值-标准差分别求平均,使用这K组平均

3. Inception v3

核心组件

非对称卷积: N*N 分解成1*N 和 N * 1

4. Inception v4

添加了一个残差神经网络的直连思想

2.ResNet 残差网络

可以拟合任意目标映射F(x), H(x) = F(x) + x

F(x)是残差映射

当H(x) 最优映射接近Identity, 容易捕捉到很小的扰动

X - weight layer - relu - weight layer -relu -

Y - weight layer - relu - weight layer - relu - , 直接从Y到达后面实现直连

其他设计:

全是3*3卷积核

卷积步长2取代池化

使用batch Normalization

取消:

Max池化

全连接

dropout

3. ResNext网络

提出了第三个维度

策略:将卷积核按通道分组,形成32个并行分支

低维度卷积,进行特征变化

加法合并

4. CNN设计准则

避免信息瓶颈

卷积过程中

空间尺寸 H * W 变小

输出通道C变多

数据量H*W*C要缓慢变小

通道数量保持在可控范围内

感受野在前期要足够大

在后面几层使用多个尺寸的卷积核

CNN 设计准则

分组策略 采用通道分解(resnext)- 降低计算量

低秩分解 - 3*3*c*k - 1*3*c*k 和 3*1*c*k

跟我学算法-图像识别之图像分类(下)(GoogleNet网络, ResNet残差网络, ResNext网络, CNN设计准则)

标签:next bsp 感受 最优 src 技术 ati 分享图片 思想

原文地址:https://www.cnblogs.com/my-love-is-python/p/9794998.html