标签:url 爬虫 分析 规则 咨询公司 code 就会 第三方 如何获取

目录

“大数据时代”,数据获取的方式:

抓取网页数据的程序

首先需要了解网页的三大特征:

URL(统一资源定位符)来定位HTML(超文本标记语言)来描述页面信息HTTP/HTTPS(超文本传输协议)来传输HTML数据爬虫的设计思路:

URL地址HTTP/HTTPS协议来获取对应的HTML页面HTML页面内有用的数据:a. 如果是需要的数据--保存

b. 如果有其他URL,继续执行第二步

| 语言 | 优点 | 缺点 |

|---|---|---|

| PHP | 世界上最好的语言 | 对多线程,异步支持不好,并发处理不够 |

| Java | 网络爬虫生态圈完善 | Java语言本身笨重,代码量很大,数据重构成本高 |

| C/C++ | 运行效率和性能几乎最强 | 学习成本很高 |

| python | 语法优美,代码简洁,开发效率高,模块多 |

HTML页面:urllib, urlib2, requestsre, xpath, BeautifulSoup(bs4), jsonpath, pyquery等HTML,验证码的处理Selenium + PhantomJS:模拟真实浏览器加载JSTesseract机器学习库,机器图像识别系统Scrapy框架:twisted)->数据下载快scrapy redis:在scarpy基础上添加了以redis数据库为核心的一套组件,主要在redis做请求指纹去重、请求分配、数据临时存储User-Agent, 代理, 验证码, 动态数据加载, 加密数据1.定义: 搜索引擎用的爬虫系统

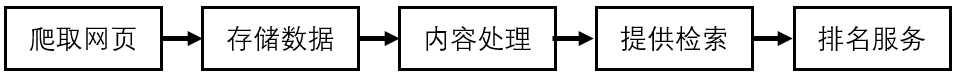

2.目标: 把所有互联网的网页爬取下来,放到本地服务器形成备份,在对这些网页做相关处理(提取关键字,去除广告),最后提供一个用户可以访问的借口

3.抓取流程:

a) 首先选取一部分已有的URL, 把这些URL放到带爬取队列中

b) 从队列中取出来URL,然后解析NDS得到主机IP,然后去这个IP对应的服务器里下载HTML页面,保存到搜索引擎的本地服务器里,之后把爬过的URL放入已爬取队列

c) 分析网页内容,找出网页里其他的URL连接,继续执行第二步,直到爬取结束

4.搜索引擎如何获取一个新网站的URL:

5.通用爬虫注意事项

通用爬虫并不是万物皆可以爬,它必须遵守规则:

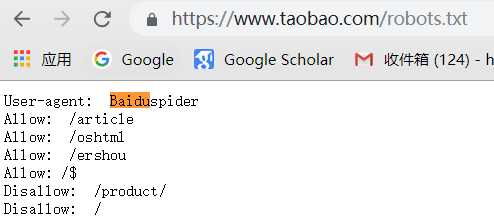

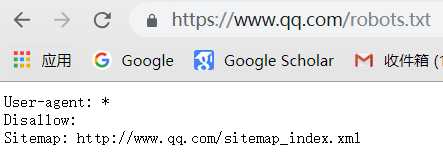

Robots协议:协议会指明通用爬虫可以爬取网页的权限

我们可以访问不同网页的Robots权限

6.通用爬虫通用流程:

7.通用爬虫缺点

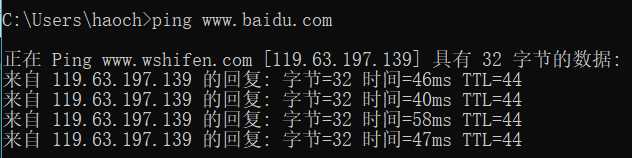

DNS 域名解析成IP: 通过在命令框中输入ping www.baidu.com,得到服务器的IP

爬虫程序员写的针对某种内容的爬虫-> 面向主题爬虫,面向需要爬虫

标签:url 爬虫 分析 规则 咨询公司 code 就会 第三方 如何获取

原文地址:https://www.cnblogs.com/haochen273/p/10202010.html