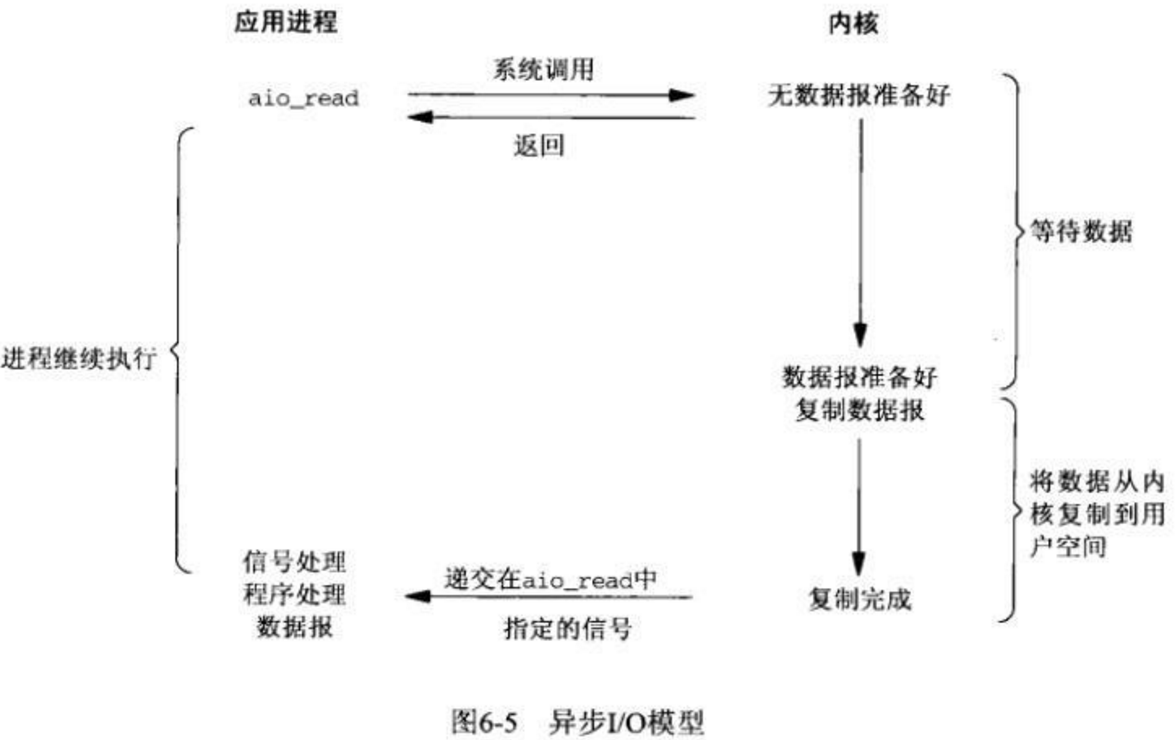

标签:网络 aio 调度 重新编译 eve 避免 注意 同步阻塞 err

目录

从一个进程的运行转到另一个进程上运行,这个过程中经过下面这些变化:

1.保存处理机上下文,包括程序计数器和其他寄存器。

2.更新PCB信息。

3.把进程的PCB移入相应的队列,如就绪、在某事件阻塞等队列。

4.选择另一个进程执行,并更新其PCB。

5.更新内存管理的数据结构。

6.恢复处理机上下文。

| Item | Value |

|---|---|

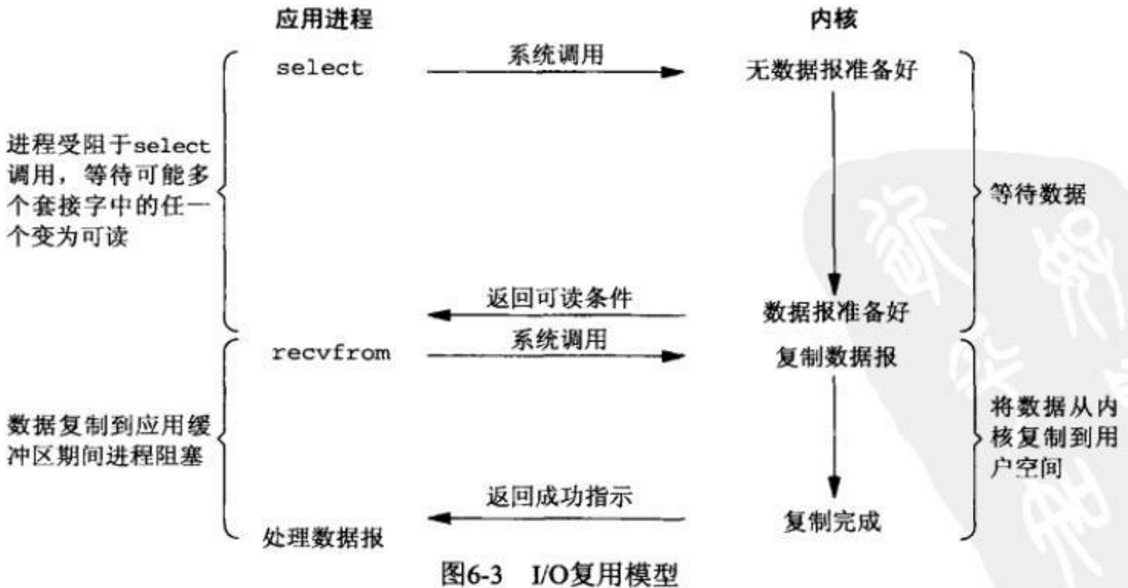

| select | 单个进程所能打开的最大连接数有FD_SETSIZE宏定义,其大小是32个整数的大小(在32位的机器上,大小就是3232,同理64位机器上FD_SETSIZE为3264),当然我们可以对进行修改,然后重新编译内核,但是性能可能会受到影响,这需要进一步的测试。 |

| poll | poll本质上和select没有区别,但是它没有最大连接数的限制,原因是它是基于链表来存储的 |

| epoll | 虽然连接数有上限,但是很大,1G内存的机器上可以打开10万左右的连接,2G内存的机器可以打开20万左右的连接 |

| Item | Value |

|---|---|

| select | 因为每次调用时都会对连接进行线性遍历,所以随着FD的增加会造成遍历速度慢的“线性下降性能问题”。 |

| poll | 同上 |

| epoll | 因为epoll内核中实现是根据每个fd上的callback函数来实现的,只有活跃的socket才会主动调用callback,所以在活跃socket较少的情况下,使用epoll没有前面两者的线性下降的性能问题,但是所有socket都很活跃的情况下,可能会有性能问题。 |

| Item | Value |

|---|---|

| select | 内核需要将消息传递到用户空间,都需要内核拷贝动作 |

| poll | 同上 |

| epoll | epoll通过内核和用户空间共享一块内存来实现的。 |

标签:网络 aio 调度 重新编译 eve 避免 注意 同步阻塞 err

原文地址:https://www.cnblogs.com/frankltf/p/10292634.html