标签:命名 根据 mha 完整 warning 编码 asi 工具 结果

目录

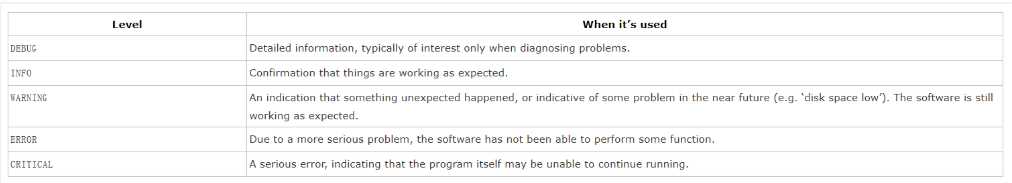

很多程序都有记录日志的需求,并且日志中包含的信息即有正常的程序访问日志,还可能有错误、警告等信息输出,python的logging模块提供了标准的日志接口,你可以通过它存储各种格式的日志,logging的日志可以分为 debug(), info(), warning(), error() and critical()5个级别,下面我们看一下怎么用。

import logging

logging.warning("warning:user/passwd is invalid")

logging.critical("critical:server is down")import logging

logging.basicConfig(filename=‘access.log‘,level=logging.INFO,format=‘%(asctime)s %(message)s‘,

datefmt=‘%m/%d/%Y %I:%M:%S %p‘)

#basicConfig 方法对日志进本信息进行配置,文件名、日志级别、输出格式等,但必须以key-value形式使用

logging.debug(‘This message should go to the log file?‘) # 由于上面已经将日志级别设置为INFO,故低于INFO的不会被打印

logging.info(‘So should this‘)

logging.warning(‘And this, too‘)format自定义格式,下表中均支持

| %(name)s | Logger的名字 |

|---|---|

| %(levelno)s | 数字形式的日志级别 |

| %(levelname)s | 文本形式的日志级别 |

| %(pathname)s | 调用日志输出函数的模块的完整路径名,可能没有 |

| %(filename)s | 调用日志输出函数的模块的文件名 |

| %(module)s | 调用日志输出函数的模块名 |

| %(funcName)s | 调用日志输出函数的函数名 |

| %(lineno)d | 调用日志输出函数的语句所在的代码行 |

| %(created)f | 当前时间,用UNIX标准的表示时间的浮 点数表示 |

| %(relativeCreated)d | 输出日志信息时的,自Logger创建以 来的毫秒数 |

| %(asctime)s | 字符串形式的当前时间。默认格式是 “2003-07-08 16:49:45,896”。逗号后面的是毫秒 |

| %(thread)d | 线程ID。可能没有 |

| %(threadName)s | 线程名。可能没有 |

| %(process)d | 进程ID。可能没有 |

| %(message)s | 用户输出的消息 |

Python 使用logging模块记录日志涉及四个主要类,使用官方文档中的概括最为合适:

可按以下步骤进行创建

实现代码如下:

# -*- coding:utf-8 -*-

import logging

def logger(log_obj):

logger = logging.getLogger(log_obj)

logger.setLevel(logging.INFO)

console_handle = logging.StreamHandler()

log_file = "access.log"

file_handle = logging.FileHandler(log_file)

file_handle.setLevel(logging.WARNING)

formatter = logging.Formatter(

‘%(asctime)s - %(name)s - %(levelname)s - %(message)s‘)

console_handle.setFormatter(formatter)

file_handle.setFormatter(formatter)

logger.addHandler(console_handle)

logger.addHandler(file_handle)

return logger

RotatingFileHandler( filename[, mode[, maxBytes[, backupCount]]])

其中filename和mode两个参数和FileHandler一样。

maxBytes用于指定日志文件的最大文件大小。如果maxBytes为0,意味着日志文件可以无限大,这时上面描述的重命名过程就不会发生。

backupCount用于指定保留的备份文件的个数。比如,如果指定为2,当上面描述的重命名过程发生时,原有的chat.log.2并不会被更名,而是被删除。

TimedRotatingFileHandler( filename [,when [,interval [,backupCount]]])

其中filename参数和backupCount参数和RotatingFileHandler具有相同的意义。

interval是时间间隔。

when参数是一个字符串。表示时间间隔的单位,不区分大小写。它有以下取值:

S 秒

M 分

H 小时

D 天

W 每星期(interval==0时代表星期一)

midnight 每天凌晨

# -*- coding:utf-8 -*-

import logging

from logging import handlers

logger = logging.getLogger(__name__)

log_file_size = "sizelog.log"

log_file_time = "timelog.log"

file_handler_size = logging.handlers.RotatingFileHandler(filename=log_file_size,maxBytes=10,backupCount=3)

file_handler_time = logging.handlers.TimedRotatingFileHandler(filename=log_file_time,when="S",interval=5,backupCount=3)

formatter = logging.Formatter(‘%(asctime)s %(module)s:%(lineno)d %(message)s‘)

file_handler_size.setFormatter(formatter)

file_handler_time.setFormatter(formatter)

logger.addHandler(file_handler_size)

logger.addHandler(file_handler_time)

logger.warning("test1")

logger.warning("test12")

logger.warning("test13")

logger.warning("test14")在python中函数编程可以大大的减少重复代码量,在打印日志时,为避免重复造轮子,可使用创建log函数进行调用。

# -*- coding:utf-8 -*-

import logging

def my_logger(log_obj):

print(logging._handlerList)

logger = logging.getLogger(log_obj)

logger.setLevel(logging.INFO)

console_handle = logging.StreamHandler()

formatter = logging.Formatter(

‘%(asctime)s - %(name)s - %(levelname)s - %(message)s ‘)

console_handle.setFormatter(formatter)

logger.addHandler(console_handle)

return logger

if __name__ == ‘__main__‘:

my_logger(‘access‘).error(‘say 1 ‘)

my_logger(‘access‘).error(‘say 2 ‘)

my_logger(‘access‘).error(‘say 3 ‘)

恩就这样定义好了一个log 函数,那我们来执行一下:

2018-06-24 13:25:54,411 - access.log - ERROR - say 1

2018-06-24 13:25:54,412 - access.log - ERROR - say 2

2018-06-24 13:25:54,412 - access.log - ERROR - say 2

2018-06-24 13:25:54,412 - access.log - ERROR - say 3

2018-06-24 13:25:54,412 - access.log - ERROR - say 3

2018-06-24 13:25:54,412 - access.log - ERROR - say 3 What‘s the fuck!为什么日志输出依次递增!

实际上logger = logging.getLogger(log_obj)在执行时,没有每次生成一个新的logger,而是先检查内存中是否存在一个叫做‘log_obj’的logger对象,存在则取出,不存在则新建。

# -*- coding:utf-8 -*-

import logging

def my_logger(log_obj):

logger = logging.getLogger(log_obj)

print(logger.handlers)

logger.setLevel(logging.INFO)

console_handle = logging.StreamHandler()

formatter = logging.Formatter(

‘%(asctime)s - %(name)s - %(levelname)s - %(message)s ‘)

console_handle.setFormatter(formatter)

logger.addHandler(console_handle)

return logger

if __name__ == ‘__main__‘:

my_logger(‘access‘).error(‘say 1 ‘)

my_logger(‘access‘).error(‘say 2 ‘)

my_logger(‘access‘).error(‘say 3 ‘)

[]

2018-06-24 13:44:47,239 - access.log - ERROR - say 1

[<StreamHandler <stderr> (NOTSET)>]

2018-06-24 13:45:22,597 - access.log - ERROR - say 2

2018-06-24 13:45:22,597 - access.log - ERROR - say 2

[<StreamHandler <stderr> (NOTSET)>, <StreamHandler <stderr> (NOTSET)>]

2018-06-24 13:45:32,877 - access.log - ERROR - say 3

2018-06-24 13:45:32,877 - access.log - ERROR - say 3

2018-06-24 13:45:32,877 - access.log - ERROR - say 3 从结果中可以看出:

logger.handlers最初是一个空列表,执行logger.addHandler(console_handle)添加一个StreamHandler,输出一条日志logger.handlers已经存在一个StreamHandler,再次执行logger.addHandler(console_handle)就会再次添加一个StreamHandler,此时的logger有两个个StreamHandler,输出两条重复的日志logger.handlers已经存在两个StreamHandler,再次执行logger.addHandler(console_handle)就会再次添加一个,此时的logger有三个StreamHandler,输出三条重复的日志# -*- coding:utf-8 -*-

import logging

def my_logger(log_obj):

logger = logging.getLogger(log_obj)

print(logger.handlers)

logger.setLevel(logging.INFO)

console_handle = logging.StreamHandler()

formatter = logging.Formatter(

‘%(asctime)s - %(name)s - %(levelname)s - %(message)s ‘)

console_handle.setFormatter(formatter)

logger.addHandler(console_handle)

return logger

if __name__ == ‘__main__‘:

my_logger(‘access1‘).error(‘say 1 ‘)

my_logger(‘access2‘).error(‘say 2 ‘)

my_logger(‘access3‘).error(‘say 3 ‘)

运行结果:

2018-06-24 13:51:33,084 - access1 - ERROR - say 1

2018-06-24 13:51:33,084 - access2 - ERROR - say 2

2018-06-24 13:51:33,085 - access3 - ERROR - say 3# -*- coding:utf-8 -*-

import logging

def my_logger(log_obj):

logger = logging.getLogger(log_obj)

logger.handlers.clear()

#print(logger.handlers)

logger.setLevel(logging.INFO)

console_handle = logging.StreamHandler()

formatter = logging.Formatter(‘%(asctime)s - %(name)s - %(levelname)s - %(message)s ‘)

console_handle.setFormatter(formatter)

logger.addHandler(console_handle)

return logger

if __name__ == ‘__main__‘:

my_logger(‘access‘).error(‘say 1 ‘)

my_logger(‘access‘).error(‘say 2 ‘)

my_logger(‘access‘).error(‘say 3 ‘)运行结果如下:

2018-06-24 13:56:38,357 - access - ERROR - say 1

2018-06-24 13:56:38,358 - access - ERROR - say 2

2018-06-24 13:56:38,358 - access - ERROR - say 3 还有一种通过清理handler的方法但是兼容性较差

# 这种写法下的可以使用removeHandler方法或logger.handlers.pop()(logger.handlers.clear也可以使用在这种写法的函数内)

# -*- coding:utf-8 -*-

import logging

def my_logger(log_obj, msg):

logger = logging.getLogger(log_obj)

#print(logger.handlers)

logger.setLevel(logging.INFO)

console_handle = logging.StreamHandler()

formatter = logging.Formatter(‘%(asctime)s - %(name)s - %(levelname)s - %(message)s ‘)

console_handle.setFormatter(formatter)

logger.addHandler(console_handle)

logger.error(msg)

logger.removeHandler(console_handle)

return logger

if __name__ == ‘__main__‘:

my_logger(‘access‘, ‘say 1‘)

my_logger(‘access‘, ‘say 2‘)

my_logger(‘access‘, ‘say 3‘)运行结果:

2018-06-24 14:02:08,390 - access - ERROR - say 1

2018-06-24 14:02:08,390 - access - ERROR - say 2

2018-06-24 14:02:08,390 - access - ERROR - say 3 # -*- coding:utf-8 -*-

import logging

def my_logger(log_obj):

logger = logging.getLogger(log_obj)

logger.setLevel(logging.INFO)

# 判断logger是否已经添加过handler,是则直接返回logger对象,否则执行handler设定以及addHandler(console_handle)

if not logger.handlers:

console_handle = logging.StreamHandler()

formatter = logging.Formatter(

‘%(asctime)s - %(name)s - %(levelname)s - %(message)s ‘)

console_handle.setFormatter(formatter)

logger.addHandler(console_handle)

return logger

if __name__ == ‘__main__‘:

my_logger(‘access‘).error(‘say 1‘)

my_logger(‘access‘).error(‘say 2‘)

my_logger(‘access‘).error(‘say 3‘)第一次遇到这个问题的时候,没有找到原因,使用了创建多个日志对象的方法解决了问题,现在通过同学的分享已经搞清楚日志重复的原因:多次增加了相同的handler对象。

以后定要多积累,多请教。

============================================================================================================================================================================================================================================================================================================================================================================================================================================================================================================

很多程序都有记录日志的需求,并且日志包含的信息有正常的程序访问日志还可能有错误,警告等信息输出,python的logging模块提供了标准的日志接口,可以通过它存储各种格式的日志,日志级别等级:critical > error > warning > info > debug

看下各个日志级别代表什么意思:

简单讲日志打印到屏幕:

1 >>> import logging 2 >>> logging.debug(‘test debug‘) 3 >>> logging.info(‘test info‘) 4 >>> logging.warning(‘test warning‘) 5 WARNING:root:test warning 6 >>> logging.error(‘test error‘) 7 ERROR:root:test error 8 >>> logging.critical(‘test critical‘) 9 CRITICAL:root:test critical 10 >>>

默认情况下只显示了大于等于WARNING级别的日志。

灵活配置日志级别,日志格式,输出位置:

1 import logging 2 logging.basicConfig(filename=‘app.log‘,level=logging.DEBUG,format=‘%(asctime)s %(filename)s[line:%(lineno)d] %(message)s‘,datefmt=‘%Y-%m-%d‘) 3 logging.info(‘test info‘) 4 logging.debug(‘test debug‘) 5 logging.warning(‘test warning‘) 6 logging.error(‘test error‘) 7 logging.critical(‘test critical‘)

查看输出:

2017-07-17 logging模块.py[line:7] test info

2017-07-17 logging模块.py[line:8] test debug

2017-07-17 logging模块.py[line:9] test warning

2017-07-17 logging模块.py[line:10] test error

2017-07-17 logging模块.py[line:11] test critical

在logging.basicConfig()函数中可通过具体参数来更改logging模块默认行为,可用参数有 filename:用指定的文件名创建FiledHandler(后边会具体讲解handler的概念),这样日志会被存储在指定的文件中。 filemode:文件打开方式,在指定了filename时使用这个参数,默认值为“a”还可指定为“w”。 format:指定handler使用的日志显示格式。 datefmt:指定日期时间格式。 level:设置rootlogger(后边会讲解具体概念)的日志级别 stream:用指定的stream创建StreamHandler。可以指定输出到sys.stderr,sys.stdout或者文件,默认为sys.stderr。若同时列出了filename和stream两个参数,则stream参数会被忽略。

format参数中可能用到的格式化串: %(name)s Logger的名字 %(levelno)s 数字形式的日志级别 %(levelname)s 文本形式的日志级别 %(pathname)s 调用日志输出函数的模块的完整路径名,可能没有 %(filename)s 调用日志输出函数的模块的文件名 %(module)s 调用日志输出函数的模块名 %(funcName)s 调用日志输出函数的函数名 %(lineno)d 调用日志输出函数的语句所在的代码行 %(created)f 当前时间,用UNIX标准的表示时间的浮 点数表示 %(relativeCreated)d 输出日志信息时的,自Logger创建以 来的毫秒数 %(asctime)s 字符串形式的当前时间。默认格式是 “2003-07-08 16:49:45,896”。逗号后面的是毫秒 %(thread)d 线程ID。可能没有 %(threadName)s 线程名。可能没有 %(process)d 进程ID。可能没有 %(message)s用户输出的消息

若要对logging进行更多灵活的控制,必须了解Logger,Handler,Formatter,Filter的概念:

logger提供了应用程序可以直接使用的接口;

handler将(logger创建的)日志记录发送到合适的目的输出;

filter提供了细度设备来决定输出哪条日志记录;

formatter决定日志记录的最终输出格式。

logger

每个程序在输出信息之前都要获得一个Logger。Logger通常对应了程序的模块名,比如聊天工具的图形界面模块可以这样获得它的Logger:

LOG=logging.getLogger(”chat.gui”)

而核心模块可以这样:

LOG=logging.getLogger(”chat.kernel”)

Logger.setLevel(lel):指定最低的日志级别,低于lel的级别将被忽略。debug是最低的内置级别,critical为最高

Logger.addFilter(filt)、Logger.removeFilter(filt):添加或删除指定的filter

Logger.addHandler(hdlr)、Logger.removeHandler(hdlr):增加或删除指定的handler

Logger.debug()、Logger.info()、Logger.warning()、Logger.error()、Logger.critical():可以设置的日志级别

handler

handler对象负责发送相关的信息到指定目的地。Python的日志系统有多种Handler可以使用。有些Handler可以把信息输出到控制台,有些Logger可以把信息输出到文件,还有些 Handler可以把信息发送到网络上。如果觉得不够用,还可以编写自己的Handler。可以通过addHandler()方法添加多个多handler

Handler.setLevel(lel):指定被处理的信息级别,低于lel级别的信息将被忽略

Handler.setFormatter():给这个handler选择一个格式

Handler.addFilter(filt)、Handler.removeFilter(filt):新增或删除一个filter对象

每个Logger可以附加多个Handler。接下来我们就来介绍一些常用的Handler:

1) logging.StreamHandler

使用这个Handler可以向类似与sys.stdout或者sys.stderr的任何文件对象(file object)输出信息。它的构造函数是:

StreamHandler([strm])

其中strm参数是一个文件对象。默认是sys.stderr

2) logging.FileHandler

和StreamHandler类似,用于向一个文件输出日志信息。不过FileHandler会帮你打开这个文件。它的构造函数是:

FileHandler(filename[,mode])

filename是文件名,必须指定一个文件名。

mode是文件的打开方式。参见Python内置函数open()的用法。默认是’a‘,即添加到文件末尾。

3) logging.handlers.RotatingFileHandler

这个Handler类似于上面的FileHandler,但是它可以管理文件大小。当文件达到一定大小之后,它会自动将当前日志文件改名,然后创建 一个新的同名日志文件继续输出。比如日志文件是chat.log。当chat.log达到指定的大小之后,RotatingFileHandler自动把 文件改名为chat.log.1。不过,如果chat.log.1已经存在,会先把chat.log.1重命名为chat.log.2。。。最后重新创建 chat.log,继续输出日志信息。它的构造函数是:

RotatingFileHandler( filename[, mode[, maxBytes[, backupCount]]])

其中filename和mode两个参数和FileHandler一样。

maxBytes用于指定日志文件的最大文件大小。如果maxBytes为0,意味着日志文件可以无限大,这时上面描述的重命名过程就不会发生。

backupCount用于指定保留的备份文件的个数。比如,如果指定为2,当上面描述的重命名过程发生时,原有的chat.log.2并不会被更名,而是被删除。

4) logging.handlers.TimedRotatingFileHandler

这个Handler和RotatingFileHandler类似,不过,它没有通过判断文件大小来决定何时重新创建日志文件,而是间隔一定时间就 自动创建新的日志文件。重命名的过程与RotatingFileHandler类似,不过新的文件不是附加数字,而是当前时间。它的构造函数是:

TimedRotatingFileHandler( filename [,when [,interval [,backupCount]]])

其中filename参数和backupCount参数和RotatingFileHandler具有相同的意义。

interval是时间间隔。

when参数是一个字符串。表示时间间隔的单位,不区分大小写。它有以下取值:

S 秒

M 分

H 小时

D 天

W 每星期(interval==0时代表星期一)

midnight 每天凌晨

屏幕输出和文件输出例子:

1 import logging 2 logger = logging.getLogger() #定义对应的程序模块名name,默认是root 3 #logger.setLevel(logging.DEBUG) #指定最低的日志级别 4 ch = logging.StreamHandler() #日志输出到屏幕控制台 5 ch.setLevel(logging.WARNING) #设置日志等级 6 7 fh = logging.FileHandler(‘access.log‘)#向文件access.log输出日志信息 8 fh.setLevel(logging.INFO) #设置输出到文件最低日志级别 9 10 #create formatter 11 formatter = logging.Formatter(‘%(asctime)s %(name)s- %(levelname)s - %(message)s‘) #定义日志输出格式 12 13 #add formatter to ch and fh 14 ch.setFormatter(formatter) #选择一个格式 15 fh.setFormatter(formatter) 16 17 logger.addHandler(ch) #增加指定的handler 18 logger.addHandler(fh) 19 # ‘application‘ code 20 logger.debug(‘debug message‘) 21 logger.info(‘info message‘) 22 logger.warn(‘warn message‘) 23 logger.error(‘error message‘) 24 logger.critical(‘critical message‘)

import logging,os

BASE_DIR = os.path.dirname(os.path.dirname(os.path.abspath(__file__))) #获取上级目录的绝对路径

log_dir = BASE_DIR + ‘/log/record.log‘

def get_logger():

fh = logging.FileHandler(log_dir,encoding=‘utf-8‘) #创建一个文件流并设置编码utf8

logger = logging.getLogger() #获得一个logger对象,默认是root

logger.setLevel(logging.DEBUG) #设置最低等级debug

fm = logging.Formatter("%(asctime)s --- %(message)s") #设置日志格式

logger.addHandler(fh) #把文件流添加进来,流向写入到文件

fh.setFormatter(fm) #把文件流添加写入格式

return logger

标签:命名 根据 mha 完整 warning 编码 asi 工具 结果

原文地址:https://www.cnblogs.com/111testing/p/10847056.html