标签:大学 图片大小 改变 channels channel 适应 code 神经元 图片

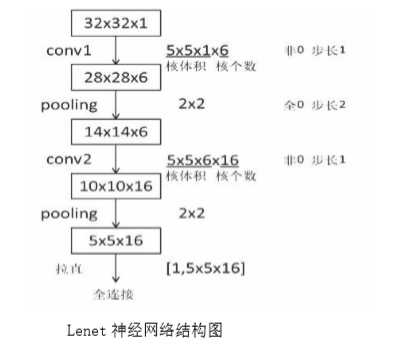

Lenet 神经网络结构为:

①输入为 32*32*1 的图片大小,为单通道的输入;

②进行卷积,卷积核大小为 5*5*1,个数为 6,步长为 1,非全零填充模式;

③将卷积结果通过非线性激活函数;

④进行池化,池化大小为 2*2,步长为 1,全零填充模式;

⑤进行卷积,卷积核大小为 5*5*6,个数为 16,步长为 1,非全零填充模式;

⑥将卷积结果通过非线性激活函数;

⑦进行池化,池化大小为 2*2,步长为 1,全零填充模式;

⑧全连接层进行 10 分类。

Lenet 神经网络的结构图及特征提取过程如下所示:

Lenet 神经网络的输入是 32*32*1,经过 5*5*1 的卷积核,卷积核个数为 6 个,采用非全零填充方式,步长为 1,根据非全零填充计算公式:输出尺寸=(输入尺寸-卷积核尺寸+1)/步长=(32-5+1)/1=28.

故经过卷积后输出为 28*28*6。

经过第一层池化层,池化大小为 2*2,全零填充,步长为 2,由全零填充计算公式:输出尺寸=输入尺寸/步长=28/2=14,池化层不改变深度,深度仍为 6。

用同样计算方法,得到第二层池化后的输出为 5*5*16。

将第二池化层后的输出拉直送入全连接层。

根据 Lenet 神经网络的结构可得,Lenet 神经网络具有如下特点:

①卷积(Conv)、池化(ave-pooling)、非线性激活函数(sigmoid)相互交替;

②层与层之间稀疏连接,减少计算复杂度。

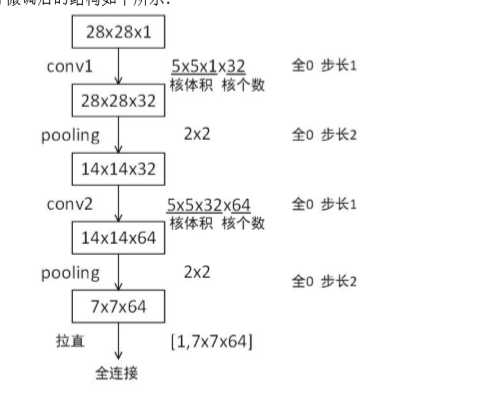

对 Lenet 神经网络进行微调,使其适应 Mnist 数据集:

由于 Mnist 数据集中图片大小为 28*28*1 的灰度图片,而 Lenet 神经网络的输入为 32*32*1,故需要对 Lenet 神经网络进行微调。(微调是如何进行调整?整个网络的对接是如何进行?后面博客继续学习)

①输入为 28*28*1 的图片大小,为单通道的输入;

②进行卷积,卷积核大小为 5*5*1,个数为 32,步长为 1,全零填充模式;

③将卷积结果通过非线性激活函数;

④进行池化,池化大小为 2*2,步长为 2,全零填充模式;

⑤进行卷积,卷积核大小为 5*5*32,个数为 64,步长为 1,全零填充模式;

⑥将卷积结果通过非线性激活函数;

⑦进行池化,池化大小为 2*2,步长为 2,全零填充模式;

⑧全连接层,进行 10 分类。

Lenet 进行微调后的结构如下所示:

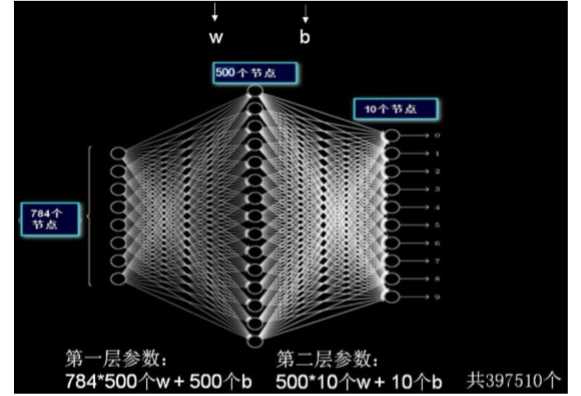

前面第五、六讲中,输入mnist数据集是28*28像素,输出是长度为10的一维数组;

现在运用Lennet神经网络

图片大小即每张图片分辨率为 28*28,故 IMAGE_SIZE 取值为 28;

Mnist 数据集为灰度图,故输入图片通道数 NUM_CHANNELS 取值为 1;

第一层卷积核大小为 5,卷积核个数为 32,故 CONV1_SIZE 取值为 5,CONV1_KERNEL_NUM 取值为 32;

第二层卷积核大小为 5,卷积核个数为 64,故 CONV2_SIZE 取值为 5, CONV2_KERNEL_NUM为 64;

全连接层第一层为 512 个神经元,故FC_SIZE 取值为 512,

全连接层第二层为 10 个神经元,OUTPUT_NODE 取值为 10,实现 10 分类输出。

注:本文章通过观看北京大学曹健老师的Tensorflow视频,笔记总结而来的。

标签:大学 图片大小 改变 channels channel 适应 code 神经元 图片

原文地址:https://www.cnblogs.com/fcfc940503/p/11082180.html