标签:方法 nod 添加 产生 获取文件 目录 存储 common 写入

jar包方式部署:

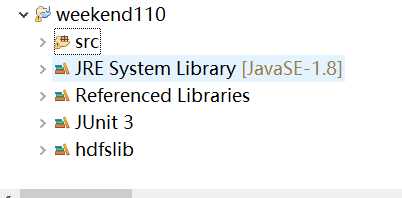

1、创建一个java工程,命名为weekend110

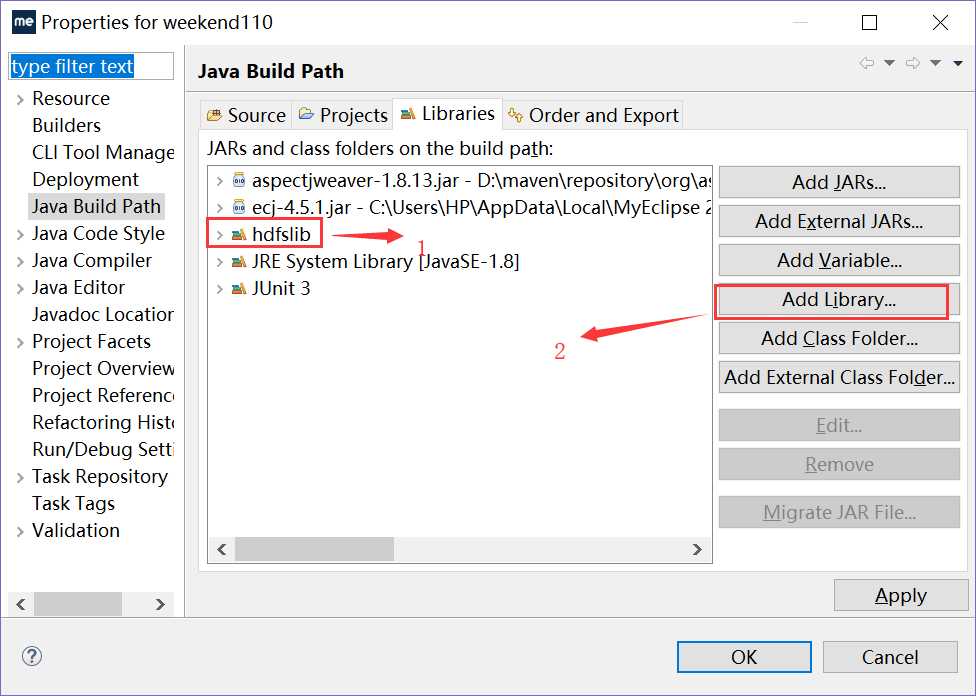

2、需要在java Build Path添加Libraries命名为hdfs

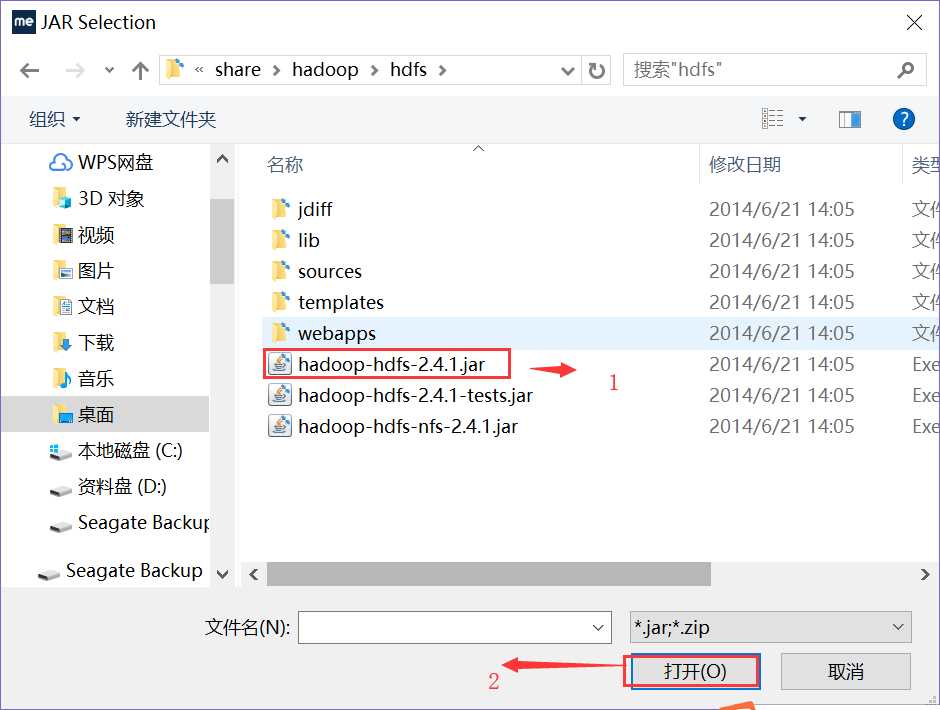

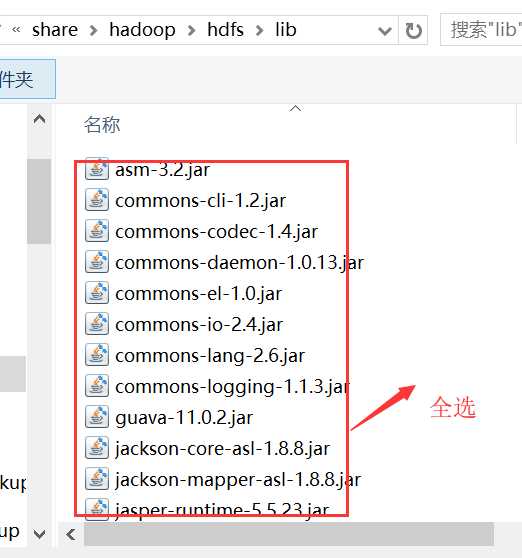

在hdfs里面 添加jar包:

接着添加lib所有jar包:

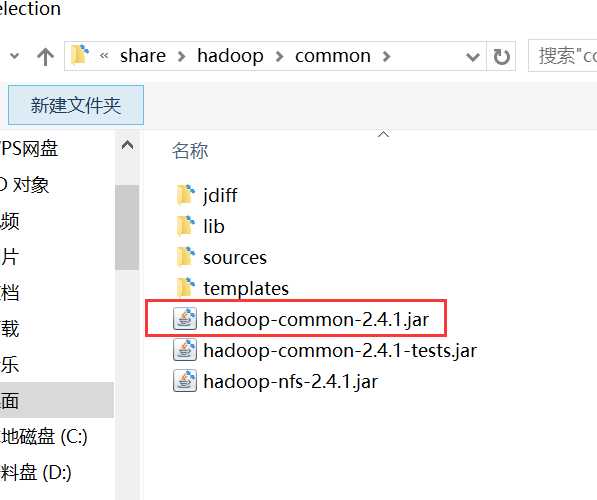

再添加common的核心包:

最后再重新添加lib包,重复可以覆盖!

完成ok!

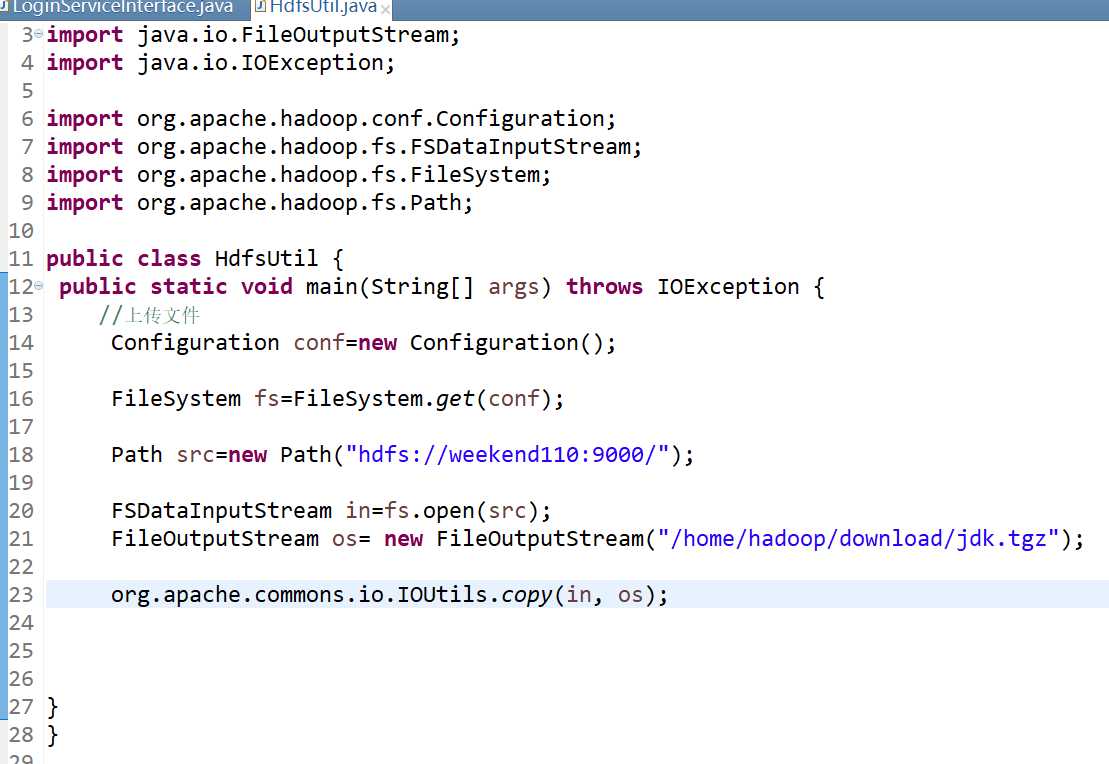

第二步,创建java工程!

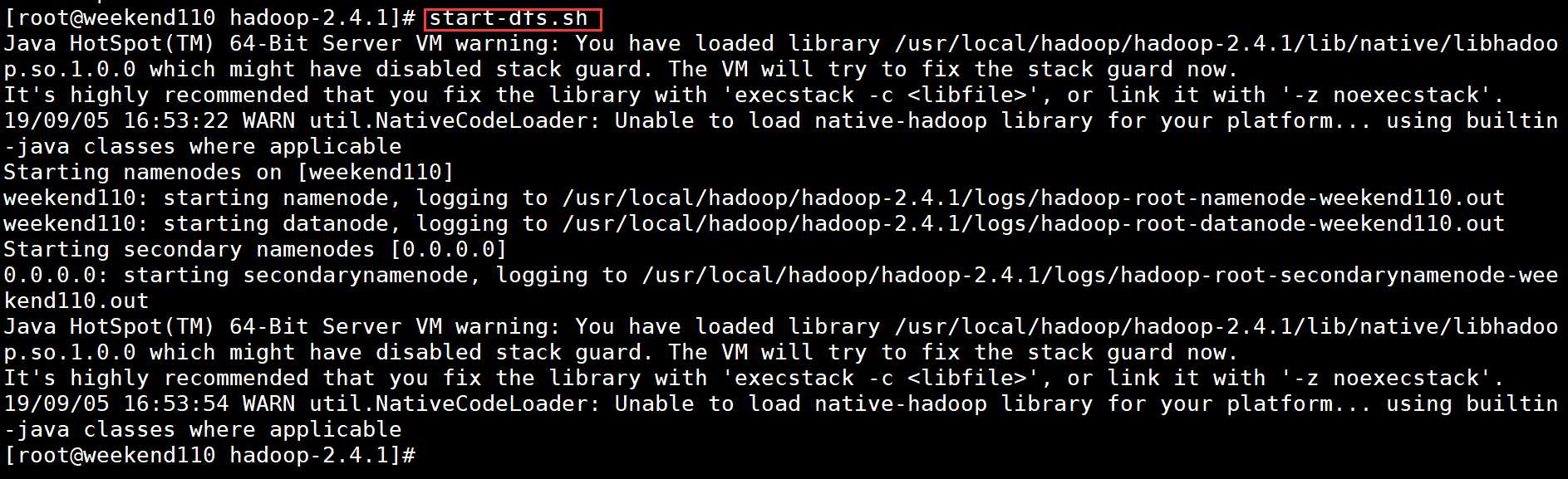

第三步:在Linux环境下启动命令:start-dfs.sh

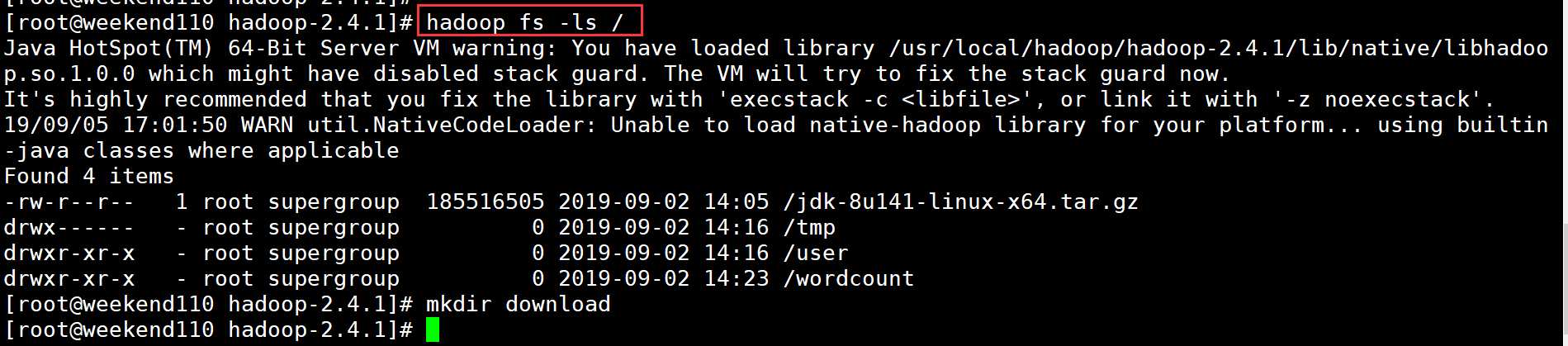

第四步:查看

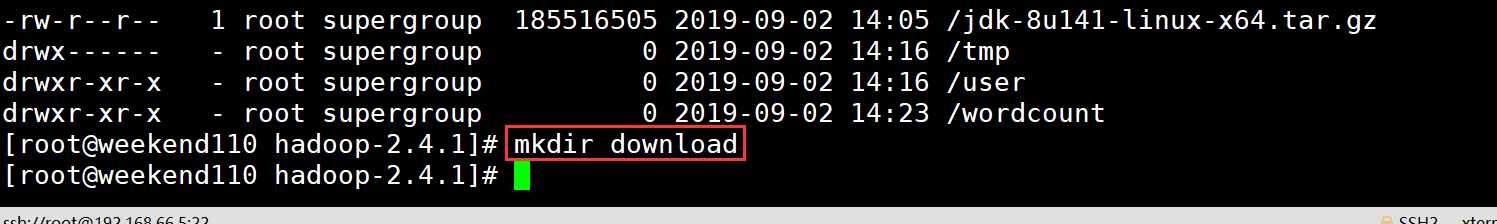

第五步:创建一个download文件

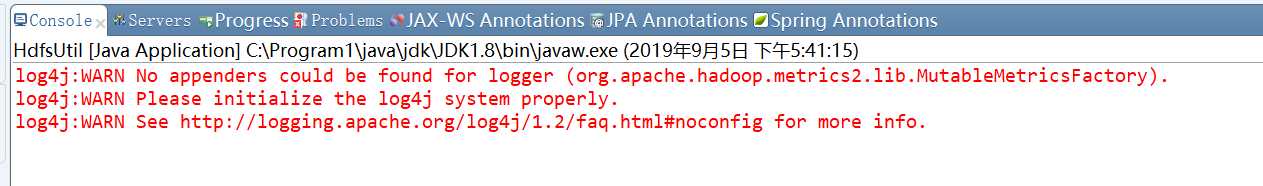

第六步:在java代码的main方法直接运行,会出现错误:

分析:没有拿到hdfs的事例,只拿到本地文件的事例!

解决问题:

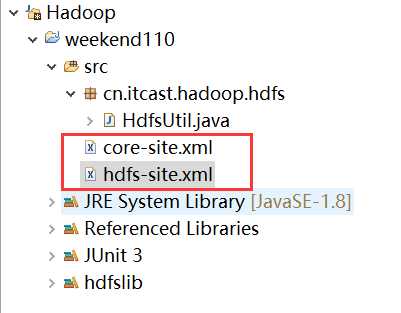

方法1:在java工程的src目录创建一个core-site.xml、hdfs-site.xml文件,配置属性是:

core-site.xml:

<configuration>

<!-- 指定HADOOP所使用的文件系统schema(URI),HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.66.5:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/hadoop-2.4.1/data</value>

</property>

</configuration>

hdfs-site.xml:

<configuration>

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!--获取文件夹写入权限-->

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

</configuration>

如图所示:

最后,直接运行:

标签:方法 nod 添加 产生 获取文件 目录 存储 common 写入

原文地址:https://www.cnblogs.com/studygithub5208868/p/11468648.html