标签:The scala 环境配置 bin mic 执行 root chm class

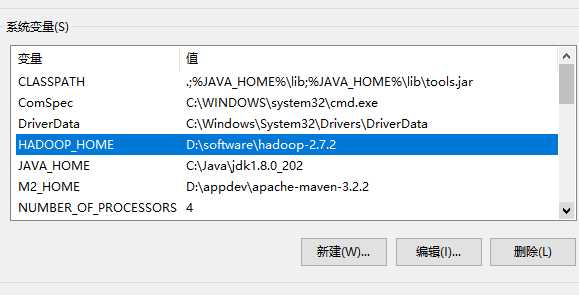

为了和以后出现的hadoop,spark出现 路径带有空格导致 调用失败的情况, 直接把 jdk的路径 剪切到 没有空格的目录下。

D:\>echo %JAVA_HOME%

C:\Java\jdk1.8.0_202

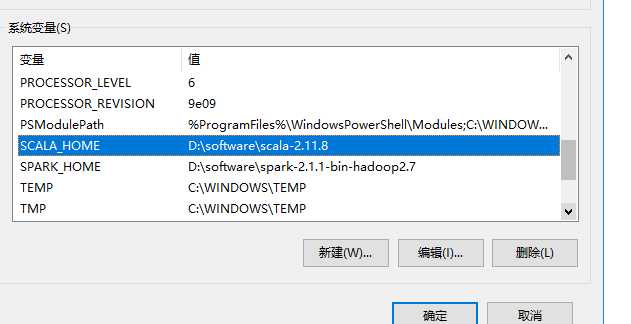

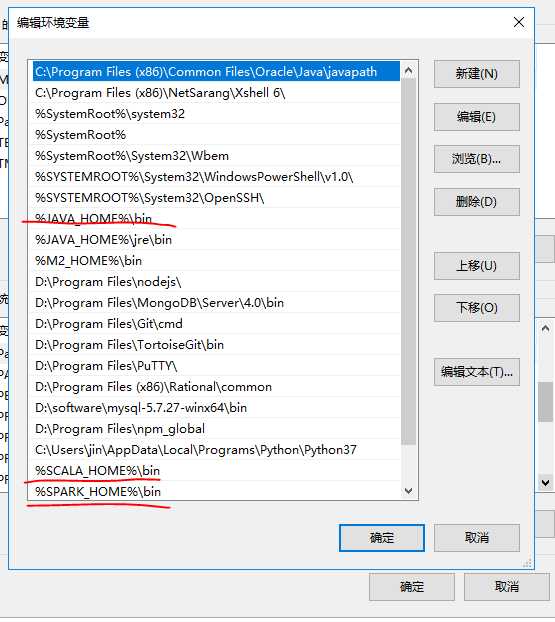

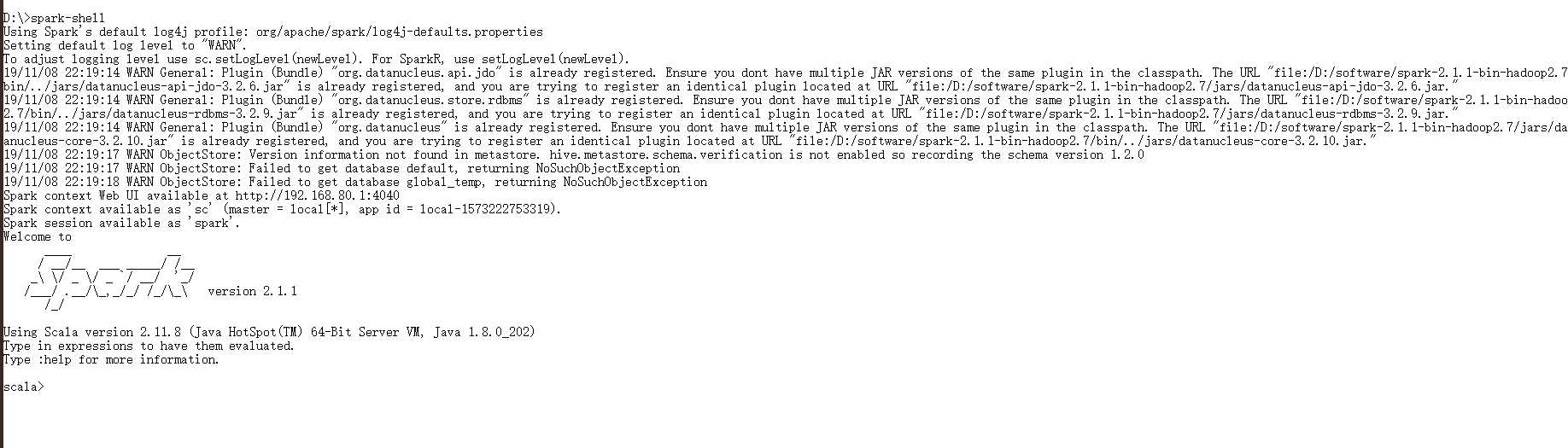

到这里,在cmd下,能 看到 scala -version和 spark-shell 。

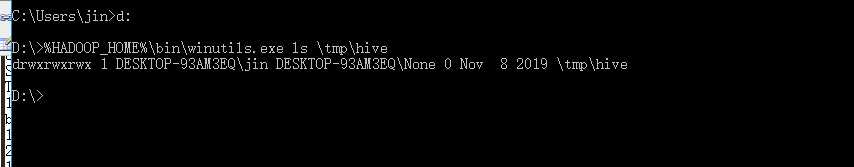

%HADOOP_HOME%\bin\winutils.exe ls \tmp\hive

%HADOOP_HOME%\bin\winutils.exe chmod 777 \tmp\hive

%HADOOP_HOME%\bin\winutils.exe ls \tmp\hive

注意:如果程序是放在 D盘, 那么要在D盘执行以上命令。

看到读写的权限都有了。

windows下jdk、hadoop、Scala、Spark的调试环境配置(jdk路径的空格问题, /tmp/hive on HDFS should be writable问题)

标签:The scala 环境配置 bin mic 执行 root chm class

原文地址:https://www.cnblogs.com/wuyicode/p/11823657.html