标签:图片 多层 就是 获得 方法 tab 过程 基本概念 nbsp

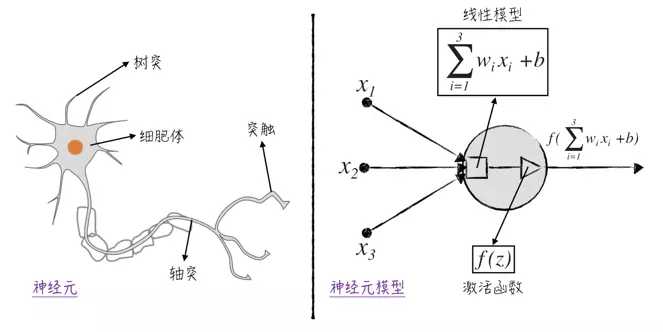

解释:每一个神经元都是相对独立的,将输入的若干个数据经过加权处理之后求和,作为一个总体输入(在上图中就是线性模型),然后将该总体输入作为变量送给激活函数,得到的函数值作为神经元的输出。

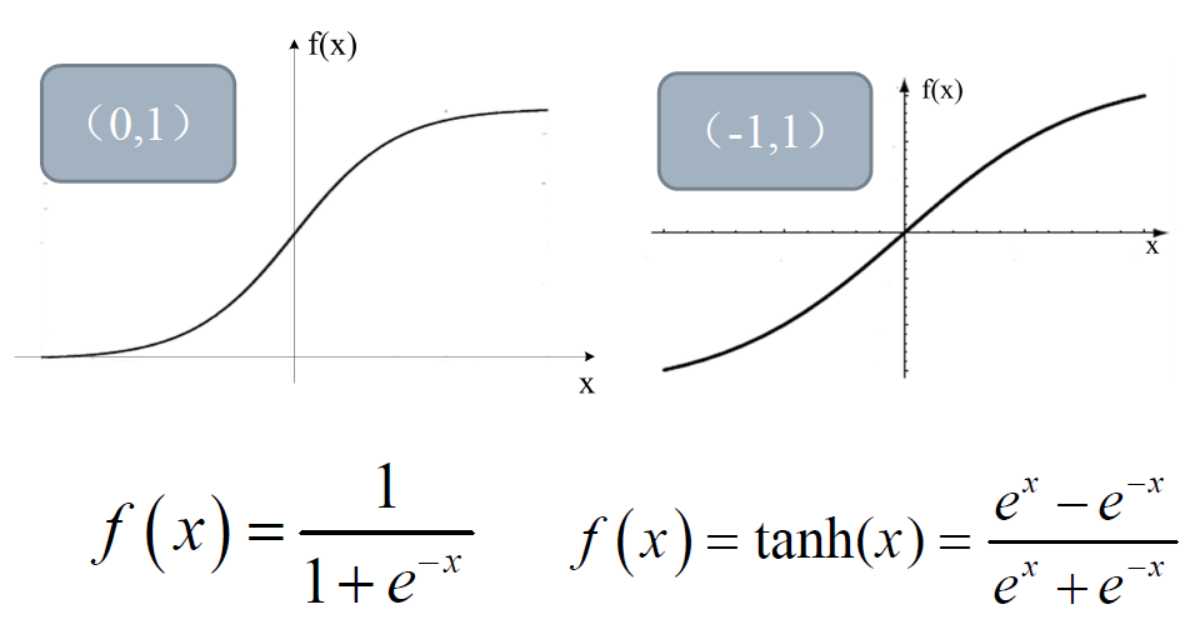

解释:从上面的左图可以看到,当x的值(也就是输入信号的加权和)为负数(一般小于-5时)时,得到的输出值就会变成0,而当输入值较大时则会有比较明确的反应,也就是表明这样的激活函数对信号有选择作用。

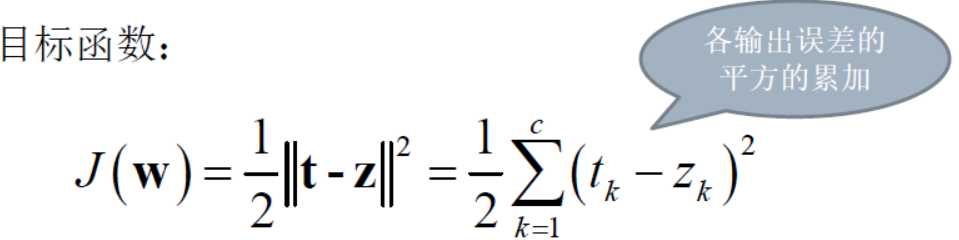

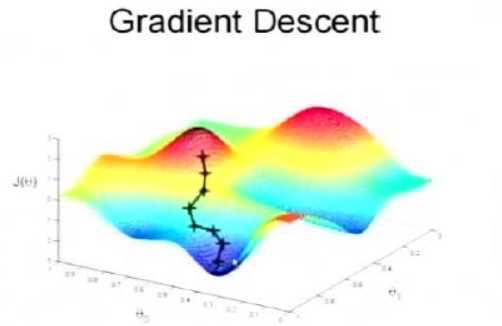

从目标函数J(w)的形式来看,它是关于w的函数,而为了提高训练精度,目标就是求取函数J(w)的最小值,直接通过求取极值的方式来进而获取最小值的方式实施起来是很困难的,所以就采用了梯度下降的方法,如下图:

在上面的三维图中,纵向的坐标就是J(w)的函数值,横向的坐标就是w值。实现梯度下降的方法是首先随机确定初始点,然后依照梯度下降的方向(这个方向可以用求导的方法得到)按照一定的步长(步长的选取十分关键)进行w值的调整,这样就导致了J(w)值的减小,一直到这个值减小到最小,那么这个时候的权重w就是对应的最佳值,得到的模型也就是最佳模型。也就是说,梯度下降的过程就是寻找最佳w值的过程。

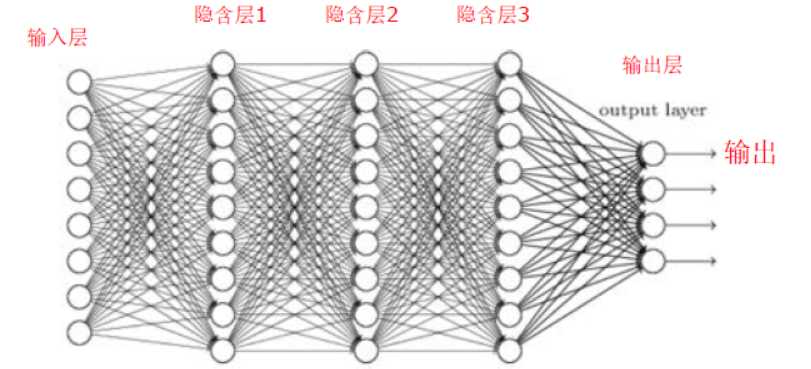

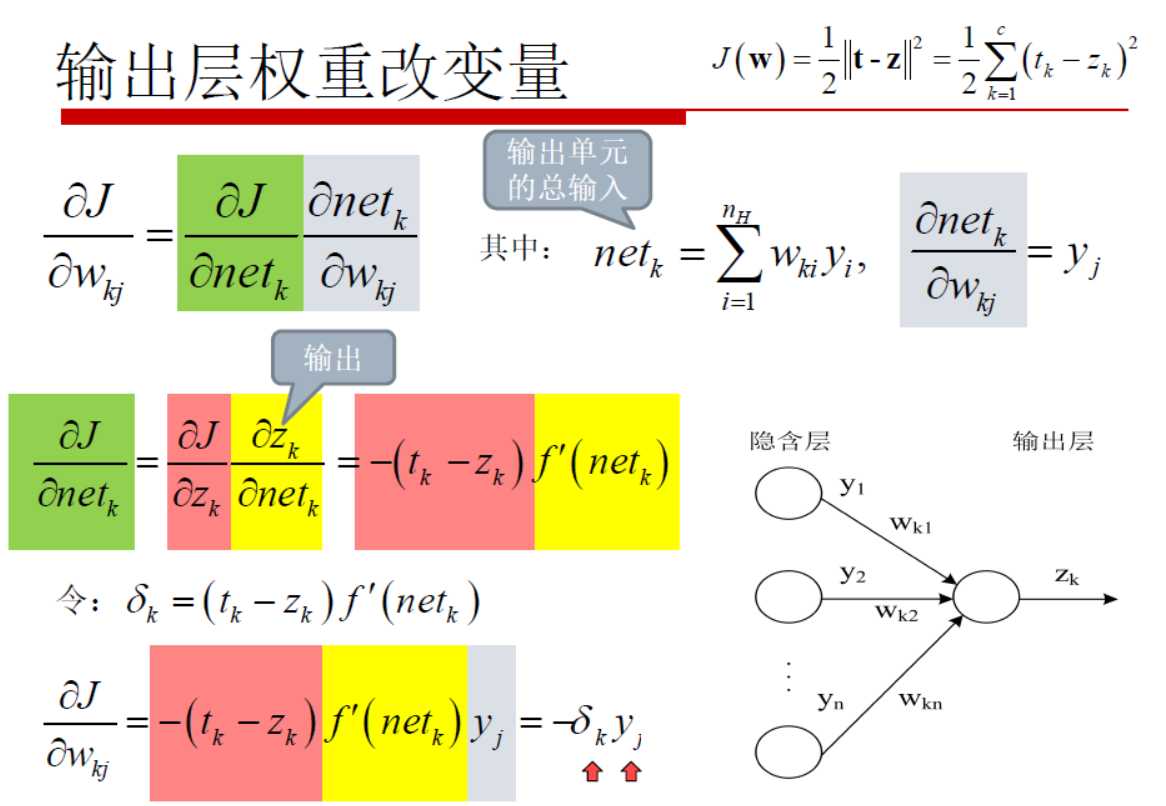

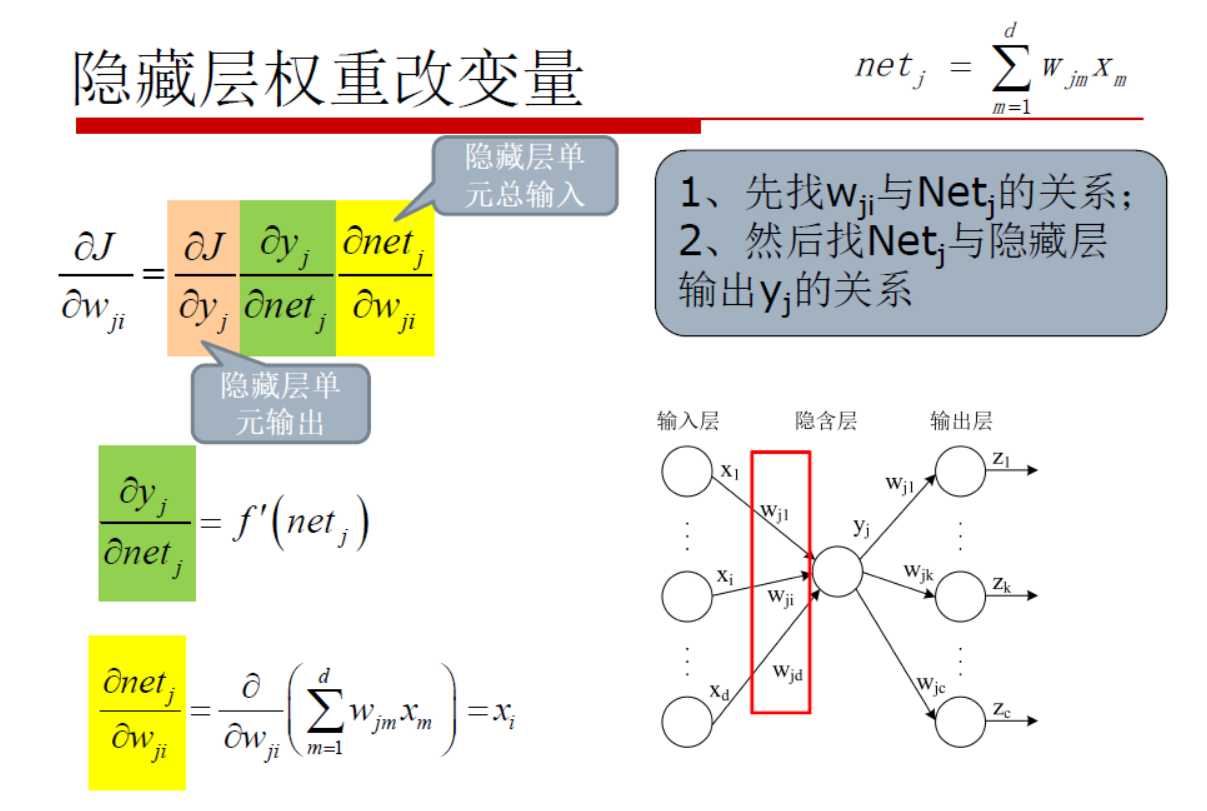

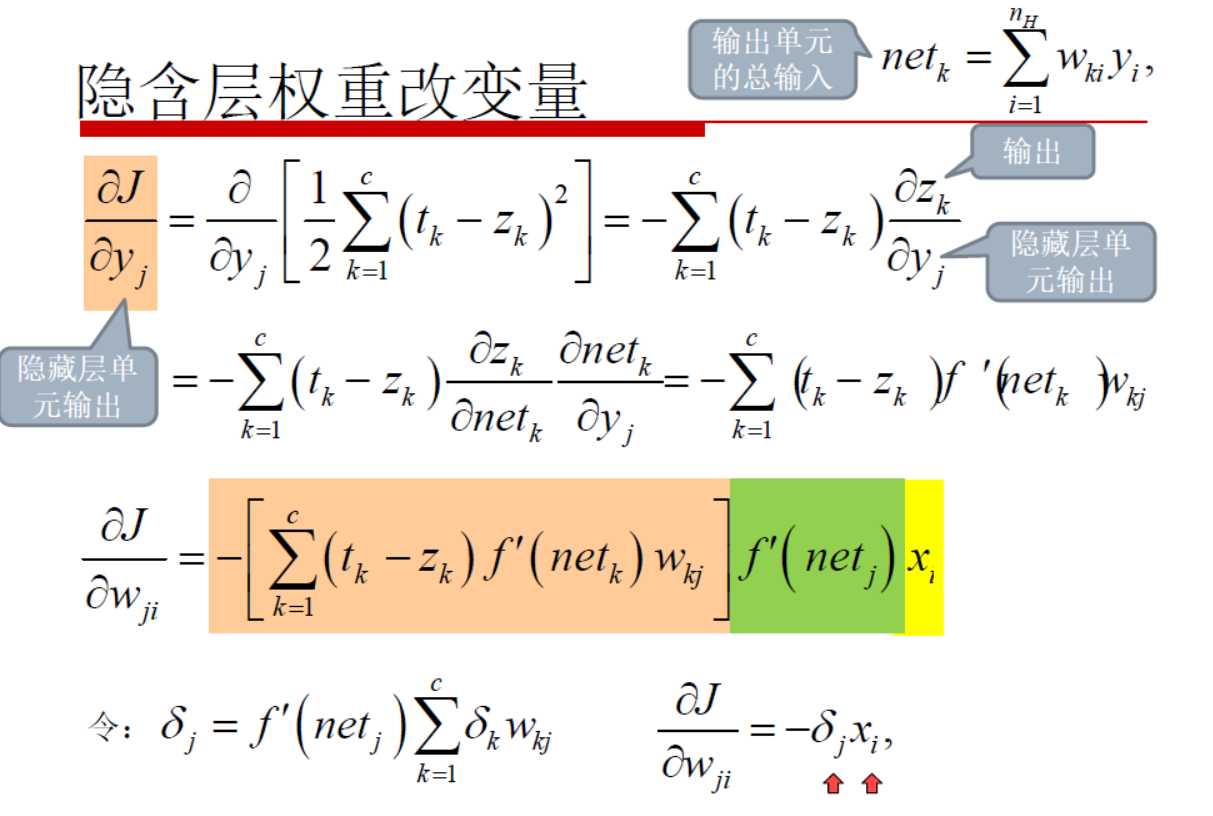

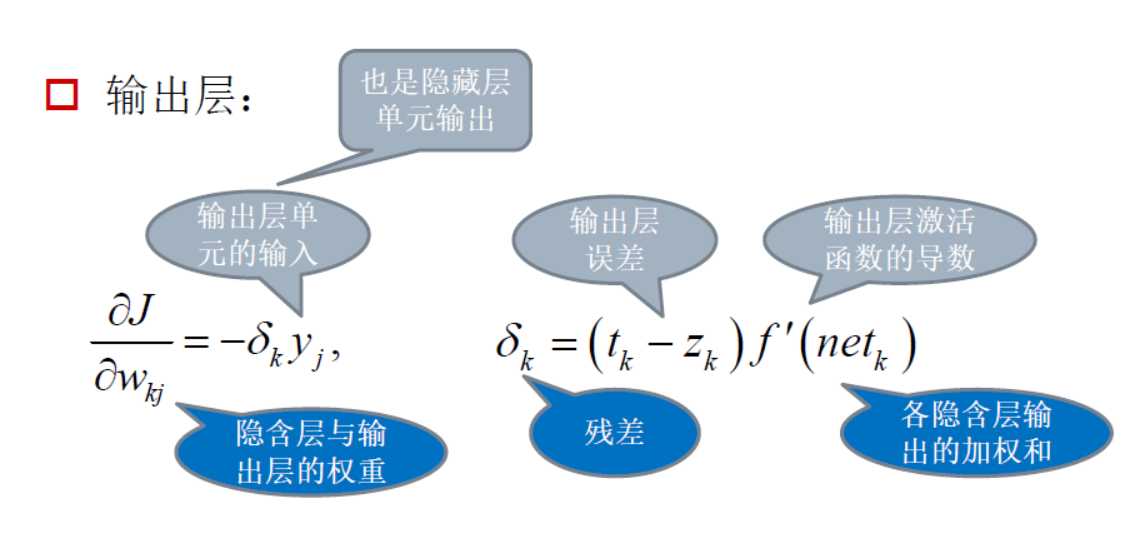

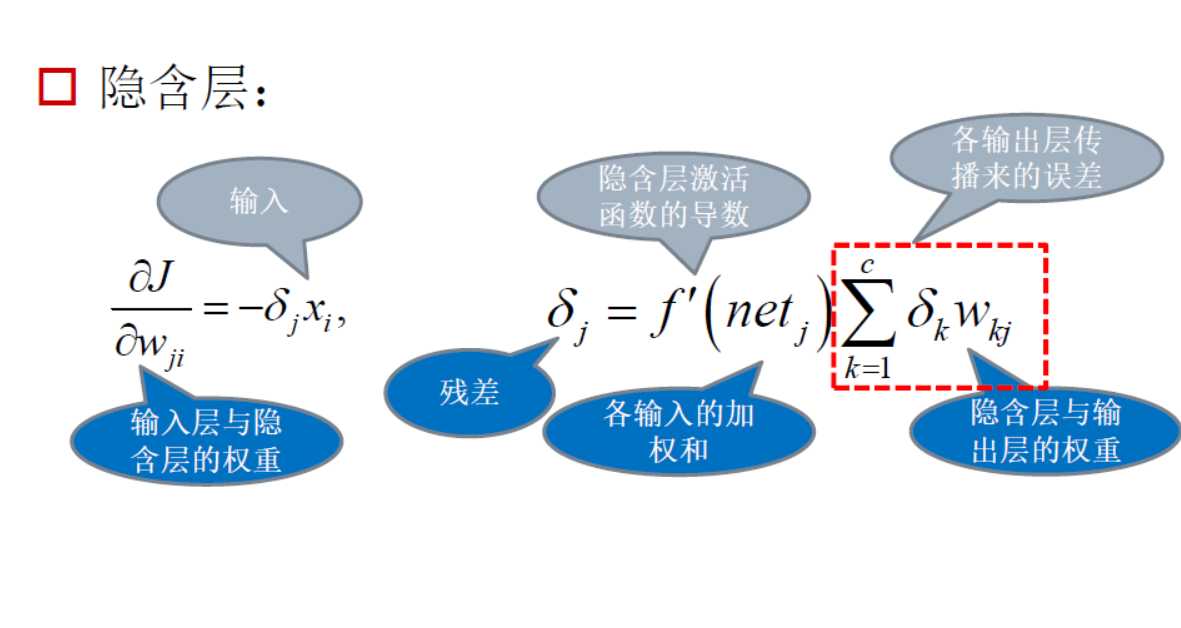

在深度神经网络中,权重w可以分成两个部分:输出层权重和隐含层权重,那么如何调整两种权重呢?或者说如何找到相应的权重改变量呢?其实这个问题可以理解成如何找到梯度下降的方向:

|

|

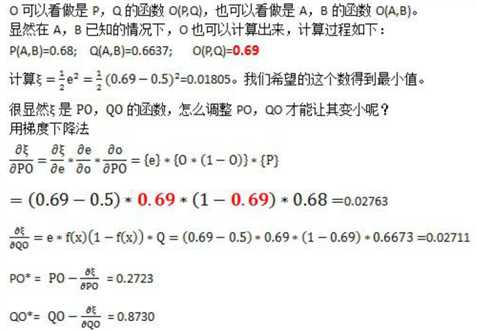

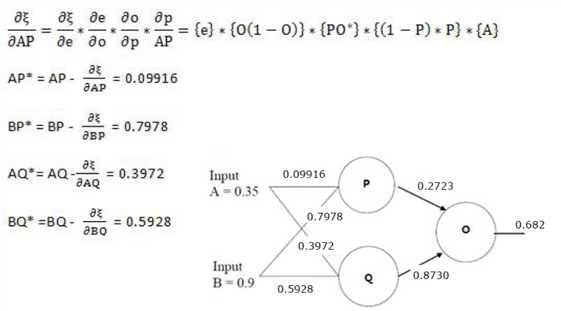

经过上面两步,于是得到了下图的结果:

|

|

|

|

|

经过上面的步骤就得到权重的改变量,那么在原来的权重基础上加上得到的改变量,于是就获得了新的权重值,开始新一轮计算目标函数。经过很多轮的调整计算之后,最终使得目标函数的值达到一个比较理想的结果。

|

|

|

找到了梯度下降的方法,那么下一步就是探究梯度下降的类型,例如:

标签:图片 多层 就是 获得 方法 tab 过程 基本概念 nbsp

原文地址:https://www.cnblogs.com/lzy820260594/p/11844512.html