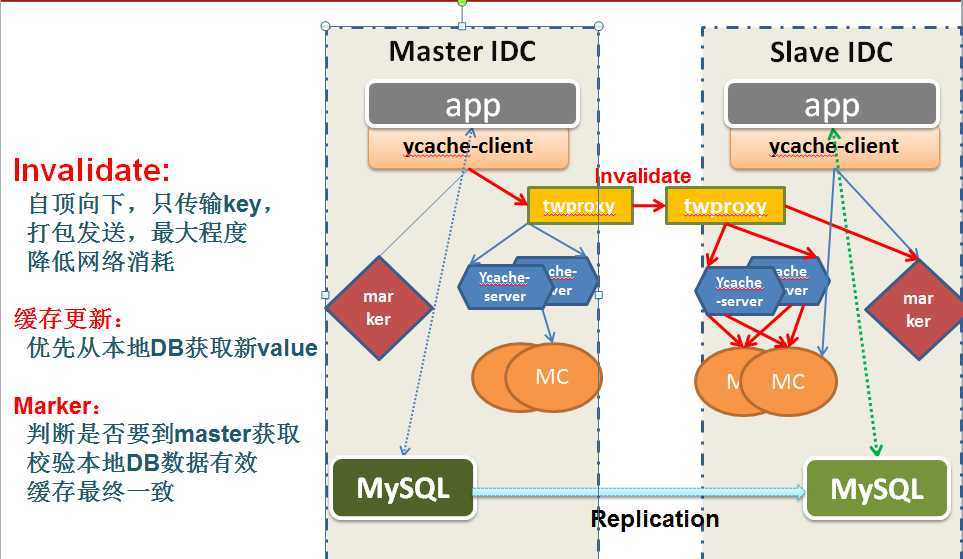

client端:

原理:app在更新数据库后(或者其他需要更新缓存的操作),调用IDCMemcacheProxyFactory工厂类获取一个实例,通过这个实例发送一个invalid消息。 这个invalid消息会在内部处理中通过twemproxy广播给所有的idc。

app需要初始化的,与以前的相比,使用IDCMemcacheProxyFactory代替以前的

YmemcacheProxyFactory;使用IDCProxy发送invalid消息,而其他的消息还是通过CacheProxy接口;

内部实现:

除了根据app指定的配置文件路径配置它的cache-pool外,还额外做如下的初始化(把本所有远端idc的2个twemproxy端口当作一个cache-pool始化(从zk上读取twemproxy的ip和端口):

public class IDCMemcacheProxyFactory extends YmemcacheProxyFactory {

/**

* 初始化 IDC cache 和 twemproxy 的连接

* @throws MemcacheInitException

*/

public void reInitIDCYCache() throws MemcacheInitException {

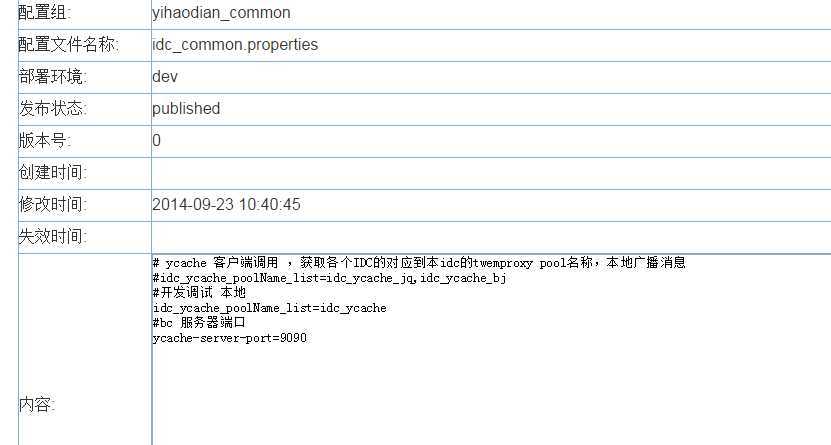

//从ycc 获取各个IDC的对应到本idc的twemproxy pool名称,本地广播消息

String properties = YccGlobalPropertyConfigurer.loadConfigString(IDCConstants.IDCPoolName, IDCConstants.idc_common);

Hashtable<String, String> pro = YccGlobalPropertyConfigurer.loadProperties(properties);

String idc_ycache_poolName_list = pro.get(IDCConstants.IDCCacheIdList);

if (idc_ycache_poolName_list == null || idc_ycache_poolName_list.trim().length() == 0) {

logger.error(IDCConstants.idc_common + " 文件缺少值" + IDCConstants.IDCCacheIdList);

}

String[] poolNames = IDCCommandUtil.getOtherIDCPoolNames();

if(poolNames == null ){

poolNames = idc_ycache_poolName_list.split(",");

IDCCommandUtil.setOtherIDCPoolNames(poolNames);

}else{

for (String poolName : poolNames) {

//先关闭原来的连接

SockIOPool pool = SockIOPool.getInstance(poolName);

if (pool != null && pool.isInitialized()) {

pool.shutDown();

}

}

}

//init idc ycache ,全局只需要增加一次

File loadConfigFile = YccGlobalPropertyConfigurer.loadConfigFile(IDCConstants.IDCPoolName, IDCConstants.idc_ycache_memcache);

super.add("file:" + loadConfigFile.getAbsolutePath());

}

public class IDCConstants {

public static final String IDCPoolName = "yihaodian/common";//poolid

public static final String idc_ycache_redis = "idc_ycache_redis.xml";// dataid

public static final String idc_ycache_memcache = "idc_ycache_memcache.xml";

public static final String idc_common = "idc_common.properties";

public static final String IDCCacheIdList = "idc_ycache_poolName_list";//idc_ycache_redis.xml idc_ycache_memcache.xml 中配置的 id

。。。

}

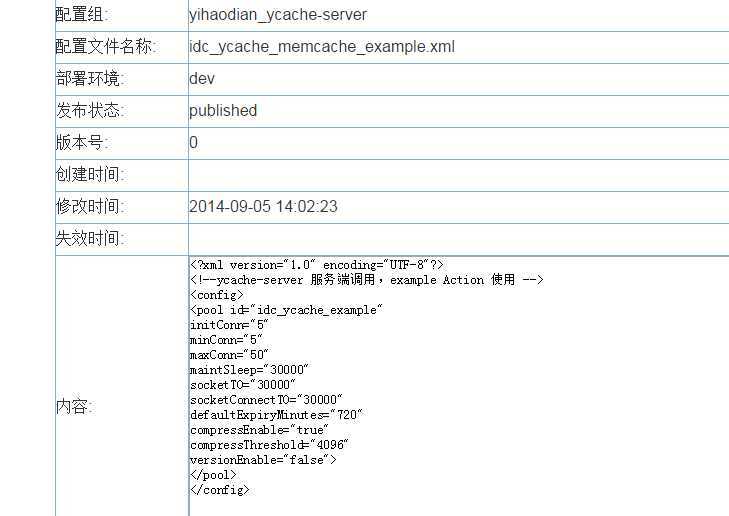

所以,在调用invalid的时候,实际上是遍历这些代表各个idc的cache-pool发送一个invalid消息;这些cache-pool的配置信息是在IDCPoolName = "yihaodian/common"、idc_ycache_memcache = "idc_ycache_memcache.xml"这连个变量指定的配置中心的配置。(多个idc公用这个配置文件,通过pool id属性扩展为多个)。注意,由于所有poolname的ycache-client实例都会连接到twenproxy,数量非常大。所以这个配置文件的mincon必须很小,否则会导致twemproxy的连接数很高。因为invalid消息不多,建议1个就够了。

而要发送给几个idc,是在 IDCPoolName = "yihaodian/common"、idc_common = "idc_common.properties"这里指定的:

ycache-server端:

原理:server端事实上是起一个消息分发器的作用。一个idc内有很多的ycache-server,他们都配置在twemproxy的一个服务组内。twemproxy将一个invalid消息随机(算法可配置)分发给一个ycache-server;ycache-server会根据消息内部的poolname,发送一个delete key和add ttl-key的命令到这个poolname的memcached。 所以ycache-server实际上支持所有poolname的cache-client实例。

内部实现: 配置文件的读取是通过spring框架的配置文件初始化的。所有的poolname使用同一个"memcacheConfigureTemplatePath"=yihaodian/common : yihaodian_ycache-server/idc_ycache_memcache_server_template.xml指定的配置文件模板,每次初始化一个poolname的clien实例时,更改一下配置文件的pool id属性即可;而poolname的memcached的ip和端口号从zk读取。

注意,ycache-server要连接所有poolname的memcache实例,数量非常大。所以这个配置文件的mincon必须很小。因为invalid消息不多,建议1个就够了。

public class CacheServiceImpl implements CacheService {

public void init() throws Exception {

logger.info("start init all cache");

CacheAdmin.getInstance().reInitAll(zkServers, this.memcacheConfigureTemplatePath, this.redisConfigureTemplatePath, initAllCache);

logger.info("finish init all cache");

}

/ycache-server/src/main/resources/applicationContext.xml

<bean id="yccPropertyConfigurer_common"

class="com.yihaodian.configcentre.client.utils.YccGlobalPropertyConfigurer">

<property name="locations">

<list>

<value>zookeeper-ycache.properties</value>

<value>idc_common.properties</value>

<value>yihaodian_ycache-server/idc_ycache_memcache_server_template.xml</value>

<value>yihaodian_ycache-server/idc_ycache_redis_server_template.xml</value>

</list>

</property>

<property name="poolId">

<value>yihaodian/common</value>

</property>

<property name="ignoreUnresolvablePlaceholders" value="true" />

</bean>

<bean id="nettyService" class="com.yhd.ycache.service.NettyServiceImpl" init-method="init" destroy-method="destroy">

<property name="port" value="${ycache-server-port}"/>

</bean>

<bean id="cacheService" class="com.yhd.ycache.service.CacheServiceImpl" init-method="init" destroy-method="destroy">

<!-- 值来自zookeeper-ycache.properties-->

<property name="memcacheConfigureTemplatePath" value="file:${global.config.path}/ycc/snapshot/yihaodian_ycache-server/idc_ycache_memcache_server_template.xml"/>

<property name="redisConfigureTemplatePath" value="file:${global.config.path}/ycc/snapshot/yihaodian_ycache-server/idc_ycache_redis_server_template.xml"/>

<property name="zkServers" value="${zk-servers}"/>

<property name="initAllCache" value="false"/>

</bean>

<bean id="exampleService" class="com.yhd.ycache.service.ExampleServiceImpl"></bean>

twemproxy:

twemproxy在整个组网中起桥接各个idc的作用。每个twemproxy都连接其他idc的twemproxy,任何ycache-client需要跨idc的通信都是通过twemproxy完成。也就是任何ycache-client都不应该看到非本idc的cache的存在。每个idc的twemproxy为本idc的ycache-client开启代表其他idc的端口(每个端口代表一个idc),所以ycache-client需要给其他idc的cache发送消息时,就往本idc的twemproxy的这些端口通信。

同时,从ycache-client的视角,twemproxy其实相当于cache实例。每个idc有两个twemproxy(相互备份和负载分担),它们像cache一样被分配在一个pool-id内,写到zookeeper的‘/ycache/pools/‘路径下。所以本idc的ycache以为自己连接的是cache。