标签:miss ecif env property 环境 ssi img bin hdfs

准备:

7Zip下载:压缩工具,支持*.tar.gz格式的压缩文件解压

Hadoop下载:http://archive.apache.org/dist/hadoop/core/,笔者选择3.0.0版本下载,官网下载的网速如同断网。。。

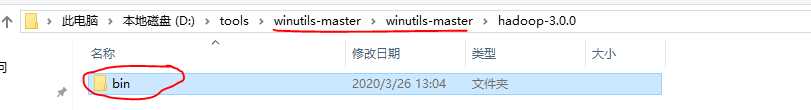

winutils下载:https://github.com/steveloughran/winutils,Hadoop不直接支持Windows,使用工具集进行支持。

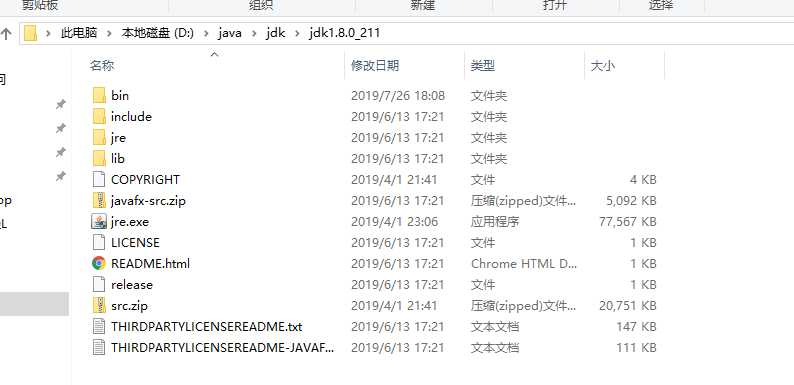

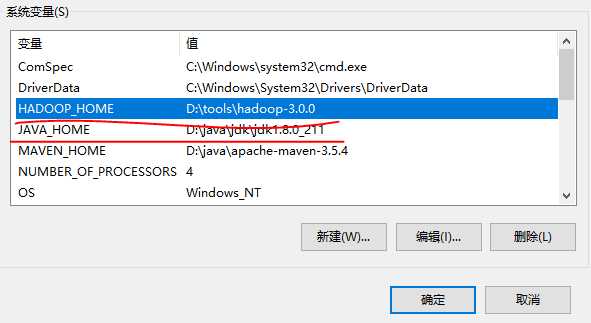

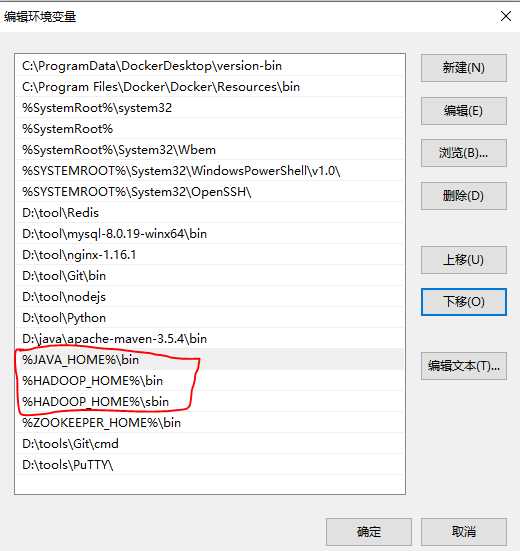

JDK1.8及其以上版本,自行安装,并配置JAVA_HOME环境变量。

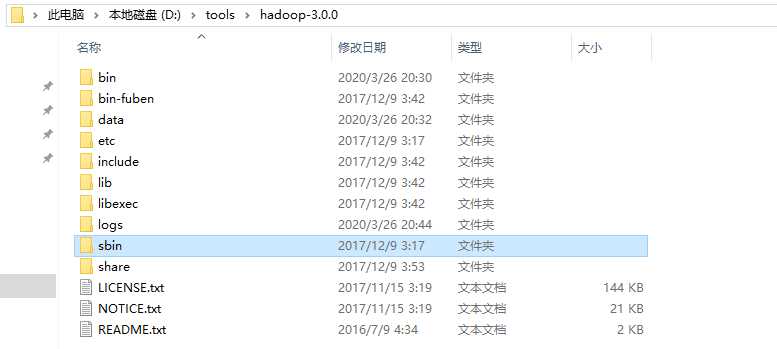

a. 将原始hadoop-3.0.0下bin目录备份;

b. 使用winutils中的bin目录整个替换hadoop中的bin目录:

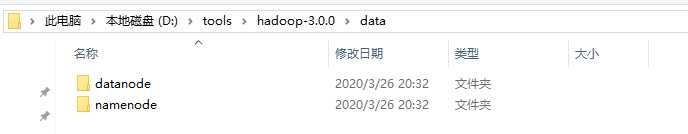

c. 在hadoop-3.0.0下按目录创建如下文件夹:

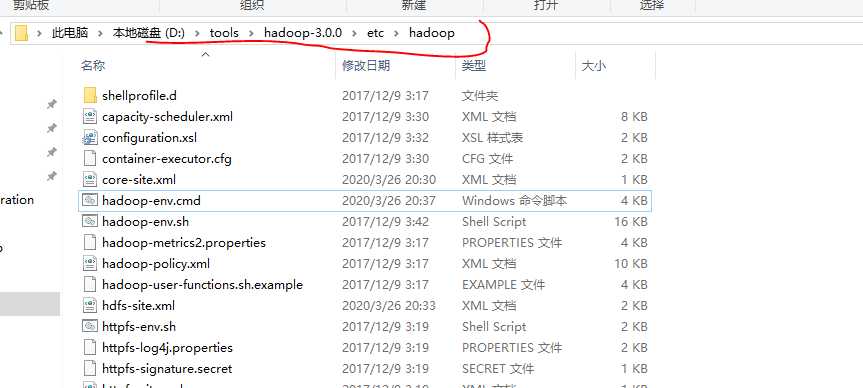

a. hadoop配置文件目录:

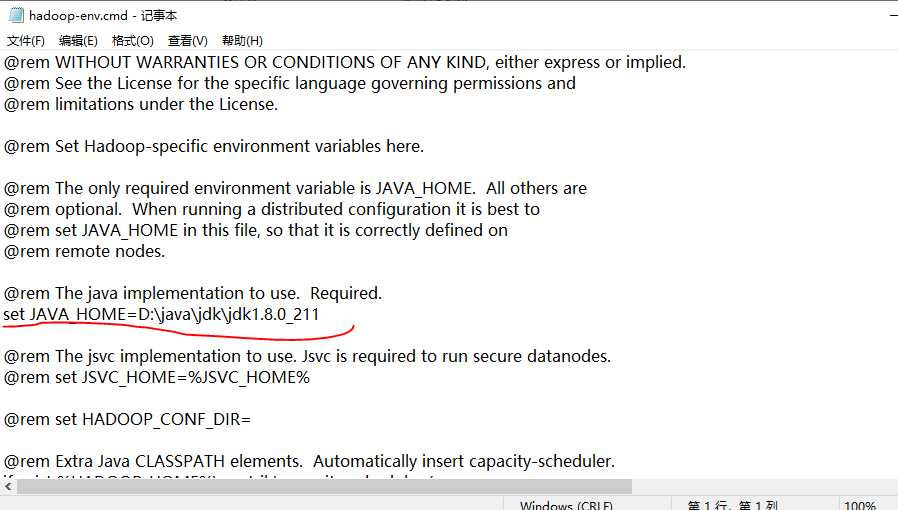

b. 配置hadoop-env.cmd, 这里将JAVA_HOME换成绝对目录(不确定不换可不可以)

c. core-site.xml 添加如下配置

1 <configuration> 2 <property> 3 <name>fs.default.name</name> 4 <value>hdfs://localhost:9000</value> 5 </property> 6 </configuration>

d. hdfs-site.xml添加如下配置

1 <configuration> 2 <property> 3 <name>dfs.replication</name> 4 <value>1</value> 5 </property> 6 <property> 7 <name>dfs.permissions</name> 8 <value>false</value> 9 </property> 10 <property> 11 <name>dfs.namenode.name.dir</name> 12 <value>/D:/hadoop-3.0.0/data/namenode</value> 13 </property> 14 <property> 15 <name>fs.checkpoint.dir</name> 16 <value>/D:/hadoop-3.0.0/data/snn</value> 17 </property> 18 <property> 19 <name>fs.checkpoint.edits.dir</name> 20 <value>/D:/hadoop-3.0.0/data/snn</value> 21 </property> 22 <property> 23 <name>dfs.datanode.data.dir</name> 24 <value>/D:/hadoop-3.0.0/data/datanode</value> 25 </property> 26 27 </configuration>

e. mapred-site.xml添加如下配置

1 <configuration> 2 <property> 3 <name>mapreduce.framework.name</name> 4 <value>yarn</value> 5 </property> 6 7 </configuration>

f. yarn-site.xml添加如下配置

1 <configuration> 2 <!-- Site specific YARN configuration properties --> 3 <property> 4 <name>yarn.nodemanager.aux-services</name> 5 <value>mapreduce_shuffle</value> 6 </property> 7 <property> 8 <name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name> 9 <value>org.apache.hadoop.mapred.ShuffleHandler</value> 10 </property> 11 </configuration>

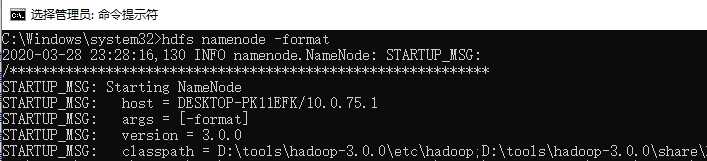

使用管理员权限运行命令行

使用如下命令进行格式化:

hdfs namenode -format

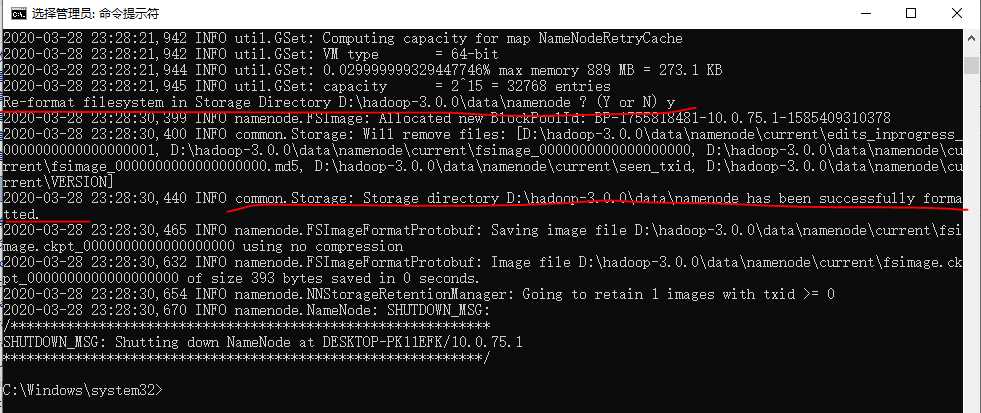

根据提示输入y,格式化成功结果如下:

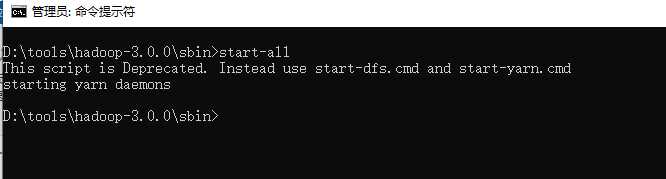

进入Hadoop的sbin目录,执行命令:

start-all

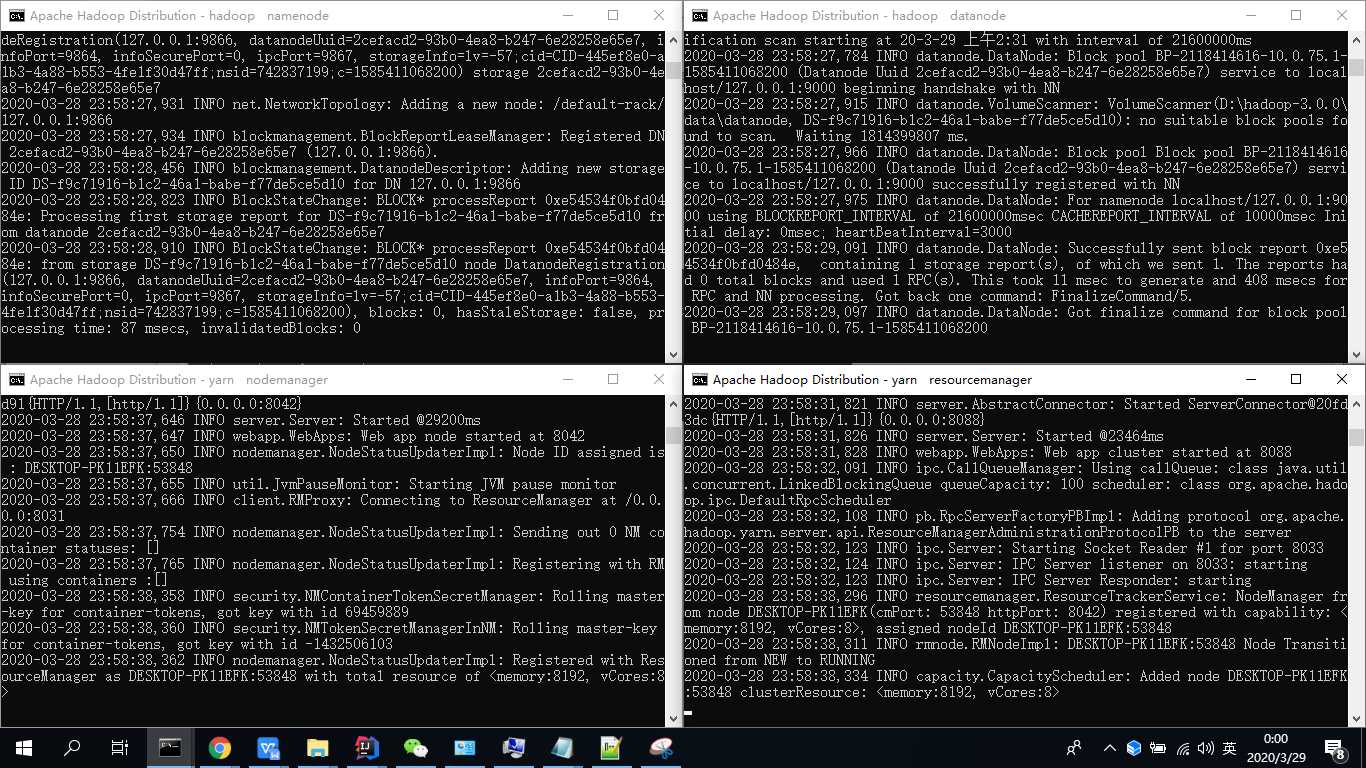

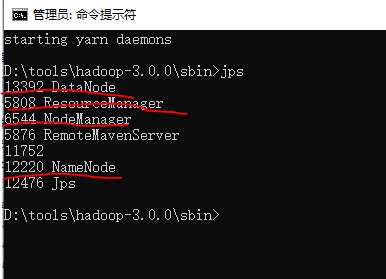

启动四个服务窗口:

四个服务如下图所示:

启动成功。

本文结束。

标签:miss ecif env property 环境 ssi img bin hdfs

原文地址:https://www.cnblogs.com/yelao/p/12577412.html