标签:存储 erro 性能 real-ip load oca style err std

为什么要使用负载均衡

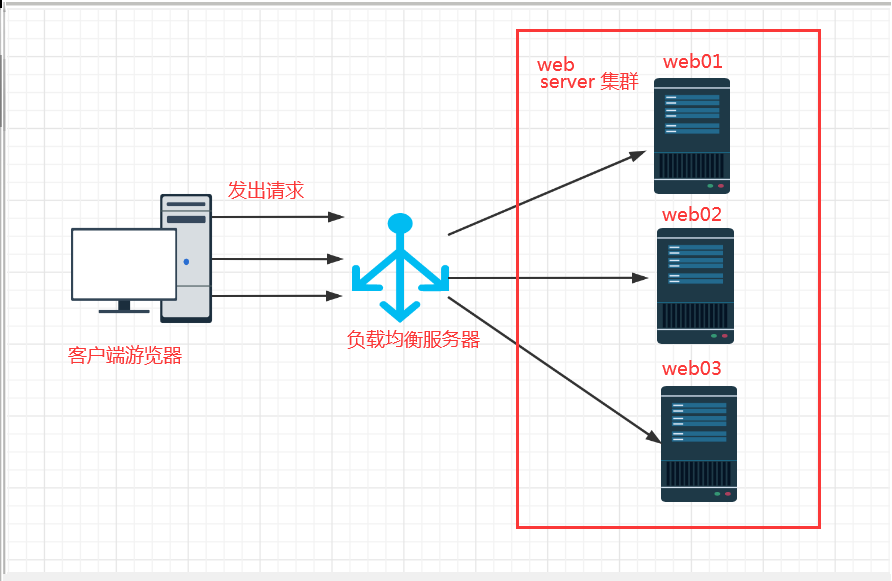

当我们的Web服务器直接面向用户,往往要承载大量并发请求,单台服务器难以负荷,我使用多台Web服务器组成集群,前端使用Nginx负载均衡,将请求分散的打到我们的后端服务器集群中,实现负载的分发。那么会大大提升系统的吞吐率、请求性能、高容灾

往往我们接触的最多的是SLB(Server Load Balance)负载均衡,实现最多的也是SLB、那么SLB它的调度节点和服务节点通常是在一个地域里面。那么它在这个小的逻辑地域里面决定了他对部分服务的实时性、响应性是非常好的。

所以说当海量用户请求过来以后,它同样是请求调度节点,调度节点将用户的请求转发给后端对应的服务节点,服务节点处理完请求后在转发给调度节点,调度节点最后响应给用户节点。这样也能实现一个均衡的作用,那么Nginx则是一个典型的SLB

负载均衡的叫法有很多:

负载均衡

负载

Load Balance

LB

公有云中叫法

SLB 阿里云负载均衡

QLB 青云负载均衡

CLB 腾讯云负载均衡

ULB ucloud负载均衡

常见的负载均衡的软件

Nginx

Haproxy

LVS

# 1.所谓四层负载均衡指的是OSI七层模型中的传输层,那么传输层Nginx已经能支持TCP/IP的控制,所以只需要对客户端的请求进行TCP/IP协议的包转发就可以实现负载均衡,那么它的好处是性能非常快、只需要底层进行应用处理,而不需要进行一些复杂的逻辑。

# 2.七层负载均衡它是在应用层,那么它可以完成很多应用方面的协议请求,比如我们说的http应用的负载均衡,它可以实现http信息的改写、头信息的改写、安全应用规则控制、URL匹配规则控制、以及转发、rewrite等等的规则,所以在应用层的服务里面,我们可以做的内容就更多,那么Nginx则是一个典型的七层负载均衡SLB

# 四层负载均衡数据包在底层就进行了分发,而七层负载均衡数据包则是在最顶层进行分发、由此可以看出,七层负载均衡效率没有四负载均衡高。

# 但七层负载均衡更贴近于服务,如:http协议就是七层协议,我们可以用Nginx可以作会话保持,URL路径规则匹配、head头改写等等,这些是四层负载均衡无法实现

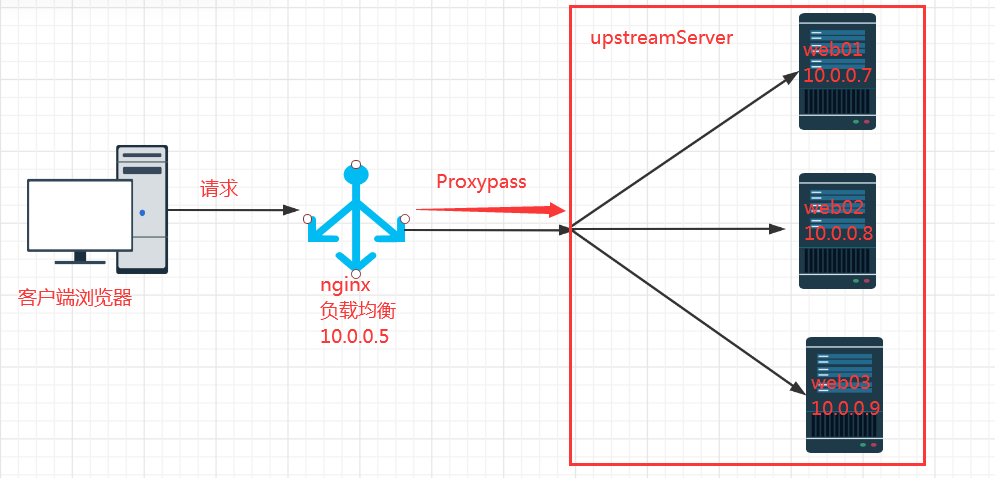

Nginx要实现负载均衡需要用到proxy_pass代理模块配置.

Nginx负载均衡与Nginx代理不同地方在于,Nginx的一个location仅能代理一台服务器,而Nginx负载均衡则是将客户端请求代理转发至一组upstream虚拟服务池.

yntax: upstream name { ... }

Default: -

Context: http

#upstream例

upstream backend {

server backend1.example.com weight=5;

server backend2.example.com:8080;

server unix:/tmp/backend3;

server backup1.example.com:8080 backup;

}

server {

location / {

proxy_pass http://backend;

}

}

负载均衡

七层负载均衡指的是,http

1.有多台web时,我不想再手动切换域名了

2.代理只能代理一台机器啊...

3.一台机器扛不住了,要上两台

4.如果手动切换,我们做不到负载均衡

文件服务器(共享存储)

NFS

HDFS

FastDFS

Ceph

GlusterFS

软件负载均衡

nginx

LVS

HAproxy

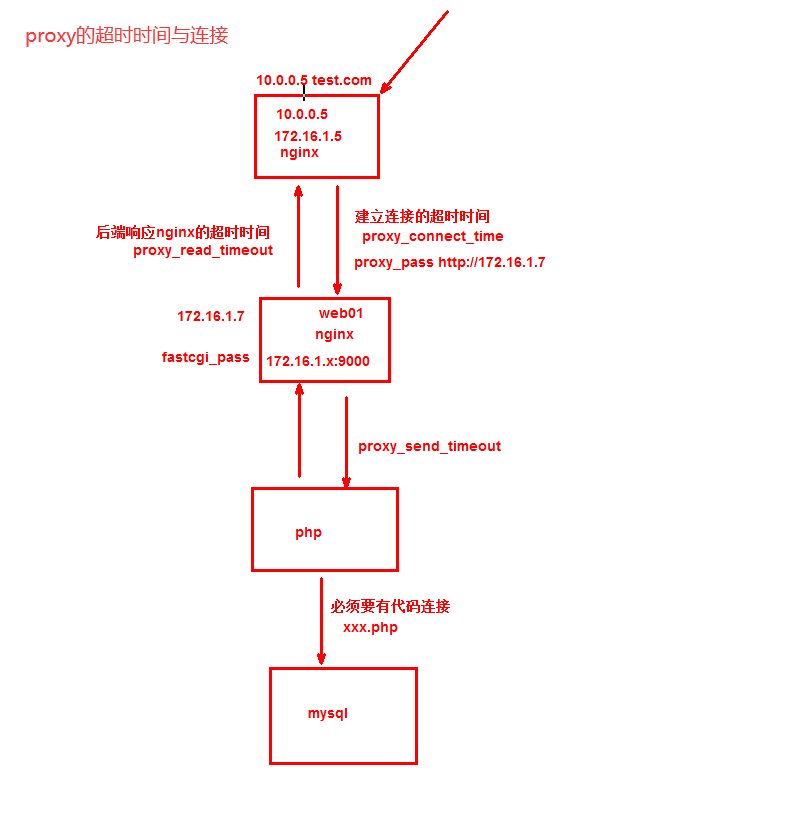

[root@Nginx ~]# vim /etc/nginx/proxy_params

proxy_set_header Host $http_host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

# nginx代理与后端服务器连

proxy_connect_timeout 30;

# nginx代理等待后端服务器的响应时间

proxy_send_timeout 60;

# 后端服务器数据回传给nginx代理超时时间

proxy_read_timeout 60;

## 优化缓冲区

proxy_buffering on;

proxy_buffer_size 32k;

proxy_buffers 4 128k;

# 解决负载均衡常见典型故障

proxy_next_upstream error timeout http_500 http_502 http_503 http_504;

upstream zh_lb { # 名字可以随便取

server 10.0.0.7; # ip

server 10.0.0.8;

server 10.0.0.9;

server 10.0.0.10;

}

server {

listen 80;

server_name zh.com;

location / {

proxy_pass http://zh_lb; # 包括上面的所有IP

include proxy_params; # 包含proxy的优化

}

proxy_set_header HOST $host; # 请求头带上的域名

}

如果后台服务连接超时,Nginx是本身是有机制的,如果出现一个节点down掉的时候,Nginx会更据你具体负载均衡的设置,将请求转移到其他的节点上,但是,如果后台服务连接没有down掉,但是返回错误异常码了如:504、502、500,这个时候你需要加一个负载均衡的设置,如下:proxy_next_upstream http_500 | http_502 | http_503 | http_504 |http_404;意思是,当其中一台返回错误码404,500...等错误时,可以分配到下一台服务器程序继续处理,提高平台访问成功率。

server {

listen 80;

server_name blog.driverzeng.com;

location / {

proxy_pass http://node;

proxy_next_upstream error timeout http_500 http_502 http_503 http_504;

}

}

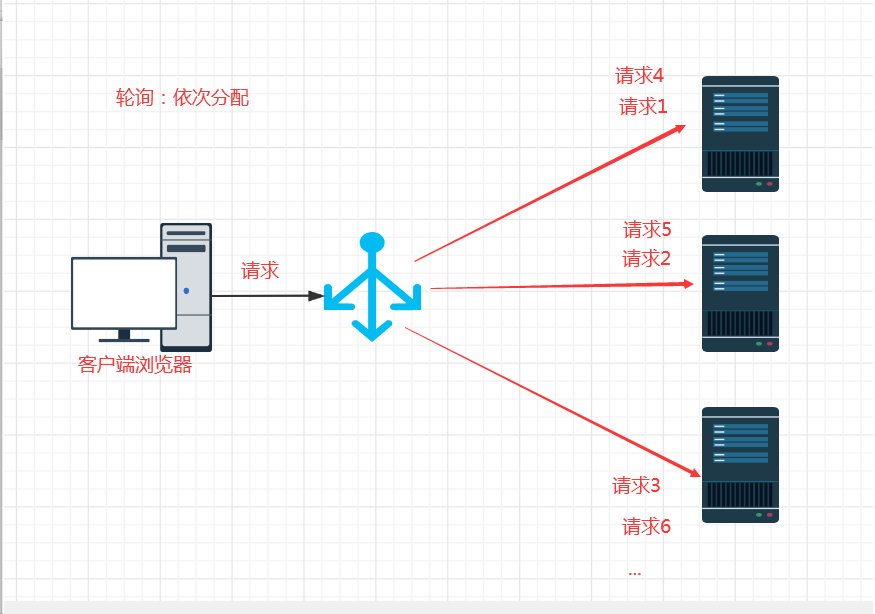

| 算法名称 | 简称 | 概述 |

|---|---|---|

| 轮询(默认) | round-robin(RR) | 按照时间顺序逐一分配到后端不同的服务器 |

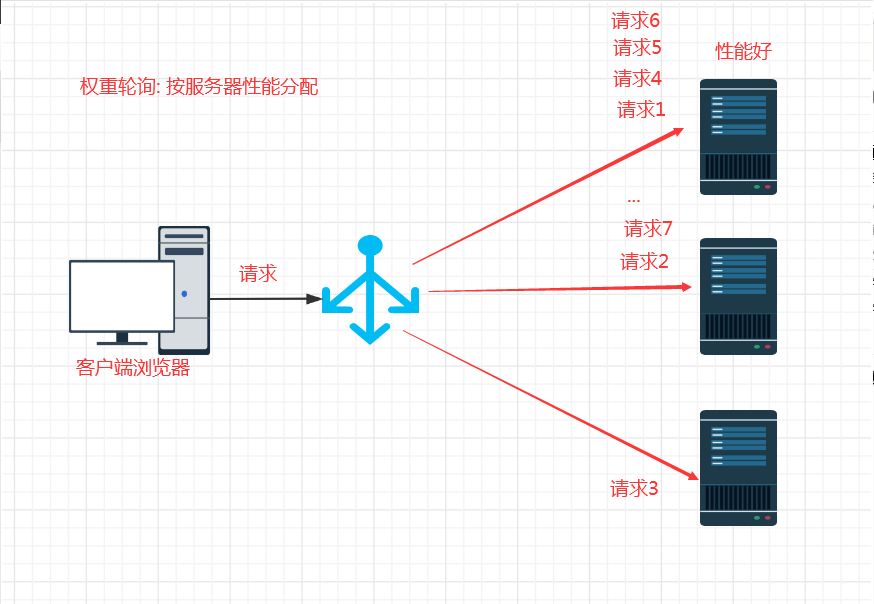

| weight | weight-round-robin(WRR) | 根据权重,将请求分配到后端的服务器 |

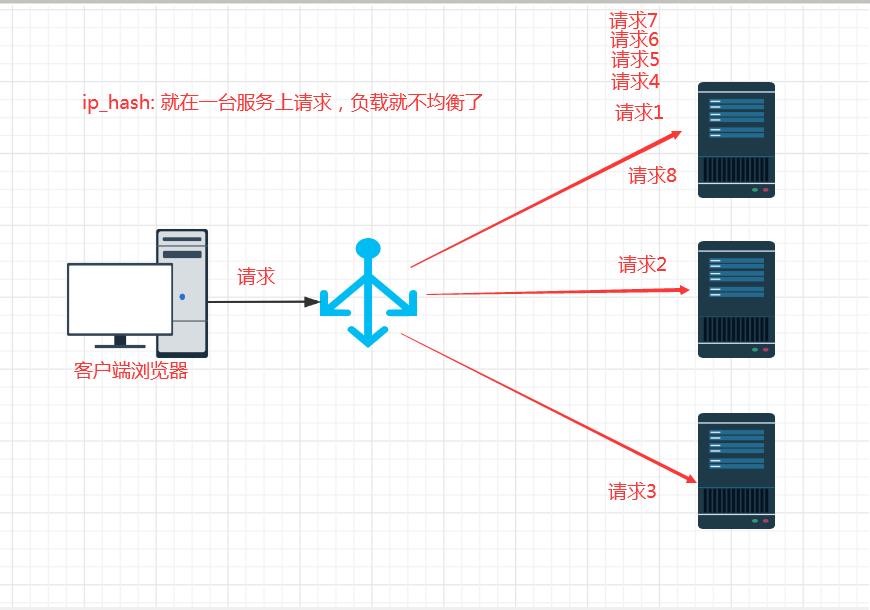

| ip_hash | ip_hash | 每个请求按访问IP的hash结果分配,这样来自同一IP的固定访问一个后端服务 |

| url_hash | url_hash | 按照访问URL的hash结果来分配请求,是每个URL定向到同一个后端服务器 |

| least_conn | least_conn | 最少链接数,那个机器链接数少就分发 |

upstream load_pass {

server 10.0.0.7:80;

server 10.0.0.8:80;

...

}

upstream load_pass {

server 10.0.0.7:80 weight=5; # 5:1分配

server 10.0.0.8:80; # 默认 1

}

使用nginx的ip_hash,根据客户端的IP,将请求分配到对应的IP上,可以保持会话

具体配置不能和weight一起使用。

#如果客户端都走相同代理, 会导致某一台服务器连接过多

upstream load_pass {

ip_hash;

server 10.0.0.7:80 weight=5;

server 10.0.0.8:80;

}

# 按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,要配合缓存命中来使用。同一个 资源多次请求,可能会到达不同的服务器上,导致不必要的多次下载,缓存命中率不高,以及一些资源时间的 浪费。而使用url_hash,可以使得同一个url(也就是同一个资源请求)会到达同一台服务器,一旦缓存住 了资源,再此收到请求,就可以从缓存中读取。

upstream load_pass {

hash $request_uri;#实现每个url定向到同一个后端服务器

server 10.0.0.7:80;

server 10.0.0.8:80;

server 10.0.0.9:80;

}

# 把请求转发给连接数较少的后端服务器。轮询算法是把请求平均的转发给各个后端,使它们的负载大致相 同;但是,有些请求占用的时间很长,会导致其所在的后端负载较高。这种情况下,least_conn这种方式就 可以达到更好的负载均衡效果。

upstream load_pass {

least_conn;

server 10.0.0.7:80;

server 10.0.0.8:80;

server 10.0.0.9:80;

}

标签:存储 erro 性能 real-ip load oca style err std

原文地址:https://www.cnblogs.com/jkz1/p/13028116.html