标签:-- dde 输出 neu 应用 idt 更新 开始学习 width

5.1 Cross-Entropy Cost

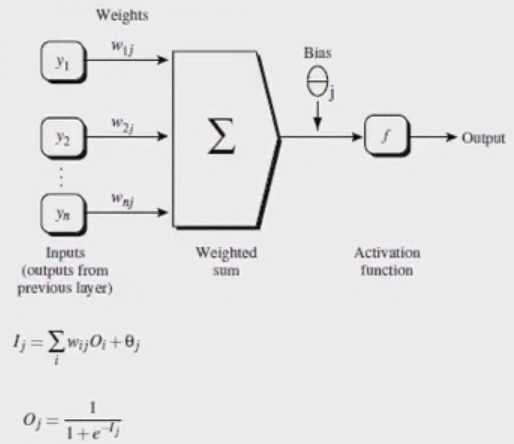

上节实现了一个简单的神经网络所需要的所有function,包括梯度下降算法,BP算法等,利用python实现最简单的神经网络。从本节课开始介绍另外一种cost function。

我们理想情况是让神经网络学习更快。

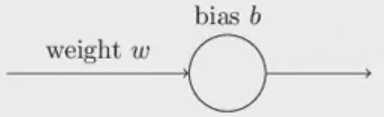

假设简单模型:只有一个输入、一个神经元、一个输出:

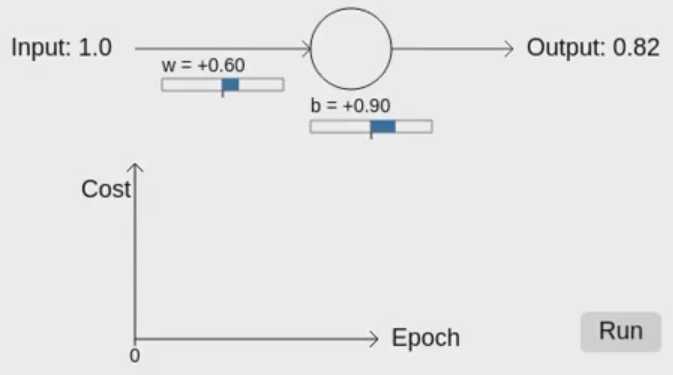

我们想让这个简单模型:输入为1的时候,输出为0.

初始w=0.6,b=0.9,初始测试的输出a=0.82,需要学习,学习率为0.15:

I = 1*0.6+0.9 = 1.5

O = 1/1+e-1.5 = 0.82

我们是要输入为1,输出为0。就需要利用学习率来更新,实现输出为0的目标。

--》

--》

http://neuralnetworksanddeeplearning.com/chap3.html

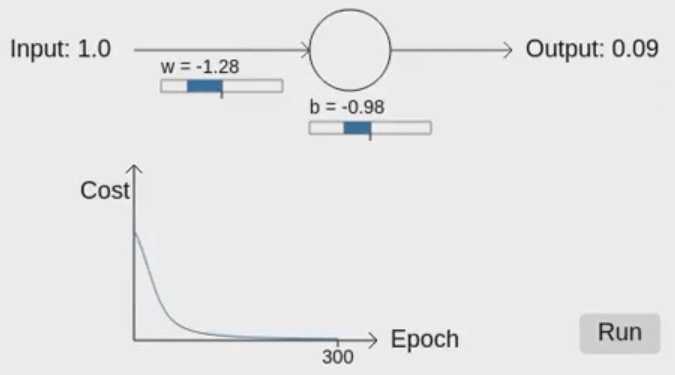

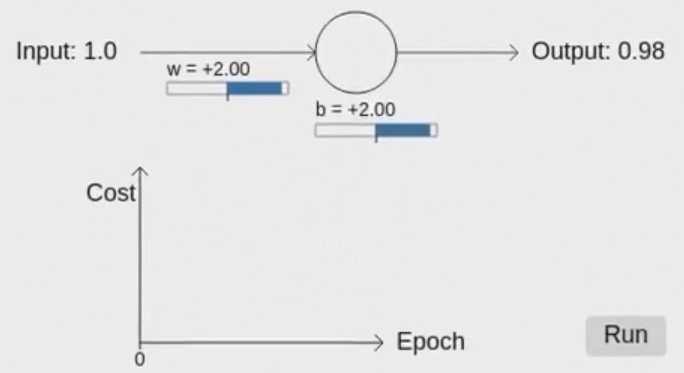

当我们设置初始值w=2.0,b=2.0,这样初始预测输出为:0.98,和理想的输出0差距很远:

--》

--》

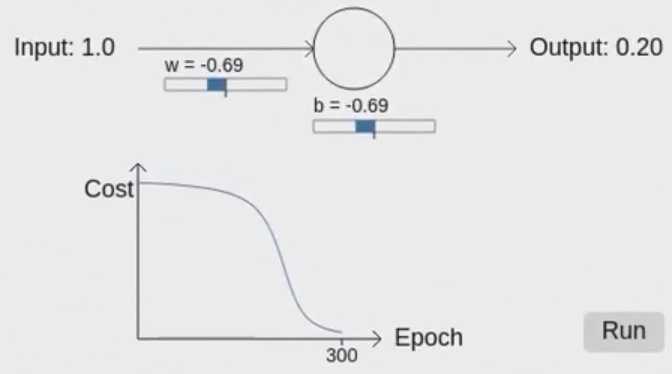

虽然一开始下降的不是很明显,但到最后下降到0.02,离0很接近了。

总结:神经网络的学习行为和人脑差的很多,开始学习很慢,后来逐渐变快了。

Python_DL_麦子学院(算法与应用_进阶)_14~20 _Cross entropy函数

标签:-- dde 输出 neu 应用 idt 更新 开始学习 width

原文地址:https://www.cnblogs.com/tlfox2006/p/13122102.html