标签:try property tty 过滤 也会 url for empty map

为了便于分析和记录系统的运行,一个系统输出其运行的关键日志是非常必要的

比如输出:请求参数、请求url、请求方式、执行的sql、重要操作的日志、响应结果等

而这些日志中,大部分不需要我们手动对每个接口去输出,主需要统一配置就可以了

步骤一:在resources下添加logback文件,这个问价基本上每个项目都是一样的,拷贝过来就可以使用

<?xml version="1.0" encoding="UTF-8"?> <!-- scan:当此属性设置为true时,配置文件如果发生改变,将会被重新加载,默认值为true。 scanPeriod:设置监测配置文件是否有修改的时间间隔,如果没有给出时间单位,默认单位是毫秒;当scan为true时,此属性生效。默认的时间间隔为1分钟。 debug:当此属性设置为true时,将打印出logback内部日志信息,实时查看logback运行状态。默认值为false。 --> <configuration scan="false" scanPeriod="60 seconds" debug="false"> <!-- property:定义变量,相当于java中定义一个 String name="张无忌"; 变量名LOG_HOME,用于日志根目录文件夹定义,可以任意命名 变量名appName,用于日志文件名定义,可以任意命名 变量名logLevel,用于日志输出级别定义,可以为 debug,info,error --> <property name="LOG_HOME" value="logs"/> <property name="appName" value="log"></property> <property name="logLevel" value="info"></property> <!-- 获取当前日期,一般生产上按照每天一个文件夹,文件夹的名称就是年月日 <timestamp key="dateTime" datePattern="yyyy-MM-dd"/> --> <!-- 1.ch.qos.logback.core.ConsoleAppender 表示控制台输出 2.name 可以任意取名字 3.每个appender为一个日志类型 --> <appender name="stdout" class="ch.qos.logback.core.ConsoleAppender"> <!-- 日志输出格式: %d表示日期时间, %thread表示线程名, %-5level:级别从左显示5个字符宽度 %logger{50} 表示logger名字最长50个字符,否则按照句点分割。 %msg:日志消息, %n是换行符 一般不输出年份 案例一:<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} ==> [%thread] ==> %-5level %logger{50} - %msg%n</pattern> --> <encoder> <pattern>%d{MM-dd HH:mm:ss.SSS} [%thread] %level %logger{50} - %msg%n</pattern> <charset>UTF-8</charset> </encoder> </appender> <!-- 滚动记录文件,先将日志记录到指定文件,当符合某个条件时,将日志记录到其他文件 --> <appender name="all" class="ch.qos.logback.core.rolling.RollingFileAppender"> <!--append:如果是 true,日志被追加到文件结尾,如果是 false,清空现存文件,默认是true。--> <append>true</append> <!-- 日志输出等级 如果需要输出mybatis执行的sql日志,需要使用debug --> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>debug</level> </filter> <!-- 指定日志文件的名称与输出位置 --> <file>${LOG_HOME}/${appName}-all.log</file> <!-- 归档日志处理规则 当发生滚动时,决定 RollingFileAppender 的行为,涉及文件移动和重命名 TimeBasedRollingPolicy: 最常用的滚动策略,它根据时间来制定滚动策略,既负责滚动也负责出发滚动。 --> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <!-- 滚动时产生的文件的存放位置及文件名称 %d{yyyy-MM-dd}:按天进行日志滚动 %i:当文件大小超过maxFileSize时,按照i进行文件滚动 .zip:表示生成的归档文件进行压缩 --> <fileNamePattern>${LOG_HOME}/%d{yyyy-MM-dd}/${appName}-all.%d.%i.log.zip</fileNamePattern> <!-- 可选节点,控制保留的归档文件的最大数量,超出数量就删除旧文件。假设设置每天滚动, 且maxHistory是30,则只保存最近30天的文件,删除之前的旧文件。注意,删除旧文件是, 那些为了归档而创建的目录也会被删除。 实际生中一般日志保留30天,可以根据特殊业务设置保留时间 --> <MaxHistory>30</MaxHistory> <!-- 当日志文件超过maxFileSize指定的大小时,根据上面提到的%i进行日志文件滚动 注意此处配置SizeBasedTriggeringPolicy是无法实现按文件大小进行滚动的,必须配置timeBasedFileNamingAndTriggeringPolicy 一般10M一个文件 这里为了测试滚动产生日志文件,设置为10KB --> <timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP"> <maxFileSize>10KB</maxFileSize> <!--<maxFileSize>10MB</maxFileSize>--> </timeBasedFileNamingAndTriggeringPolicy> </rollingPolicy> <!-- 日志输出格式: %d表示日期时间, %thread表示线程名, %-5level:级别从左显示5个字符宽度 %logger{50} 表示logger名字最长50个字符,否则按照句点分割。 %msg:日志消息, %line: 行号显示,建议删除,这个有很多的性能损耗,报错的时候有堆栈信息 %n是换行符 案例: <pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [ %thread ] - [ %-5level ] [ %logger{50} : %line ] - %msg%n</pattern> --> <encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder"> <pattern>%d{MM-dd HH:mm:ss.SSS} [%thread] %level - %msg%n</pattern> <charset>UTF-8</charset> </encoder> </appender> <!--输出到error--> <appender name="error" class="ch.qos.logback.core.rolling.RollingFileAppender"> <append>true</append> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>error</level> </filter> <file>${LOG_HOME}/${appName}-error.log</file> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <fileNamePattern>${LOG_HOME}/%d{yyyy-MM-dd}/${appName}-error.%d.%i.log.zip</fileNamePattern> <MaxHistory>30</MaxHistory> <timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP"> <maxFileSize>10MB</maxFileSize> </timeBasedFileNamingAndTriggeringPolicy> </rollingPolicy> <encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder"> <pattern>%d{MM-dd HH:mm:ss.SSS} [%thread] %level - %msg%n</pattern> <charset>UTF-8</charset> </encoder> </appender> <!-- logger主要用于存放日志对象,也可以定义日志类型、级别 name:表示匹配的logger类型前缀,也就是包的前半部分 level:要记录的日志级别,包括 TRACE < DEBUG < INFO < WARN < ERROR additivity:作用在于children-logger是否使用 rootLogger配置的appender进行输出, false:表示只用当前logger的appender-ref,true: 表示当前logger的appender-ref和rootLogger的appender-ref都有效 root与logger是父子关系,没有特别定义则默认为root,任何一个类只会和一个logger对应, 要么是定义的logger,要么是root,判断的关键在于找到这个logger,然后判断这个logger的appender和level。 --> <root level="${logLevel}"> <appender-ref ref="stdout"/> <appender-ref ref="all"/> <appender-ref ref="error"/> </root> </configuration>

步骤二:添加一个过滤器,在过滤器中统一输出日志

package com.ldp.user.common.interceptor; import cn.hutool.core.util.RandomUtil; import cn.hutool.core.util.StrUtil; import cn.hutool.extra.servlet.ServletUtil; import lombok.extern.slf4j.Slf4j; import org.springframework.http.HttpHeaders; import org.springframework.http.MediaType; import org.springframework.stereotype.Component; import javax.servlet.*; import javax.servlet.http.HttpServletResponse; import java.io.IOException; /** * @Copyright (C) XXXXX科技有限公司 * @Author: LI DONG PING * @Date: 2019/4/22 17:47 * @Description: */ @Component @Slf4j public class HttpServletRequestWrapperFilter implements Filter { private final String CHARSET = "UTF-8"; @Override public void doFilter(ServletRequest request, final ServletResponse response, FilterChain chain) throws IOException, ServletException { // 自定义线程名称 Thread.currentThread().setName(RandomUtil.randomString(10)); MultiReadHttpServletRequest requestWrapper = new MultiReadHttpServletRequest(request); ResponseWrapper responseWrapper = new ResponseWrapper((HttpServletResponse) response, CHARSET); String contentType = requestWrapper.getHeader(HttpHeaders.CONTENT_TYPE); String url = requestWrapper.getRequestURL().toString(); if (url.contains("actuator") || url.contains("swagger") || url.contains("csrf")) { chain.doFilter(requestWrapper, responseWrapper); byte[] bytes = responseWrapper.getBytes(); response.getOutputStream().write(bytes); return; } if (!url.contains("actuator")) { log.info("ContentType: {}", contentType); log.info("请求地址: {}", url); log.info("请求方法: {}", requestWrapper.getMethod().toUpperCase()); if (isTextContentType(contentType)) { String params = requestWrapper.getQueryString(); if (!StrUtil.isEmpty(params)) { log.info("请求参数: {}", params); } String body = ServletUtil.getBody(requestWrapper); if (!StrUtil.isEmpty(body)) { log.info("请求参数[body]: {}", body); } } long start = System.currentTimeMillis(); chain.doFilter(requestWrapper, responseWrapper); long end = System.currentTimeMillis(); byte[] bytes = responseWrapper.getBytes(); if (isTextContentType(response.getContentType())) { try { log.info("响应结果: {}", new String(bytes, CHARSET)); } catch (Exception ex) { log.error("响应异常", ex); } } log.info("HTTP状态: {}", responseWrapper.getStatus()); long diff = end - start; if (diff < 1000) { log.info("处理时长: {}毫秒", diff); } else { log.error("处理时长: {}毫秒,url:{}", diff, url); } response.getOutputStream().write(bytes); } else { chain.doFilter(requestWrapper, responseWrapper); byte[] bytes = responseWrapper.getBytes(); response.getOutputStream().write(bytes); } } private boolean isTextContentType(String contentType) { return contentType != null && (contentType.contains(MediaType.TEXT_PLAIN_VALUE) || contentType.contains(MediaType.TEXT_XML_VALUE) || contentType.contains(MediaType.TEXT_HTML_VALUE) || contentType.contains(MediaType.APPLICATION_FORM_URLENCODED_VALUE) || contentType.contains(MediaType.APPLICATION_JSON_VALUE) || contentType.contains(MediaType.APPLICATION_XML_VALUE)); } }

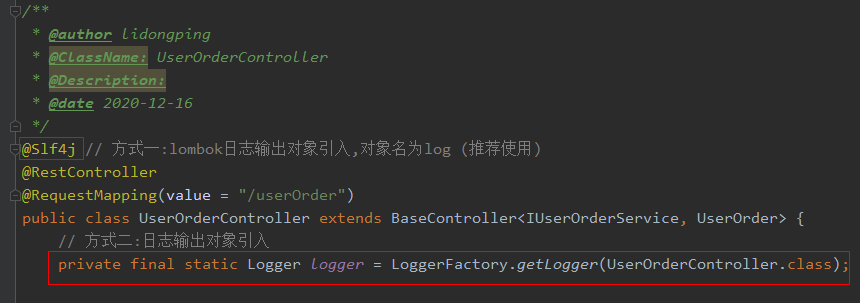

步骤三:引入日志输出对象

// 方式一:lombok日志输出对象引入,变量名为log (推荐使用) @Slf4j // 方式二:日志输出对象引入 变量名为logger private final static Logger logger = LoggerFactory.getLogger(UserOrderController.class);

步骤四:使用

/** * 测试统一日志输出 * * @param message * @return */ @GetMapping("/log") public BaseResponse log(String message) { // 注意这个System.out.println的输出,只会输出到控制台,不能输出到日志文件, // 而且效率很低,只用于平时开发,实际生产几乎不可能使用 System.out.println("message=" + message); logger.debug("debug日志输出,message={}", message); // 这两种写法一样 logger.debug("debug日志输出,message=" + message); logger.info("info日志输出,message={}", message); logger.error("error 日志输出,message={}", message); // 模拟输出错误堆栈信息 try { if ("abc".equals(message)) { Integer value = Integer.valueOf(message); logger.info("value=" + value); } } catch (Exception e) { logger.error("数字转换异常:", e.getMessage()); logger.error("数字转换异常:", e); } // 不处理的异常 Integer value2 = Integer.valueOf(message); logger.info("value2=" + value2); return ResponseBuilder.success("统一参数检查....."); }

步骤五:模拟请求测试

/** * 统一日志输出测试 */ @Test void logTest() { String url = urlLocal + "/userOrder/log"; System.out.println("请求地址:" + url); HttpRequest request = HttpUtil.createRequest(Method.GET, url); Map<String, Object> map = new TreeMap<>(); // 业务参数 map.put("message", "1000"); // 公用参数 map.put("appid", "1001"); map.put("sequenceId", "seq" + System.currentTimeMillis()); map.put("timeStamp", System.currentTimeMillis()); map.put("sign", signApi(map, "123456")); request.form(map); System.out.println("请求参数:" + map); request.header("Authorization", token); request.setConnectionTimeout(60 * 1000); String response = request.execute().body(); System.out.println("请求结果:" + response); }

日志输出结果:

01-02 08:59:51.760 [rptudgh22m] INFO com.ldp.user.controller.UserOrderController - info日志输出,message=1000

01-02 08:59:51.760 [rptudgh22m] ERROR com.ldp.user.controller.UserOrderController - error 日志输出,message=1000

01-02 08:59:51.760 [rptudgh22m] INFO com.ldp.user.controller.UserOrderController - value2=1000

01-02 08:59:51.796 [rptudgh22m] INFO c.l.u.c.i.HttpServletRequestWrapperFilter - 响应结果: {"message":"success","code":100,"data":"统一参数检查....."}

01-02 08:59:51.797 [rptudgh22m] INFO c.l.u.c.i.HttpServletRequestWrapperFilter - HTTP状态: 200

01-02 08:59:51.798 [rptudgh22m] INFO c.l.u.c.i.HttpServletRequestWrapperFilter - 处理时长: 275毫秒

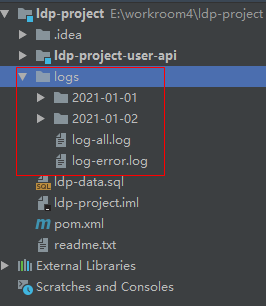

生成的日志文件夹

文字描述内容有限,如果还是不明白可以直接问我,或者在看视频讲解与演示

标签:try property tty 过滤 也会 url for empty map

原文地址:https://www.cnblogs.com/newAndHui/p/14221092.html