标签:blog http io ar 使用 sp 文件 数据 on

最近由于研究需要,使用R语言对文本进行了主题发现,下面对具体过程进行记录。

本实验中主要对从SCI引文数据库中关于bigdata的索引记录进行分析,文件名为download_2.txt 目录为c:\\data\\,具体代码为:

#文件路径

textfile<-"C:\\data\\download_1.txt"

#按行读取该文本到变量bigdata

bigdata<-readLines(textfile)

#使用正则表达式对记录中的摘要进行提取

doc<-grep("^AB.*?",bigdata)

#删除文件开头的AB 字符,得到摘要列表

doc<-sub("^AB ","",doc)

将摘要信息读取doc变量后,接下来就需要使用tm包对文本进行处理了.

#加载tm包

library(tm)

#建立语料库

doc.vec<-VectorSource(doc)

doc.corpus<-Corpus(doc.vec)

#进行预处理

doc.corpus<-tm_map(doc.corpus,tolower)

doc.corpus<-tm_map(doc.corpus,removePunctuation)

doc.corpus<-tm_map(doc.corpus,removeNumbers)

doc.corpus<-tm_map(doc.corpus,removeWords, stopwords("english"))

#加载SnowballC包

library(SnowballC)

#继续进行预处理

doc.corpus <- tm_map(doc.corpus, stemDocument)

doc.corpus <- tm_map(doc.corpus, stripWhitespace)

#建立TermDocumentMatrix

TDM <- TermDocumentMatrix(doc.corpus)

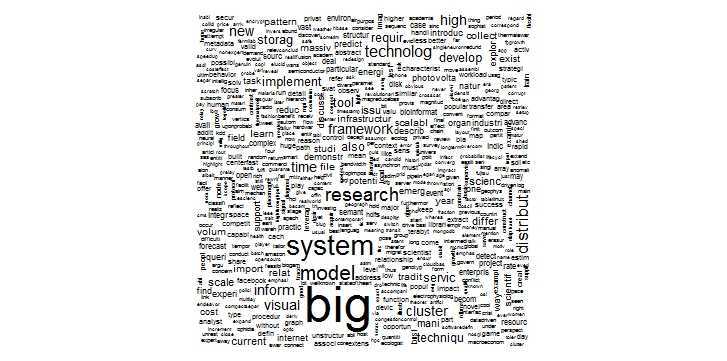

library(wordcloud) m <- as.matrix(TDM) v <- sort(rowSums(m),decreasing=TRUE) d <- data.frame(word = names(v),freq=v) wordcloud(d$word,d$freq,c(8,.3),2)

经过上述步骤后,可以得到该语料的词云图如下

未完待续......

标签:blog http io ar 使用 sp 文件 数据 on

原文地址:http://www.cnblogs.com/deeplearningfans/p/4114892.html