标签:

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词。其基本实现原理有三点:

安装(Linux环境)

下载工具包,解压后进入目录下,运行:python setup.py install

模式

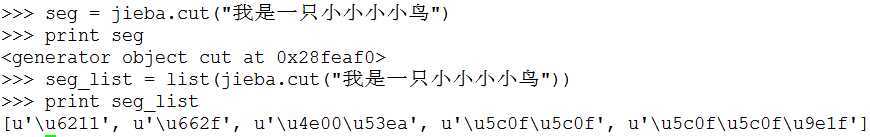

接口

实例

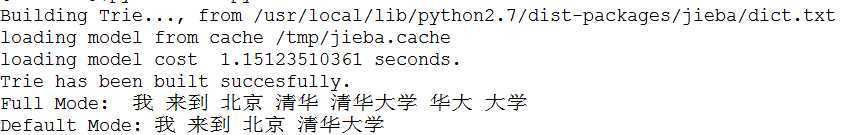

#! -*- coding:utf-8 -*- import jieba seg_list = jieba.cut("我来到北京清华大学", cut_all = True) print "Full Mode:", ‘ ‘.join(seg_list) seg_list = jieba.cut("我来到北京清华大学") print "Default Mode:", ‘ ‘.join(seg_list)

结果

实现原理

1. Trie树:参考http://www.cnblogs.com/kaituorensheng/p/3602155.html

标签:

原文地址:http://www.cnblogs.com/kaituorensheng/p/3597271.html