标签:

synchronized不仅仅只有原子性,还具有内存可见性。我们不仅希望能够避免一个线程修改其他线程正在使用的对象的状态,而且希望确保当一个线程修改了对象的状态后,其他线程能够真正看到改变。你可以使用显示的同步或者利用内置于类库中的同步机制,来保证对象的安全性。

在多线程环境下,下面程序中当ready为true时,number不一定为42,这是因为它没有使用恰当的同步机制,没有保证主线程写入ready和number的值对读线程是可见的。

public class NoVisibility {

private static boolean ready;

private static int number;

private static class ReaderThread extends Thread {

public void run() {

while (!ready)

Thread.yield();

//这里可能输出0,也可能永远都不会输出

System.out.println(number);

}

}

public static void main(String[] args) {

new ReaderThread().start();

number = 42;

ready = true;

}

}

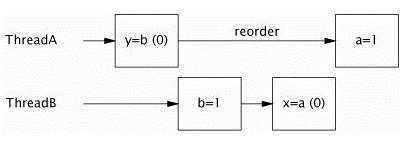

这里可能会产生两个问题,一是程序可能一直保持循环,因为对于读线程来说,ready的值可能永远不可见。二是输入的number为0,这是因为重排序引起的,在写线程将ready与number从工作内存中写回到主内存中时,在没有同步的机制下,先写ready还是先写number这是不确定的,也就是说将它们写回到主内存时的顺序可能与程序逻辑顺序恰好相反,这是因为在单个线程下,只要重排序不会对结果产生影响,这是允许的。

在没有使用同步的情况下,编译器、运行器、运行时安排顺序可能完全出乎意料,在没有进行适当同步的多线程程序中,尝试推断那些“必然”发生在内存中的动作时,你总是会判断错误。

上面NoVisibility程序在多线程环境下还可能读取到过期数据,比如当ready为true时,写线程已将number域的值置为了42,但在它还未来得及将这个新值从工作内存中写回到主内存前,读线程就已将ready从主内存中读取出来了,这时的值还是为初始的默认值0,这个值显然是一个已过期了的值,因为number现在真真的值应该为42,而不是0。

在没有同步的情况下读取数据类似于数据库中使用READ_UNCOMMITTED(未提交读)隔离级别,这时你更愿意用准确性来交换性能。

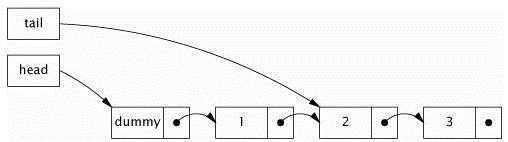

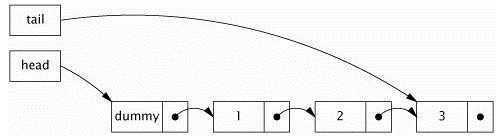

在NoVisibility中,过期数据可能导致它打印错误数值,或者程序无法终止。过期数据可能会使对象引用中的数据更加复杂,比如链指针在链表中的实现。过期数据还可能引发严重且混乱的错误,比如意外的异常,脏的数据结构,错误的计算和无限的循环。

下面的程序更对过期数据尤为敏感:如果一个线程调用了set,但还未来得及将这个新值写回到主内存中时,而另一个线程此时正在调用get,它就可能看不到更新的数据了:

@NotThreadSafe

public class MutableInteger {

private int value;

public int get() { return value; }

public void set(int value) { this.value = value; }

}

我们可以将set与get同步,使之成为线程安全的。注,仅仅同步某个方法是没有用的。

当一个线程在没有同步的情况下读取变量,它可能会得到一个过期值。但是至少它可以看到某个线程在那里设定的一个完整而真实数值,而不是一个凭空而来的值。这样的安全保证被称为是最低限的安全性。

最低限的安全性应用于所有变量,除了一个例外:没有声明为volatile的64位数值变量double和long。Java内存模型规定获取(read动作)和存储(write动作)操作都是原子性的,但是对于非volatile的long和double变量,JVM允许将64位的读回写划分为两个32的操作。如果读和写发生在不同的线程,这种情况读取一个非volatile类型long就可能会现得到一个线程写的值的高32位和另一个线程写的值的低32位,最终这个long变量的值由这两个线程高低位组合而成的值。因此,即使你并不关心过期数据,但仅仅在多线程程序中使用共享的、可变的long和double变量也可能是不安全的,除非将它们声明为volatile类型,或者锁保护起来。

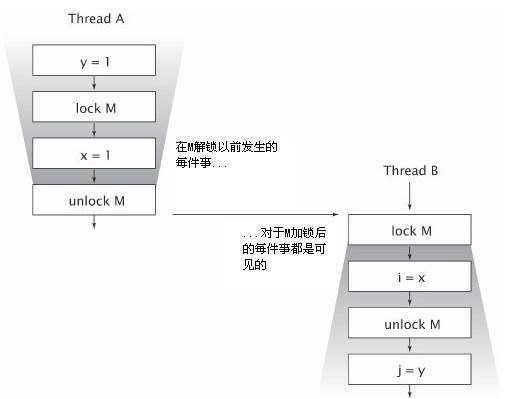

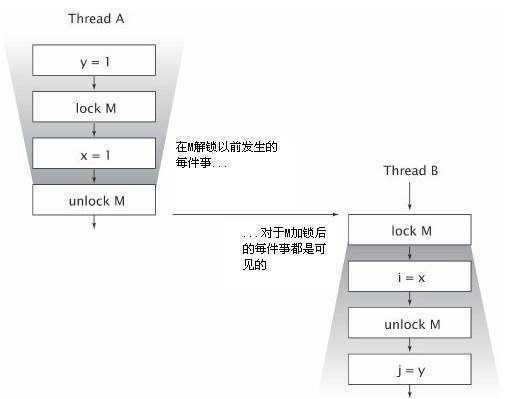

内置锁可以用来确保一个线程以某种可预见的方法看到另一个线程的影响,像下图一样。当B执行到与A相同的锁监视的同步块时,A在同步块之中所做的每件事,对B都是可见的,如果没有同步,就没有这样的保证。

锁不仅仅是关于同步与互斥的,也是关于内存可见的。为了保证所有线程都能够看到共享的、可变变的最新值,读取和写入线程必须使用公共锁进行同步。

volatile是一种弱同步的形式,它确保对一个变量的更新后对其他线程是可见的。当一个域声明为volatile类型后,编译器与运行时会监视这个变量:它是共享的,而且对它的操作不会与其他的内存操作一起被重排序。volatile变量不会缓存在寄存器或者缓存其他处理器隐藏的地方,所以,读一个volatile类型的变量时,总会返回由某一线程所写入的最新值。

读取volatile变量的操作不会加锁,也就不会引起执行线程的阻塞,这使得volatile变量相对于sychronized而言,只是轻量级的同步机制

volatile变量对可见性的影响所产生的价值远远高于变量本身。线程A向volatile变量写入值,随后线程B读取该变量,所有A执行写操作前可见的变量的值,在B读取了这个volatile变量后,对B也是可见的(与解锁前所有动作对后继加锁后的动作可见是一样的)。所以从内存可见性的角度来看,写入volatile变量就像退出同步块,读取volatile变量就像进入同步块。但是我们并不推荐过度依赖volatile变量所提供的可见性。因为依赖volatile变量来控制状态可见性的代码,比使用锁的代码更脆弱,更难以理解。

调试提示:对于服务器应用程序,确保无论是在开发阶段还是测试阶段,启动JVM时都使用-server命令行选项。server模式的JVM会比client模式的JVM执行更多的优化,比如把没有在循环体中修改的变量提升到循环体外部;在开发环境(client模式的JVM)中可以工作的代码,可能会在部署环境(server模式的JVM)中失败。举个例子:比如下面程序中,如果我们忘记把asleep变量声明为volatile,server模式的JVM会将检查asleep的工作提升到循环外部(将它变为一个无限循环),但是client模式的JVM不会这样做。开发环境中的无限循环的开锁远小于将它置于生产环境中所产生的开销。

//实例:数绵羊。

//一定要加上volatile,否则其他线程更新后可能不可见volatile boolean asleep;...

while (!asleep)

countSomeSheep();

volatile变量固然方便,但也存在限制,它们通常被当作标识完成、中断、状态的标记使用,比如上面程序中的asleep变量。尽管volatile也可以用来标示其他类型的状态信息,但是决定这样做之前请格外小心,如volatile的语义不足以使用自增操作(i++)原子化。

加锁可以保证可见性与原子性;volatile变量只能保证可见性。

只有满足了下面所有的标准后,你才能使用volatile变量:

1、 写入变量时并不依赖变量的当前值;或者能够能够确保只有单一线程修改变量的值;

2、 变量不需要与其他的状态变量共同参与不变约束;

3、 而且,访问变量时,没有其他的原因需要加锁。

发布一个对象的意思是使它能够被当前范围之外的代码所使用。比如将一个引用存储到其他代码可以访问的地方、在一个非私有的方法中返回这个引用、也可以把它传递到共他类的方法中。在很多情况下,我们需要确保对象及它们的内部状态不被暴露,在另外一些情况下,为了正当的使用目的,我们又的确希望发布一个对象,这时为了线程安全可能需要同步。如果变量发布了内部状态,就可能危及到封装性,并使用程序难以维持稳定;如果发布对象时,它还没有完成构造,同样危及线程安全。一个对象在尚未准备地时就将它发布,这种情况称作逸出。下面看看一个对象是如何逸出的。

最常见的发布对象的方式是将对象的引用存储到公共静态域,任何类和线程都能看到这个域。initialize方法实例化一个新的HashSet实例,并通过将它存储到knownSecrets引用,从而发布了这个实例:

//发布对象

public static Set<Secret> knownSecrets;

public void initialize() {

knownSecrets = new HashSet<Secret>();

}

发布一个对象还会间接地发布其他对象。如果你将一个Secret对象加入集合knownSecrets中,你就已经发布了这个对象,因为任何代码都可以遍历并获得新Secret对象的引用。类似地,从非私有方法中返回引用,也能发布返回的对象,下面发布了包含洲名的数组,而这个数组本应是私有的:

//内部可变的数据逸出(不要这样做)

class UnsafeStates {

private String[] states = new String[] {

"AK", "AL" ...

};

public String[] getStates() { return states; }

}

以这种方式发布states会出问题,这样会允许内部可变的数据逸出,请不要这样做。因为任何一个调用者都能修改它的内容。在这个例子中,数组states已经逸出了它所属的范围,这个本就是私有的数据,事实上已经变成公有的了。

发布一个对象,同样也发布了该对象所有非私有域所引用的对象。

最后一种发布对象和它的内部状态的机制是发布一个内部类实例。

//隐式地允许this引用逸出,请不要这样做:

public class ThisEscape {

public ThisEscape(EventSource source) {

source.registerListener(

new EventListener() {//会过早地暴露this

public void onEvent(Event e) {

doSomething(e);

}

});

}

}

对象只有通过构造函数返回后,才处于稳定状态。从构造函数内部发布的对象,只是一个未完成构造的对象。甚至即使是在构造函数的最后一行发布的引用也是如此。如果this引用在构造器中逸出,这样的对象被认为是“没有正确构建的”,所以不要让this引用在构造期间逸出。

一个导致this引用在构造期间逸出的常见错误,是在构造函数中创建局部、匿名线程并启动它或者启动一个线程并显示地将this传递过去,这都是不安全的,因为新的线程在所属对象完成构造前就能看见了。在构造器中创建线程并没有错,但是最好不要立即启动它,取而代之的是,发布一个start或initialize方法来启动对象拥有的线程。

另外,构造器中调用一个覆盖的实例方法同样会导致this引用在构造期间逸出。

如果想要在构造器中注册监听器或启动线程,你可以使用一个私有的构造函数和一个公有的工厂方法,这样避免了不正确的问题。

下面是使用工厂方法防止this引用在构造期间逸出:

public class SafeListener {

private final EventListener listener;

private SafeListener() {//私有构造器

listener = new EventListener() {

public void onEvent(Event e) {

doSomething(e);

}

};

}

//使用静态 工厂方法安全发布对象

public static SafeListener newInstance(EventSource source) {

SafeListener safe = new SafeListener();//等构造完后再注册

source.registerListener(safe.listener);

return safe;//安全发布对象

}

}

局部变量是线程安全的,只要我们不要将它们逸出。

使用ThreadLocal确保线程的封闭性。假设你正在将一个单线程的应用迁移到多线环境中,你可以将共享的全局变量都转换为ThreadLocal类型,这样可以确保线程安全。前提是全局共享的语义是允许这样的,如果将应用级的缓存变成一个堆线程缓冲,它将毫无价值。

不可变性也可以满足同步的需求。

创建后状态不能被修改的对象叫做不可变对象。不可变对象天生就是线程安全。它们常量域是在构造函数中创建的。既然它们的状态无法被修改,这些常量永远不会变。所以不可变对象永远是线程安全的。

不可变性并不简单地等于将对象中的所有域都声明为final类型,所有域都是final类型的对象仍然可能是可变的,因为final域可以获得一个到可变对象的引用。只有满足如下状态,一个对象才是不可变的:

1、 它的状态不能在创建后再被修改;

2、 所有域都是final类型;并且,

3、 它被正确创建(创建期间没有发生this引用逸出)。

注,从技术上讲,不可变对象的域并不是全部声明为final类型,这样的情况是可能存在的,String就是这种类。设计这种类依赖于对象良性(恶意除外)数据竞争的精准分析,还需要对Java内存模型有深入的理解,但请不要自己这么做。(1.5版本中除了hash域外都已经是final类型的,而在这之前不是的,所以1.5版本中加强了不可变的语义。)

在不可变对象的内部,同样可以使用可变性对象来管理它们的状态,如下面代码,虽然域stooges是可变的,但它满足了以上三点,所以是一个不可变对象:

@Immutable//不可变对象可以基于可变对象来实现

public final class ThreeStooges {

private final Set<String> stooges = new HashSet<String>();

public ThreeStooges() {

stooges.add("Moe");

}

public boolean isStooge(String name) {

return stooges.contains(name);

}

}

final域不能修改的(尽管如果final域指向的对象是不可变的,这个对象仍然可被修改),然而它在Java内存模式中还有着特殊语义。final域使得确保被始化安全性成为可能,初始化安全性让不可变性对象不需要同步就能自由地被访问和共享。

正如“将所有的域声明为私有的,除非它们需要更高的可见性”一样“将所有的域声明为final型,除非它们是可变的”,也是一条良好的实践。

尽管原子引用自身是线程安全的,不过UnsafeCachingFactorizer中存在竞争条件,在A 与 B,C 与 D之间都有可能切换到其他线程,从而造成错误的结果。

//没有正确原子化的Servlet试图缓存它的最新结果。

@NotThreadSafe

public class UnsafeCachingFactorizer implements Servlet {

private final AtomicReference<BigInteger> lastNumber

= new AtomicReference<BigInteger>();//缓存最后一次客户请求因式分解的数

private final AtomicReference<BigInteger[]> lastFactors

= new AtomicReference<BigInteger[]>();//缓存最后一次客户请求因式分解的结果

public void service(ServletRequest req, ServletResponse resp) {

BigInteger i = extractFromRequest(req);

if (i.equals(lastNumber.get()))//A

encodeIntoResponse(resp, lastFactors.get() );//B

else {

BigInteger[] factors = factor(i);

lastNumber.set(i);//C

lastFactors.set(factors);//D

encodeIntoResponse(resp, factors);

}

}

}

如果上面的A与B操作、以及C与D操作如果是原子性的,那么将不会出现线程安全性问题。如果为这两组操作创建一个不可变的类,即使在不使用同步的情况也能解决安全共享问题。下面就为UnsafeCachingFactorizer创建一个OneValueCache类,对以上操作进行了封装,它是一个不可变对象,进(构造时传进的参数)出(使用时)都对状态进行了拷贝。因为BigInteger是不可变的,所以直接使用了Arrays.copyOf来进行拷贝了,如果状态所指引的对象不是不可变对象时,就要不能使用这项技术了,因为外界可以对这些状态所指引的对象进行修改,如果这样只能使用new或深度克隆技术来进行拷贝了。

@Immutable

class OneValueCache {

private final BigInteger lastNumber;

private final BigInteger[] lastFactors;

public OneValueCache(BigInteger i,

BigInteger[] factors) {

lastNumber = i;

lastFactors = Arrays.copyOf(factors, factors.length);

}

public BigInteger[] getFactors(BigInteger i) {

if (lastNumber == null || !lastNumber.equals(i))

return null;

else

return Arrays.copyOf(lastFactors, lastFactors.length);

}

}

VolatileCachedFactorizer利用OneValueCache存储缓存的数字及因数。与cache域相关的操作的线程不会相互干扰,因为OneValueCache是不可变的,并且利用volatile引用确保及线程之间及时的可见,这两个前提(不可变、使用volatile发布)保证了VolatileCachedFactorizer在没有显式地使用锁,但这个类仍然是线程安全的。

@ThreadSafe

public class VolatileCachedFactorizer implements Servlet {

private volatile OneValueCache cache =

new OneValueCache(null, null);//使用volatile安全发布

public void service(ServletRequest req, ServletResponse resp) {

BigInteger i = extractFromRequest(req);

BigInteger[] factors = cache.getFactors(i);

if (factors == null) {

factors = factor(i);

//由于cache为volatile,所以最新值立即能让其它线程可见

cache = new OneValueCache(i, factors);

}

encodeIntoResponse(resp, factors);

}

}

下面程序中简单地将对象的引用存储到public域中,这不足以安全地发布它:

// 不安全的发布:在没有适当的同步情况下就发布对象

public Holder holder;

public void initialize() {

holder = new Holder(42);

}

public class Holder {

private int n;

public Holder(int n) { this.n = n; }

public void assertSanity() {

if (n != n)//在不正确的发布中,是很有可能出现不等

throw new AssertionError("This statement is false.");

}

}

上面程序的问题是由于对象的可见性问题引起的(最根本的原因是由于JVM运行时重排序引起的),发布的对象可能还处于构造期间,所以是不稳定的。因为没有同步来确保Holder对其他线程可见,所以我们称Holder是“非正确发布”。

由于上面 n != n 会从主存中两次读取,这有可能从这两次读操作间切换到其他线程,这就有可能出 n!=n奇怪的问题。

Java内存模型为共享不可变对象提供了特殊的初始化安全性的保证,即对象在完全初始化之后才能被外界引用,所以只要是不可变对象,一旦构建完成,就可以安全地发布了。

即使发布对象引用时没有使用同步,不可变对象仍然可以被安全地访问(注,只能保证一旦看到的对象就是完整的,在没有使用同步的情况下是不能保证对象引用的可见性,所以不可变对象只能保证初始化完后的就处于稳定状态)。为了获得这种初始化安全性的保证上,应该满足所有不可变性的条件:不可修改的状态、所有域都是final类型的以及正确的构造。(如果上面的Holder是不可变的,那么即使Holder没有正确的发布,assertSanity也不会抛出AssertionError。)

不可变对象可以在没有额外同步的情况下,安全地用于任意线程;甚至发布它们时也不需要同步。

这个保证还会延伸到一个正确创建的对象中所有final类型域的值。final域可以在没有额外的同步情况下被安全地访问(因为只要构造器一旦调用完毕,则final域的也会随之初始化完并可见),然而,如果final域指向可变对象,那么访问这些对象的状态时仍然需要同步的。

如果一个对象不是不可变的,它就必须要被安全的发布,通常发布线程与消费线程都必须同步。我们要确保消费线程能够看到处于发布当时的对象状态。

为了安全地发布一个可变对象,对象的引用以及对象的状态必须同时对其他线程可见。一个正确创建的对象可以通过下列条件安全地发布:

1、 通过静态初始化器初始化对象引用;

2、 将它的引用存储到volatile域或AtomicReference;

3、 将它的引用存储到正确创建的对象的Final域中;

4、 或者将它的引用存储到由锁正确保护的域中,即将对它的访问置于同步器中。

线程安全中的容器提供了线程安全保证(即变向地将对象置于了同步器中进行访问),正是遵守了上述最后一条要求。

比如类库中的安全性容器、Future、Exchanger同样创建了安全发布机制

通常,以最简单和最安全的方式发布一个被静态创建的对象,就是使用静态初始化器:

public static Holder holder = new Holder(42);

静态初始化器由JVM在类的初始阶段执行,由于JVM内在的同步,该机制确保了以这种方式初始化的对象可以被安全地发布。

如果对象在创建后被修改,那么安全发布仅仅可以保证“发布当时”状态的可见性。不仅仅在发布对象时需要同步,而且在对象发布后修改了对象状态又要让其他线程可见,则也需要对每次状态的访问进行同步。为了安全地共享可变对象,可变对象必须被安全发布,同时对状态的访问需要同步化。

如果某个类是可变的,但是它的状态不会在发布后被修改,这样的对象称为高效不可变对象。

用高效不可变对象可以简化开发,并且由于减少了同步的使用,还会提高性能。

任何线程都可以在没有额外的同步下安全地使用一个安全发布的高效不可变对象。

比如,Date自身是可变的(这也许是类库设计的一个错误),但是如果你把它当作不可变对象来使用就可以忽略锁。否则,每当Date被跨线程共享时,都要用锁确保安全。假设你正在维护一个Map,它存储了每位用户的最近登录时间:

public Map<String, Date> lastLogin =

Collections.synchronizedMap(new HashMap<String, Date>());

如果Date值在转入Map中后就不会改变,那么,synchronizedMap中同步的实现就足以将Date安全地发布,并且访问这些Date值时就不再需要额外的同步。

发布对象的必要条件依赖于对象的可变性:

1、 不可变对象可以通过任意机制发布(不需要同步);

2、 高效不可变对象(指对象本身是可变的,但只要发布后状态不再做修改)必须要安全发布;

3、 可变对象必须要安全发布,同时必须是线程安全或者是被锁保护的;

当你获得一个对象的引用时,你要知道用它来做什么,是否需要在使用它前先获得一个锁?是否允许修改它的状态,还是仅仅可读?很多并发错误都是源自没有理解共享对象的这些“预设约束”。当你发布一个类后,应该将如何访问它们写入文档。

在并发程序中,使用和共享对象的一些最有效的策略是:

线程受限(Thread-confined):线程受限的对象只能被一个线程排它使用与独占,即不可共享对象,如方法中的局部变量就是。

只读共享(Shared read-only):一个只读共享的对象能够被并发地被多个线程在没有额外同步的情况访问,但不能被任何线程修改。共享只对读对象包括不可变和高效不可变对象。

线程安全共享(Shared thread-safe):一个线程安全的对象在内部已经进行了同步,所以其他线程无须额外同步,就可以通过它提供的公共接口无需在同步的情况下访问。

被守护的(Guarded):一个被守护的对象只能通过特定的锁来访问。被守护的对象包括那些被其他线程安全对象封装的对象和已知被特定锁保护起来的已发布的对象。

有时一个线程安全类支持我们需要的全部操作,但是更多时候,一个类只支持我们需要的大部分操作,这时我们需要在不破坏其线程安全性的前提下,向它添加一个新的操作。

现在假设我们需要一个线程安全的List,它需要提供给我们一个原子的“缺少即加入(put-if-absent)”操作,该如何做?

第一种方式:扩展Vecotr

@ThreadSafe

public class BetterVector<E> extends Vector<E> {

public synchronized boolean putIfAbsent(E x) {

boolean absent = !contains(x);

if (absent)

add(x);

return absent;

}

}

第二种方式:客户端自己加锁

@ThreadSafe

public class ListHelper<E> {

public List<E> list =

Collections.synchronizedList(new ArrayList<E>());

...

public boolean putIfAbsent(E x) {

synchronized (list) {

boolean absent = !list.contains(x);

if (absent)

list.add(x);

return absent;

}

}

}

第三种方式,也是最好的方式,组合加实现:

ImprovedList通过将操作委托给底层的List实例,并实现了List接口,同时还添加了一个原子操作putIfAbsent。(这种方式就像Collections.synchronizedList和其他容器封装那样)

@ThreadSafe

public class ImprovedList<T> implements List<T> {//实现

private final List<T> list;//组合

public ImprovedList(List<T> list) { this.list = list; }

public synchronized boolean putIfAbsent(T x) {

boolean contains = list.contains(x);

if (contains)

list.add(x);

return !contains;

}

public synchronized void clear() { list.clear(); }

// ... 类似地将其他方法也委托给List相应的方法

}

以下是第16章 Java内存模式内容

Java语言规范规定了JVM要维护内部线程类似顺序化语意:只要程序的最终结果等同于它在严格的顺序化环境中执行的结果,那么对指令的重新排序的行为是允许的。

public class PossibleReordering {

static int x = 0, y = 0;

static int a = 0, b = 0;

public static void main(String[] args)

throws InterruptedException {

Thread one = new Thread(new Runnable() {

public void run() {

a = 1;

x = b;

}

});

Thread other = new Thread(new Runnable() {

public void run() {

b = 1;

y = a;

}

});

one.start(); other.start();

one.join(); other.join();

System.out.println("( "+ x + "," + y + ")");

}

}

图解上面程序是如何输出 (0, 0)的:

Java存储模型定义了一系列的动作(actions),包括变量的读和写、监视器加锁和释放锁、线程的启动和连接(join).

要想保证执行动作B的线程看到动作A的结果(无论A和B是否发生在同一个线程中),A和B之间就必须满足happens-before关系。如果两个操作之间并未依照happens-before关系排序,JVM可以对它们随意地重排序。

当一个变量被多个线程读取,且至少被一个线程写入时,如果读写操作并未依照happens-before排序,就会产生数据竞争。一个正确同步的程序是没有数据竞争的程序,正确同步的程序会表现出顺序的一致性。

happens-before的法则包括:

1、 程序次序法则:线程中的每个动作A都happens-before于该线程中每个动作B,其中,在程序中,所有动作B都出现在动作A之后。

2、 监视器锁法则:对一个监视器锁的解锁happens-before于每个后续对同上监视器锁的加锁。

3、 volatile变量法则:对volatile域的写入操作happens-before于每一个后续对同一域的读操作。

4、 线程启动法则:在A线程中调用B线程的start方法,则发生在A线程中的所有动作happens-before于B线程中的每个动作。

5、 线程终结法则:线程中的任何动作都happens-before于能检测到这个线程已经终结(从Thread.join调用中成功返回,或Thread.isAlive返回false)的任何线程。

6、 中断法则:一个线程调用另一个线程interrupt happens-before于被中断线程发现中断(通过InterruptedException,或者调用isInterrupted和interrupted来发现中断)。

7、 终结法则:一个对象的构造函数的结束happens-before 于这个对象的finalizer的开始。

8、 传递性:如果A happens-before 于B,且B happens-before 于 C,则 A happens-before 于 C。

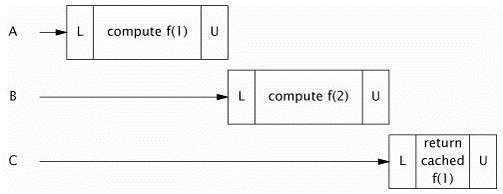

下图演示了两个线程同步使用一个公共锁时,它们之间的happens-before关系。线程AB内部所有动作都是依照了“程序次序法则”进行排序的。因为A释放了锁M,B随后获取了锁M,A中所有释放锁之前的动作,也就因此排到了B中请求到锁后动作的前面。如果两个线程是在不同的锁上进行同步,则这两个线程的动作之间就不存在happens-before关系。

在缺少happens-before关系的情况下,存在重排序的可能性。这就解释了为什么如果在没有充分同步的情况下就发布一个对象,会导致另外的线程看到一个部分创建对象(即构建不完整对象)。

如果你不能保证发布共享引用happens-before于另外的线程读取这个共享引用,那么读取这个共享对象引用与初始化共享对象状态域可以被重排序(这里的重排序关键在于消费线程读取共享对象的引用动作与将构造期修改的状态值写回到主存中的动作是无序的,更准确一点是,按照正规则的语义是当构造器调用完毕后对象状态对象外界是可见的,但在未同步的情况下不能做到在构造函数结束前将状态域值写回到主存中去)(从使用该对象的线程的角度看),在这种情况下,另一个线程就会读到一个还未初始化完整的对象。

错误的惰性初始化会导致不正确的发布:

//不安全的惰性初始化

public class UnsafeLazyInitialization {

private static Resource resource;

public static Resource getInstance() {

if (resource == null)

resource = new Resource(); // 不安全的发布

return resource;

}

}

上面的程序有二个问题:第一个是可能创建出多个Resource;第二个问题是其他线程看到一个构建不完整的对象。

前面描述的安全发布的常用模式,可以确保发布的对象对于其他线程是可见的,因为它们保证发布对象happens-before于消费线程加载已发布对象的引用。

借助于类库中现在的同步容器、使用锁保护共享变量、或都使用共享的volatile类型变量,都可以保证对该变量的读取和写入是按照happens-before排序的。

happens-before事实上可以比安全发布承诺更强的可见性与排序性。如果X对象从A线程到B线程是安全发布的,安全发布可以保证X本身的状态是可见的,但是不包括A所依赖的其他对象(即A中还包含了其他对象,不只是基本类型变量)的状态;但是如果X对象是在同步的情况下由线程A生产,然后由线程B消费,B不仅仅能看到A中所有直接状态域,而且还能看见A所依赖的甚至是更深一层的状态域所做的更改。

使用静态域来初始化,会有的额外的线程安全性保证。静态初始化是JVM完成的,发生在类的初始化阶段(加载、链接、类的初始化),即类被加载后到类被任意线程使用之前。JVM会在初始化期间获得一个锁,这个锁每个线程都至少会获取一次,来确保类是否已被加载;这个锁也保证了静态初始化期间,内存写入的结果自动地对照所有线程都是可见的。所以静态初始化的对象,无论是构造期间还是被引用的时候,都不需要显试地进行同步。然而,这仅仅适用于构造当时的状态——如果对象是可变的,为了保证后续修改的可见性,仍然需要同步。

@ThreadSafe//主动初始化

public class EagerInitialization {

private static Resource resource = new Resource();

public static Resource getResource() { return resource; }

}

主动初始化,避免了懒汉式每次调用getInstance时引发的同步开销,如下面:

@ThreadSafe

public class SafeLazyInitialization {

private static Resource resource;

public synchronized static Resource getInstance() {

if (resource == null)

resource = new Resource();

return resource;

}

}

将主动初始(饿汉式)技术与JVM的惰性类加载相结合,创建出一种惰性初始化技术:

@ThreadSafe

public class ResourceFactory {

private static class ResourceHolder {

public static Resource resource = new Resource();

}

public static Resource getResource() {

return ResourceHolder.resource ;

}

}

JVM将ResourceHolder的初始化被延迟到真正使用它的时刻了。又因为Resource是在静态初始阶段进行初始化的,所以不再需要额外的同步。线程第一次调用getResource,才会引起ResourceHolder的加载和初始化,这个时候,正是在静态初始阶段Resource完成初始化发生的时间。

保证了初始化的安全,就可以让正确创建的不可变对象在没有同步的情况下,可以被安全地跨线程地共享,而不管它们是如何发布的——甚至在发布时存在数据竞争。(这就是说如果Resource 是不可变的,上面的UnsafeLazyInitialization事实上也可以是安全的)

假如没有初始化安全性,就会发生这样的事情:像String这样不可变对象,没有在发布或消费线程中进行同步,它们的值可能表现出变化的性为。(为了确保初始化的安全,所以在1.5中String中的域都已修改成了final了)

初始化安全可以保证,对于正确创建的对象,无论它是如何发布的,所有线程都将看到构造函数设置的final域的值。更进一步,一个正确创建的对象中,任何可以通过其final域访问得到的变量(比如一个final数组中的元素,或者一个final域引用的HashMap里面的内容),也可以保证对其他线程都是可见的。

对于含有final域的对象,安全初始化禁止了在构造器中将final域写回到主存动作与获取引用动作间的重排序,会按照程序的语义——先构造,再引用的,的顺序先去构造完对象,然后再获取该对象的引用,而final域又是在构造器中初始化的,而JVM内存模型又对final作出了明确的可见性规定——当构造完后final域对其他线程一定是可见的,所以final写回主存的动作会happens-before于获取对象的引用。

安全初始化只能保证那些final域及它可以访问得到的其他域,在构造函数完成时才是可见的。对于那些非final,或者即使是final域但创建完成后会修改的,必须使用同步来确保可见性。

平台类库中包含了一个并发构建块的丰富集合,如线程安全的容器与同步工具。

分两部分,一是JDK1.0的Vector与Hashtable,另一个是JDK1.2才被加入的同步包装类Collections.synchronizedXxx工厂方法创建的。Collections.synchronizedXxx工厂方法构造出的容器返回的List与Set的iterator()与listIterator()(List集合)没有使用同步。

同步容器都是线程安全的,但是对于复合操作,有可能客户端需要使用额外的加锁进行保护。如迭代、putIfAbsent(如果不存在则加入)等,这有点像事务要做在Service层而不能做在Dao层一样的道理。

操作Vector(同步容器)的复合操作可能导致混乱的结果:

public static Object getLast(Vector list) {

int lastIndex = list.size() - 1;

return list.get(lastIndex);

}

在多线程的环境下可能会抛出ArrayIndexOutOfBoundsException,因为基他线程可能会在size()与get中修改Vector,但单线程下是不会有问题的。

使用客户端加锁,对Vector进行复合操作:

public static Object getLast(Vector list) {

synchronized (list) {

int lastIndex = list.size() - 1;

return list.get(lastIndex);

}

}

多线程环境下迭代过程中也可能抛出ArrayIndexOutOfBoundsException:

for (int i = 0; i < vector.size(); i++)

doSomething(vector.get(i));

迭代过程中可能抛出异常,但并不意味着Vector就不是线程安全。Vector的状态仍然是有效的,事实上异常恰好使它保持规范的一致性。然而,在正常或迭代读过程中抛出异常的确不是人们所期望的。

造成迭代不可靠的问题同样可以通过在客户端加锁来完成,这要增加一些开销,像下那样,通过在迭代期间持有Vector的锁,我们防止其他线程在迭代期间修改Vector,这样完全阻止了其他线程在这期间访问它,如果集合很大或者对每个元素执行的任务耗时比较长,这会削弱并发性

synchronized (vector) {

for (int i = 0; i < vector.size(); i++)

doSomething(vector.get(i));//还要持有另一个锁,这是一个产生死锁风险的因素

}

尽管上面讨论的Vector是“遗留”下来的容器类,这只是说明同步容器有这样的问题。其实,“现代”的容器类也并没有消除复合操作产生的问题,比如迭代复合操作,当其他线程并发修改容器时,使用迭代器仍然避免不了在使用的地方加锁,在设计同步容器返回迭代器时,并没有使用同步(注,这里讲的是说返回的迭代器不是线程安全,而不是指返回迭代器的方法iterator() 没有使用同步,它本身就是经过同步了的。),因为他们是“及时失败”——只要有其他线程修改容器结果,立马就会抛出未检查性异常ConcurrentModificationException。

注:ConcurrentModificationException也可能出现在单线程的代码中,如果对象不是调用Iterator.remove,而是直接从容器中删除就会出现这种情况。

1.5中的for-each循环语法对容器进行迭代时,也是隐式地用到了Iterator,所以在多线程下也需要同步:

List<Widget> widgetList = Collections.synchronizedList(new ArrayList<Widget>());

...

// May throw ConcurrentModificationException

for (Widget w : widgetList)

doSomething(w);

迭代期间,对容器加锁的一个替代办法就是复制容器。注,复制期间也需要加锁。复制容器会有明显的开销;这样做是好是坏取决于许多因素,包括容器的大小、每一个元素的工作量等。

在一个可能发生迭代的共享容器中,各处都需要锁,这是一个棘手的问题,因为迭代器有时是隐藏的,就像下面代码一样,容器的toString方法的实现是通过迭代容器中的每个元素。如果将HashSet包装为synchronizedSet就不会出现ConcurrentModificationException异常了。

public class HiddenIterator {

private final Set<Integer> set = new HashSet<Integer>();

public synchronized void add(Integer i) { set.add(i); }

public void addTenThings() {

Random r = new Random();

for (int i = 0; i < 10; i++)

add(r.nextInt());

System.out.println("DEBUG: added ten elements to " + set);//这里会隐式地使用迭代

}

}

容器的hashCode和equals方法也会间接地调用迭代,比如当容器本身作为一个元素时,或者是作为另一个容器的key时。类似地,containsAll、removeAll、retainAll方法,以及把容器做为参数的构造函数,都会对容器进行隐式地迭代,所以都会抛出ConcurrentModificationException异常。

1.5提供了几个并发的容器类来改进同步容器。同步容器通过对容器的进行串行访问,从而实现了它们的线程安全。这样做虽然是绝对的安全,但代价是削弱了并发性,当多个线程共同竞争容器级的锁时,吞吐量会降低。

并发容器是为多线程并发访问而设计的。1.5添加了ConcurrentHashMap,来替代同步的哈希Map实现;当大多数的操作是读操作时(因为如果有很多写操作会引起内部对原来集合进行复制,从而带来开销),CopyOnWriteArrayList是List相应的同步实现,同样CopyOnWriteArraySet是Set相应的同步实现(内部是以CopyOnWriteArrayList来实现的)。并且在ConcurrentMap接口还加入了对常见复合操作的支持,如“缺少即加入 put-if-absent”、替换和条件删除。

用并发容器替换同步容器,这种作法以很小的风险带来了可扩展性显著的提高。

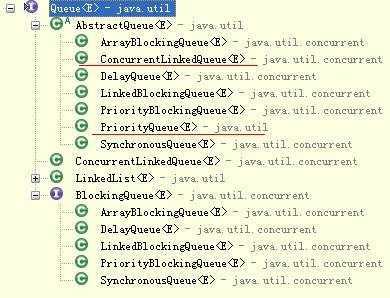

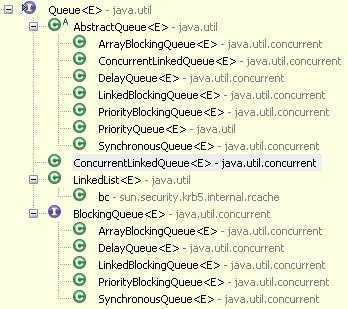

1.5同时增加了两个新的容器类型:Queue和BlockingQueue(Queue接口继承了Collection接口)。有几种实现,一个传统意义上(入队与出队不会被阻塞,是相对阻塞队列来说的)的FIFO队列ConcurrentLinkedQueue,底层是基于链表结构;一个是有优先级顺序的队列PriorityQueue(注,它不支持非并发)。Queue的操作不会阻塞,如果队列是空,那么从队列中获取时返回null。尽管可以使用List来模拟Queue的类——事实上,LinkedList就已实现了Queue(如果我们只需要一个单纯的或者是传统意义上的队列时,我们应该使用LinkedList,如果我们需要在并发环境下,则使用ConcurrentLinkedQueue来代替它)——但我们还是需要Queue的类,因为如果忽略掉List的随机访问需求的话,使用Queue能得到高效的并发实现。

Queue接口:

|

element() |

|

|

boolean |

|

|

peek() |

|

|

poll() |

|

|

remove() |

BlockingQueue接口:

|

|

|

|

|

|

|

|

|

|

|

BlockingQueue扩展了Queue,增加了可阻塞的插入(put)和获取操作(take)。如果队列为空,则take阻塞;如果队列满(对于有限队列:LinkedBlockingQueue—可以不指定,不指定时容量为最大的Integer.MAX_VALUE、ArrayBlockingQueue构造时则一定要指定大小),put操作会阻塞直到有空间,而对于无界队列(PriorityBlockingQueue、DelayQueue),放入时不会被阻塞,直到OutOfMemoryError。阻塞队列在生产者——消费者设计中非常有用。

正如ConcurrentHashMap作为同步的哈希Map的一个替代,1.6加入了ConcurrentSkipListMap和ConcurrentSkipListSet,用来作为同步的SortedMap和SortedSet的并发替代品(用synchronizedMap包装的TreeMap或TreeSet)

同步容器类在每个操作的执行期间都持有一个锁。比如HashMap.get或者List.contains操作,再调用它们的过程中可能需要很长一段时间,并且在这段时间内,其他线程都不能访问这个容器。

ConcurrentHashMap和HashMap一样是一个哈希表,但是它使用完全不同的锁策略,可以提供更好的并发性和或伸缩性。以前的同步容器在内部只有一把锁,即容器自身,而ConcurrentHashMap使用一个更加细化的锁机制,名叫“锁分离”。这种机制允许更深层次的共享访问。任意数量的读线程可以并发访问Map,读和写线程可以并发访问Map,并且有限数量的写线程还可以并发修改Map。这样为并发访问带来了更高的吞吐量,同时几乎没有损失单个线程访问的性能。

ConcurrentHashMap提供了不会抛出ConcurrentModificationException异常的迭代器,因此不需要在容器迭代时加锁访问,它所返回的迭代器是弱一致性的,而非“及时失败”的。弱一致性的迭代可以允许并发修改,当迭代器被创建时,它会遍历已有的元素,并且可以(但是不保证)感应到在迭代器被创建后,对容器的修改。

尽管有这么多改进,但有一些还是需要权衡的地方。那些对整个Map进行操作的方法,如size和isEmpty,它们的语义在反映容器并发特性被弱化了。因为size的结果相对于在计算的时候可能已经过期,它仅仅只是一个估算值,所以允许size返回一个近似值而不是一个精确的值。这在一开始会让人有些困扰,不过事实上像size和isEmpty这样的方法在并发环境下几乎没有什么用处,因为它们的目标是在于并发的读与写,所以这些操作的原子性被弱化了。相反,应该保证对最重要的操作进行性能优化,最重要的是get、put、containsKey和remove。

相比于Hashtable和synchronizedMap,ConcurrentHashMap有很多的优势,因此大多数情况下ConcurrentHashMap取代同步Map实现只会带来更好的可伸缩性。只有当你程序需要独占访问中加锁时,ConcurrentHashMap才无法胜任。

因为ConcurrentHashMap不能被独占访问,所以我们不能在客户端加锁来创建新的原子操作,比如我在前面对Vector复合操作施加的原子性。不过一些常的复合操作,如“缺少即加入”、“相乘便移除”和“相等便替换”等都已被实现为原子操作。如果你正在已同步Map中加入这些功能时,你可能考虑使用ConcurrentHashMap来替代同步的Map。

public V putIfAbsent(K key, V value) :如果键不存在,则关联

public boolean remove(Object key, Object value) :如果键存在且值相等,则删除

public boolean replace(K key, V oldValue, V newValue) :如果键存在且值相等,则使用新的值替代旧值

public V replace(K key, V value) 如果键存在,则替换

CopyOnWriteArrayList是同步List的一个并发替代品,在通常情况下提供了更好的并发性,并避免了在迭代期间对容器加锁和复制.。相似地,CopyOnWriteArraySet是同步Set的一个并发替代,它是对CopyOnWriteArrayList包装,所有的操作都是转换给CopyOnWriteArrayList,与CopyOnWriteArrayList没什么区别。

“写入时复制 copy-on-write”容器的线程安全性保障是有要求的:只要将不可变对象正确的发布,那么访问它将不再需要同步。在每次修改时,所有对象它们的修改线程都会拥有一个底层数据的拷贝,以此来实现可变性。当集合上的迭代线程数目大大多于修改线程时,这种安排就显得十分有用了。

它们的迭代器保留容器底层基础数据的另一拷贝引用(注,仅仅是浅拷贝),这个数组永远不会被修改,因此对它的同步只不过是为了确保数组内容的可见性。因此,多个线程可以对这个容器进行迭代,并且不会受到另一个或多个想要修改容器的线程的影响。并且迭代时不会抛出ConcurrentModificationException异常,并且返回的元素严格与迭代器创建时相一致(但是如果元素本身是可变的则不一定),不会考虑后续的修改。

CopyOnWriteArrayList<StringBuffer> cwa = new CopyOnWriteArrayList<StringBuffer>();

cwa.add(new StringBuffer("0"));

Iterator<StringBuffer> it = cwa.iterator();

cwa.get(0).append("1");

cwa.add(new StringBuffer("3"));

while (it.hasNext()) {

// 不会抛异常,那怕在迭代创建后修改了结构,并只输出 01

System.out.println(it.next());

}

在每次对容器修改时都会复制底层基础数组,这需要开销,特别是对大容器,所以只有当对容器替代操作的频率远远高于对容器修改的频率时,使用“写入时复制”容器是个合理的选择。

Queue继承体系结构:

队列是一种数据结构,它有两个基本操作:在队列尾部加人一个元素,和从队列头部移除一个元素就是说,队列以一种先进先出的方式管理数据,如果你试图向一个已经满了的阻塞队列中添加一个元素或者是从一个空的阻塞队列中移除一个元索,将导致线程阻塞.在多线程进行合作时,阻塞队列是很有用的工具。工作者线程可以定期地把中间结果存到阻塞队列中而其他工作者线线程把中间结果取出并在将来修改它们。队列会自动平衡负载。如果第一个线程集运行得比第二个慢,则第二个线程集在等待结果时就会阻塞。如果第一个线程集运行得快,那么它将等待第二个线程集赶上来。下表显示了jdk1.5中的阻塞队列的操作:

add增加一个元素如果队列已满,则抛出一个IIIegaISlabEepeplian异常

remove移除并返回队列头部的元素如果队列为空,则抛出一个NoSuchElementException异常

element返回队列头部的元素如果队列为空,则抛出一个NoSuchElementException异常

offer添加一个元素并返回true如果队列已满,则返回false

poll移除并返问队列头部的元素如果队列为空,则返回null

peek返回队列头部的元素如果队列为空,则返回null

put添加一个元素如果队列满,则阻塞

take移除并返回队列头部的元素如果队列为空,则阻塞

remove、element、offer 、poll、peek 其实是属于Queue接口,这些方法都不会阻塞。

队列Queue接口与List、Set同一级别,都是继承了Collection接口。LinkedList现已经实现了Queue接口。Queue接口窄化了对LinkedList的方法的访问权限(即在方法中的参数类型如果是Queue时,就完全只能访问Queue接口所定义的方法了,而不能直接访问LinkedList的非Queue的方法),以使得只有恰当的方法才可以使用。BlockingQueue 继承自Queue接口。

阻塞队列的操作可以根据它们的响应方式分为以下三类:aad、removee和element操作在你试图为一个已满的队列增加元素或从空队列取得元素时抛出异常。当然,在多线程程序中,队列在任何时间都可能变成满的或空的,所以你可能想使用offer、poll、peek方法。这些方法在无法完成任务时只是给出一个出错示而不会抛出异常。

注意:poll和peek方法出错进返回null。因此,向队列中插入null值是不合法的。

还有带超时的offer和poll方法变种,例如,下面的调用:

boolean success = q.offer(x,100,TimeUnit.MILLISECONDS);

尝试在100毫秒内向队列尾部插入一个元素。如果成功,立即返回true;否则,当到达超时进,返回false。同样地,调用:

Object head = q.poll(100, TimeUnit.MILLISECONDS);

如果在100毫秒内成功地移除了队列头元素,则立即返回头元素;否则在到达超时时,返回null。

最后,看看阻塞操作put和take。阻塞队列提供了可阻塞的put和take方法,它们与可定时的offer和poll是等价的。如果Queue已经满了,put方法会阻塞直到有空间可用;如果是空,那么take方法会被阻塞直到有元素可用;而带有时间参数的offer与poll在没有空间或为空时,会阻塞到指定时间时返回。Queue的长度可以有限,也可以无限,无限的put方法将不会被阻塞。

生产者—消费者模式将“需要完成的工作”和“执行工作”分开。他简化了开发,消除了生产者与消费都之间的代码依赖。并解决了产生与消费在速度上不匹的问题。

最常见的生产者-消费者设计是将线程池与工作队列相结合起来(据我所知,Executor框架有以下地方用到了池:池中的线程就是放在队列中的,但Executor的任务提交后不是会放入队列中,而是立刻准备执行;ScheduledExecutorService定制的计划任务会放入工作队列中,等到延迟到达后执行;另外CompletionService处理完后的结果会放在队列中),讲述Executor任务执行框架时会具体介绍这个模式。

如果生产者产生工作的速度总是比消费者处理的速度快,那么任务放在没有边界的队列中最终会耗尽内存,如果我们此时使用有界的列队,当队列充满时则put会阻塞,从而消费者有时间追上进度。

阻塞队列同样提供了一个offer方法,如果加入不成功则返回失败,这样就给我们带了处理任务上的灵活,比如将未放入的任务序列化到磁盘、减少生产者线程、增加消费线程等。

有界队列是强大的资源管理器,用来建立可靠的应用程序:它会遏制那些产生多的工作量、具有威胁的活动,从而让你的程序在而对超负荷工作进更加的健壮。

类库中中包含一些BlockingQueue的实现:

LinkedBlockingQueue,底层基于链表结构的阻塞队列,默认情况下容量是没有上限的(说的不准确,在不指定时容量为Integer.MAX_VALUE,要不然的话在put时怎么会受阻呢),但是也可以选择指定其最大容量,它是基于链表的队列,此队列按 FIFO(先进先出)排序元素。

ArrayBlockingQueue,底层基于数组结构的阻塞队列,在构造时需要指定容量,并可以选择是否需要公平性,如果公平参数被设置true,等待时间最长的线程会优先得到处理(其实就是通过将ReentrantLock设置为true来达到这种公平性的:即等待时间最长的线程会先操作)。通常,公平性会使你在性能上付出代价,只有在的确非常需要的时候再使用它。它的底层基于数组的阻塞循环队列,此队列按 FIFO(先进先出)原则对元素进行排序。

PriorityBlockingQueue,它是基于PriorityQueue来实现的,而PriorityQueue优先队列底层是基于堆数据结构的,是一个带优先级的队列,而不是先进先出队列。元素按优先级顺序被移除,该队列也没有上限(因PriorityQueue是没有容量限制的,与ArrayList一样,所以在优先阻塞队列上put时是不会受阻的。虽然此队列逻辑上是无界的,但是由于资源被耗尽,所以试图执行添加操作可能会导致 OutOfMemoryError),但是如果队列为空,那么取元素的操作take就会阻塞,所以它的检索操作take是受阻的。另外,放入的元素要具有比较力或构建队列时指定一个Comparator比较器。

DelayQueue,也是基于PriorityQueue来实现的,是一个存放Delayed 元素的无界阻塞队列,只有在延迟期满时才能从中提取元素。该队列的头部是延迟期满后保存时间最长的 Delayed 元素。如果延迟都还没有期满,则队列没有头部,并且poll将返回null。当一个元素的 getDelay方法返回一个小于或等于零的值时,则出现期满,poll就以移除这个元素了。此队列不允许使用 null 元素。下面是Delayed接口:

public interface Delayed extends Comparable<Delayed> {

long getDelay(TimeUnit unit);

}

另外关于的介绍请参考:定时周期性任务章节最后。

最后一个BlockingQueue的实现是SynchronousQueue,但它根本上不是一个真正的队列,因为这个类没有存储元素的空间。不过,它维护一个排队的线程清单,这些线程等待把元素加入队列或者移出队列。这好比在洗盘子时,没有盘架子(在生产者与消费者模式中相当于它们之间的缓冲区)一样,却是直接将洗好的盘子放入烘干机。这种直接地移交工作,减少了在生产者和消费者之间移动数据的延迟时间。另外直接移交任务同样会给生产者带来更多关于任务状态的反馈信息,当移交被接受,它就知道消费者已经得到了任务,而不是简单地把任务放在一个队列或是什么其他地方。因为SynchronousQueue没有存储能力,所以除非另一个线程已经准备好参与移交工作,否则put和take会一直阻塞。SynchronousQueue这类队列只有在消费者充足的时候比较合适,因为这样总能为下一个任务移交做好准备(而生产者是主动发起,发不发起及什么时候发起移交动作由生产者来决定,所以只需要有够的消费者,而生产者多还是少不重要)。具体示例请参考:SynchronousQueue(同步队列)章节。

/**

* @author jiangzhengjun

* @date 2010-6-11

*/

public class TestLinkedBlockingQueue {

// 随机获取字母

private static char getChar() {

return (char) (Math.random() * 26 + 65);

}

// 随机睡几秒

private static void sleep() {

try {

Thread.sleep((long) (Math.max(500, Math.random() * 1000)));

} catch (InterruptedException e) {

e.printStackTrace();

}

}

private static class Producer implements Runnable {// 生产者

private BlockingQueue<String> sq;

public Producer(BlockingQueue<String> d) {

this.sq = d;

}

public void run() {

try {

while (!Thread.currentThread().isInterrupted()) {

sq

.put(Thread.currentThread().getName() + " - "

+ getChar());

sleep();

}

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

private static class Consumer implements Runnable {// 消费者

private BlockingQueue<String> sq;

public Consumer(BlockingQueue<String> d) {

this.sq = d;

}

public void run() {

try {

while (!Thread.currentThread().isInterrupted()) {

System.out.println(Thread.currentThread().getName() + " - "

+ sq.take());

sleep();

}

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

public static void main(String[] args) {

// LinkedBlockingQueue阻塞队列,可换成其他阻塞队列

BlockingQueue<String> sq = new LinkedBlockingQueue<String>();

Thread t = null;

for (int i = 0; i < 2; i++) {

t = new Thread(new Producer(sq));

t.setName("Producer -" + i + "- ");

t.start();

t = new Thread(new Consumer(sq));

t.setName("Consumer -" + i + "- ");

t.start();

}

}

}

/**

* @author jiangzhengjun

* @date 2010-6-11

*/

public class TestPriorityBlockingQueue {

// 随机获取字母

private static char getChar() {

return (char) (Math.random() * 26 + 65);

}

public static void main(String[] args) throws Exception {

// 优先级队列

BlockingQueue<Character> sq = new PriorityBlockingQueue<Character>();

Map<Character, Character> hashMap = new HashMap<Character, Character>();

System.out.print("put - ");

for (int i = 0; i < 26; i++) {

char c = getChar();

while (hashMap.containsKey(c)) {

c = getChar();

}

hashMap.put(c, c);

System.out.print(c + " ");

sq.put(c);

}

System.out.println();

System.out.print("take - ");

for (int i = 0; i < 26; i++) {

System.out.print(sq.take() + " ");

}

}

} /*

put - D G Q X P I Z L K E T O W F Y N M B V S U J H A R C

take - A B C D E F G H I J K L M N O P Q R S T U V W X Y Z

*/

从上面的输出可以看出队与入队的顺序是不一样的,在入队时会将元素进行排序,这里按照字母的自然顺序排列,所以出出队时就是有顺的了。

/**

* @author jzj

* @date 2010-6-11

*/

public class TestDelayQueue {

// 放入DelayQueue的对象需实现Delayed接口

static class DelayObj implements Delayed {

long time;// 可从队列中取出的时间点

int id;

public int getId() {

return id;

}

// time的单位是秒

DelayObj(long time, int id) {

this.time = System.nanoTime() + TimeUnit.SECONDS.toNanos(time);

this.id = id;

}

public int compareTo(Delayed y) {

long i = time;

long j = ((DelayObj) y).time;

if (i < j)

return -1;

if (i > j)

return 1;

return 0;

}

public boolean equals(Object other) {

return ((DelayObj) other).time == time;

}

public long getDelay(TimeUnit unit) {

long n = time - System.nanoTime();// 剩余延迟时间

return unit.convert(n, TimeUnit.NANOSECONDS);

}

public long getTime() {

return time;

}

public String toString() {

return String.valueOf(time);

}

}

public static void main(String args[]) throws InterruptedException {

Random random = new Random();

DelayQueue<DelayObj> queue = new DelayQueue<DelayObj>();

for (int i = 0; i < 5; i++) {

queue.add(new DelayObj(random.nextInt(5), i));

}

long last = 0;

for (int i = 0; i < 5; i++) {

// 只有延迟时间点到后才会取出

DelayObj delay = queue.take();

//从延时时间到达至从队列中取出来使用所相隔时间

long tmpTime = System.nanoTime() - delay.getTime();

long t = delay.getTime();

System.out.println("DelayObj_" + delay.getId() + "- "

+ delay.getTime() + " " + tmpTime);

if (i != 0) {

// 打印后一个比前一个延迟了多少

System.out.println("Delay last: " + (t - last));

}

last = t;

}

}

} /*

DelayObj_2- 10380274830293 40575

DelayObj_0- 10381273985449 414310

Delay last: 999155156

DelayObj_3- 10381274835355 15126560

Delay last: 849906

DelayObj_4- 10381274839786 15205837

Delay last: 4431

DelayObj_1- 10384274818037 15111507

Delay last: 2999978251

*/

从上面的输出来看,取出的顺序与放入的顺序是完全不一样的,取出的顺序是依赖于DelayObj的延时时间点time的值,即哪个时间点在前就先取出哪个。

BlockingQueue的put和take方法会抛出一个受检查的InterruptedException,这与类库中的其他方法是相同的,比如Thread.sleep。当一个方法能够抛出中断异常时,是在告诉你这个方法是一个可阻塞方法,并且,如果它被中断,将可以提前结束阻塞状态。

中断只是一种请求或者是一种提醒,中断方法是不会真真将某个线程立即停止掉。中断的结果线程是死亡、还是等待新的任务或是继续运行至下一步,就取决于这个程序本身。

如果当你的代码调用的方法抛出了InterruptedException异常,则意味着你的方法也就是一个阻塞方法了。处理InterruptedException异常的方式有以下几种:

1、 传递——可以不捕获InterruptedException异常,也可以先捕获然后做一些处理后再次抛出。

2、 恢复中断——有时你不能抛出InterruptedException异常,比如当你的代码是Runnable的一部分时。在这样的情况下,你必须捕获InterruptedException,并且,在当前线程中通过调用线程的interrupt从中断中恢复,这样高层代码将会发现中断已经发生。

以上是两种差不多可以对付大多数情况了,但是你不应该捕获InterruptedException后,不作任何响应,这样的话会丢掉线程中断的证据,从而剥夺了上层栈的代码处理中断的机会,除非你的代码是最高层代码。

详细的中断线程请参见这里XXXXXXXXXXXXXXXXXXX

java.util.concurrent包包含了若干能够帮助人们来管理线程相互合作的类。如果有一个相互合作的线程集,它又满足这些行为模式中的一种,那么应该直接重用合适的库类而不要去试图手工维护。

Class

它能做什么

何时使用它

CyclicBarrier

允许一个线程集等待直至其中预定数量的线程达到一个公共检障栅为止,然后可以选择执行一个处理障栅的动作

当大量的线程需要在它们的结果可用之前完成时

CountDownLatch

允许一个线程集等待直到计数器减为0为止

当一个或多个线程需要等待直到制定数量的结果可用为止

Exchanger

允许两个线程在要交换的对象准备好时交换对象

当两个线程工作在同一个数据结构的两个实例上时,一个向实例中添加数据,另一个将数据从实例中清除

SynchronousQueue

允许一个线程将对象交给另一线程

在没有同步的情况下,当两个线程准备好将一个对象从一个线程会给另一个时

Semaphore

允许线程集等待直到允许继承运行为止

用来限制访问资源的线程总数。如果许可是1,则阻塞线程直到另一个线程给出许可为止

闭锁(Latch),它可以延迟线程的进度直到线程到达终止状态。一个闭锁工作方式就像一道大门,直到闭锁到达终点状态之前,门一直关闭着,没有线程能够通过,终点状态到来的时候,门开了,允许所有线程都可以通过。一旦闭锁到达了终点状态,它就不能够再改变状态了,所以它会永远保持敞开状态,这与CyclicBarrier是不同的。闭锁可以用来确保特定的活动直到其他活动完成后才发生。

CountDownLatch 使用一个计数器来实现,它初始化为一个正,用来表示需要等待的活动事件数。countDown 方法使计数器减一,表示一个事件已经发生了,而await方法等待计数器达到零,此时表示所有需要等待的事件都已发生,只有当计数器到达零时,锁才会开起。如果计数器的初始值不为零,await会一直阻塞直到计数器为零,或者是等待线程中断或超时。

TestHarness展示了两种常见的用法。它有两个闭锁,一个是“开始阀门”和一个“结束阀门”,开始阀门将计数器初始化为1,结束阀门将计数器初始化为工作线程的数量。每个工作线程要做的第一件事是等待开始阀门的打开;这样做能确保所有线程都准备后才开始工作。每个线程的最后一个工作是为结束阀门减一,这样做会即时知道所有工作线程是都完成,这样就能计算事个耗时了。

public class TestHarness {

public static long timeTasks(int nThreads, final Runnable task)

throws InterruptedException {

final CountDownLatch startGate = new CountDownLatch(1);// 开始阀门

final CountDownLatch endGate = new CountDownLatch(nThreads);// 结束阀门

for (int i = 0; i < nThreads; i++) {

Thread t = new Thread() {

public void run() {

System.out.println(" " + System.currentTimeMillis());

try {

// 开始阀门,等待外界将阀门打开后(即所有线程都准备好后)

// 开始向下执行

startGate.await();

try {

task.run();

} finally {

// 当执行完后计数器减1

endGate.countDown();

}

} catch (Exception ignored) {

}

}

};

t.start();

}

long start = System.nanoTime();

startGate.countDown();//打开开始阀门

// 结束阀门,等待所有线程都完成后会自动打开

System.out.println("- " + System.currentTimeMillis());

endGate.await();

long end = System.nanoTime();

return end - start;

}

public static void main(String[] args) throws Exception {

System.out.println(timeTasks(10, new Runnable() {

public void run() {

}

}));

}

}/*

- 1276925505488

1276925505488

1276925505489

1276925505489

1276925505489

1276925505489

1276925505490

1276925505490

1276925505491

1276925505491

1276925505491

4738512

*/

上面为什么不在线程创建后就立即运行,还要像上面那样使用闭锁的方式?如果我们简单地创建线程并启动线程,那么先启动的就比后启动的具有“领先优势”,并且根据活动线程数据的增加或者减少,这样的竞争度也在不断改变。而开始阀门让控制线程能够同时释放所有工作线程,结束阀门让控制线程能够等待最后一个线程完成任务,而不需要自己去判断每个线程是否完成。

??但是要注意的是,上面还是不精确,因为从输出的结果可以看出startGate.countDown()是完全有可能在所有任务线程还没有开始前就已经先执行了,所有任务线程都聚集在一点后再同时执行在这里好像没有作到??下面是我改进后的结果:

public static long timeTasks(int nThreads, final Runnable task)

throws InterruptedException {

final CountDownLatch startGate = new CountDownLatch(1);// 开始阀门

final CountDownLatch taskStartGate = new CountDownLatch(nThreads);// 任务开始阀

final CountDownLatch endGate = new CountDownLatch(nThreads);// 结束阀门

for (int i = 0; i < nThreads; i++) {

Thread t = new Thread() {

public void run() {

System.out.println(" " + System.currentTimeMillis());

//只有所有任务线程执行此句后主线程才能继续执行

taskStartGate.countDown();

try {

// 开始阀门,等待外界将阀门打开后(即所有线程都准备好后)

// 开始向下执行

startGate.await();

try {

task.run();

} finally {

// 当执行完后计数器减1

endGate.countDown();

}

} catch (Exception ignored) {

}

}

};

t.start();

}

//确保所有任务线程都启动后(即进行了run方法)开始往后执行

taskStartGate.await();

System.out.println("- " + System.currentTimeMillis());

long start = System.nanoTime();

startGate.countDown();//打开开始阀门

// 结束阀门,等待所有线程都完成后会自动打开

endGate.await();

long end = System.nanoTime();

return end - start;

}

闭锁与障栅(CyclicBarrier)有下面向个不同点:

1、 不是所有线程(根据指定的线程数)都需要等待到闭锁打开为止

2、 闭锁可以由外部事件打开

3、 倒计时闭锁是一次性的,一旦计数器到达0,就不能再重用它了

闭锁Latch是一次性使用的对象,一旦进入到最终状态,就不能被重置了。

障栅类似于闭锁,它们都能够阻止一组线程,直到某些事件发生。与闭锁不同的是,所有线程必须都到达障栅后,才能继续处理。闭锁等待的则是事件,障栅等待的是其他线程。

CyclicBarrier在构造时需传递一个需在障栅点集合的线程数量,只有所有预定的线程都到达这个障栅点后,才可能往下执行,否则会被阻塞。

CyclicBarrier的await调用地方就是一个障栅点。如果所有线程都到达了障栅点,障栅就被成功地突破,这样所有线程都被释放,障栅会重置以备下一次使用。如果对await的调用超时或阻塞过程中被中断,那么障栅会失败,所有对await调用未完成的都抛出BrokenBarrierException异常而终止。如果所有线程都成功通过障栅,await为每一个线程返回一个唯一的到达索引号(其中,索引 getParties() - 1 指示将到达的第一个线程,零指示最后一个到达的线程)。CyclicBarrier 有一个可选的 Runnable 参数构造器,在一组线程中的最后一个线程到达之后(但在释放所有线程之前),该命令只在每个屏障点运行一次,若在任何参与线程继续执行之前更新共享状态,此屏障操作很有用。

下面是并行求和,它将数据根据CPU的内核数量分成多个任务后求和,一旦所有分段计算任务计算出结果后,就可以将每个任务的和进行汇总:

//并行计算

public class ConcurrentCal {

private final CyclicBarrier barrier;// 屏障

private final int cpuCoreNumber;// 待计算数组

private final int[] data;// 等计算数组

private final AtomicInteger sum = new AtomicInteger();// 和

// 计算任务

class SumCal implements Runnable {

private int[] numbers;

private int start;

private int end;

public SumCal(int num, final int[] numbers, int start, int end) {

this.numbers = numbers;

this.start = start;

this.end = end;

}

public void run() {// 求每小段数组的和

int tmpSum = 0;

for (int i = start; i < end; i++) {

tmpSum += numbers[i];

}

sum.getAndAdd(tmpSum);//存储每段和

try {

/*

* 在最后一个线程调用 await 方法之前,都将一直等待。只有当所有线

* 程都到达这里后才能通过

*/

barrier.await();

} catch (InterruptedException ex) {

return;

} catch (BrokenBarrierException ex) {

return;

}

}

}

public ConcurrentCal(int[] data) {

this.data = data;

cpuCoreNumber = Runtime.getRuntime().availableProcessors();// CPU内核数

this.barrier = new CyclicBarrier(cpuCoreNumber, new Runnable() {// 计算完后输出结果

/*

* 在最后一个线程到达之后,即触发点是最后一个线程调用await方法,并在该

* 方法中调用直接调用这个run方法(注,不会启动另一线程,而是直接在调用

* await方法线程中执行),且该命令只在每个屏障点运行一次

*/

public void run() {

System.out.println("计算完毕 sum=" + sum);

}

});

}

public void start() {

// 根据CPU核心个数拆分任务

for (int i = 0; i < cpuCoreNumber; i++) {

int increment = (data.length + 1) / cpuCoreNumber;

int start = increment * i;

int end = increment * i + increment;

if (end > data.length) {

end = data.length;

}

new Thread(new SumCal(i, data, start, end)).start();

}

}

public static void main(String[] args) {

int[] numbers = new int[] { 1, 2, 3, 4, 5, 6, 7, 8, 10, 11 };

new ConcurrentCal(numbers).start();

}

}

FutureTask实现了Runnable, Future两个接口

FutureTask同样可以作为闭锁。FutureTask的实现描述了一个抽象的可携带的结果的计算。FutureTask计算是通过Callable来实现的,它等价于一个可携带结果的Runnable,并有三个状态:等待、运行、完成,而完成包括正常结束、取消、异常。一旦进行完成状态,就会永永远停止在这个状态上。

FutureTask.get的行为依赖于任务的状态,如果它已经完成,便可立即返回结果,否则会被阻塞直到任务完成后返回结果或者抛出异常。

FutureTask把计算结果从运行计算的线程传送到了需要这个结果的线程,同时FutureTask保证了返回的对象是已经初始化完整的对象,可以心使用。

Executor框架利用了FutureTask来完成异步任务,并可以用来进行任何潜在的耗时计算,而且可以在真正需要计算结果之前就启动它们开始预先计算。

使用FutureTask预载稍后需要的数据:

public class Preloader {

private final FutureTask<ProductInfo> future =

new FutureTask<ProductInfo>(new Callable<ProductInfo>() {

public ProductInfo call() throws DataLoadException {

return loadProductInfo();

}

});

private final Thread thread = new Thread(future);

//不要在构造器中或静态初始化方法中启动线程,所以提供了这个单独的启动方法

public void start() { thread.start(); }//可以在get方法之前预先异步执行,等到调用get时结果已经准备后或者只需要等待很短的时间了

public ProductInfo get() throws DataLoadException, InterruptedException {

try {

//get会抛出三种异常:ExecutionException - 如果计算抛出异常;InterruptedException - 如果当前的线程在等待时被中断;以及非捕获性异常CancellationException - 如果计算被取消。

return future.get();

} catch (ExecutionException e) {// ExecutionException表示只要是计算过程的异常都会封装在这里面,再被Future.get重新抛出

Throwable cause = e.getCause();

if (cause instanceof DataLoadException)

throw (DataLoadException) cause;

else

throw launderThrowable(cause);

}

}

}

/** 如果Throwable是Error则抛出;如果是

* RuntimeException 则返回;其他情况抛出IllegalStateException

*/

public static RuntimeException launderThrowable(Throwable t) {

if (t instanceof RuntimeException)

return (RuntimeException) t;

else if (t instanceof Error)

throw (Error) t;

else

throw new IllegalStateException("Not unchecked", t);

}

使用信号量进行同步和互斥的控制是最经典的并发模型,java中也提供支持。相当于操作系统中的PV操作原语。

计数信号量用来控制能够同时访问某特定资源的线程的数量,它可以用来实现资源池或者给一个容器限定边界。

一个Semaphore管理一个有效的许可(permits)集,许可初始量通过构造函数传入,通过acquire方法申请一个许可(相当于PV操作原语中的P操作,即申请一个资源),许可数为0则阻塞线程,否则许可获取成功后要使用release方法释放一个许个(相当于PV操作原语中的V操作,即释放资源),这时许可数就加一。

通俗一点讲,许可就像一个令牌,谁拿到令牌(acquire)就可以去执行了,如果没有令牌则需要等待。执行完毕,一定要归还(release)令牌,否则令牌会被很快用光,别的线程就无法获得令牌而执行下去了。

计算信息量的一种退化形式就是二元信号量:一个计数量为1的Semaphore为二元信号量,相当于一个互斥锁,表示不可重入的锁,谁拥有了这个唯一许可,就拥有了互斥锁。请参考PV操作对单缓冲的同步与互斥XXXXXXXXXXXXXXXXX

下面使用Semaphore把任何容器转换为有界的阻塞容器:

public class BoundedHashSet<T> {

private final Set<T> set;

private final Semaphore sem;

public BoundedHashSet(int bound) {

this.set = Collections.synchronizedSet(new HashSet<T>());

sem = new Semaphore(bound);// bound为容器允许的最大容量

}

public boolean add(T o) throws InterruptedException {

sem.acquire();//如果容器满后则阻塞

boolean wasAdded = false;

try {

wasAdded = set.add(o);

return wasAdded;

}

finally {

if (!wasAdded)//如果添加不成功,则释放刚刚获取的信号量

sem.release();

}

}

public boolean remove(Object o) {

boolean wasRemoved = set.remove(o);

if (wasRemoved)//如果删除成功,则需要释放一个信号量

sem.release();

return wasRemoved;

}

}

Exchanger是两个线程可以交换对象的同步点。每个线程都在进入 exchange 方法时给出某个对象,相互接受对方准备的对象。

当两个线程工作在同一个数据缓冲区的两个实例上时,就可以使用交换器。典型情形是,一个线程向缓冲区中添加数据,另一个线程消费掉这些数据,当它们都完成后,它们相互交换缓冲。

Exchanger 可能被视为 SynchronousQueue 的双向形式。

/**

* 生产线程不停地向未满绥存中添加元素直到满为止,

* 消费线程不停地从非空缓存读取元素直到缓冲空为止,

* 当生产线程的缓存满且消费线程的缓存空时,将两者

* 的缓存互换,就这样一直下去

* @author jiangzhengjun

* @date 2010-6-9

*/

public class TestExchanger {

//交换器

static Exchanger<DataBuffer> exchanger = new Exchanger<DataBuffer>();

static DataBuffer emptyBuffer = new DataBuffer(10);

static DataBuffer fullBuffer = new DataBuffer(10);

public static void main(String[] args) {

new Thread(new ProducerThread()).start();

new Thread(new ConsumerThread()).start();

}

//随机获取字母

private static char getChar() {

return (char) (Math.random() * 26 + 65);

}

//随机睡几秒

private static void sleep() {

try {

Thread.sleep((long) (Math.max(500, Math.random() * 1000)));

} catch (InterruptedException e) {

e.printStackTrace();

}

}

//生产者 —— 不停的向缓冲中添加字母

static class ProducerThread implements Runnable {

public void run() {

int index = 0;

while (!Thread.currentThread().isInterrupted()) {

try {

// 如果发现数据缓冲满后,则不能再向缓冲添加元素,准备与消费线程中的空缓冲交换

if (emptyBuffer.isFull()) {

// 等待一个满的数据缓冲,一旦生产线程准备好,则互换,即将满的数所缓存

// 传递给消费线程,并获取消费线程会传进来的空的数据缓存

emptyBuffer = exchanger.exchange(emptyBuffer);

System.out.println("ProducerThread.capacity - "

+ emptyBuffer.data.size());

index = 0;

} else {//如果数据缓冲不满,则直到添加满为止

char c = getChar();

System.out.println("ProducerThread - " + (index++) + " - " + c);

emptyBuffer.put(c);

sleep();

}

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

//消费者 —— 不停的从缓冲中获取字母

static class ConsumerThread implements Runnable {

public void run() {

int index = fullBuffer.capacity;

while (!Thread.currentThread().isInterrupted()) {

try {

// 如果发现数据缓冲为空,则不能再读取元素,准备与生产消费线程中的满缓冲交换

if (fullBuffer.isEmpty()) {

// 等待一个满的数据缓冲,一旦生产线程准备好,则互换,即将空的数所缓存

// 传递给生产线程,并获取生产线程会传进来的满的数据缓存

fullBuffer = exchanger.exchange(fullBuffer);

System.out.println("ConsumerThread.capacity - "

+ fullBuffer.data.size());

index = fullBuffer.capacity;

} else {//如果缓冲不为空,则读到缓冲为空止

System.out.println("ConsumerThread - " + (--index) + " - "

+ fullBuffer.get());

sleep();

}

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

//数据缓冲

static class DataBuffer {

private List<Character> data;

private int capacity;//缓冲允许最大容量

public DataBuffer(int capacity) {

this.capacity = capacity;

data = new ArrayList<Character>();

}

public void put(char c) {

if (data.size() < capacity) {

data.add(c);

}

}

public char get() {

if (data.size() >= 0) {

return data.remove(data.size() - 1);

} else {

return 0;

}

}

public boolean isFull() {

return data.size() == capacity ? true : false;

}

public boolean isEmpty() {

return data.size() == 0 ? true : false;

}

}

}

一个阻塞队列,在每次的put操作中必须等待另一线程执行对应的take操作,反之亦然。同步队列没有任何内部容量,甚至连一个队列的容量都没有。SynchronousQueue允许我们在两个线程之间交换单个元素。

同步队列类似于 CSP 和 Ada 中使用的 rendezvous 信道。它非常适合于传递性设计,在这种设计中,在一个线程中运行的对象要将某些信息、事件或任务传递给在另一个线程中运行的对象,它就必须与该对象同步(即信息在两个线程间是相同的,这与普通的列队缓存是不一样的,这个是即放即取,信息对象不会停留在同步队列中)。

对于正在等待的生产者和消费者线程而言,SynchronousQueue的构造器还支持可选的公平排序策略。默认构造器是下不保证这种排序。使用公平设置为 true 所构造的队列可保证线程以 FIFO 的顺序进行访问。公平通常会降低吞吐量,但是可以减小可变性并可避免得不到服务。

另外SynchronousQueue详细的介绍请参考:阻塞队列和生产者—消费者模式章节。

/**

* @author jiangzhengjun

* @date 2010-6-9

*/

public class TestSynchronousQueue {

// 随机获取字母

private static char getChar() {

return (char) (Math.random() * 26 + 65);

}

// 随机睡几秒

private static void sleep() {

try {

Thread.sleep((long) (Math.max(500, Math.random() * 1000)));

} catch (InterruptedException e) {

e.printStackTrace();

}

}

private static class Producer implements Runnable {// 生产者

private BlockingQueue<String> sq;

public Producer(BlockingQueue<String> d) {

this.sq = d;

}

public void run() {

try {

while (!Thread.currentThread().isInterrupted()) {

// 但不一定能做到即消即产,因为生产者远少于消费者

sq.put(Thread.currentThread().getName() + " - "

+ getChar());

sleep();

}

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

private static class Consumer implements Runnable {// 消费者

private BlockingQueue<String> sq;

public Consumer(BlockingQueue<String> d) {

this.sq = d;

}

public void run() {

try {

while (!Thread.currentThread().isInterrupted()) {

System.out.println(Thread.currentThread().getName() + " - "

+ sq.take());// 即产即消,因为消费者比生产者充足

sleep();

}

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

public static void main(String[] args) {

// 同步队列

BlockingQueue<String> sq = new SynchronousQueue<String>();

Thread t = null;

//我们只创建二个生产者

for (int i = 0; i < 2; i++) {

t = new Thread(new Producer(sq));

t.setName("Producer -" + i + "- ");

t.start();

}

//创建多个消费者

for (int i = 0; i < 10; i++) {

t = new Thread(new Consumer(sq));

t.setName("Consumer -" + i + "- ");

t.start();

}

}

}

几乎每个服务器应用程序都使用某种形式的调整缓存。利用已有的计算结果可以缩短等等时间,提高吞吐量,代价是占用更多的内存。

下面我们一步步来构建一个调整的缓存,并一步步的优化。先尝试使用HashMap和同步来初始化缓存,下面是简单的实现:

public interface Computable<A, V> {//具有计算能力接口

V compute(A arg) throws InterruptedException;

}

//实现计算接口

class ExpensiveFunction implements Computable<String, BigInteger> {

public BigInteger compute(String arg) {//假设这是一个耗时的计算实现

// after deep thought...

return new BigInteger(arg);

}

}

class Memoizer1<A, V> implements Computable<A, V> {

//使用HashMap来建立缓存

private final Map<A, V> cache = new HashMap<A, V>();

private final Computable<A, V> c;//

public Memoizer1(Computable<A, V> c) {

this.c = c;

}

//注意这里需要同步HashMap

public synchronized V compute(A arg) throws InterruptedException {

V result = cache.get(arg);//缓存中是否已有

if (result == null) {//如果缓存中没有则重新计算

result = c.compute(arg);

cache.put(arg, result);

}

return result;

}

}

上面实现中Memoizer1中compute方法被整个同步了,这保证了线程安全,但是却带来一个明显的可伸缩性问题:一次只有一个线程能够执行compute。如果另外一个线程正忙于计算结果,其他调用compute的线程可能被阻塞很长时间。那么,compute可能会比不使用缓存花费更长的时间。这显示不是我们希望的结果。

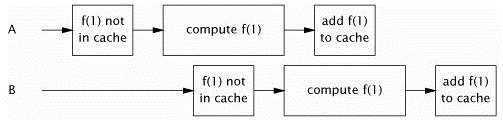

下面使用ConcurrentHashMap取代HashMap,改进Memoizer1中这种糟糕的并发行为。因为ConcurrentHashMap是线程安全的,所以不需要同步。Memoizer2与Memoizer1相比,毫无疑问具有更好的并发性:多线程可以真正并发地使用它了。但是它作为调整缓存仍然存在缺陷——当两个线程同时调用compute时,存在一个漏洞,可能同时计算相同的值。这对于这种备忘录形式的缓存,这仅仅是效率的问题,但是对于像一个缓存对象仅仅只能被初始化一次的缓存,这个漏洞就会带来安全性问题了。

public class Memoizer2<A, V> implements Computable<A, V> {

private final Map<A, V> cache = new ConcurrentHashMap<A, V>();

private final Computable<A, V> c;

public Memoizer2(Computable<A, V> c) { this.c = c; }

public V compute(A arg) throws InterruptedException {

V result = cache.get(arg);

if (result == null) {//计算相同参数的线程可能在相隔不长的时间内都到达

result = c.compute(arg);

cache.put(arg, result);

}

return result;

}

}

下面使用ConcurrentHashMap<A,Future<V>>替代ConcurrentHashMap<A, V>:

class Memoizer3<A, V> implements Computable<A, V> {

//缓存的不是值,而是一个计算的任务过程,它可能正在计算,也可能已计算完成

private final Map<A, Future<V>> cache = new ConcurrentHashMap<A, Future<V>>();

private final Computable<A, V> c;

public Memoizer3(Computable<A, V> c) {

this.c = c;

}

public V compute(final A arg) throws InterruptedException {

Future<V> f = cache.get(arg);

if (f == null) {

Callable<V> eval = new Callable<V>() {

public V call() throws InterruptedException {

return c.compute(arg);

}

};

FutureTask<V> ft = new FutureTask<V>(eval);

f = ft;

cache.put(arg, ft);//这里与上面if一起使用时是一个复合操作,所以还是有问题

ft.run(); // call to c.compute happens here

}

try {

return f.get();//如果还没有计算完则等待,否则马上返回

} catch (ExecutionException e) {

e.printStackTrace();

}

return null;

}

}

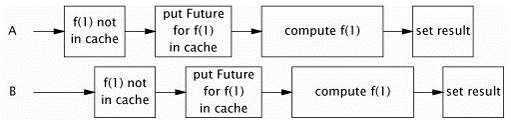

Memoizer3首先检查一个相应的计算是否开始,Memoizer2与它相反,它计算是否完成。Memoizer3的实现近乎是完美的:它展现了非常好的并发性(大部分来源于ConcurrentHashMap良好的并发性),能很快的返回结果,如果新到的线程请求的是其他线程正在计算的结果,它会耐心地等待。虽然这个程序与Memoizer2一样也存在着相同的缺陷,从上面幅图可以看出这个机率要小得多。这是还是因为if语句与put操作不是一个原子性引起的。

使用putIfAbsent方法来替换上面的复合操作:

public V compute(final A arg) throws InterruptedException {

while (true) {

Future<V> f = cache.get(arg);

if (f == null) {

Callable<V> eval = new Callable<V>() {

public V call() throws InterruptedException {

return c.compute(arg);

}

};

FutureTask<V> ft = new FutureTask<V>(eval);

f = cache.putIfAbsent(arg, ft);//重新检测if条件不是否满足

if (f == null) { f = ft; ft.run(); }//只有在成功放入后才开始计算

}

try {

return f.get();//注,计算取消或失败时都需要从缓存中移除,因为取消与失败的任务下次还是不会计算成功

} catch (CancellationException e) {

cache.remove(arg, f);//如果计算被取消,则移除,以便下次新的计算

} catch (ExecutionException e) {

cache.remove(arg, f);//如果计算失败,也要移除,以便下次新的计算

throw launderThrowable(e.getCause());//对ExecutionException异常进行分解

}

}

}

这个最终的修复的程序还是有缓存过期的问题,但是这些可以通过FutureTask的一个子类来完成,它会为每一个结果关联在一个过期时间,并周期性地扫描缓存中过期的访问。

@ThreadSafe

public class Factorizer implements Servlet {

private final Computable<BigInteger, BigInteger[]> c =

new Computable<BigInteger, BigInteger[]>() {

public BigInteger[] compute(BigInteger arg) {

return factor(arg);//计算某个数的因子,可能耗时比较长

}

};

private final Computable<BigInteger, BigInteger[]> cache

= new Memoizer<BigInteger, BigInteger[]>(c);//高速缓存

public void service(ServletRequest req, ServletResponse resp) {

try {

BigInteger i = extractFromRequest(req);

encodeIntoResponse(resp, cache.compute(i));//从缓存中取或重新计算

} catch (InterruptedException e) {

encodeError(resp, "factorization interrupted");

}

}

}

任务就是抽象、离散的工作单元。把一个应用程序的工作分离到任务中,执行与任务的分离,可以简化程序的管理。

服务器应用程序应该兼具良好的吞吐量和快速的响应性。

下面SingleThreadWebServer顺序地处理它的任务——接受达到80端吕的HTTP请求:

class SingleThreadWebServer {

public static void main(String[] args) throws IOException {

ServerSocket socket = new ServerSocket(80);

while (true) {

Socket connection = socket.accept();

handleRequest(connection);

}

}

}

理论上它是正确的,但它一次只能处理一个请求,因此在生产环境中的执行效率是很糟糕的。线程不断地在“接受连接”与“处理相关请求”之间交替运行,并且直到线程完成了当前的请求并再次调用accept,此前新的请求都必须等待。如果请求的处理速度很快,这样未尝不可,但我们不能将它应用到现实的Web Server中。该程序响应慢而且CPU利用率低。

顺序化处理在简单性或者安全性上具有优势,当任务数量少,但生命周期很长时或者服务器只服务于唯一用户时,比较应用。但它不能为服务器应用程序提供良好的吞吐量或快速的响应性。

为了提供好的响应性,可以为每个服务请求创建一个新的线程:

class ThreadPerTaskWebServer {

public static void main(String[] args) throws IOException {

ServerSocket socket = new ServerSocket(80);

while (true) {

final Socket connection = socket.accept();

Runnable task = new Runnable() {//使用线程处理每个请求

public void run() {

handleRequest(connection);

}

};

new Thread(task).start();

}

}

}

执行任务的负载已经脱离了主线程,这让主循环能够迅速地重新开始等待下一个连接,提高了响应性。另外“每任务一个线程”这样并行处理任务,使得多个请求可以同时得到服务,如果加上有多个处理器,程序的吞量会得到提高。

在中等强度的负载水平下,“每任务一个线程”方法是对顺序化执行的良好改进,只要请求的到达速度尚未超出服务器的请求处理能力,那么这种方法可以同时带来更快的响应性和更大的吞吐量。

“每任务一线程”存在一些实际的缺点:

1、 线程生命周期的开销:线程的创建关闭都要消耗资源,如果请求是频繁的,为每个请求创建一个线程会消耗大量的资源。

2、 资源消耗量:活动线程会消耗系统资源,尤其是内存。如果可运行的线程数多于可用的处理器数,线程将会空闲。大量空闲的线程会占用更多的内存,给垃圾回收带来压力,而且大量线程在竞争CPU资源时,还会产生其他性能开销。如果在这种有大量线程竞争CPU资源情况下,再创建线程将会产生更大的威害。

3、 稳定性:应该限制可创建线程的数目。这个数目在依赖于不同的平台与JVM启动时所带的参数。如果你超过这个数目,最可能的结果是收到一个OutOfMemoryError。

在一定范围内,增加线程可以提高系统的吞吐量,一旦超出了这个范围,再创建更多的线程只会拖垮你的程序。为了避免这种危险,应该设置一个范围限制你的应用程序可以创建的线程数,然后测试你的程序,确保线程数达到这个范围的极限,程序又不会耗尽所有的资源。

“每任务一线程”的问题在于它没有对创建的线程的数量进行任何限制。无限制的创建线程的行为在开发阶段可能表现还良好,但一旦部署后,并运行于高负载环境下,它的问题才会暴露出来。

任务是逻辑上的工作单元,线程是使任务异步执行的机制。

前面两种线程执行任务的策略者有严重的局限性:顺序执行会产生糟糕的响应性和吞吐量;“每任务一线程”会给资源管理带来麻烦。

就像“有界队列”防止应用程序过载而耗尽内存,线程池为线程管理提供了同新的好处。

作为Executor框架的一部分,java.util.concurrent提供了一个灵活的线程池实现。在Java类库中,任务执行的首要抽象不是Thread,而是Executor。

Executor接口:

public interface Executor {

void execute(Runnable command);

}

这是一个简单的接口,但它却为灵活强大的框架提供了基础。这个框架可以用于异步任务的执行,且支持很多不同的任务执行策略。为任务提交和任务执行之间的解耦提供了方法,并支持以前旧的Runnable的任务形式。

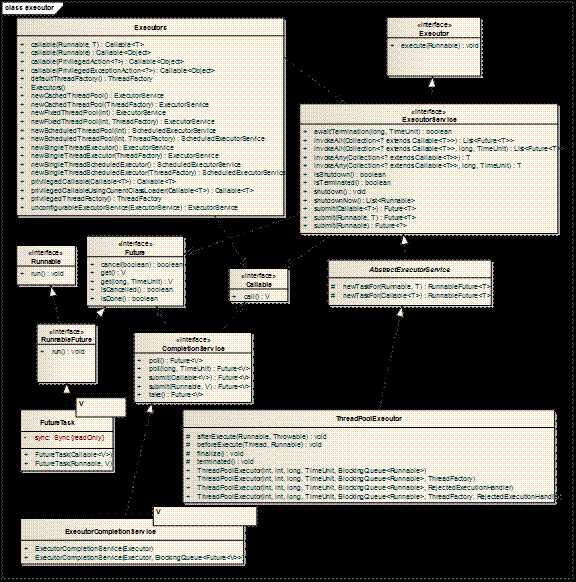

java.util.concurrent包中提供的 Executor 实现实现了 ExecutorService,这是一个使用更广泛的接口。ThreadPoolExecutor 类提供一个可扩展的线程池实现。Executors 类为这些 Executor 提供了便捷的工厂方法。

Executor是基于生产者——消费者模式。提交任务的执行者是生产者(产生待执行的工作单元-任务),执行任务的线程是消费者(从队列中取任务并执行)。如果你要在你的程序中实现一个生产者-消费者的设计,使用Executor通常是最简单的方式。

class TaskExecutionWebServer {

private static final int NTHREADS = 100;

private static final Executor exec = Executors.newFixedThreadPool(NTHREADS);

public static void main(String[] args) throws IOException {

ServerSocket socket = new ServerSocket(80);

while (true) {

final Socket connection = socket.accept();

Runnable task = new Runnable() {

public void run() {

handleRequest(connection);

}

};

exec.execute(task);

}

}

}

在这个程序中我们使用到了Executor的标准实现ThreadPoolExecutor。通过使用Executor,将处理请求任务的提交与它的执行体进行了解耦。只要替换一个不同的Executor实现,就可以改变服务器的行为。改变Excecutor的实现或者配置,所产生的影响远远小于直接改变任务的执行方式。

只要作些简单的修改,就可以让TaskExecutionWebServer像ThreadPerTaskWebServer那样一样运行:替换一个Executor,它为每个请求都创建一个新的线程。我们只需这样实现:

public class ThreadPerTaskExecutor implements Executor {

public void execute(Runnable r) {

new Thread(r).start();

};

}

或者如果要像SingleThreadWebServer那样运行,则可以让Executor在调用线程中同步地执行所有任务:

public class WithinThreadExecutor implements Executor {

public void execute(Runnable r) {

r.run();

};

}

所以使用Executor是很方便的,它可以让你很方便的更改线程的执行机制,做到了任务与执行的解耦与真正分离。

将任务的提交与任务的执行进行解耦,它的价值在于让你可以简单地为一个任务制定执行策略,并且保证后续的修改不会很因难。

任务策略包括以下几方面:

1、 任务在哪个线程中执行?

2、 任务以什么顺序执行(FIFO、LIFO、优先级)?

3、 可以有多少个任务并发执行?

4、 可以有多少个任务进入等待执行队列?

5、 如果系统过载,需要放弃哪一个任务呢?另外,如何通知应用程序知道这一切呢?

6、 在一个任务的执行前与结束后,应该做什么处理?

执行策略是资源管理的手段。最佳策略取决于可用的计算资源和你对服务质量的需求。将任务的提交与任务的执行策略规则进行分离,有助于在部署阶段选择一个与当前硬件最匹配的执行策略。

无论何时当你看到这种形式的代码:new Thread(runnable).start(),并且你可能最终希望获得一个更加灵活的执行策略时,请认真考虑使用Executor代替Thread。

线程池是与工作队列紧密绑定的。所谓工作队列,其作用是持有所有等待执行的任务。

在线程池中执行任务有很多“每任务一线程”无法比的优势。重用存在的线程而不是新的线程可以在处理多请求时抵消线程创建与消亡产生的开销。另一好处就是,在请求到达时,工作者线程通常已经存在,不需要因创建线程而延迟任务的执行,因此提高了响应性。我们还可以通过调整线程池的大小,你可以得到更多的线程让处理器处于忙碌状态,同时也可防止过多的线程相互竞争资源。

类库中已经提供了灵活的线程池实现和一些有用的预设配置。你可以通过Executors中的某静态方法来创建这个线程池:

newFixedThreadPool:创建一个固定数目的线程池,每当提交一个任务就创建一个线程,直到达到最大数目,这时线程池会保持长度不再变化(如果一个线程因意外的异常而死掉后会重新增加一个)。

newCachedThreadPool:创建一个可缓存的线程池,如果当前线程池的长度超过了处理的需要时,它可以灵活地回收空闲的线程,当需要增加时,它可以灵活地添加新的线程,而并不会池的长度作任何限制。

newSingleThreadExecutor:创建一个单线程化的Executor,它只创建唯一的工作者线程来执行任务,如果这个线程因异常结束,会有另一个线程取代它。Executor会保证任务依照任务队列所规定的顺序(FIFO、LIFO、优先级)执行。

newScheduledThreadPool:创建一个定长的线程池,而且支持定时的以及周期性的任务执行,类似于Timer。

newFixedThreadPool与newCachedThreadPool两个工厂方法返回多用途的ThreadPoolExecutor实例。直接使用ThreadPoolExecutor,也能创建出专用的Executor。

从“每任务一线程”策略迁移到基于池的策略,会对应用程序的稳定性产生重大的影响:Web Server再也不会因过高的负载而失败了(尽管服务器不会因为创建过多的线程而失败,但如果在很长的时里,任务到达的速度要超任务的执行速度工,内存仍然可能耗尽,因为等待执行的Runnable队列会不断的增长,当然我们可以使用一个有界的工作队列在Executor框架内解决这个问题)。

JVM会在所有线程(守护线程除外)全部终止后才退出。因此,如果无法正确关闭Executor,将会阻止JVM的结束。

Executor是异步执行任务的,任务集中,有些可能完成,有些可能正在运行,有些还可能在队列中等待执行,这会导致关闭很复杂。为了解决ExecutorService生命的问题,ExecutorService接口扩展了Executor,并且添加了一些用于生命周期管理的方法(同时还提供任务提交的便利方法):

public interface ExecutorService extends Executor {

void shutdown();

List<Runnable> shutdownNow();

boolean isShutdown();

boolean isTerminated();

boolean awaitTermination(long timeout, TimeUnit unit)

throws InterruptedException;

// ... additional convenience methods for task submission

}

ExecutorService有三种状态:运行(running)、关闭(shutting down)、和终止(terminated)。ExecutorService最初创建后的初始状态是运行状态。shutdown方法会启动一个平缓的关闭过程:停止接受新的任务,同时等待已经提交的任务完成——包括尚未开始执行的任务。shutdownNow方法会启动一个强制的关闭过程:停止所有正在执行的活动任务,暂停处理正在等待的任务,无法保证能够停止正在处理的活动执行任务,但是会尽力尝试,例如,通过 Thread.interrupt() 来取消是一种典型的实现,如果任何任务屏蔽或无法响应中断,则可能永远无法终止该任务。

如果Executor已关闭后提交的任务会被拒绝执行器(rejected execution handler)处理,拒绝执行器可能会悄悄的放弃任务,也可能引发execute抛出一个RejectedExecutionException异常,一旦所有任务都完成,则ExecutorService进行终止状态。可以调用awaitTermination等待ExecutorService进行终止状态,也可以轮询查询isTerminated来判断否进行终止状态了。通常awaitTermination紧跟随shutdwon之后,这样可以产生同步关闭ExecutorService的效果。

下面LifecycleWebServer为Web Server提供了生命周期的支持进行了扩展,它支持两种关闭方式:通过编程手工的调用stop方法,另一种就是由客户端发送一个关闭请求然后再调用stop进行关闭。

class LifecycleWebServer {

private final ExecutorService exec = ...;

public void start() throws IOException {

ServerSocket socket = new ServerSocket(80);

while (!exec.isShutdown()) {

try {

final Socket conn = socket.accept();

exec.execute(new Runnable() {

public void run() { handleRequest(conn); }

});

} catch (RejectedExecutionException e) {

if (!exec.isShutdown())

log("task submission rejected", e);

}

}

}

public void stop() { exec.shutdown(); }

void handleRequest(Socket connection) {

Request req = readRequest(connection);

if (isShutdownRequest(req))//判断客户端是否发送关闭请求

stop();

else

dispatchRequest(req);

}

}

Timer存在一些缺陷,我们应该使用ScheduledThreadPoolExecutor替换他,你也可以使用Executors的工厂方法newScheduledThreadPool工厂方法来创建它。

Timer只创建一个线程来执行所有的timer的任务TimerTask,如果一个任务的执行很耗时,会导致其他的TimerTask的定时执行不准确。例如一个TimerTask每10秒执行一次,而另一个TimerTask每40秒执行一次,短的TimerTask任务可能会在长的TimerTask执行完后快速连续地执行4次,也可能丢掉4次调用(这取绝于你是调用的按固定频率方法如scheduleAtFixedRate或延迟进行调用方法如schedule)。但调度线程池解决了这个缺陷,它提供了多个线程来执行定时周期性任务。

Timer的另一问题是如果TimerTask中抛出了未检查异常(不可能抛检查异常,因为TimerTask的run方法声明没有抛出任何异常),由于Timer线程不捕获任何异常,所以Timer线程会被终止掉,未开始执行的TimerTask将不会不再执行(当然执行了一半的线程就是当前抛出异常的线程,不会是其他线程,因为Timer是按串行来执行每个任务的,所以不会同时出现两个任务在执行)。

由于Timer是启动一个线程来串行的从任务队列中取任务然后执行,如果任务抛出未检查异常,则这个异常不会被抛到调用Timer的线程,因为异常是不会从子线程抛到他的父线程中去的,所以只是Timer线程死掉,而它的父线程还会正常运行。只要某个任务抛出了未检测异常,如果你在计划任务将会得到一个携带“Timer already cancelled”信息的异常。但ScheduledThreadPoolExecutor妥善地处理了这个行为异常的任务。

如果你要自己创建调度服务,你可以使用类库中提供的DelayQueue,它是BlockingQueue的一个实现,是它为ScheduledThreadPoolExecutor提供了调度的功能。DelayQueue是管理实现Delayed接口的对象,只有在延迟期满时才能从中提取元素,该队列的头部是延迟期满后保存时间最长的 Delayed 元素。实现Delayed的getDelay方法可以告诉DelayQueue所剩余延迟时间(零或负值指示延迟时间已经用尽,表示延时期满),只有延时期满的对象才能放入队列中,在调用take时会调用getDelay进行判断是否延时期满。在放入队列过程中还会根据延时长短进行排序,排序的依据是compareTo(因为Delayed还实现了Comparable接口)方法。

要使用Executor,我们得要将任务描述成Runnable对象,这就需要在需求中找出任务的边界,这些任务可大可小。

下面我们开发一个组件的不同版本,每个版本允许的不同的并发性。示例是模拟浏览器渲染HTTP页面的功能,模拟一个页面渲染器组件。假设HTTP页面里只有文本标签,当然在文本中穿插着图片(图片标签还带有尺寸大小)。

最简单的渲染方式是顺序处理,当遇到文本时就先渲染到图像缓存中;当遇到图像时,先去到服务器上下载图像,然后也将它渲染到图像缓存里,等整个HTML页面都渲染好后展示给用户,如果页面很大,图片很的多的情况下会让用户等等很长时间。

另一种同样是顺序执行的方法血稍微好一些,它将渲染文本与渲染图像分开执行。它先渲染所有文本,并为图片预留出图像的所占用的框,在完成第一趟处理后就展示给用户,接着程序开始下载图像,并将它们绘制到相应的框中。SingleThreadRenderer就采用了这种方式:

public class SingleThreadRenderer {

void renderPage(CharSequence source) {

renderText(source);//渲染文本,并预留图像占位框

List<ImageData> imageData = new ArrayList<ImageData>();

for (ImageInfo imageInfo : scanForImageInfo(source))//扫描所有图像

imageData.add(imageInfo.downloadImage());

for (ImageData data : imageData)

renderImage(data);//下载并渲染图像

}

}

虽然Executor框架可以使用Runnable作为基本的任务单元,但Runnable不具有返回值与抛出受检查异常。

如果Callable不需要返回值,可以使用Callable<void>。

可以通过Executors的相关方callable法将Runnable封装成Callable接口的对象。

一个Executor执行的任务生命周期有4个阶段:创建、提交、开始和完成。

在Executor框架中,总可以取消(shutdown、shutdownNow)已经提交但未开始的任务,但是对于已经开始执行的任务,只有它们响应中断才可以取消。取消已经完成的任务没有影响。

Future描述了任务的任命周期,并提供了相关方法来获取结果(get)、取消任务(cancel)以及检查任务是已经完成(isDone)还是被取消(isCancelled)。

Future任务生命周期是单向的,不能向后转换——与ExecutorService的生命周期一样,一旦任务,它就永远停留在完成状态上。下面是Future与Callable接口:

public interface Callable<V> {

V call() throws Exception;

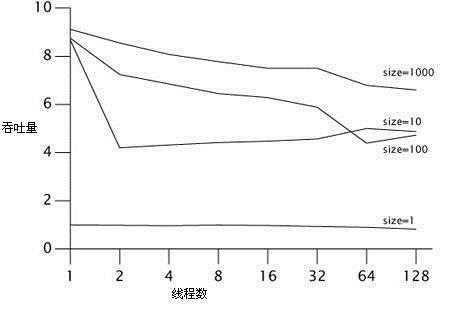

}

public interface Future<V> {

boolean cancel(boolean mayInterruptIfRunning);

boolean isCancelled();

boolean isDone();

V get() throws InterruptedException, ExecutionException,

CancellationException;

V get(long timeout, TimeUnit unit)

throws InterruptedException, ExecutionException,

CancellationException, TimeoutException;

}

任务的状态(还未开始、运行中、完成)决定了get方法的行为:如果任务已完成,get会立即返回或者抛出一个异常;如果任务没有完成,get会阻塞直到它完成。在计算的过程中,如果任务抛出了异常,get会将该异常封装为ExecutionException,然后重新抛出;如果任务被取消,get会抛出CancellationException。当抛出ExecutionException时,可以用getCause获取原始异常,下面是get的源码片段:

V innerGet() throws InterruptedException, ExecutionException {

acquireSharedInterruptibly(0);//如果未执行完会在这里阻塞

if (getState() == CANCELLED)//如果任务已取消

throw new CancellationException();

if (exception != null)//如果任务执行的过程中抛出异常

throw new ExecutionException(exception);

return result;

}

有很多种获取任务的Future,ExecutorService中的submit方法可以接受一个Callable或Runnable,然后可以返回一个Future,因此可用它来获取任务的结果或者取消它。FutureTask实现了Future与Runnable接口,在构造时我们可以确地传进Runnable或Callable来实例化一个FutureTask,它可以提交给Executor来执行,或者将它包装成Thread后当作线程执行,因为FutureTask具有Future特性,所以已可取消或获取执行结果。

在1.6中,ExecutorService所有的实现都覆写了AbstractExecutorService中的newTaskFor方法,以此来控制ExecutorService中get方法所返回的Future的实例对象类型,该方法默认就是创建一个FutureTask类型的Future实例对象。

将Runnable或Callable对象提交到Executor是一个对象安全发布的过程,即Runnable或Callable对象从提交线程传递到任务执行的任务的过程是线程安全的,我们不用担心这些对象是否完全初始(Runnable与Callable对象的工作内存中的数据写回到主内存中)。类似地,通过Future的get方法获取的任务执行结果也是一个安全发布了的对象,我们在获取它的过程中是线程安全的。

为了使用渲染器具有更高的并发性,我们需要将渲染过程分成两个任务:一个是渲染文本,一个是下载所有图像(因为一个受限于CPU,一个受限于I/O)。

使用Future等待图像下载:

public class FutureRenderer {

private final ExecutorService executor = ...;

void renderPage(CharSequence source) {

final List<ImageInfo> imageInfos = scanForImageInfo(source);

Callable<List<ImageData>> task =//图像下载任务

new Callable<List<ImageData>>() {

public List<ImageData> call() {

List<ImageData> result//存储下载的图片

= new ArrayList<ImageData>();

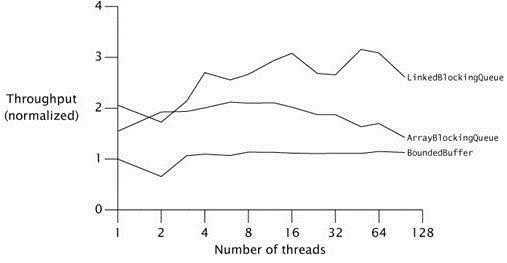

for (ImageInfo imageInfo : imageInfos)

result.add(imageInfo.downloadImage());

return result;//返回下载的图片

}

};

Future<List<ImageData>> future = executor.submit(task);//在渲染文本前启动

renderText(source);//开始渲染文本

try {

List<ImageData> imageData = future.get();//阻塞获取下载的图片

for (ImageData data : imageData)

renderImage(data);//待图片下载完后开始渲染图像

} catch (InterruptedException e) {

// 恢复中断状态

Thread.currentThread().interrupt();

// 我们不需要结果了,所以可以将任务取消

future.cancel(true);

} catch (ExecutionException e) {

throw launderThrowable(e.getCause());

}

}

}

虽然上面在一定程度上提高了并发性,然后,我们还可以做得更好,用户不必等到怕有的图像下载完成后一下子看到所有图片,他们或许更希望只要下载完一幅图像就要看到一幅。

FutureRenderer用到了两个任务:一个负责渲染文本,一个负责下载图像。如果渲染文件的速度远远大于下载图像的速度(这完全是有可能的),那么最终的性能与顺序执行版的性能不会有很大的不同,反倒提高了代码的复杂度。

如果你向Executor提交了一批任务并且还要处理这批任务返回的结果,我们可以通过Executor的实现类ExecutorService的“List<Future<T>> invokeAll(Collection<Callable<T>> tasks)”方法快捷的实现,也可以通过循环这批任务然后在循环里通过ExecutorService的“Future<T> submit(Callable<T> task)”一个个提交给Executor并将返回的Future存储在列表中供后续取消或获取任务结果使用。

上面是调用invokeAll返回的Future列表,列表里元素的顺序与给定任务列表的迭代器所生成的顺序或在循环中通过submit一个个提交的顺序相同。这个缺点就是如果第一个任务要花很多时间,invokeAll就不能及时返回Future列表,这会造成不必要的等待,而在等待期间可能某些任务已经完成,并可以对这些已完成的任务结果先进行处理,显然,返回的结果列表顺序与给定任务列表的迭代器所生成的顺序相同在某些时候可能没什么意义,如果将结果列表按可获得任务结果的顺序保存起来会更有意义(即哪个任务先完成则先处理谁),我们可以通过ExecutorCompletionService来实现。

当然我们也可以不用invokeAll而是在在循环中逐个提交一批任务,并将任务相关连的Future存在放列表中,处理结果时需要手动自己对Futue列表进行遍历,如果想等前面的任务结果返回后再处理紧跟在后面的,则也会造成不必要的等待,但我们也可以反复的轮询Future列表,谁先完成后就处理谁,但这要经过反复的检查任务是否完成(isDone),即使这也不会比使用ExecutorCompletionService方便。

CompletionService提供将“任务生产者线程”与“获取已完成任务的结果”分离开来的服务。原来是这样处理的:在提交任务后(不管是批量还是单条)处理结果时,我们直接通过Future来get结果,如果任务未执行完,get会阻塞,这对只提交一条任务来说没关系,但如果是一批的话,挨个get就不合理的了,因为很有可能调用的get的这个任务还未完成就会阻塞,而其他的任务已经执行完成便可以处理了,所以这会造成不必要的等待。而合理的做法是谁先完成就处理谁的结果。那既然想要这样合理的处理,就要对任务返回的结果进行排列——谁先完成就把它排在最前面,幸运的是我们不需要自己做这些事,ExecutorCompletionService已为会提供了这一切。

CompletionService它整合了Executor和BlockingQueue的功能。通过CompletionService提交的任务会委托给Executor去提交并执行,而执行的返回结果会按照任选执行完成的先后顺序存放到BlockingQueue中,所以能从BlockingQueue队列中取出的结果是已执行完的任务结果。

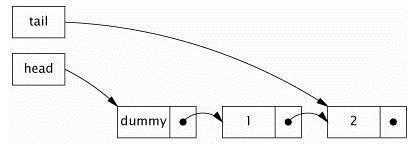

ExecutorCompletionService是一个CompletionService实现,它通过封装Executor与LinkedBlockingQueue来实现。任务执行完成时会调用FutureTask(ExecutorService返回的Future结果就是FutureTask类型实现)中的done方法。当向ExecutorCompletionService提交一个任务后,首先把这个任务包装为QueueingFuture(而ExecutorService则是封装成FutureTask),它是FutureTask的一个子类,并覆写了done方法,就是在这个方法中将结果放入LinkedBlockingQueue中的。

ExecutorCompletionService的使用大致如下:

//包装一个Executor

ExecutorCompletionService service = new ExecutorCompletionService(executor);

//在循环中一个个提交任务,因为CompletionService不像ExecutorService具

//有任务批量提交方法invokeAll

for (Callable<Integer> task : tasks) service.submit(task);

//在循环中从队列中获取任务结果,结果的个数就是任务的个数,taks为任务集合

for (int i = 0; i < taks.size(); i++)

count += service.take().get();//从阻塞队列中取出Futur,再读取结果,这里的结果肯定是执行完或取消的任务,调用get是不会阻塞的,但take是可能被阻塞的。

使用CompletionService,我们可以从两方面提高页面渲染器的性能:缩短总的运行时间以及提高响应性。我们可以在每需要下载一个图像时,就创建一个独立的任务,并在线程池中执行它们,将顺序的下载过程转换为并行的:这能减少下载所有图像的总时间。而且从CompletionService中获取结果,只要任何一个图像下载完成,就能立刻展示给用户,由此我们要以给用户提供一个更加动态和有更高响应的用户界面。

public class Renderer {

private final ExecutorService executor;

Renderer(ExecutorService executor) {

this.executor = executor;

}

void renderPage(CharSequence source) {

final List<ImageInfo> info = scanForImageInfo(source);

//对ExecutorService进行包装,转换成CompletionService

CompletionService<ImageData> completionService =

new ExecutorCompletionService<ImageData>(executor);

for (final ImageInfo imageInfo : info)//对图像信息循环

//每幅图像一个下载任务

completionService.submit(new Callable<ImageData>() {

public ImageData call() {

return imageInfo.downloadImage();

}

});

//当所有图像下载任务启动后进行文本渲染工作

renderText(source);

try {

//返回结果数目与任务数相等,对结果进行遍历

for (int t = 0, n = info.size(); t < n; t++) {

//从结果队列中获取Future结果对象,来一个就取一个,但这里有可能阻塞

Future<ImageData> f = completionService.take();

//获取任务结果,这里不可能被阻塞

ImageData imageData = f.get();

renderImage(imageData);//开始渲染图像

}

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

} catch (ExecutionException e) {

throw launderThrowable(e.getCause());

}

}

}

有时如果一个任务无法在某个指定的时间内完成,那么它的结果就失效了,此时程序可以放弃该任务。如,一个Web应用会从外部的广告服务器上获取广告信息,但是如果应用程序在两秒钟得不到响应,就会显示一个默认的信息,这样即使得不到广告信息也不会破坏站点的响应性需求。

Future.get(long timeout,TimeUnit unit)为我们提供了时限便利操作:它在结果准备好后立即返回,如果在时限内没有准备好,就会抛出TimeoutException。

使用限时任务的问题是,当它们超时时应该能够停止它们,这样才不会继续运行而浪费资源。为了达到这个目的,可以让任务自己严格管理它的预定时间,超时后就终止执行;或者也要吧在超出时限后取消任务。Future再次派上用场:如果一个限时的get抛出TimeoutException,你可以通过Future取消任务。

下面演示了限时的Future.get的一种典型应用,在指定时间内获取广告信息,如果get超时,会取消获取广告的任务,并使用默认信息代替:

Page renderPageWithAd() throws InterruptedException {

long endNanos = System.nanoTime() + TIME_BUDGET;//预计任务在这个点运行完

Future<Ad> f = exec.submit(new FetchAdTask());//提交下载广告任务

// 在等待广告的时渲染页面

Page page = renderPageBody();

Ad ad;//广告

try {

// 仅需等待所剩余的预计时间

long timeLeft = endNanos - System.nanoTime();

ad = f.get(timeLeft, NANOSECONDS);//在限时内获取结果

} catch (ExecutionException e) {

ad = DEFAULT_AD;//如果广告任务执行失败,则设置默认广告

} catch (TimeoutException e) {

ad = DEFAULT_AD; //如果广告下载超时,则设置默认广告

f.cancel(true);//并取消广告下载任务

}

page.setAd(ad);//为页面设置广告

return page;

}

上面是单个任务采用Future.get来限时的,如果现在我们要对一批任务进行限时,且我们不关心任务是否全部完成,则我们可以通过Executor的invokeAll、invokeAny的限时版本来提交任务。invokeAll会在指定的时间内一定会返回Future列表,但列表里可能会有被取消的任务;invokeAny只要有一个任务完成,则

get:在任务完成前一直阻塞。会抛出三种异常:CancellationException - 如果计算被取消、ExecutionException - 如果计算抛出异常、InterruptedException - 如果当前的线程在等待时被中断。

get(long timeout, TimeUnit unit):在超时之前且任务未完成则一直阻塞。除抛出以上三种异常

cancel(boolean mayInterruptIfRunning):试图取消对此任务的执行。如果任务已完成、或已取消,或者由于某些其他原因而无法取消,则此尝试将失败。当调用cancel时,如果调用成功,而此任务尚未启动,则此任务将永不运行。如果任务已经启动,则mayInterruptIfRunning参数决定了是否调用运行任务的线程的interrupt操作。

isCancelled:如果在任务正常完成前将其取消,则返回true

isDone:正常终止、异常或取消而完成,在所有这些情况中,此方法都将返回 true

ExecutorService的有三个重载的submit方法:

1、 可以接收Runnable或Callable类型的任务,返回Future<?>类型的Future的get返回null。

2、 这三个方法都将提交的任务转换成了Future的实现类FutureTask实例,并作为submit的返回实例。

3、 另外调用这三个方法不会阻塞,不像invokeAll那样要等到所有任务完成后才返回,与不像invokeAny那样要等到有一个任务完成后才返回Future。

4、 这个三方法会调用Executor的execute来完成,因为Executor的execute会抛出RejectedExecutionException - 如果不能接受执行此任务、NullPointerException - 如果命令为 null这两个运行进异常,所以这三个方法也会抛出这两个异常。

T invokeAny(Collection<Callable<T>> tasks):

1、 只要某个任务已成功完成(也就是未抛出异常,这与任务完成概念不一样:任务完成是指定Future的isDone返回true,有可能是抛出异常后进行完成状态),才返回这个结果。一旦正常或异常返回后,则取消尚未完成的任务(即任务所运行的线程处理中断状态,一旦在它上面出现可中断阻塞的方法调用,则会抛出中断异常)。

2、 此方法会阻塞到有一个任务完成为止(正常完成或异常退出)。

3、 也是调用Executor的execute来完成

4、 调用get不会阻塞

invokeAny(Collection<Callable<T>> tasks, long timeout, TimeUnit unit):

1、 只要在给定的超时期满前某个任务已成功完成(也就是invokeAny方法不能抛出异常,包括Future.get所抛的异常),则返回其结果。一旦正常或异常返回后,则取消尚未完成的任务。

2、 此方法会阻塞到有一个任务完成为止(正常完成或异常退出)。

3、 也是调用Executor的execute来完成

4、 调用get不会阻塞

List<Future<T>> invokeAll(Collection<Callable<T>> tasks):

1、 只有当所有任务完成时,才返回保持任务状态和结果的 Future 列表。返回列表的所有元素的 Future.isDone() 为 true。注意,可以正常地或通过抛出异常来已完成任务。

2、 此方法会阻塞到所有任务完成为止(正常完成或异常退出)。

3、 也是调用Executor的execute来完成,如果任务执行过程中抛出了其他异常,则方法会异常退出,且取消所有其他还未执行完成的任务。

4、 返回的列表中的Future都是已经完成的任务,get时不会再阻塞

invokeAll(Collection<Callable<T>> tasks, long timeout, TimeUnit unit):

1、 当所有任务完成或超时期满时(无论哪个首先发生),返回保持任务状态和结果的 Future 列表(如果是超时返回的列表,则列表中的会包括这些还未执行完的任务,使用get获取结果时可能会抛出CancellationException异常)。返回列表的所有元素的 Future.isDone() 为 true。一旦返回后,即取消尚未完成的任务。注意,可以正常地或通过抛出异常来完成任务。

2、 此方法会阻塞到所有任务完成为止(正常完成或异常退出或超时)。

3、 也是调用Executor的execute来完成,如果任务执行过程中抛出了其他异常,则方法会异常退出,且取消所有其他还未执行完成的任务。

4、 返回的列表中的Future中会有因超时执行任务时异常而未执行完的任务,get时会抛出CancellationException或ExecutionException,当然所有的Future的get也不会阻塞。

当外部代码能够在活动自然完成前,能把它的状态更改为完成,那么这个活动被称为可取消的。我们可能会因为很多的原因取消一个活动:用户请求取消、应用程序事件、限时活动、错误、关闭系统。

简单的取消任务的方式是,在活动中定义一个标示,用它来保存取消状态,但要注意的是这个标示域一定要是volatile域,否则由于线程对变量的可见性问题而永远不会停止活动。

一个可取消任务必须拥有取消策略——其他代码如何请求取消该任务、任务在什么时间点检查取消语法是否到达、如何处理取消请求。

PrimeGenerator中的取消机制最终会导致任务退出,但并不是立刻发生的,需要花费一定的时间。如果某个任务调用了一个阻塞方法,如BlockingQueue.put,我们可能会永远都不能取消标志,因些永远都不会终结。

每一个线程都有一个boolean类型的中断状态;在中断的时候,这个中断状态被设置为了true,Thread包含其他用于中断线程的方法,以及获取线程中断状态的方法:

public class Thread {

public void interrupt() { ... }

public boolean isInterrupted() { ... }

public static boolean interrupted() { ... }

...

}

interrupt方法是发出中断请求,并且将线程的中断状态设置为true;isInterrupted是返回目标线程的中断状态;静态方法interrupted也是返回目标线程中断状态,只不过是在访问后立即清除中断状态,它也是唯一清除中断状态的方法,它的目标线程是发起interrupted操作的线程,即当前线程:

public static boolean interrupted() {

return currentThread().isInterrupted(true);

}

所有的类库阻塞方法,如Thread.sleep、Object.wait,如果在阻塞过程中发现线程的中断状态为true,则会先清除当前线程中断状态,再抛出InterruptedException异常,则阻塞方法会因抛出异常而不再阻塞。JVM并没有对阻塞方法发现中断的速度作出保证,不过在现实中这样的响应还是比较迅速的。

当线程在并不处于阻塞状态的情况下发生中断时,会设置线程的中断状态为true,然后一直等到被取消的线程获取中断状态,来检查是否发生了中断,如果不触发InterruptedException异常,中断状态会一直保持,直到有人特意去清除中断状态。

调用interrupt并不意味着一定会停止目标线程,它仅仅是传递了请求中断的消息。线程自己会在一个方便时候选择是否退出运行。

静态的isInterrupted应该小心使用,因为它会清除并发线程的中断状态。如果你调用了isInterrupted,并返回true,你必须对其进行处理,除非你想掩盖这个中断——这时你可以抛出InterruptedException,或者通过再次调用interrupt来保证中断状态。

好像在while循环中显示的检测中断状态(!Thread.currentThread().isInterrupted()))并不是绝对必要的,因为调用了阻塞的put方法,在阻塞时如果线程被中断,则会抛出异常而退出循环,但是这种检测会使用PrimeProducer对中断具有更好的响应性。这是因为在耗时的任务开始之前就有可能发出了中断请求,而不需一定等到put抛出异常才退出。

正如任务的取消策略一样,线程也应有中断策略,一个中断策略决定线程如何应对中断请求——当发现中断请求时如何处理、哪些任务需要考虑原子性、以怎样的速度响应中断。

区分任务和线程对中断的反应很重要,一个单一的中断请求可能有一个或一个以上预期的接收者——在线程池中中断一个工作者线程,意味着取消当前任务,并关闭工作线程,这个中断请求会涉及到任务与线程。

任务不会在自己拥有的线程中执行,它们借助于属性服务的线程,如线程池。如果代码不属于这个线程(对线程池而言,线程池中的线程执行的任何任务都是外部代码)就应该小心地保存中断状态,以便代码拥有者线程能够处理它(中断状态)(想一想,Executor框架中正是这样处理的,我们向Executor提交的任务相对于Executor来说就是外部代码,Executor在执行任务过程中所发生的异常都会保存下来,并可通过Future.get来获取这些异常,另外Executor也将底层的InterruptedException异常传递给了get方法)。

不要掩盖了低层的中断信息,这就是为什么大多数的阻塞库函数仅仅是抛出InterruptedException作为处理的过程,因为这些阻塞库函数调用是经过了库以外的用户(比如我们)调用,所以它们作出了这样合理的取消策略:将异常重新抛给调用者们,这样上层栈就可以进一步处理了。

当检查到中断请求时,任务并不需要放弃所有事情——它可以选择推迟,直到更合理的时机,这需要记得它已经被请求过中断了,完成当前正在进行的任务,然后抛出InterruptedException或者指明中断。

当发现中断信息后,不管我们是否取消任务还是继续执行任务,我们都要保存中断信息,如果对中断的处理不仅仅是将InterruptedException传递给调用者,那还应该在捕获InterruptedException之后恢复中断状态:

Thread.currentThread().interrupt();

因为每一个线程都有其自己的中断策略,所以你不应该终止线程,除非你知道中断对这个线程意味关什么,而是将中断信息传递给上层调用者。

Java中的中断策略是推迟处理,在响应性和健壮性之间处于平衡。

有两种处理InterruptedException异常的实用策略:

1、 传递异常,使用你的方法也成为可中断阻塞方法

2、 或者保存中断状态,上层调用栈中的代码能够对其进行处理

向调用者传递InterruptedException:

BlockingQueue<Task> queue;

...

public Task getNextTask() throws InterruptedException {

return queue.take();

}

如果你不能将InterruptedException传递出去(比如你的任务实现了Runnable的run方法,它是不允许报出非检测异常的),这里你需要在异常块里再次调用interrupt保存中断状态,而不是捕获到了什么也不做,除非你真正实现了线程的中断策略。大多数代码并不知道它们会在哪个线程中运行,所以应该保存中断状态。

只有实现了线程中断策略的代码才可以接收中断请求,通用的任务和库的代码绝不应该接收中断请求,因为它们会被上层调用。

不可取消的任务的中断方式:有些任务拒绝被中断,这使得它们是不可取消的。但是,即使是不可取消的任务也应该尝试保留中断状态,以防在不可取消的任务结束之后,调用栈上更高层的代码需要对中断进行处理。清单 6 展示了一个方法,该方法等待一个阻塞队列,直到队列中出现一个可用项目,而不管它是否被中断。为了方便他人,它在结束后在一个 finally 块中恢复中断状态,以免剥夺中断请求的调用者的权利。(它不能在更早的时候恢复中断状态,因为那将导致无限循环—— BlockingQueue.take() 将在入口处立即轮询中断状态,并且,如果发现中断状态集,就会抛出 InterruptedException。)

清单 6. 在返回前恢复中断状态的不可取消任务

public Task getNextTask(BlockingQueue<Task> queue) {

boolean interrupted = false;

try {

while (true) {

try {

return queue.take();

} catch (InterruptedException e) {

interrupted = true;

// 失败并重试

}

}

} finally {

if (interrupted)// 保留中断状态

Thread.currentThread().interrupt();

}

}

如果你的代码没有调用可中断的阻塞方法,它仍然可以通过检查任务当前线程中断状态来响应中断。选择适当的检查频率需要在效率和响应性之间进行权衡,如果你有高响应性的需求,那么你不应该调用潜在的耗时方法,

有很多的程序运行是没有结束条件的,它们可能永远地运行下去(比如列举某个数的所有质数)。下面是求所有的质数过程:

//求所有质数(素数)的任务

public class PrimeGenerator implements Runnable {

//存储所有求得的质数

private final List<BigInteger> primes = new ArrayList<BigInteger>();

private volatile boolean cancelled;//取消标示

public void run() {

BigInteger p = BigInteger.ONE;//从质数1开始

while (!cancelled) {//轮询是否已被取消

/*

* BigInteger.nextProbablePrime返回大于此 BigInteger 的

* 可能为素数的第一个整数

*/

p = p.nextProbablePrime();

synchronized (this) {

primes.add(p);

}

}