标签:

让Java程序能够识别Hadoop的hdfs URL方案需要一些额外的工作,采用的方法是通过FsUrlStreamHandlerFactory实例调用java.net.URL对象的setURLStreamHandlerFactory方法。每个Java虚拟机只能调用一次这个方法,因此通常在静态方法中调用。

程序如下:

package com.lcy.hadoop.file; import java.io.InputStream; import java.net.URL; import org.apache.hadoop.fs.FsUrlStreamHandlerFactory; import org.apache.hadoop.io.IOUtils; public class URLCat {

static{ URL.setURLStreamHandlerFactory(new FsUrlStreamHandlerFactory()); }

public static void main(String[] args) throws Exception { // TODO Auto-generated method stub InputStream in=null; try{ in=new URL(args[0]).openStream(); IOUtils.copyBytes(in, System.out, 4096,false); }finally{ IOUtils.closeStream(in); } } }

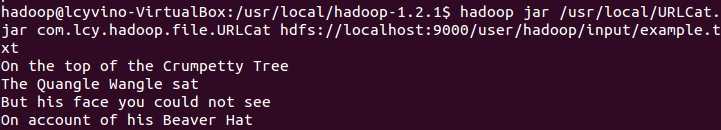

运行示例:

标签:

原文地址:http://www.cnblogs.com/Murcielago/p/4318384.html