标签:

这不是一个有说服力的测试,算是我的体验吧

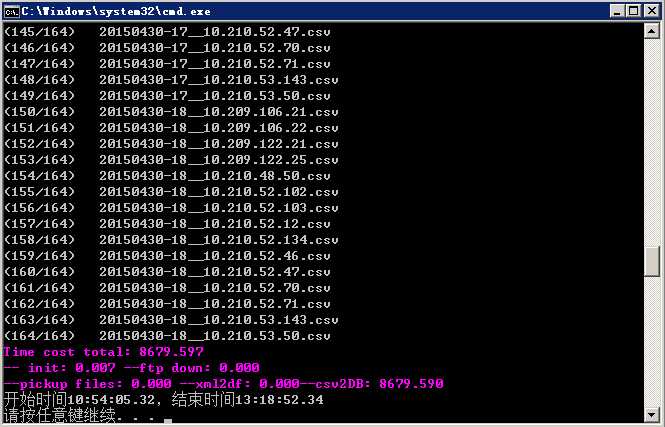

通过pandas.read_csv函数将总共1.44GB的164个csv文件依次(转为dataframe对象,并新增2条series,再将该dataframe通过 pandas.to_sql函数写成1.23GB的sqlite数据库文件,从导入第四个文件后,就越来越慢,怀疑是缓存不足,总共花费两个多小时。

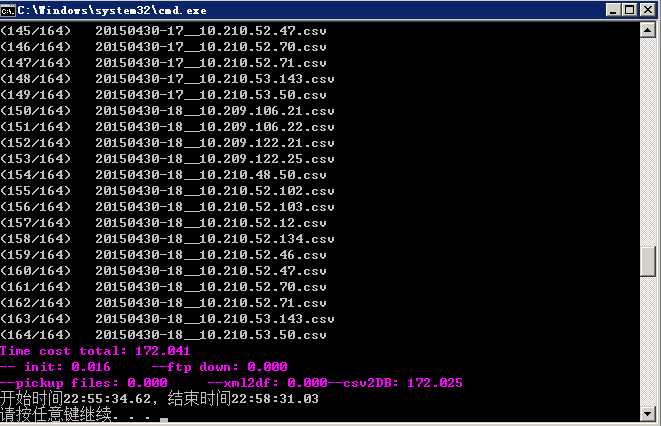

而sqlite3.connect(‘:memory:‘)写入内存数据库仅需2分钟多,当然还没转储到磁盘,相信转储花的时间应该也不多。

标签:

原文地址:http://www.cnblogs.com/lightwind/p/4507143.html