标签:

|

使用的教程为: 1. windows7+eclipse+hadoop2.5.2环境配置 http://www.cnblogs.com/huligong1234/p/4137133.html 2. Hadoop 在Windows7操作系统下使用Eclipse来搭建Hadoop开发环境 http://www.linuxidc.com/Linux/2014-12/111061.htm 3. eclipse_win7_hadoop1.2.1开发环境搭建1 |

1. 下载安装最新版本Eclipse IDE for Java EE Developers(java环境配置在此不赘述)。

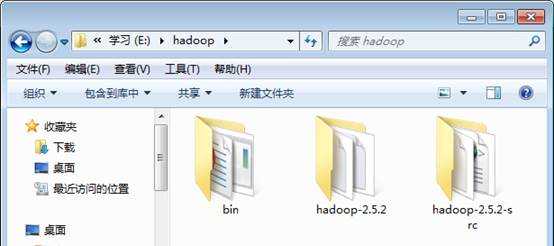

2. 将之前编译好的64位的hadoop-2.5.2.tar.gz下载下来,同官网下载的hadoop-2.5.2-src.tar.gz 一样,解压到E:\hadoop。并将老羊群里给的hadoop2.5.2(x64).zip也解压到该目录下,如下图:

3. 添加环境变量HADOOP_HOME=E:\hadoop\hadoop-2.5.2\

追加环境变量path内容:%HADOOP_HOME%/bin

以上变量均添加在系统变量而非用户变量中。--------(原因不明)

(后面配置paoding环境变量时是配置在hadoop系统中而非虚拟机系统中------------------------------------------------原因依旧不明)

4. 下载插件hadoop-eclipse-plugin-2.5.2.jar并将其复制到Eclipse的目录的"plugins"中,然后重新Eclipse即可生效。

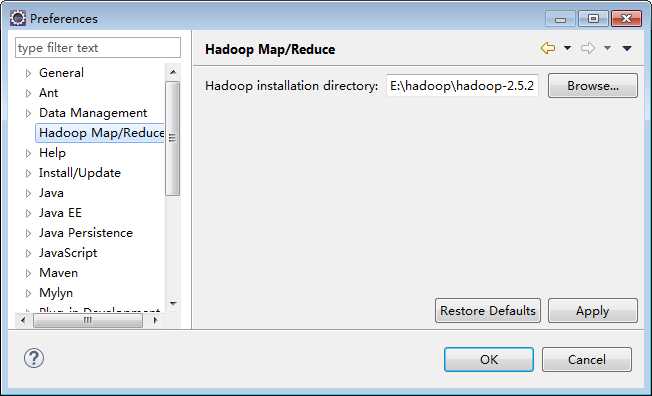

5. 配置Hadoop installation director。打开菜单Window--Preference--Hadoop Map/Reduce进行配置,在窗口右侧设置Hadoop安装路径。如下图所示:

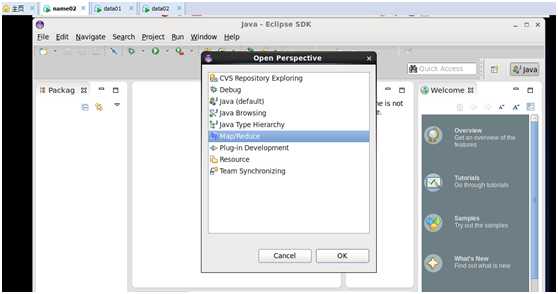

6. 配置Map/Reduce Locations

打开Windows-->Open Perspective-->Other

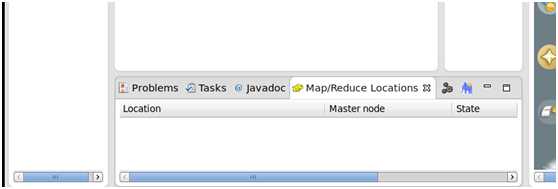

选择Map/Reduce,点击OK,在右下方看到有个Map/Reduce Locations的图标,如下图所示:

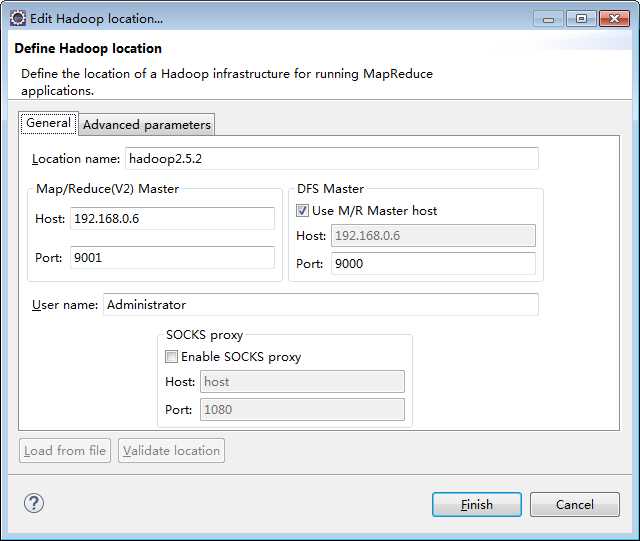

7. 点击Map/Reduce Location选项卡,点击右边小象图标,打开Hadoop Location配置窗口:输入Location Name,任意名称即可.配置Map/Reduce Master和DFS Mastrer,Host和Port配置成与core-site.xml的设置一致即可。

去找core-site.xml配置:

|

fs.default.name hdfs://master:9000 |

在界面配置如下:

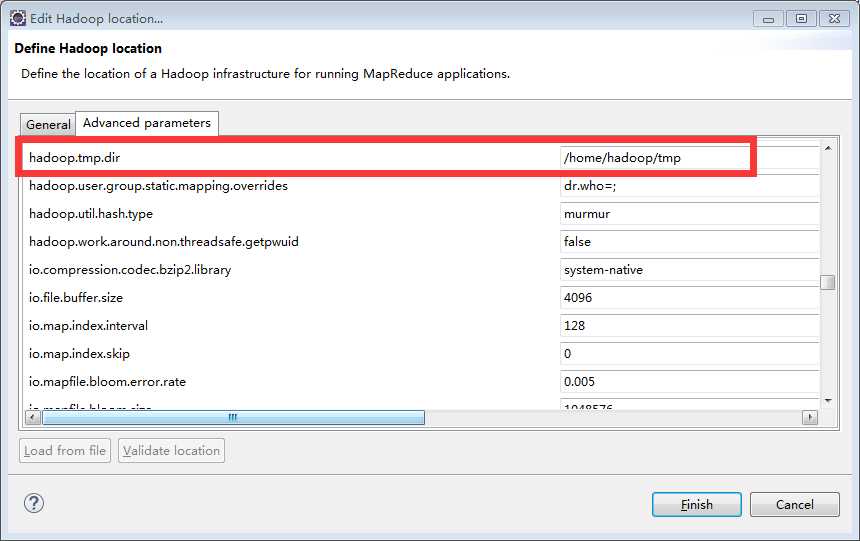

接着点击"Advanced parameters"从中找见"hadoop.tmp.dir",修改成为我们Hadoop集群中设置的地址,我们的Hadoop集群是"/home/hadoop/tmp",这个参数在"core-site.xml"进行了配置。-----------------这步貌似别人并没有做,也成功了,关于advanced parameters的配置还需要还再研究下。

书上说的配置用户和用户组的内容在这里没有找到,是在master节点上修改hdfs-site.xml。具体方法见下一页。

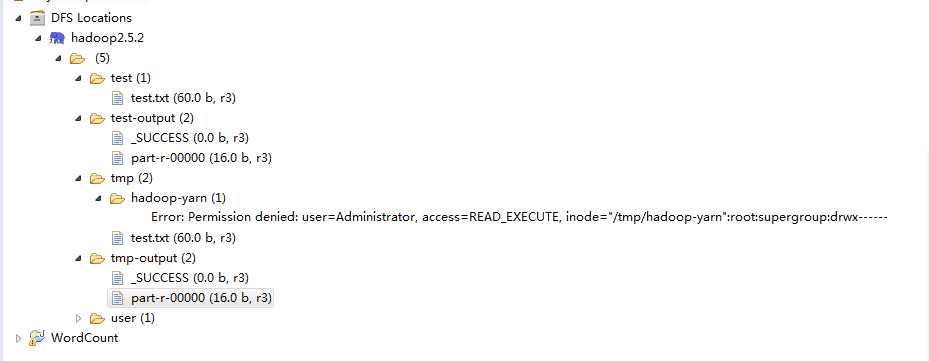

8. 查看HDFS文件系统,并尝试建立文件夹和上传文件。点击Eclipse软件左侧的"DFS Locations"下面的"hadoop2.5.2",就会展示出HDFS上的文件结构。

报错了。解决方式如下:

|

a.在master节点上修改hdfs-site.xml加上以下内容 <property> <name>dfs.permissions</name> <value>false</value> </property> 旨在取消权限检查,原因是为了解决我在windows机器上配置eclipse连接hadoop服务器时,配置map/reduce连接后报以下错误,org.apache.hadoop.security.AccessControlException: Permission denied: 如此配置后就可以在Eclipse端操作,而无需打包上传到hadoop上。 b.同样在master节点上修改hdfs-site.xml加上以下内容 <property> <name>dfs.web.ugi</name> <value>Administrator,supergroup</value> </property> 原因是运行时,报如下错误 WARN org.apache.hadoop.security.ShellBasedUnixGroupsMapping: got exception trying to get groups for user jack 应该是我的windows的用户名为jack,无访问权限 更多权限配置可参看官方说明文档: HDFS权限管理用户指南http://hadoop.apache.org/docs/r1.0.4/cn/hdfs_permissions_guide.html 配置修改完后重启hadoop集群: (貌似最好先stop再修改配置再重启) stop-dfs.sh stop-yarn.sh sbin/start-dfs.sh sbin/start-yarn.sh |

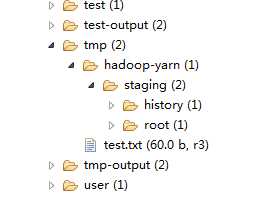

问题解决后不再报错,如下:

右击可以尝试建立一个"文件夹--xiapi",然后右击刷新就能查看我们刚才建立的文件夹。可以右键upload一个文件,刷新显示,并在master上查看到,则代表配置完成。

标签:

原文地址:http://www.cnblogs.com/qianqianjun/p/4579298.html