标签:

在我看来,实现UI自动化测试的过程一向都是令人快乐的事情,而维护它们就是跟噩梦一样了,尤其是对每次CI产生的build进行BVT测试,由于开发不会告诉你任何UI的变化,那么你拿到的测试结果就势必会一片红了。但是对于界面相对稳定的项目,有大量回归测试需要进行的项目,实现UI自动化的投资回报率还是很高的。

最近我实现了公司一个产品在Mac OSX上的UI自动化测试,下面就把具体的细节写出来。

首先,选用的是由 MIT 研究团队发布的图形化编程技术 Sikuli,它以图像检索为基础,提供了一套基于 Jython 的脚本语言以及集成开发环境,使用者可利用屏幕截图直接引用 GUI 元素进行编程,完成交互操作。

所有的按钮操作和拖动操作都是用Sikuli来完成的,而像窗口的相关操作,比如非全屏最大化,控制Finder定位到一个路径等等操作都是用AppleScript实现的,因为用图像识别去操作一些很小的或者是与周围图像没有明显区别的控件时,使用Sikuli还是不稳定的。

Sikuli不光提供了类库,还提供了一个IDE, 当然其功能很简单,而且经常crash,所以建议还是能不用就不用它吧。

还有就是由于Sikuli提供的是一套java包,然后再使用Jython进行包装,让其语言更加简单,但是这就有可能导致你想用的python库不能与jython兼容。

1. 安装Java SDK

2. 下载Sikuli, 访问官网下载jar包即可

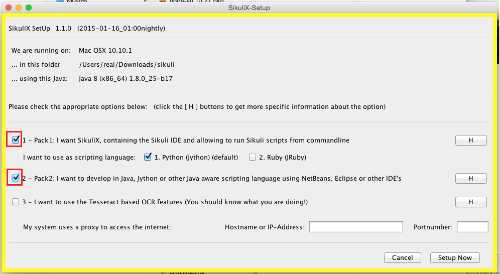

3. 安装Sikuli, 双击‘sikulixsetup-1.1.0.jar‘, 勾选1, 2即可 (Sikuli的安装界面,左右一个开源项目来说,已经是很出色了)

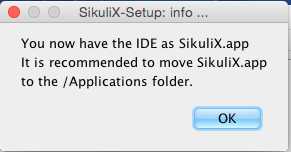

4. 安装过后,会生成一个app文件,建议将其拖到Application中吧:

5. 最后执行SikuliX.app即可

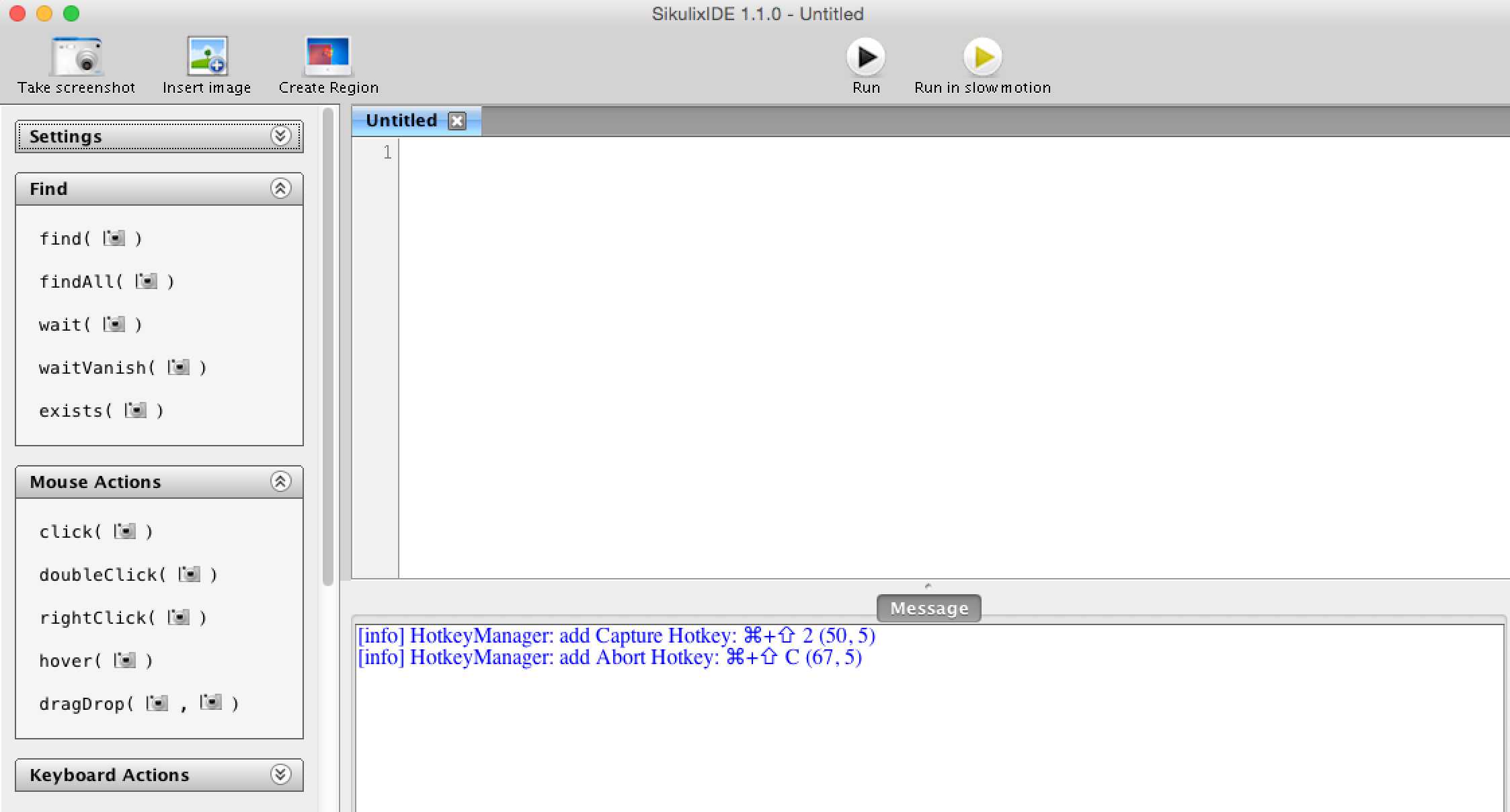

到此,安装就结束了,打开即可开到Sikuli的IDE了:

可以使用它方便进行截图和调整图片的匹配度。

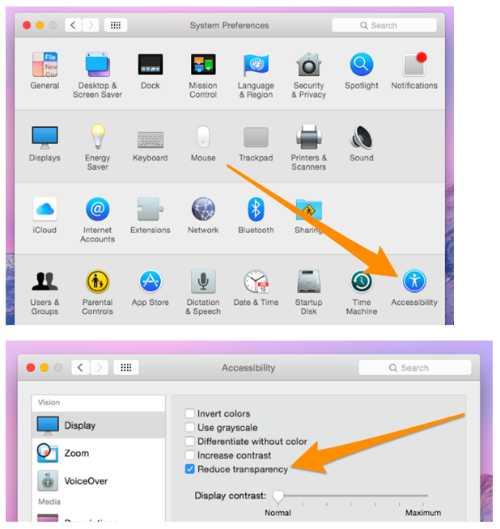

6. 由于使用的是图像识别,所以最好在开发和运行阶段都将OSX的透明度关掉,以免干扰图像识别的准确度。

在System Preferences中关掉透明:

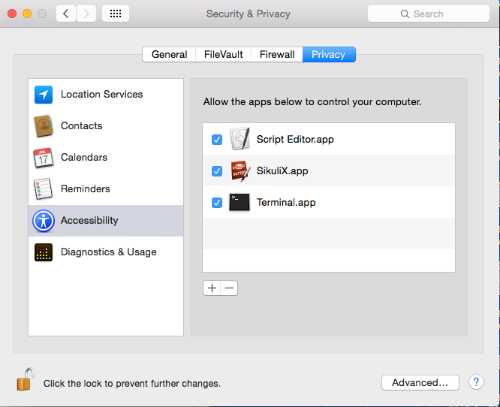

7. 将需要用到的app加入到“Security & Privacy”的“Accessibility”中:

到此,环境准备的差不多了,当然如果需要用到python的相关模块, 可以安装get-pip.py,之后执行install命令了:

sudo pip install [module name]

标签:

原文地址:http://www.cnblogs.com/liupengblog/p/4649529.html