标签:

增加特征数:

解决办法:

选取尽可能多的、可能有用的特征,然后根据需要进行特征约简。

目的:

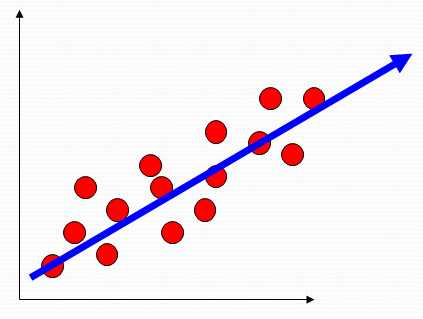

寻找能够表示采样数据的最好投影子空间。

求解:

对样本的散布矩阵(scatter matrix)进行特征值分解,所求之空间为过样本均值,(何为过样本均值?)

以最大特征值所对应的特征向量为方向的之空间。

特点:

线性判别分析(LDA)

思想:

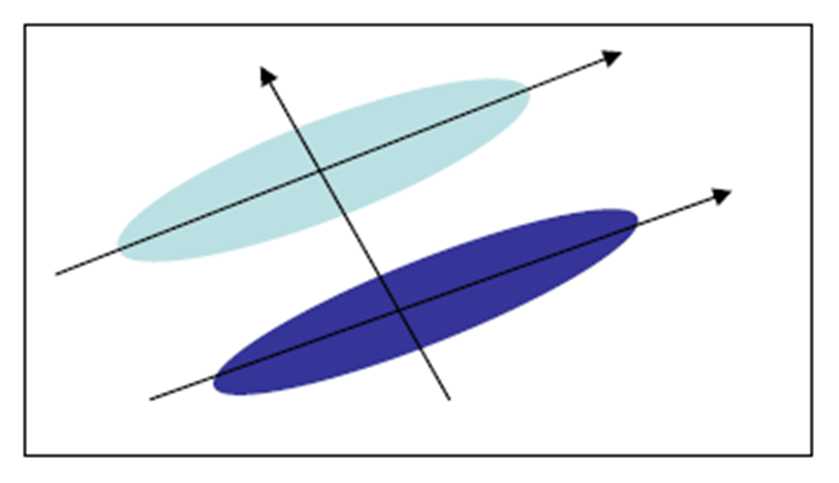

寻找最能把两类样本分开的投影直线

特点:

监督的维数约简

目标:

是投影后两类样本的均值之差与投影样本的总类散步的比值最大。

求解:

把原问题转化为关于样本集总类内散步矩阵和总类间散步矩阵的广义特征值问题。

LDA往多类情况的推广

解法与LDA类似,对于C-类问题,把样本投影到C-1维之空间。

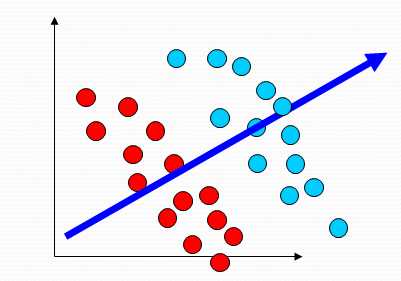

线性方法的缺点:

线性方法对于某些数据不能进行有效的处理,这类数据,在现实中,往往很多。比如下图:

另外,现实中的数据往往并不是特征的线性组合。

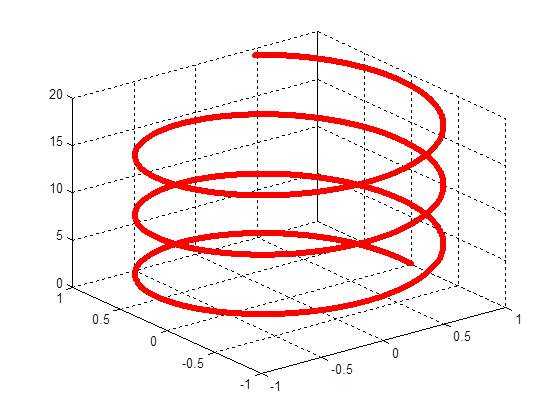

比如 paper:A Global Geometric Framework for Nonlinear Dimensionality Reduction 所提到的人脸模型

可行性分析:

几种经典的流形学习方法:

局部线性嵌入(LLE) Nonlinear dimensionality reduction by locally linear embedding. Science

等距映射(IsoMap)A global geometric framework for nonlinear dimensionality reduction. Science,

拉普拉斯特征映射(Laplacian Eigenmap)Laplacian Eigenmaps for Dimensionality Reduction and Data Representation. Neural Computation,

参考:

标签:

原文地址:http://www.cnblogs.com/time-hummer/p/4820503.html