标签:style blog http java color 使用

前言:

CDH4不带yarn和spark, 因此需要自己搭建spark集群. 这边简单描述spark集群的安装过程, 并讲述spark的standalone模式, 以及对相关的脚本进行简单的分析.

spark官网: http://spark.apache.org/downloads.html

*)安装和部署

环境: 172.16.1.109~172.16.1.111三台机器(对应域名为tw-node109~tw-node111), centos6.4, 已部署cdh4

目标是: 搭建一个spark集群(standlone), 部署目录统一为$SPARK_HOME=/root/mmxf/spark, 172.16.1.109部署Master, 172.16.1.109~172.16.1.111部署Worker节点.

预先的准备工作:

#) 在各个节点已配置/etc/hosts

172.16.1.109 tw-node109 172.16.1.110 tw-node110 172.16.1.111 tw-node111

#) 进行ssh无密钥登录设置(ssh-genkey, ssh-copy-it)

1. 下载pre-build cdh4版spark

wget http://mirrors.hust.edu.cn/apache/spark/spark-1.0.1/spark-1.0.1-bin-cdh4.tgz

2. 解压spark

tar zxvf spark-1.0.1-bin-cdh4.tgz

ln -s spark-1.0.1-bin-cdh4 spark

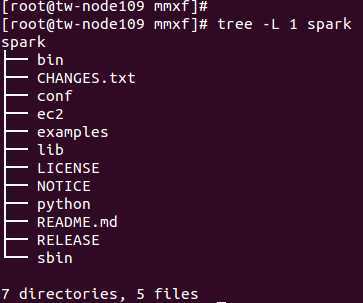

目录结构如下:

3. 配置属性

配置${SPARK_HOME}/conf/spark-env.sh

cd conf/

cp spark-env.sh.template spark-env.sh

SPARK_MASTER_IP=172.16.1.109

SPARK_MASTER_PORT=7077

MASTER=spark://${SPARK_MASTER_IP}:${SPARK_MASTER_PORT}

修改${SPARK_HOME}/conf/slaves

tw-node109 tw-node110 tw-node111

4. 使用rsync做同步

SPARK_INSTALL_DIR=/root/mmxf

rsync -avh ${SPARK_INSTALL_DIR} <username>@<server>:${SPARK_INSTALL_DIR}

rsync -avh /root/mmxf/ root@172.16.1.110:/root/mmxf/

rsync -avh /root/mmxf/ root@172.16.1.111:/root/mmxf/

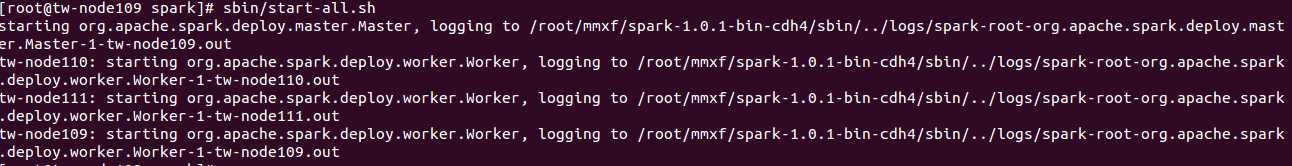

5. 启用服务

sbin/start-all.sh

sbin/stop-all.sh

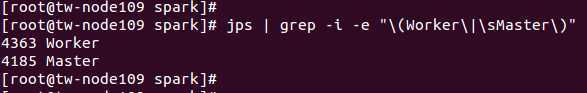

6. 验证

jps | grep -i -e "\(Worker\|\sMaster\)"

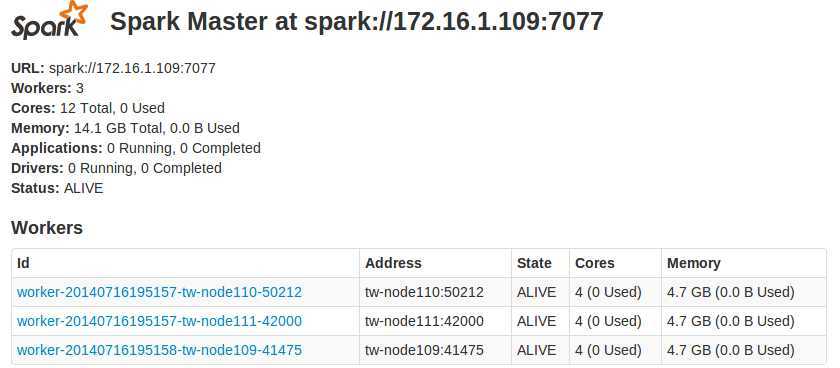

集群UI展示

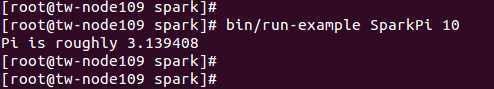

官方提供的测试用例: bin/run-example SparkPi 10

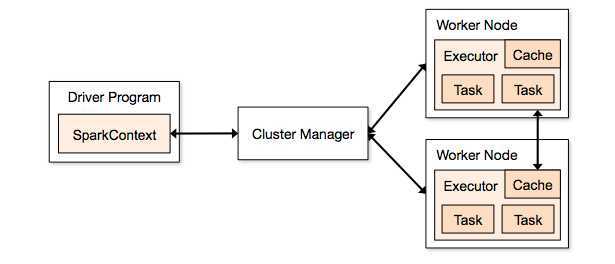

7. standlalone架构

总结:

spark集群的搭建还是很简单的, 服务启动维护亦然.

Spark 个人实战系列(1)--Spark 集群安装,布布扣,bubuko.com

标签:style blog http java color 使用

原文地址:http://www.cnblogs.com/mumuxinfei/p/3843179.html