标签:

本课程的视频教程地址:《Kafka实战项目之编码实践》

该课程我以用户实时上报日志案例为基础,带着大家去完成各个KPI的编码工作,实现生产模块、消费模块,数据持久化,以及应用调度等工作, 通过对这一系列流程的演示,让大家能够去掌握Kafka项目的相关编码以及调度流程。下面,我们首先来预览本课程所包含的课时,他们分别有:

接下来,我们开始第一课时的学习:《数据生产实现》

本课时主要给大家演示Kafka数据生产的代码实现,在前面搭建好的集群环境下,完成Kafka的数据生产功能,以及一些注意事项,为我们编写

消费代码做好准备,让大家掌握Kafka的数据生产的代码实现。

实践本课时的内容,我们需要设计到两个知识点,他们分别是:

接着,我们先从一个知识点来开始实践,实践数据生产模块所包含的内容,有以下几点:

首先第一点是:对项目工程的文件进行配置(pom) 然后是对集群的链接信息进行配置(这里为什么要将这些链接信息配置在配置文件当中,原因是,这些链接信息单独剥离到一个配置文件,便于我们后期维护, 比如:后期添加新的节点信息,或是移除一个已损坏的节点信息,我们可以轻松,快速的在配置文件中修改节点信息即可,无需在去操作我们的业务代码。)具体演示细节请大家参考视频操作。

在演示完数据生成模块相关内容后,下面,我带着大家去实践Flume到Kafka模块的相关内容,如下所示:

以上就是本课时的相关内容演示,其中包含了相关信息的配置,数据的收集过程演示等。

本课时给大家演示 Kafka 数据消费的代码实现,在前面我们创建的 Kafka 的项目工程的基础上,完成消费代码的编写, 以及编写 Storm 代码消费 Kafka 数据的需要注意的细节,通过本课时让大家能够掌握数据消费的代码实现。

那么,接下来我给大家列出本课时所涉及的核心知识点,如下所示:

下面,我们开始第一个核心知识点的实践,实践的所包含的内容如下所示:

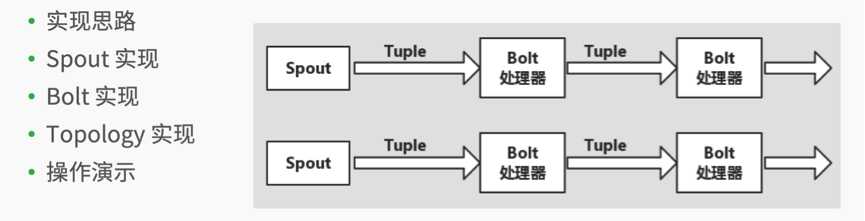

接下来我带这大家看看,如何编码实现这一部分内容,即:实现Kafka到Storm模块的 内容实现,该部分涉及的内容如下所示:

具体的演示细节,大家可以参考视频操作,观看地址:《数据消费实现》

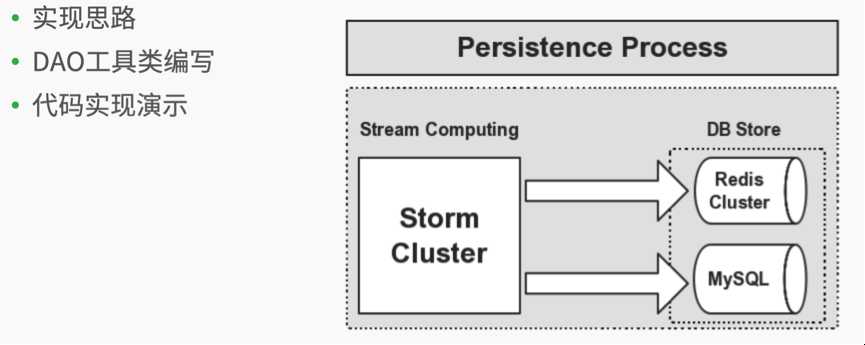

内容涉及给大家,介绍如何将消费后的数据(即我们统计的kpi结果)持久化,在前面数据消费实现的基础上,通过流式计算将统计的结果持久化到 Redis 集群或是 DB 中,让大家掌握数据持久化的代码实现。

那么,接下来,我们去看看本课时所涉及的核心知识点,如下所示:

下面,我们开始第一个知识点的实践,实现基础层代码模块所包含的内容,如下所示:

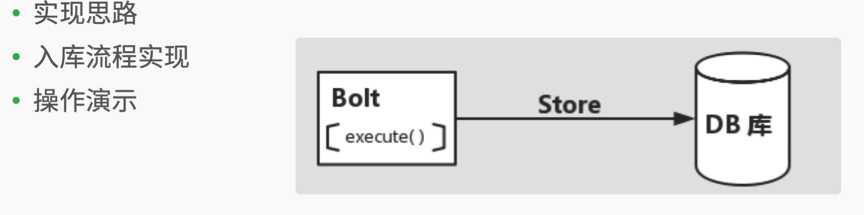

下面,我们去实现Storm统计结果存储到DB的相关内容,还模块包含如下所示的内容:

具体演示细节,大家可以参考视频操作,观看地址:《数据持久化》

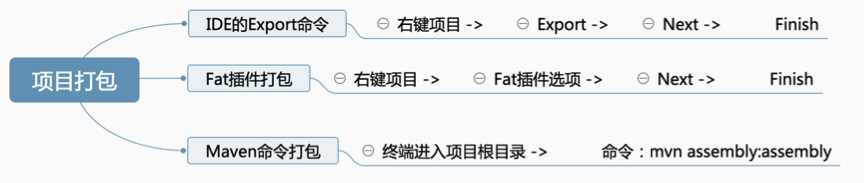

该部分内容将给大家介绍将开发好的应用打包部署到服务器,通过提交 Topology 到 Storm 集群, 完成 Storm 消费的程序的部署,让大家掌握项目的打包部署以及调度流程。下面,我们去看看实践本课时的内容,所涉及那些核心知识点,如下所示:

接下来,我们开始对第一个知识点的实践。关于打包所包含的内容,如下所示:

下面我们去实践如何将我们打包好的应用部署到Storm集群,去跑相应的任务。 实现该模块所包含的内容,如下所示:

具体演示细节,大家可以参考视频操作,观看地址:《应用调度》

本课程我们对项目的指标进行了编码实践,并指导大家去编码实现了相应的模块功能,以及帮助大家去提交我们开发的应用等知识,应该掌握一下知识:

我们在有了这些知识作为基础会使得我们在今后的工作当中,开发类似实时统计项目变得游刃有余,更加的得心应手。

如果本教程能帮助到您,希望您能点击进去观看一下,谢谢您的支持!

转载请注明出处,谢谢合作!

本课程的视频教程地址:《Kafka实战项目之编码实践》

标签:

原文地址:http://www.cnblogs.com/Leo_wl/p/4883447.html