标签:

这可能是实际中遇到的最多问题。

比如FC网络为什么效果比CNN差那么多啊,是不是陷入局部最小值啊?是不是过拟合啊?是不是欠拟合啊?

在操场跑步的时候,又从SVM角度思考了一下,我认为Poor Generalization属于过拟合范畴。

与我的论文 [深度神经网络在面部情感分析系统中的应用与改良] 的观点一致。

ImageNet 2012上出现了一个经典虐杀场景。见[知乎专栏]

里面有一段这么说道:

| 当时,大多数的研究小组还都在用传统computer vision算法的时候,多伦多大学的Hinton祭出deep net这样一个大杀器。差距是这样的:

第一名Deepnet的错误率是0.16422

第二名日本东京大学的错误率是0.2617 第三名牛津大学的错误率是0.2679 |

|

Question:如果用裸SVM跑ImageNet会怎么样?

My Answer:SVM的支持向量集会十分庞大。比如有10000个数据,那么就会有10000个支持向量。

|

|

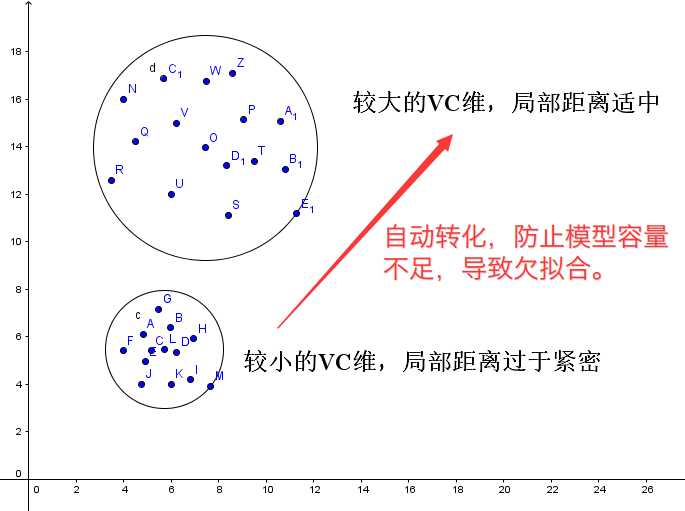

维数灾难:

在Test Phase,由于参数空间十分庞大,测试数据只要与训练数据有稍微变化,很容易发生误判。

原因是训练数据在参数空间里拟合得过于离散,在做最近局部距离评估时,误差很大。

|

再来看一个NN的例子,我在[深度神经网络以及Pre-Training的理解]一文的最后,用了一个神奇的表格:

[FC]

| 负似然函数 | 1.69 | 1.55 | 1.49 | 1.44 | 1.32 | 1.25 | 1.16 | 1.07 | 1.05 | 1.00 |

| 验证集错误率 | 55% | 53% | 52% | 51% | 49% | 48% |

49% |

49% | 49% | 49% |

[CNN]

| 负似然函数 | 1.87 | 1.45 | 1.25 | 1.15 | 1.05 | 0.98 | 0.94 | 0.89 | 0.7 | 0.63 |

| 验证集错误率 | 55% | 50% | 44% | 43% | 38% | 37% |

35% |

34% | 32% | 31% |

当初只是想说明:FC网络的Generalization能力真是比CNN差太多。

但现在回顾一下,其实还有有趣的地方。

I、先看FC的Epoch情况,可以看到,后期的Train Likelihood进度缓慢,甚至基本不动。

此时并不能准确判断,到底是欠拟合还是陷入到局部最小值。

但,我们有一点可以肯定,增大FC网络的规模,应该是可以让Train Likelihood变低的。

起码在这点上,应该与SVM做一个同步,就算是过拟合,也要让Train Likelihood更好看。

II、相同Train Likelihood下,CNN的Test Error要低很多。

如果将两个模型看成是等效的规模(实际上CNN的规模要比FC低很多),此时FC网络可以直接被判为过拟合的。

这点需要转换参照物的坐标系,将CNN看作是静止的,将FC网络看作是运动的,那么FC网络Test Error就呈倒退状态。

与过拟合的情况非常类似。

综合(I)(II),个人认为,从相对运动角度,Poor Generalization也可以看作是一种过拟合。

(II)本身就很糟了,如果遇到(I)的情况,那么盲目扩张网络只会变本加厉。

这是为什么SVM过拟合非常可怕的原因,[知乎:为什么svm不会过拟合?]

关于过拟合、局部最小值、以及Poor Generalization的思考

标签:

原文地址:http://www.cnblogs.com/neopenx/p/5001851.html