标签:

Θ应初始化为什么值

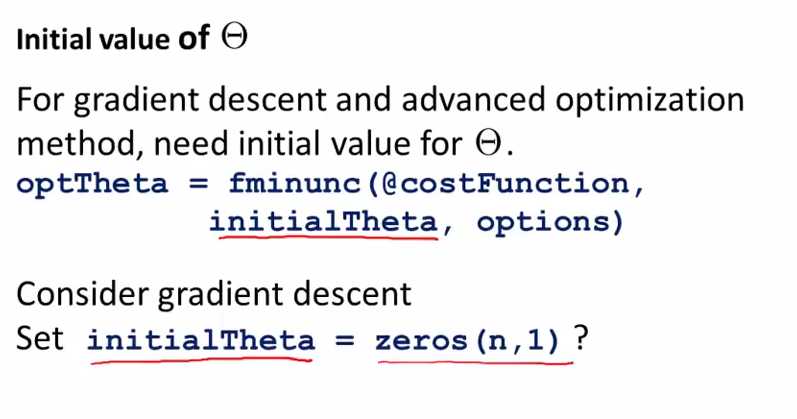

当我们是用logistic regression算法时,将θ初始化为0是可以的;但是如果在神经网络里面,将θ初始化为0是不可行的

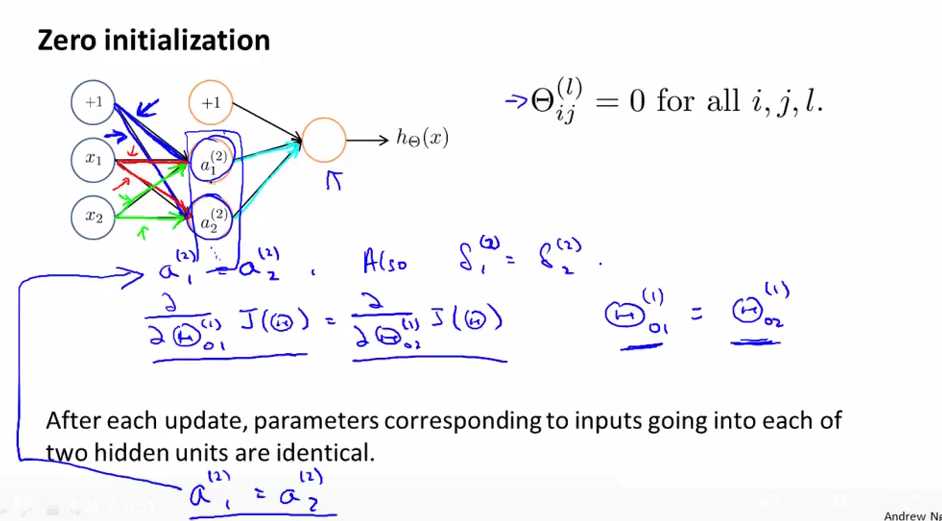

若将Θ初始化为0的后果-the problem of symmetry ways

当Θ初始化为0后,蓝色线上的两个weights是相等的,红色线上的两个weights也是相等的,绿色线上的两个weights也是相等的,这样a1(2)=a2(2),同样δ1(2)=δ2(2),然后对的两个蓝色线上的Θ求导后值也相等,即经过一次update后,a1(2)仍然与a2(2)相等.假设我们有很多个hidden units,则它们的值都是相等的,这样对于output layer来说,是等同于同一个feature的,会引起很大的冗余,引起的问题称为the problem of symmetry ways。

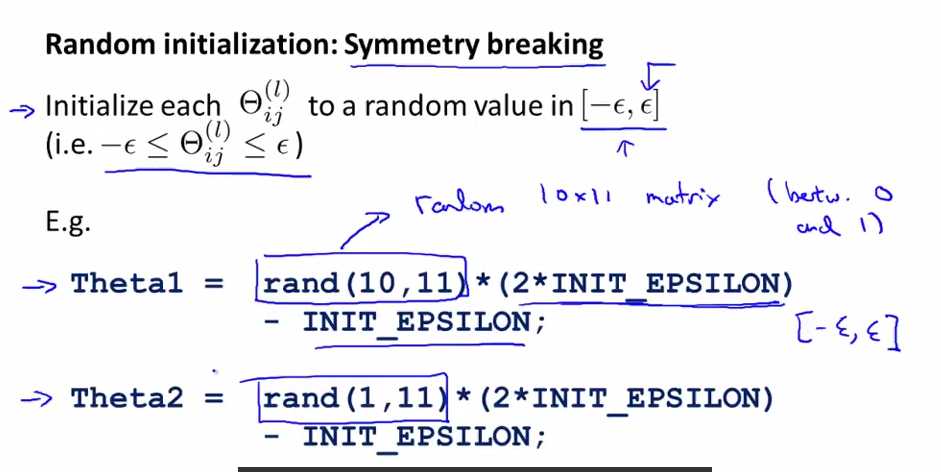

Θ应如何初始化-symmetry breaking

rand(10,11)创建一个10*11的矩阵,其中每个数都是在0到1之间的随机数,这个里面的EPSILON与我们之前讲的做gradient checking时的EPSILON是没有关系的,这里用EPSILON表示只是表示一个很接近于0的初始值。

总结

神经网络(13)--具体实现:random initialization

标签:

原文地址:http://www.cnblogs.com/yan2015/p/5026350.html