标签:

今晚听了王家林老师的第六课精通Spark集群搭建和测试,课后作业是:搭建自己的spark环境并成功运行pi,我的总结如下:

1 硬件环境:

至少8GB内存,推荐金士顿内存,虚拟机推荐Ubuntu kylin版本,可以安装各种办公软件包括搜狗输入法。

上网方式:Nat,root权限登录,避免权限问题

2.软件环境:

RedHat 6.4 spark 1.6.0 hadoop 2.6.0 scala 2.11.8

3 /etc/hosts ip-hostname对应关系

spark.eventLog.enabled true 记录spark运行事件,便于运维

./start-history-server.sh 启动

spark://Master:7077 默认端口

4 Pi 程序

object SparkPi {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("Spark Pi")

val spark = new SparkContext(conf)

val slices = if (args.length > 0) args(0).toInt else 2

val n = math.min(100000L * slices, Int.MaxValue).toInt // avoid overflow

val count = spark.parallelize(1 until n, slices).map { i =>

val x = random * 2 - 1

val y = random * 2 - 1

if (x*x + y*y < 1) 1 else 0

}.reduce(_ + _)

println("Pi is roughly " + 4.0 * count / n)

spark.stop()

}

}

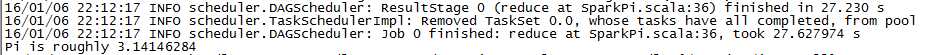

5 运行结果:

./bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://Master:7077 \

./lib/spark-examples-1.6.0-hadoop2.6.0.jar \

1000

后续课程可以参照新浪微博 王家林_DT大数据梦工厂:http://weibo.com/ilovepains

标签:

原文地址:http://www.cnblogs.com/haitianS/p/5107679.html