标签:

作者:樱花猪

摘要:

本文为七月算法(julyedu.com)12月机器学习第十次次课在线笔记。人工神经网络在支持图像处理、文本、语言以及序列多种类型的数据处理时都用用到。本次课程更加侧重于实践,把抽象的人工神经网络用程序展现出来,课上讲述了编程使用的工具和方法,对于日后实验有非常重要的帮助。

引言:

人工神经网络(Artificial Neural Network,即ANN ),是20世纪80 年代以来人工智能领域兴起的研究热点。它从信息处理角度对人脑神经元网络进行抽象,建立某种简单模型,按不同的连接方式组成不同的网络。在工程与学术界也常直接简称为神经网络或类神经网络。本次课程讨论了神经网络的基本框架、非常热门的BP算法以及实际编程的要点。

预备知识:

概率论;梯度下降法

人工神经网络

前向全连接网路

人工神经网络求法

一、人工神经网络

人工神经网络基础形态是前向全连接网络,同时拥有多种变形,这些变形构成了深度学习的主要内容。

卷积网路(CNN):属于部分连接网络,是深度学习结构核心之一

递归网络(RNN):是一种更为复杂的网络结构,能够很好的应对序列数据。

自编码器(Auto Encoder),一种数据特征学习,类似于PCA的作用

二、前向全连接网路(Full connected Forward Network)

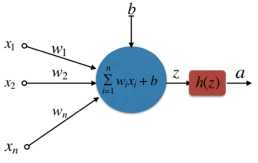

1、基础神经单元

神经元是构成神经网络的基本单元,一个神经元的组成包括:

输入:n 维向量x;

输入:n 维向量x;

线性加权:![]()

激活函数:![]() ,求非线性,容易求导;

,求非线性,容易求导;

输出标量:![]()

2、常用激活函数:

a、sigmoid函数![]() 。输出值域不对称,两头过于平坦。

。输出值域不对称,两头过于平坦。

b、tanh函数。两头过于平坦

C、Rectified linear unit

收敛速度比sigmoid和tanh快,计算简单高效。是目前最广泛使用的激活函数,特别应用在CNN。

3、丛神经元到网络

输入错,输入向量;

中间层(隐含层)

输出层,输出向量,用于预测、分类以及回归。

三、人工神经网络求法

1、损失函数(Loss Function)

![]()

配合模型训练,有Loss/Error Fuction:

Softmax / Cross-entropy loss:

SVM / hinge loss:![]()

Least squares (L2 loss):![]()

2、输入数据的预处理:

如果输入数据各个维度数据是相关的,将导致各个权重相互影响,不利于优化算法寻找局部最优解。

如果各个维度的规模不一致,将导致对应的Error Surface容易出现狭窄区域,不利于优化算法寻找局部最优。

通常对向量数据必须要用PCA和白化处理,而对于一般的数据只需要做到均值化和归一化。

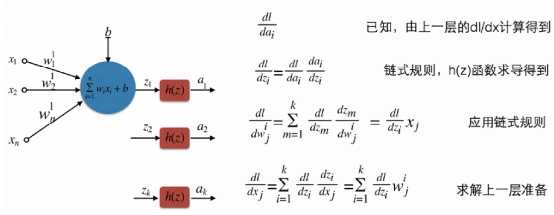

3、训练算法(BP算法)

神经网络的训练目标是找到W和B使得损失函数最小。优化算法需要计算dW和dB。BP算法就是计算W和B导数的算法。

BP算法的核心是链式规则。

算法步骤:

a. forward计算一次

b. 逐层计算backwoard得到各个层的dW和dB。

c. 应用随机梯度下降法SGD,更新W,B

4、数值校验

实现BP算法的过程中比较容易出错,因此有必要进行检查。

5、算法优化

多层网络的Error Surface非常复杂,存在很多局部最优,我们要寻找尽可能大的范围内的局部最优。

动量法不随更新W合适更新“更新W”的速度。

当位于距离较长的“坡”的时候动量法可以加快滑动速度;当位于平缓的区域时,动量法也能够保持一定的速度。

![]()

标签:

原文地址:http://www.cnblogs.com/Dr-XLJ/p/5369970.html