标签:

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点既作为 NameNode 也作为 DataNode,同时,读取的是 HDFS 中的文件。

伪分布式需要修改2个配置文件 core-site.xml 和 hdfs-site.xml 。Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。

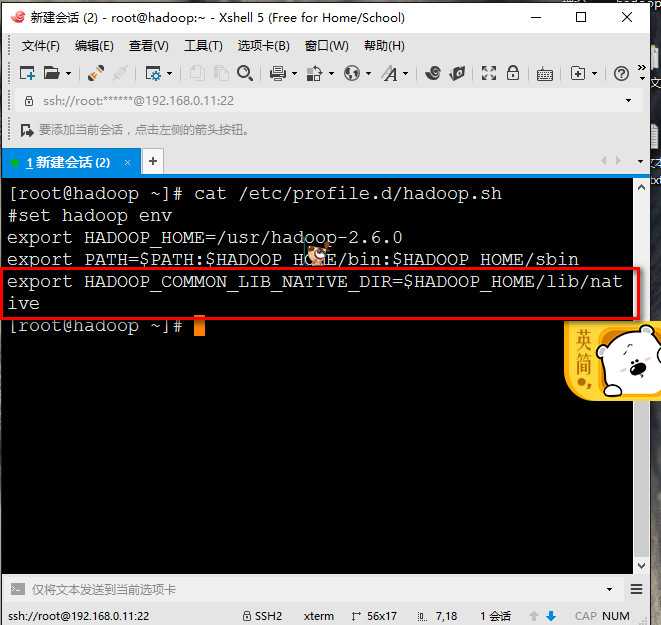

在搭建hadoop之前,为了方便后面的操作,先配置一下环境变量。vi /etc/profile.d/hadoop.sh

红框是解决不能解决主机名这个错。Could not resolve hostname

#set hadoop env

export HADOOP_HOME=/usr/hadoop-2.6.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

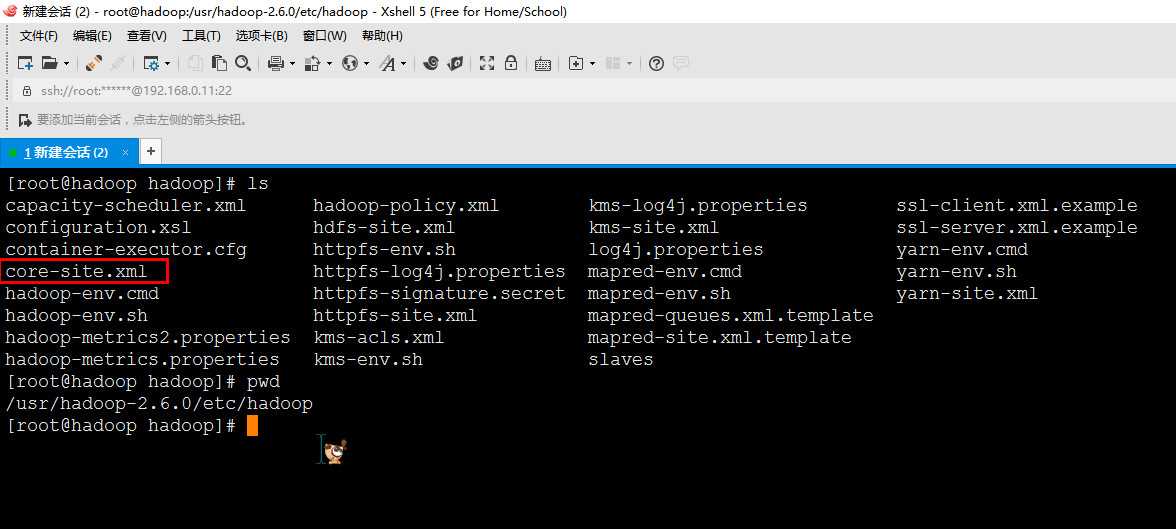

1.首先进入到hadoop安装目录下etc/hadoop下

2.添加以下参数

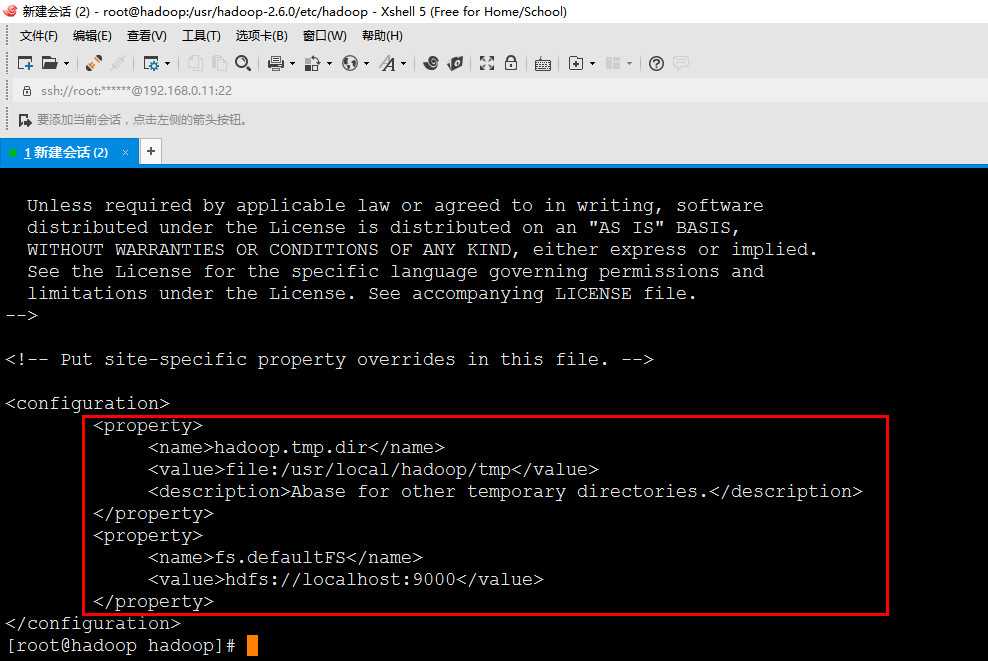

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

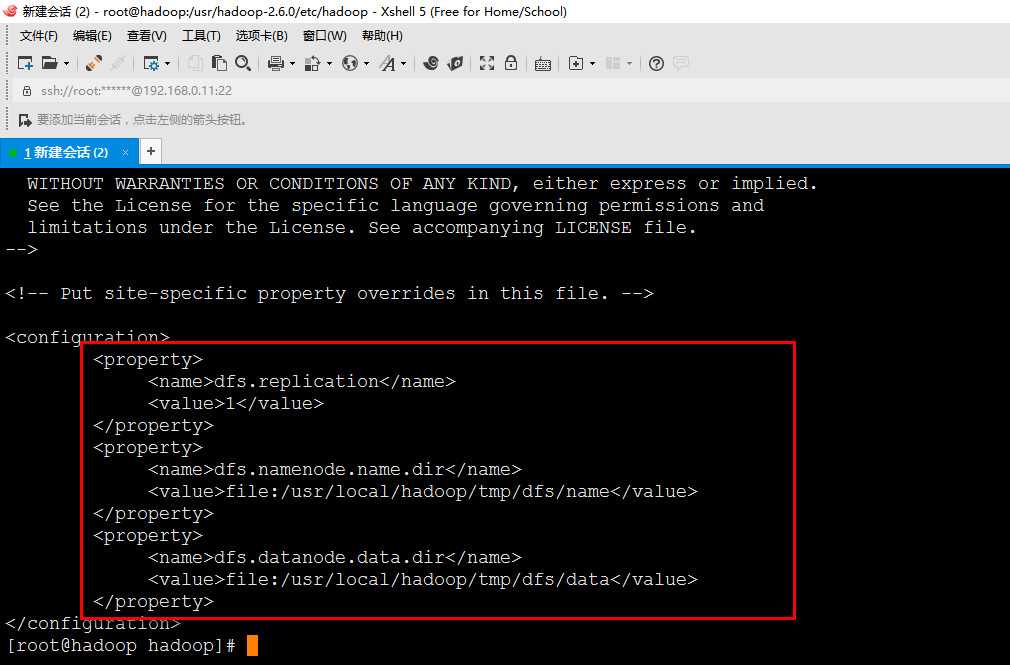

3.同样的,修改配置文件 hdfs-site.xml:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

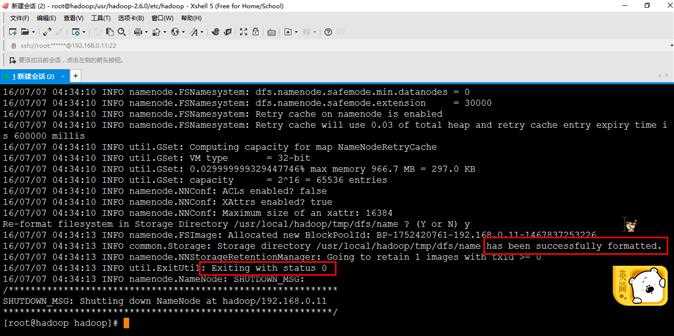

4.配置完成后,执行 NameNode 的格式化:hdfs namenode -format(不可多次执行,后果是datanode起不来。)

,出现红框的信息即为成功

如果在这一步时提示 Error: JAVA_HOME is not set and could not be found. 的错误,则说明之前设置环境变量那边就没设置好。

art-dfs.sh

5.这边启动的时候可能会出现如下SSH提示,输入yes即可。

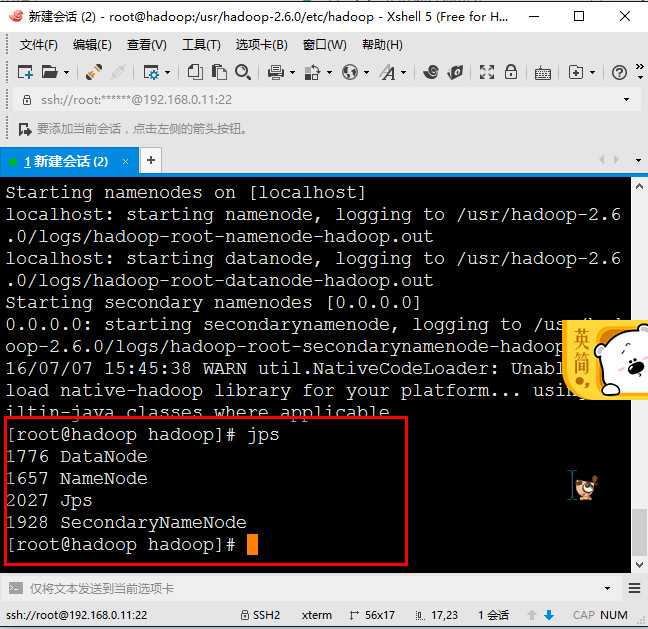

statr-dfs.sh

启动之后输入jps,输出结果,加上jps是四个的话就搭建成功!

欢迎佳佳批评指正。

标签:

原文地址:http://www.cnblogs.com/jiangsu2/p/5648112.html